通信量减少500倍

热点

大模型落地战,挺进大消费

2025-01-13 17:14:20用AI押题2025蛇年春晚小品,看完我沉默了。。。

2025-01-13 15:22:46ChatGPT,取代工作or生产力神器?清华校友联手发文:AI时代怎么选工作

2025-01-13 14:19:56你喜欢的二创大手,有多少是AI

2025-01-13 14:06:14极越汽车:已和所有员工签署赔偿协议 预计1月20日前发放补偿金

2025-01-13 14:00:29AI耳机开年大战:谁卖爆?谁尴尬?

2025-01-13 13:56:39行业最强小折叠!小米MIX Flip 2配置出炉

2025-01-13 11:24:24买到烂尾车的车主,靠开网约车自救

2025-01-13 09:17:47蜜雪冰城、肯德基悄然涨价,小红书上的网友吵翻了

2025-01-13 09:15:13谷子经济,何以站上时代风口

2025-01-13 09:12:31

关注

抖音电商向卷低价、仅退款开刀

2025-01-09 14:17:16重生之我在小红书卖泡面

2025-01-09 14:15:51高通确认!三星Galaxy S25系列将搭载骁龙芯片:1月23日发布

2025-01-09 14:04:26英伟达开年第一炸,2025年生成式AI将迎来哪些革命性变化?

2025-01-09 11:39:53贾跃亭全新品牌FX官宣!首款MPV车型谍照正式发布

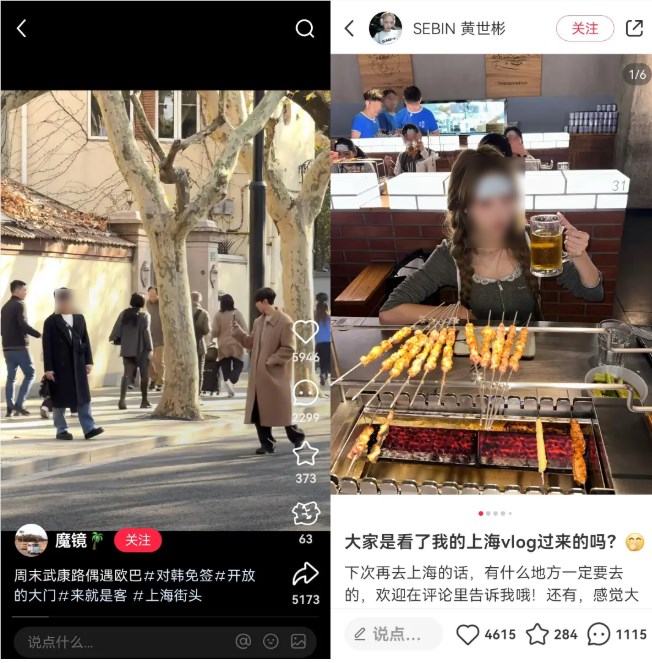

2025-01-09 11:21:58挤满上海的韩国人,把中国“十元店”再次搬回韩国

2025-01-09 09:20:05重磅!微软开源最强小模型Phi-4,超GPT-4o、可商用

2025-01-09 09:17:42一年卖出50亿,高端羽绒赛道杀出“黑马”

2025-01-09 09:07:52我们飞去 CES 逛了逛,结果被一帮中国企业狠狠圈粉。。。

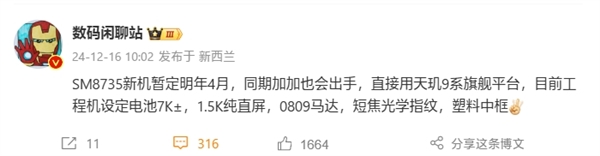

2025-01-09 09:03:30真我Neo7 SE入网:首款7K电池的天玑8400-Ultra神机

2025-01-09 08:42:19