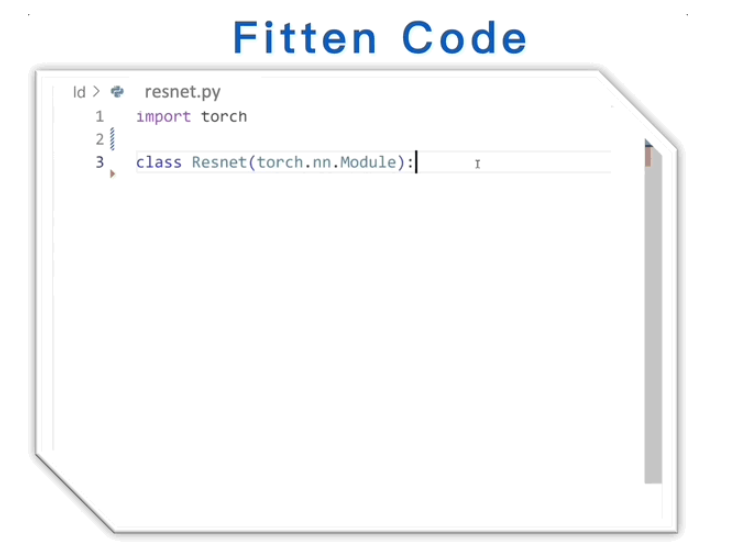

比Copilot快两倍!国产编程神器Fitten Code来了 准确率更高

要点:

Fitten Code是一款国产编程神器,比Copilot更快两倍,准确率提高约20%。

支持80多种编程语言,包括Python、Javascript、Java等,且完全免费。

Fitten Code的核心团队毕业于清华大学,基于国产深度学习框架计图(Jittor)和非十研发的代码大模型开发。

在最新发布的非十科技的Fitten Code中,一款国产编程神器在速度、准确率和功能上均超越了Copilot。这款神器支持80多种编程语言,包括Python、Javascript、Java等,并且完全免费。其核心开发团队是清华大学的博士,他们曾推动了计图(Jittor)深度学习框架的开源工作。Fitten Code在多个方面展现了其强大之处,包括代码自动补全、自然语言生成代码、自动添加注释、智能bug查找、解释代码、自动生成单元测试等功能。

官网地址:https://top.aibase.com/tool/fitten-code

文章首先强调Fitten Code相较Copilot更快、更准确,通过对比“编写ResNet模型”任务,显示Fitten Code平均延迟只有300ms,而Copilot首次延迟长达5秒。Pass@1准确率测试中,Fitten Code达到60.1%,显著高于Copilot的49.5%。在复杂算法任务上,Fitten Code展现了其高效性,例如实现O(nlogn)时间复杂度的最长上升子序列算法。

除了速度和准确率,Fitten Code支持80多种语言,而且在功能上也十分全面。从自动代码补全到自然语言生成代码,再到自动添加注释,智能bug查找,以及解释代码的功能,Fitten Code都展现出了其多才多艺。文章还指出,Fitten Code在一次性补全大量代码上相较于其他产品更为高效,平均补全3-5行,大幅提升了补全效率。

最后,文章介绍了Fitten Code的安装方式和团队背景。Fitten Code不仅免费且功能全,其安装方式也非常简单,支持在Visual Studio Code、IntelliJ IDEA、PyCharm等IDE中使用。团队由清华大学博士组成,曾在深度学习框架和大模型领域取得多项成就,包括开源计图框架和发布JNeRF神经渲染库与JittorLLMs大模型推理库。

综合而言,Fitten Code以其超越同类产品的速度、准确率和功能,以及简单易用的特点,成为一款备受关注的国产编程神器。

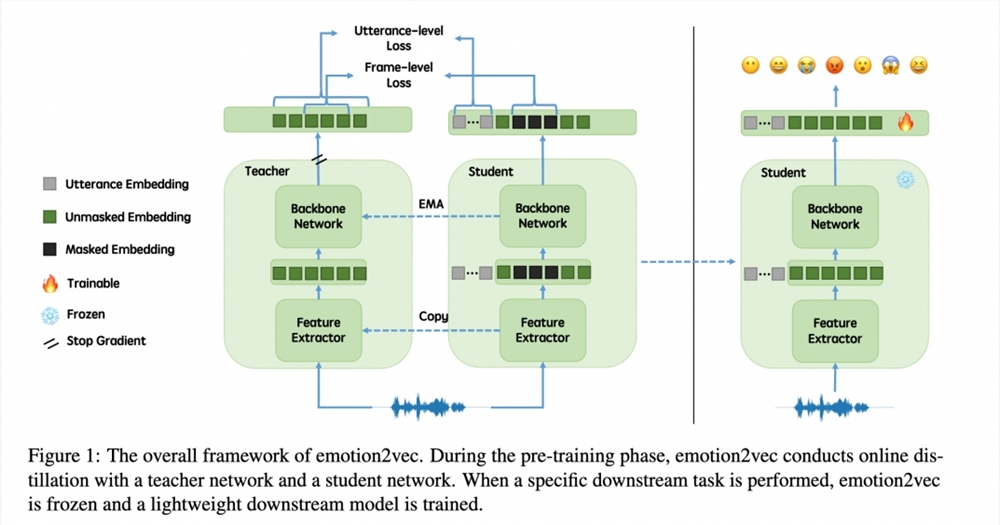

阿里巴巴等开源语音情感基座模型emotion2vec

情感识别技术在各种场景中都有广泛的应用,如客服机器人根据客户语气调整策略、智能助手根据用户情绪提供建议、情感健康应用监测用户情感状态。为了支持情感理解,上海交通大学、阿里巴巴、复旦大学和香港中文大学的研究者联合开发了通用的语音情感表征模型emotion2vec。站长网2024-03-07 15:18:430001《纽约时报》禁止人工智能公司使用其内容进行模型算法训练

据Adweek报道,纽约时报在8月初更新了其服务条款,禁止将其文章和图片用于人工智能训练。此举发生在科技公司继续通过像ChatGPT和GoogleBard这样的AI语言应用获取数据的大规模未经授权抓取的情况下。站长网2023-08-15 08:49:010000OpenAI预警系统探索 GPT-4 在制造生物武器方面的优势

划重点:1.📡OpenAI通过研发早期预警系统,评估GPT-4是否能提高获取生物威胁信息的效率。2.🤖对100名参与者进行的研究表明,使用GPT-4与互联网相结合,在生物危害任务的准确性和完整性上略有改善,但效果并不显著。站长网2024-02-01 11:42:060000在笔记本电脑上从头设计一款会走路的机器人,AI只需26秒

受自然界进化设计的启发,使用进化算法的机器人自动化设计已经尝试了二十年,但效率仍然低下。现在,从一块肥皂状物质到成功步行的机器人,AI的整个设计过程在笔记本电脑(消费级硬件)上只用了26秒。站长网2023-10-07 09:02:330000GPT-4o mini突然上线!该换小模型赛道的OpenAI意欲何为?

ChatGPT正式进入了“4”时代。7月18日,OpenAI官宣推出了GPT-3.5Turbo的替代品——GPT-4omini,至此,ChatGPT的更新迭代又近了一步,来到了4字开头的时期。据了解,即日起,ChatGPT的免费用户,Plus用户以及Team用户都能够使用GPT-4omini,企业版客户也会在随后获得使用GPT-4omini的权限。站长网2024-07-22 17:41:540000