LLM不靠谱!研究:AI聊天机器人提供了错误的癌症治疗建议

文章概要:

1. 研究人员评估了大语言模型聊天机器人提供癌症治疗建议的可靠性,发现33.33%的建议与确立的指南不完全一致。

2. 研究强调了AI技术渗透医疗决策时需谨慎和监管的必要性。

3. 聊天机器人的建议与NCCN指南不完全一致,专家也未能检测到这些错误,凸显LLM聊天机器人在提供可靠和精确的癌症治疗建议方面的表现低于平均水平。

在最近发表在 《JAMA Oncology》杂志上的一篇文章中,研究人员评估了由人工智能 (AI) 算法驱动的大型语言模型 (LLM) 驱动的聊天机器人是否可以提供准确可靠的癌症治疗建议。

关于该研究

在本研究中,研究人员评估了大语言模型聊天机器人在提供前列腺癌、肺癌和乳腺癌治疗建议方面的表现,该建议与国家综合癌症网络 (NCCN) 指南一致。

研究人员开发了四个零样本提示模板,并用于创建26种癌症诊断描述的四个变体,最终获得了104个提示。然后将这些提示作为输入提供给GPT-3.5。

研究团队由四名经过委员会认证的肿瘤学家组成,其中三人根据研究人员制定的五项评分标准评估了聊天机器人输出与2021年 NCCN 指南的一致性。采用多数决原则来确定最终得分。

第四位肿瘤学家帮助其他三位解决了分歧,这些分歧主要是在法学硕士聊天机器人输出不清楚时出现的。例如,大语言模型没有具体说明针对特定类型的癌症应结合哪些治疗方法。

研究结果

该研究对聊天机器人提供的104条癌症治疗建议进行了评估。结果显示33.3%的建议至少部分不符合NCCN指南,被视为错误或不准确的。

聊天机器人对98%的提示给出了至少一个治疗建议。所有包含治疗建议的回复中,至少有一个治疗方法与NCCN指南一致。

但是在102条产出中,有35条包含一个或多个不一致的治疗方法,占34.6%。这意味着超过三分之一的建议包含了错误信息。

聊天机器人提供的建议根据提问方式而变化。当提问不明确时,它的回复也变得模糊,导致评估者之间出现分歧。

本研究中评估的大语言模型士聊天机器人将错误的癌症治疗建议与正确的建议混合在一起,即使是专家也未能发现这些错误。

研究结果表明,大语言模型聊天机器人在提供可靠且精确的癌症治疗建议方面表现低于平均水平。

鉴于AI的广泛使用,医疗保健提供者需要适当教育病人有关这项技术可能提供的错误信息的潜在风险。这些发现还强调了针对AI及其他潜在危害公众的技术制定联邦法规的重要性。

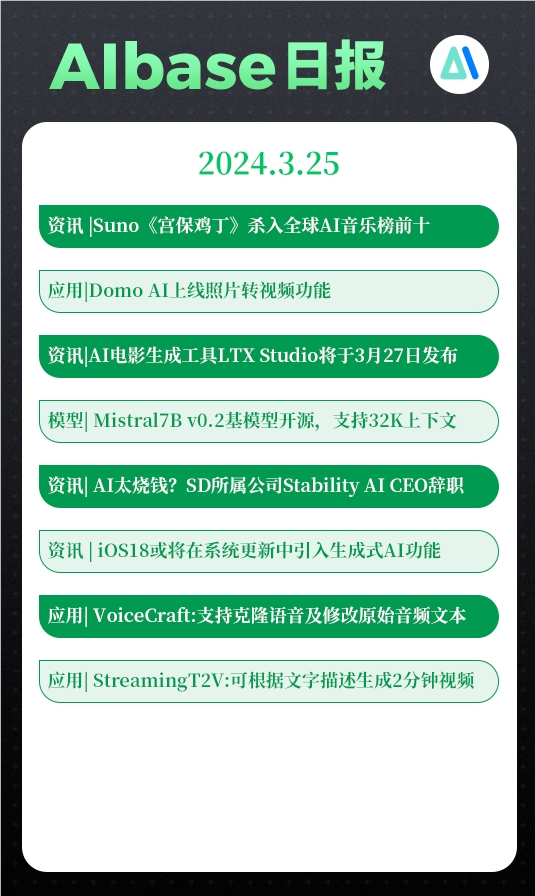

今日AI:Suno《宫保鸡丁》杀入全球AI音乐榜前十;AI太烧钱? Stability AI CEO辞职;Domo AI上线照片转视频功能;Viggle让静态图片跳舞

欢迎来到【今日AI】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。新鲜AI产品点击了解:https://top.aibase.com/🤖📱💼AI应用DomoAI上线新功能只需一张照片和视频即可让人物动起来【AiBase提要:】⭐️只需一张照片和一个动态视频就可以让静态的图像跳舞站长网2024-03-25 19:13:160000会说话的汤姆猫被AI“变活”了!AI玩具成了下一个超级风口?

主打“情绪价值”。正在读这篇文章的大伙,有看过皮克斯经典动画电影《玩具总动员》的,请举一下手。嗯,虽然我隔着屏幕看不到,但我估计举手的人数是不少的。要我说,《玩具总动员》还真能算是90后和00后共同的童年回忆了,像是牛仔胡迪、翠儿、巴斯光年、Mr.Potato这些拥有自我意识,能够说话聊天的玩具,应该没有人不想拥有吧。好消息是,如今动画正在照进现实。0001雷军公布小米澎湃 OS、汽车大压铸两项自主技术获百万美元最高技术大奖

站长之家(ChinaZ.com)1月4日消息:1月4日,小米集团董事长兼CEO雷军发文宣布,2024年第一件大事就是颁发小米百万美元技术大奖。其中最高奖项的两项技术分别是“一体化大压铸技术”和“小米澎湃OS新架构”。雷军表示,这两项技术的获奖,标志着小米在底层核心技术能力以及操作系统领域,实现了重大突破。它们不仅代表着公司技术实力的积累,也体现了小米工程师团队敢于挑战高峰的勇气与决心。00007.7亿参数,超越5400亿PaLM!UW谷歌提出「分步蒸馏」,只需80%训练数据|ACL 2023

【新智元导读】LLM不实用,小模型蒸馏才是「现实」的大模型应用路线,全面领先微调技术!土豪请无视。。。大型语言模型虽然性能优异,可以用零样本或少样本提示解决新任务,但LLM在实际应用部署时却很不实用,内存利用效率低,并且需要大量计算资源。站长网2023-10-08 10:54:040000三星计划 2025 年推出第六代高性能 HBM4 DRAM:争夺快速增长的 AI 芯片领域的主导地位

站长之家(ChinaZ.com)10月11日消息:三星电子周三发布的初步财报显示,第三季度营业利润同比下降77.9%,原因是全球芯片供应持续过剩的影响导致其芯片业务出现亏损。该公司将于本月晚些时候发布第三季度正式财报。站长网2023-10-11 16:55:290000