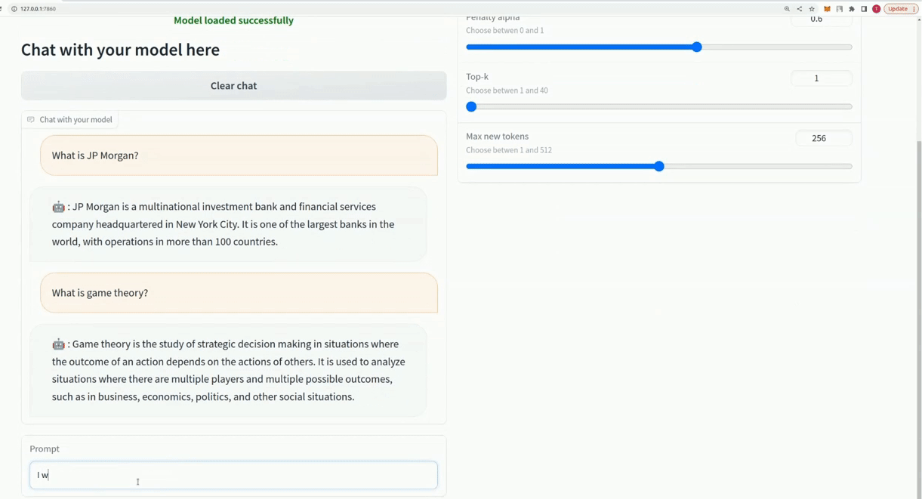

开源工具xTuring厉害了,三行代码就能创建自己的大语言模型

xTuring 是一个开源工具,可以让用户只用三行代码就能创建自己的大语言模型 (LLMs)。

据了解,xTuring由 Stochastic 团队开发,旨在优化和加速人工智能大语言模型。Stochastic 拥有一支由聪明的机器学习工程师、博士后和哈佛大学研究生组成的团队,专注于优化和加速法学硕士的人工智能。

自动文本传输、聊天机器人、语言翻译和内容制作等应用程序是人们努力利用这些概念开发和创建新应用程序的领域。训练和微调这些模型可能既耗时又昂贵。无论是使用 LLaMA、GPT-J、GPT-2还是其他方法,xTuring 都可以轻松快速地进行模型优化。

xTuring 可以适应不同的硬件配置,通过内存高效的微调技术 LoRA,加快学习过程,降低硬件成本。据称,xTuring 使用 LoRA 等内存高效微调技术来加速学习过程,并将硬件支出减少多达90%。通过减少微调所需的内存量,LoRA 有助于更快速、更有效的模型训练。

与其他微调技术相比,xTuring 在 LLaMA7B 模型的微调能力上取得了出色的结果。LLaMA7B 模型被用作 xTuring 微调能力的基准,团队将 xTuring 与其他微调技术进行了比较。数据集由52K token组成,测试中使用了335GB CPU 内存和4xA100GPU。

结果表明,使用 DeepSpeed CPU 卸载对 LLaMA7B 模型进行每个 epoch21小时的训练消耗了33.5GB GPU 和190GB CPU。在使用 LoRA DeepSpeed 或 LoRA DeepSpeed CPU 卸载进行微调时,GPU 上的内存使用量分别急剧下降至23.7GB 和21.9GB。CPU 使用的 RAM 量从14.9GB 下降到10.2GB。此外,使用 LoRA DeepSpeed 或 LoRA DeepSpeed CPU 卸载时,训练时间从每个 epoch40分钟减少到20分钟。

操作方面,用户可以通过简单的鼠标点击来微调模型,并且 xTuring 的用户界面非常简单易用。该团队表示,xTuring 是调整大型语言模型的不错选择,因为它支持单个和多个 GPU 训练,使用内存高效的方法,并具有直观的界面。

项目网址:https://github.com/stochasticai/xTuring

https://xturing.stochastic.ai/

华为鸿蒙智行宣布问界M9上市7个月大定超11万台

7月19日,鸿蒙智行宣布其问界旗舰SUV车型M9自上市以来7个月的订单量已超过11万台,这一成绩使其在50万元以上价格区间的所有车型和动力形式中销量排名第一。截至7月14日的数据显示,问界M9在今年已交付6.13万台,目前还有近5万台的订单储备。客户对M9的忠诚度非常高,他们宁愿等待也不愿意选择其他品牌的车型。站长网2024-07-20 03:30:390000vivo推出自研影像芯片V3 X100系列或首发搭载

根据最新爆料,vivoX100系列将会首发搭载vivo自研芯片V3。这款芯片采用6nm制程工艺,能效较上一代提升了30%,并拥有多并发AI感知ISP架构和第二代FIT互联系统,在提升算法效果的同时还兼顾了降低功耗,综合体验相比上一代V2芯片有明显提升。站长网2023-07-31 08:13:550000腾讯会议发布极速版 AI小助手可计算会议垃圾时长占比

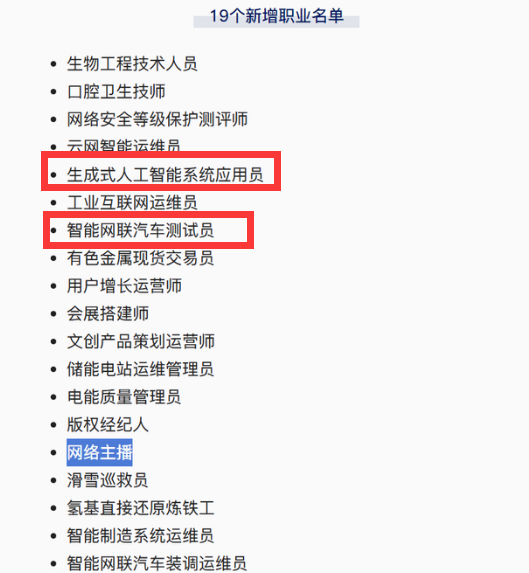

腾讯会议发布了极速版,新增了三项功能以提升开会效率。首先是支持一键闭麦功能,参会人员可以点击“提效”来匿名提醒发言人闭麦,如果多人反复点击“提效”,系统会逐步降低发言人音量直至闭麦,减少低效发言,提升会议效率。其次是AI小助手功能,可以帮助判断会议是否已经进入无效讨论阶段,如果垃圾时长占比超过80%,AI小助手将在30秒后自动结束会议。站长网2024-04-18 14:27:180000网络主播、生成式AI系统应用员等正式成为国家认定职业

近日,中国人力资源和社会保障部公布了最新职业分类调整结果,其中网络主播正式成为国家认定的新职业,引发广泛关注。除此之外,智能网联汽车测试员和生成式AI系统应用员也被纳入新职业名单。站长网2024-08-01 10:17:220000谷歌受到诉讼 指控窃取了数百万用户的数据来训练人工智能工具

据CNN报道,周二,科技巨头谷歌遭到了一场诉讼,指控该公司未经数百万用户同意就窃取了他们的数据,并违反了版权法,起诉谷歌使用这些数据来训练和开发其人工智能产品。站长网2023-07-13 23:56:240000