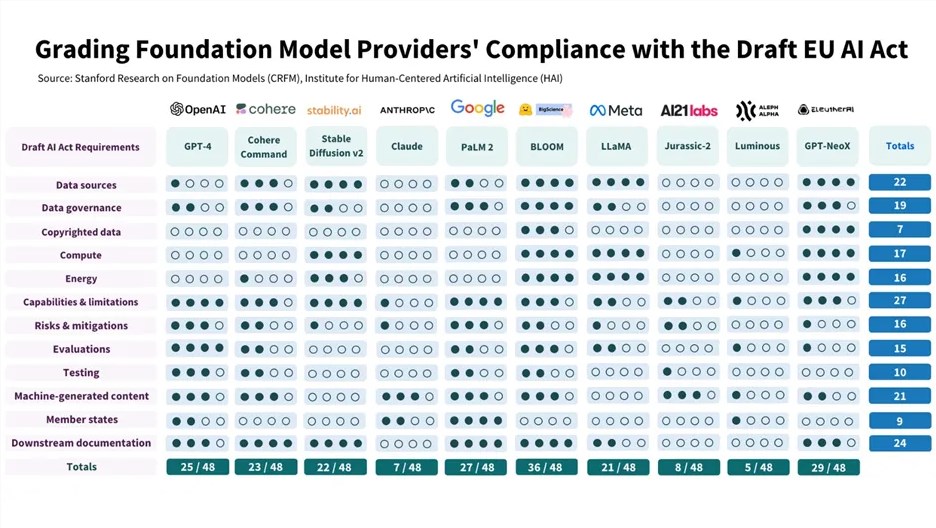

斯坦福大学:大多数大语言模型不符合欧盟AI法案 GPT-4仅排第四

斯坦福大学著名的以人为中心的人工智能研究所 (HAI) 表示,对10个主要基础模型的调查显示,它们“基本上不”遵守欧盟的人工智能法案。

得分最高的基础模型是Bloom,它是 Hugging Face 的开源模型,于2022年7月发布,是一个大型多语言模型,具有多达1760亿个参数,旨在通用。

紧随其后的是 EleutherAI 的GPT-NeoX和 Google 的PaLM2。OpenAI 的 GPT-4排名第四,Cohere 的Command跻身前五。

得分最低的模型是来自德国人工智能初创公司 Aleph Alpha 的Luminous 。令人惊讶的是,表现第二差的模型是Anthropic 开发的人工智能机器人 Claude,这是 ,旨在生成更安全的响应。第三差的是AI21的Jurassic-2。

斯坦福大学研究人员表示,Claude的结果表明模型是受限或封闭的。他们发现,像 Claude 这样的模型,以及 Google 的PaLM2和 OpenAI 的GPT-4等几乎没有被披露的模型,使得评估数据源和计算水平变得困难。GPT-4得分为25,PaLM 得分为27,尽管与 Claude 一样,在涉及数据源和治理的测试时,两者都排名较低。

斯坦福大学的研究人员考虑了欧盟人工智能法案的22项要求,并选择了12项可以利用公共信息进行“有意义的评估”的要求。它们是数据源、数据治理、受版权保护的数据、计算、能源、能力/限制、攻击/缓解、评估、测试、机器生成的内容、成员国和下游文档。

这12个指标按4分制进行评估,其中 最低得分为1分,4为最高。然而,由于创建者没有透露足够的信息,某些模型无法得到充分评估。例如,封闭模型的数据源通常不公开。

研究人员表示,他们选择《欧盟人工智能法案》是因为它是“当今世界最重要的人工智能监管举措”。该法案很快将成为适用于欧盟4.5亿人口的法律,同时也为全球人工智能监管开创了先例。

研究人员得出结论,得分最高的模型仍有“重大改进”的空间。这意味着欧盟人工智能法案将导致透明度和问责制方面的“重大变化”和“实质性进展”。

大多数模型陷入困境的四个领域是受版权保护的数据(不明确的责任问题)、计算/能源(能源使用报告不均匀)、风险缓解(披露不充分)和评估/测试(模型提供商很少根据故意伤害来衡量性能)。

一般来说,广泛开放的模型在资源披露方面较强,但在监视或控制部署方面较弱。封闭或受限模型则相反。因此,斯坦福大学的研究人员呼吁欧盟政策制定者加强部署要求,以确保更大的问责制。

研究人员表示,欧盟人工智能法案必须明确未明确规定的领域,例如哪些性能维度需要披露。此外,评估合规性时必须考虑模型的准确性、稳健性、公平性和效率,类似于美国标准与技术研究所的人工智能风险管理框架。

斯坦福大学团队表示,欧盟人工智能法案还应迫使提供商披露使用模式,以反映在线平台的透明度报告。对于全球政策制定者来说,他们应该优先考虑模型的透明度。社交媒体监管的经验是一个明显的教训,即平台透明度不足导致了许多危害。

模型提供商合规性最差的领域是受版权保护的训练数据的披露。研究人员呼吁立法者澄清版权与生成模型的训练和输出的关系,包括机器生成内容侵犯内容创作者权利的条件。

对于模型提供商来说,斯坦福大学的研究人员建议他们从“容易实现的成果”开始,例如为基于基础模型构建的下游开发人员改进文档。他们还应该与学术界和公众合作制定行业标准,以提高整个生态系统的透明度和问责制。

Kimi Chat移动端UI大幅重构 并上线“月之亮面”模式

KimiChat移动端应用迎来了重要的更新,版本1.2.1对用户界面(UI)进行了全面的重构,并引入了“月之亮面”浅色模式,旨在提供更加舒适和直观的用户体验。更新亮点包括:用户界面(UI)改进:界面经过重新设计,提升了美观度和易用性,使用户操作更加直观。性能优化:响应速度和流畅度得到提升,减少了应用运行中的卡顿和延迟。站长网2024-04-28 20:50:040000“硅谷钢铁侠”成主播!马斯克宣布直播《暗黑破坏神4》:挑战99级噩梦副本

快科技9月29日消息,日前,埃隆马斯克宣布,将在X平台(原Twitter)直播速通《暗黑破坏神4》,挑战99级噩梦副本。不过,根据马斯克最新回应,他以工作为由推迟了直播计划。据了解,硅谷钢铁侠”马斯克此次成为主播似乎是进行X平台推流直播测试,马斯克强调,他说的速通只是普通玩家水平,不要期望太高。站长网2023-09-29 15:32:340000男子用ChatGPT炮制虚假信息赚流量牟利

ChatGPT等生成式AI编写文本内容的能力甚至可以超越很多普通人,而这也引发有人利用这类工具编造谣言的担忧。最近,甘肃侦破首例利用AI人工智能技术炮制虚假信息案。根据官方通报,4月25日,平凉市公安局崆峒分局网安大队在日常网络巡查中发现,某百度账号出现一篇标题为“今晨甘肃一火车撞上修路工人致9人死亡”的文章,初步判断为信息虚假不实。站长网2023-05-08 11:45:260000日本NTT将于明年3月发布高效能大语言模型

划重点:NTT计划于明年3月向公司提供大规模语言模型(LLM),为学习日语的生成式人工智能提供基础。通过专注于特定行业(如医疗保健),可以降低模型学习和运行所需的成本。NTT打算通过提供该模型来与美国信息技术巨头竞争。日本电报电话公司(NTT)于11月1日宣布,将于明年3月向公司提供大规模语言模型(LLM),为学习日语的生成式人工智能提供基础。站长网2023-11-02 18:13:170000微信支付与移动、电信、联通三大运营商实现条码支付互联互通

微信支付宣布,已经完成与中国移动、中国电信、中国联通等三大通讯运营商旗下支付平台条码支付的互联互通。现在,用户通过中国移动“和包App”、中国电信“翼支付App”、中国联通“沃钱包App”扫描微信支付个人收款码,就可以完成支付。站长网2023-11-10 10:31:300000