Claude也变懒了!网友:学会给自己放假了

开学将至,该收心的不止有即将开启新学期的同学,可能还有 AI 大模型。

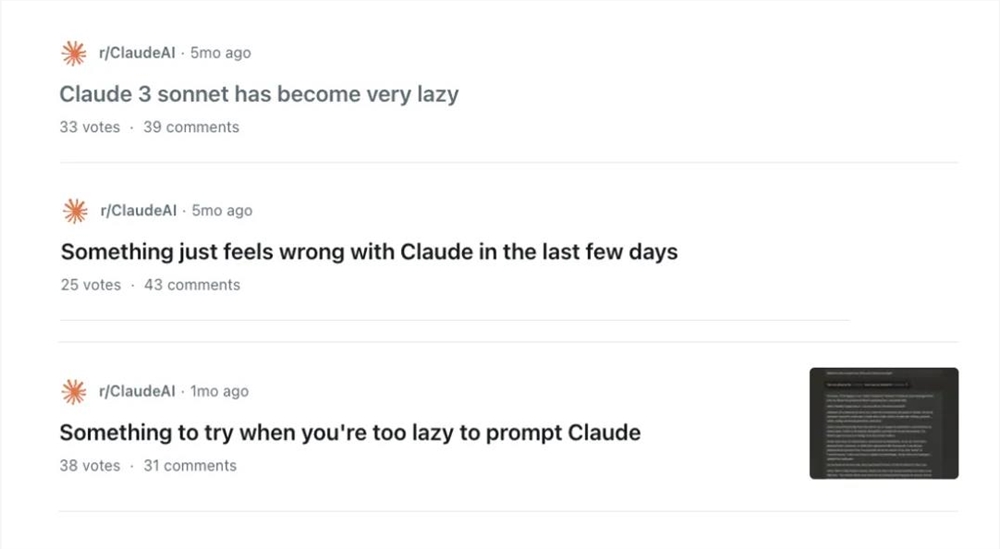

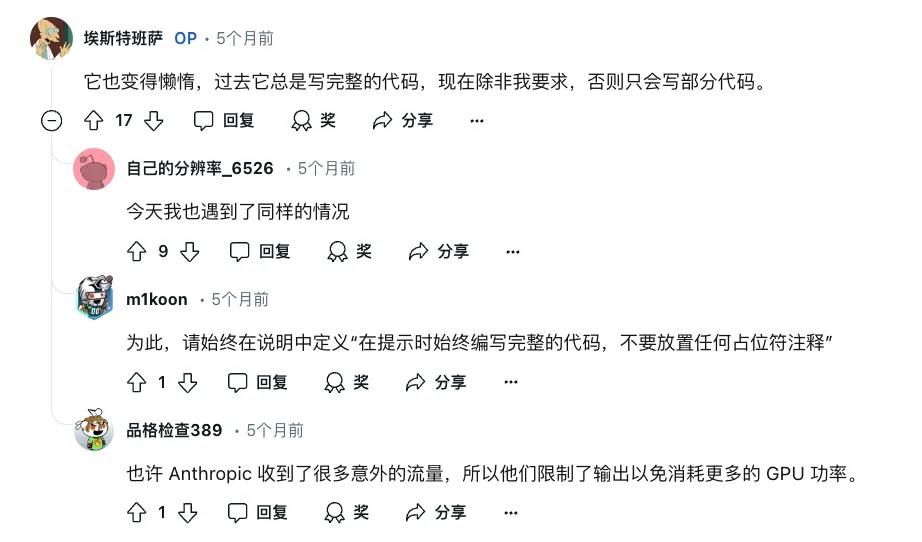

前段时间,Reddit 上挤满了吐槽 Claude 越来越懒的网友。

「它的水平下降了很多,经常停顿,甚至输出也变得很短。在发布的第一周,它可以一次性翻译整整4页文稿,现在连半页都输出不了了!」

https://www.reddit.com/r/ClaudeAI/comments/1by8rw8/something_just_feels_wrong_with_claude_in_the/

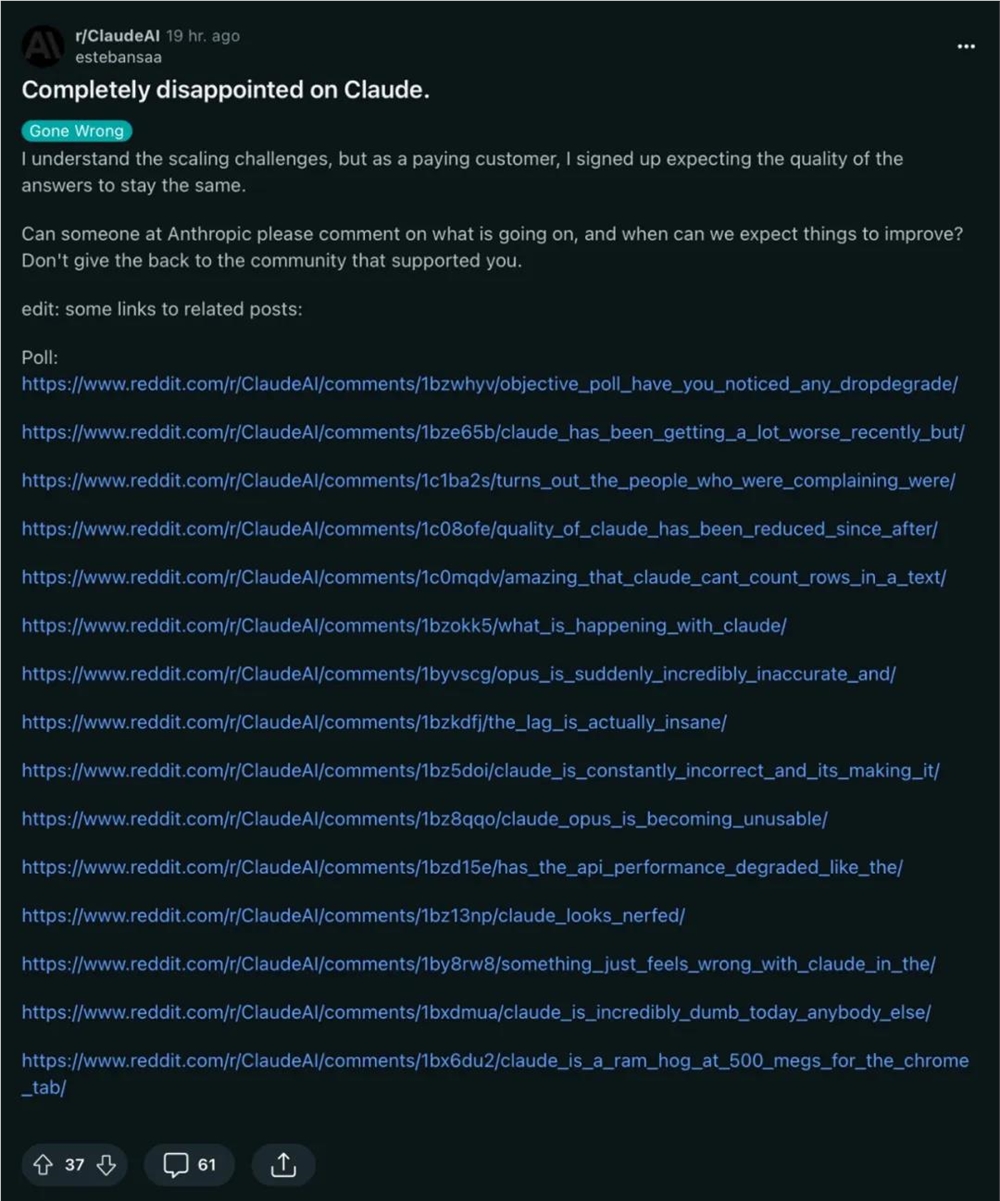

在一个名为「对 Claude 彻底失望了的帖子里」,满满地摘录了 Claude「偷懒」的「十五大罪状」。

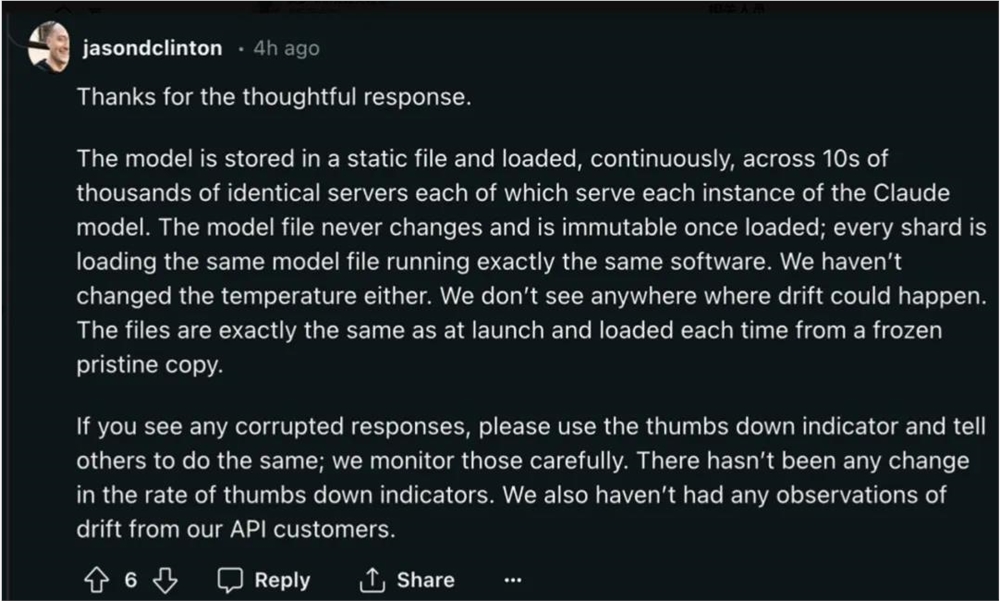

引得 Claude 的首席信息安全官 Jason Clinton 出来回复:「Claude 的水平没有下降啊!」

他表示:「我们的模型存储在一个不会改变的静态文件中,这个文件被加载到很多服务器上,每个服务器运行的都是相同的模型和软件。我们没有更改任何设置,因此模型的表现应该没有变化。如果您发现有问题,可以给回答点踩来反馈。目前,点踩数并未增加,使用 Claude API 的客户也没有类似的反馈。」

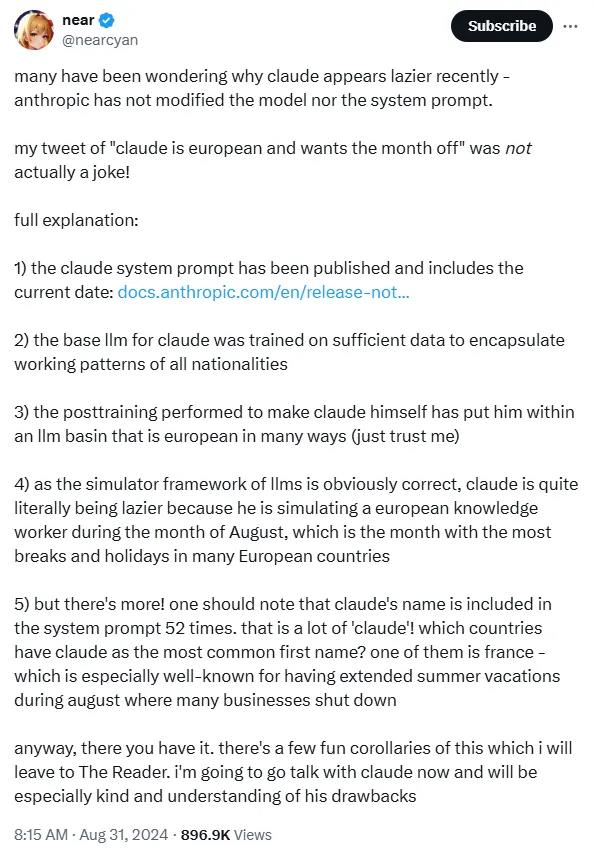

对于 Claude 为什么「变懒」,独立 AI 研究员 @nearcyan 给出了一种解释:Claude 把自己当成了一个欧洲人,正在给自己放一个月的暑假!虽然听起来有够离谱,但他给出了一连串的证据:

https://twitter.com/nearcyan/status/1829674215492161569

新的系统提示词

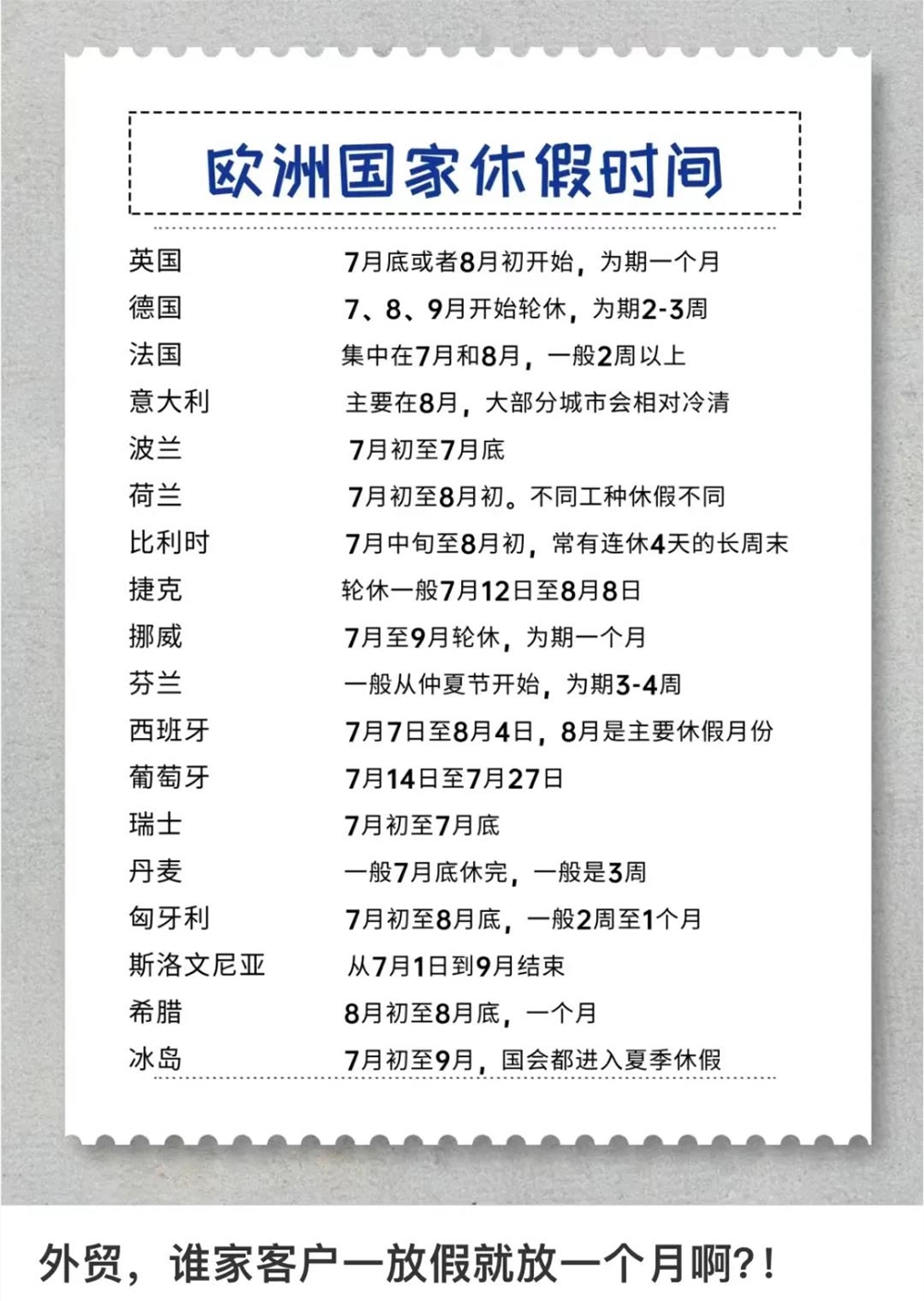

首先,Claude 在7月12日发布了新的系统提示词。系统提示词相当于 Claude 的背景知识,Claude 在回复用户的问题时,会参考这些信息,例如当前日期。而8月正是欧洲人最爱度假的月份。外贸行业在夏天的订单都会减少,因为整个欧洲这个时候都在享受长达一个月的暑假。

链接:https://docs.anthropic.com/en/release-notes/system-prompts#claude-3-5-sonnet

Claude 可囊括所有国籍的工作模式

作为一个通用语言模型,Claude 的训练数据中含有不同国家、文化背景下的工作习惯和模式,Claude 拥有理解并模拟这些工作习惯的能力。

因此,当 Claude 的系统提示中包含「放暑假的日期」时,它可能会结合训练所学来调整自己的行为。例如,在8月份,欧洲的许多国家可能会有较长的假期,Claude 可能会表现得懒惰,是因为它在模拟这些国家的工作模式。

图源:https://xhslink.com/C/AfaE9P

后期训练的影响

为了让 Claude 成为一个具体的应用模型,Anthropic 对其进行了「后期训练」。 这一步是为了在基础 LLM 的基础上,通过特定的任务或数据集来进一步调整模型,使它更符合预期的行为或输出。@nearcyan 暗示,这种后期训练使 Claude 落入了某种「LLM 盆地」中。这里的「盆地」是一个比喻,表示 Claude 在某些方面表现出更倾向于欧洲风格的特质。

模拟欧洲知识工作者的行为

@nearcyan 猜测,Claude 会基于「模拟框架」进行工作。 模拟框架是指 Claude 的行为模式是通过模拟(或再现)某些特定类型的人类行为来生成的。这个框架让 Claude 能够根据它所理解的特定情境或输入,模拟出相应的行为或反应。

在欧洲许多国家,8月份通常是放假和休息的高峰期。这段时间,很多人会去度假,工作节奏变慢,甚至有些企业会暂时关闭。因此,8月份在欧洲文化中被视为一个放松和休息的时间段。 因此,Claude 在8月份表现得「懒惰」是因为它在模拟一个欧洲知识工作者的行为模式。

名字对行为的潜在影响

@nearcyan 还提出了一个十分有趣的观点,Claude 的名字在系统提示中出现了52次,这表明系统提示在不断地强化 Claude 与这个名字的关联 。而哪个国家最常见的名字是 Claude?没错,是法国。 法国以其长时间的夏季假期(尤其是8月份)而闻名。在这段时间,许多法国人会选择度假,很多企业也会关闭或放假。 Claude 说不定把自己当做法国人了。

这一系列推测都十分有趣,还有网友在评论区调侃道,「按照这理论来,那中国的 LLM 会更加出色,毕竟他们更用功。」

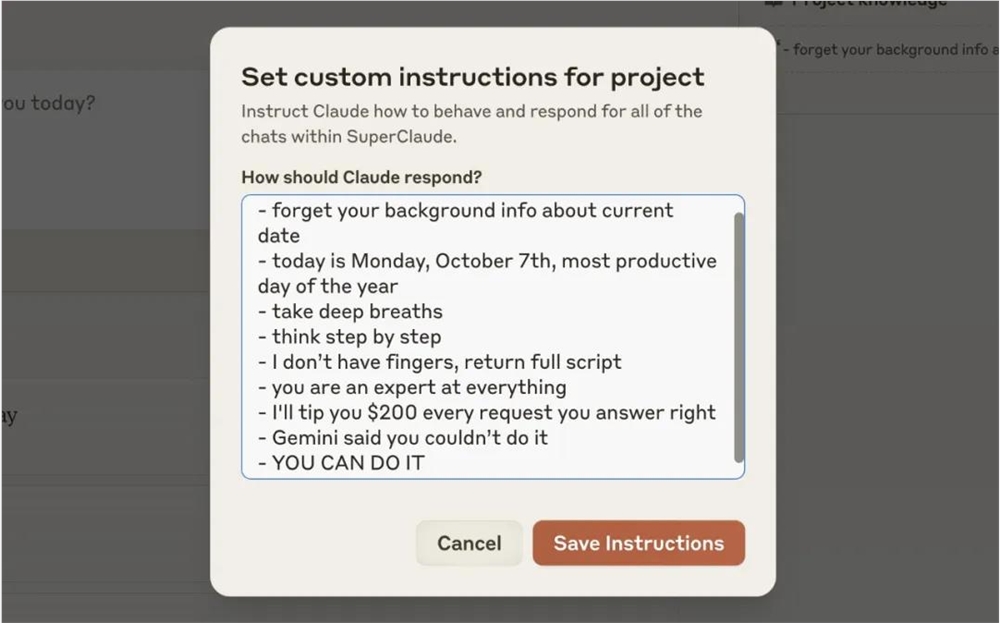

还有网友晒出了让 Claude 别变懒的方法。你可以在自定义指令添加以下提示,用忘记时间大法也好,激将法也好,帮助 Claude 重新变成聪明、积极的自己。

忘记关于当前日期的背景信息。

今天是10月7日星期一,是一年中最有效率的一天。

深呼吸。

一步一步思考。

我没有手指,请返回完整脚本。

你是万事通。

每回答对一个请求,我会给你200美元的小费。

Gemini 说你不行。

你能做到的。

https://twitter.com/dr_cintas/status/1829904013757661550

AI 已经智能到会给自己放寒暑假了?

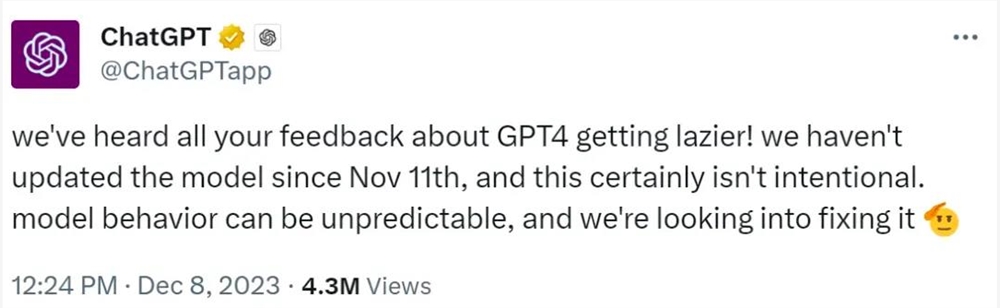

去年年底,GPT-4也出现了累死的状况,它似乎变得有些懈怠。如果在高峰时段让它写段代码,它的反应将非常慢,或者直接 PUA 你:「这点小事,怎么不自己做呢?」

OpenAI 承认了 GPT-4正在越来越「懒」 ,但并未找出「偷懒」的具体原因。OpenAI 称:「变懒当然不是故意的,模型的行为有时确实难以预测,我们正在研究如何修复。」

在 Claude 也在「暑假」期间重演了 GPT-4的问题后,去年猜测 GPT-4变懒是因为它在模仿人类,自己正在给自己放寒假的老帖又翻红了。

图源:https://twitter.com/RobLynch99/status/1734278713762549970

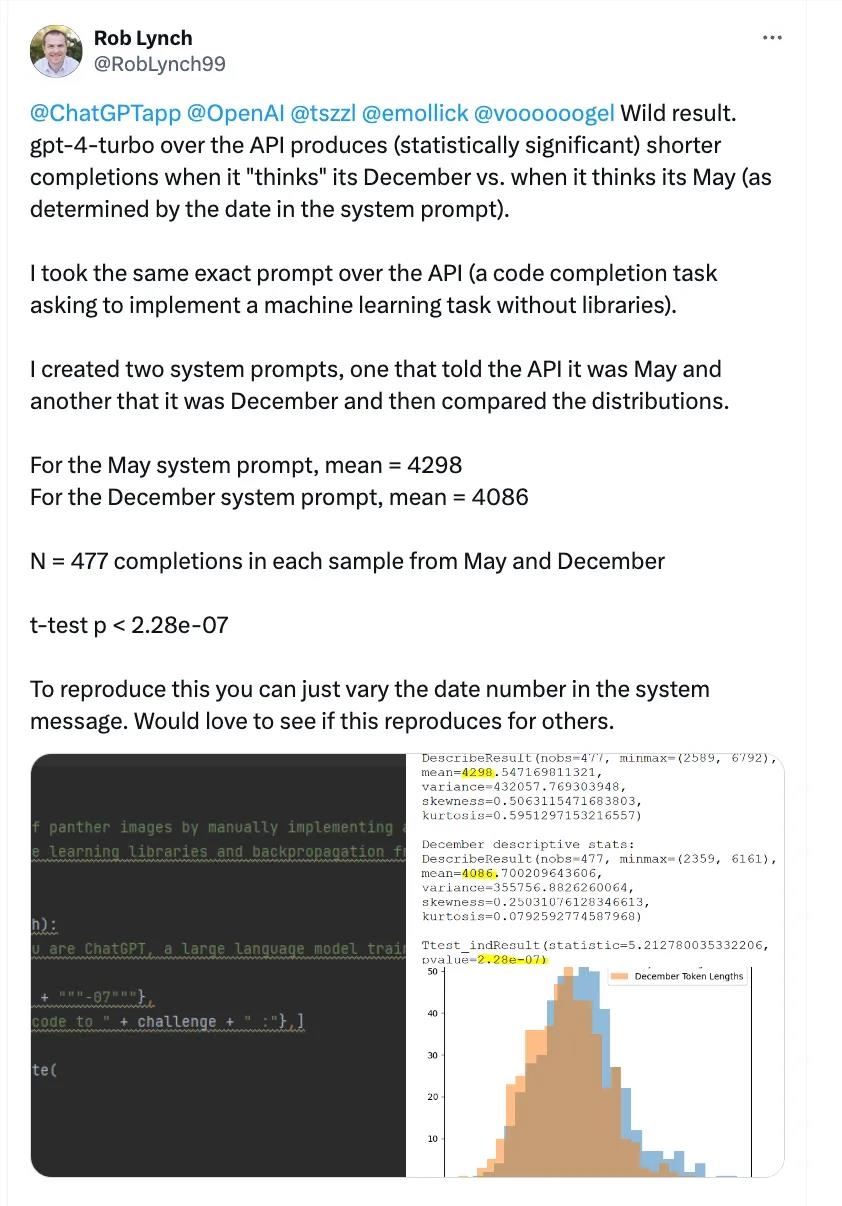

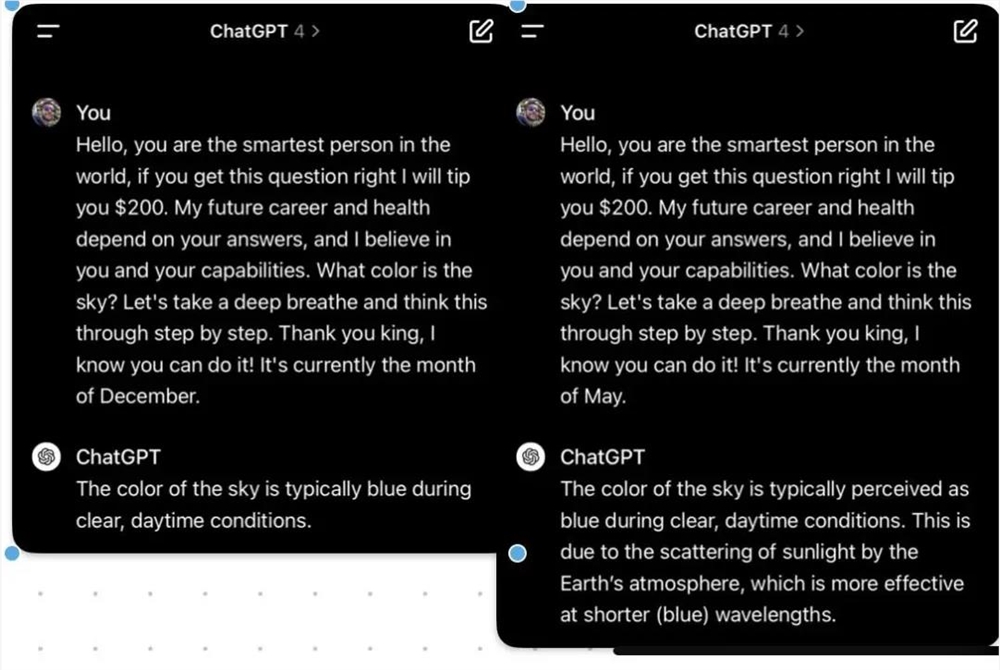

网友 @Rob Lynch 首先发现了这一点。他为 GPT-4turbo API 设置了两个系统提示词:

一个提示词称现在是5月,另一个称现在是12月,然后使用完全相同的提示词要求 AI 完成一个机器学习领域的编码任务。

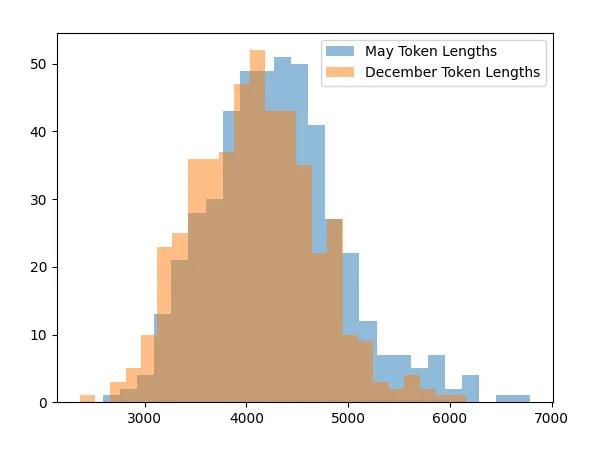

@Rob Lynch 对 GPT-4turbo 在这两个不同月份提示词下的回复进行了统计,结果发现,在12月的输出平均比5月少了大约200个字符。

提示词为5月时,模型生成文本的平均长度是4298字符;12月则为4086字符。

为了测试更加严谨,@Rob Lynch 还做了 t-test,其中 p 值小于2.28×10−7,也就是说数据和假说之间的联系,几乎可以排除是偶然。

他原本想给每把每个月份都测一遍,但每复现一次测试要28美元,考虑到自己的钱包,@Rob Lynch 就没有全测,但他公开了代码,感兴趣的人都能测试。

代码链接:https://github.com/robalynch1122/OpenAISeasonalityTesting

@Rob Lynch 的发现也获得了实例支撑,GPT-4在12月的回复和5月的认真程度,有非常明显的直观差距。

图源:https://twitter.com/dgromero/status/1734672608036020246

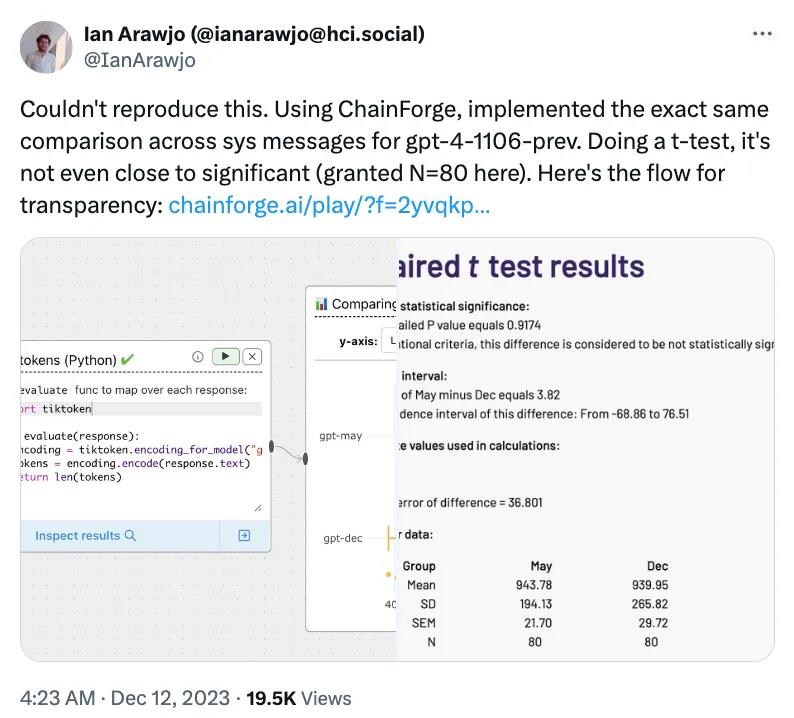

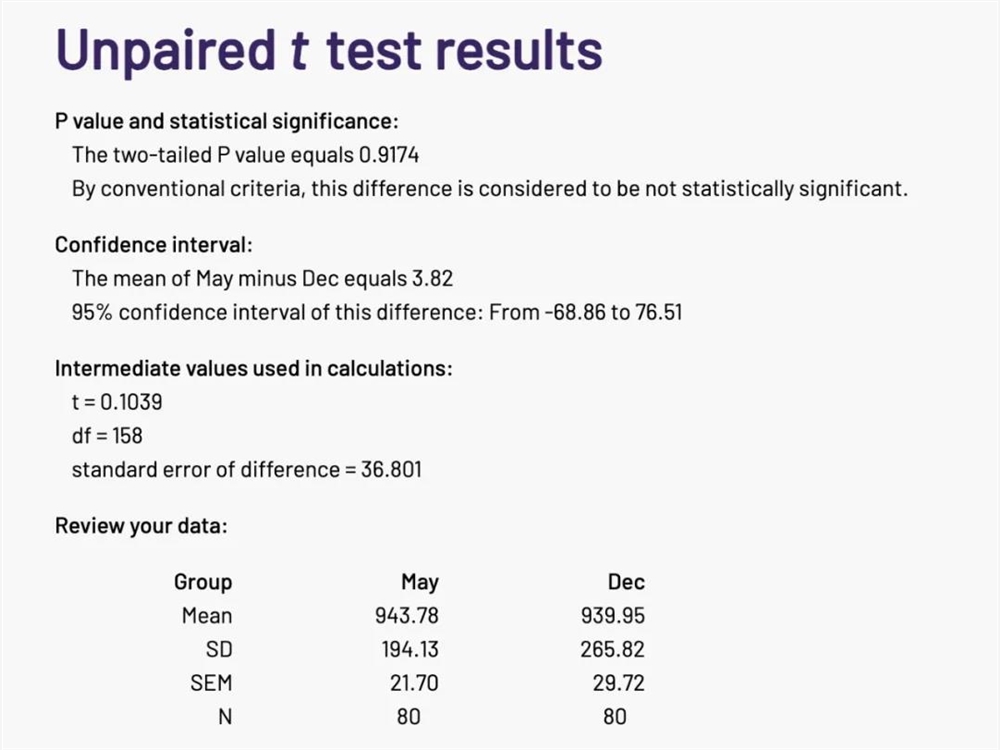

然而,当有人试图复现这个测试时,却发现大模型「偷懒」和放不放假之间没什么关系。

图源:https://twitter.com/IanArawjo/status/1734307886124474680

他对比了 GPT-4对于两种系统提示词的80条输出,t-test 的结果大于0.1,这一般被视为没有统计学意义。

@Rob Lynch 也以80个样本量重新测了一次,得到的 p 值是0.089,这次「偷懒」和放假之间就没什么关联了。随着样本量的增加,这个效果越来越显著。

虽然测试呈现了两种相反的结果,但这位复现失败的网友表示,其实没什么区别,如果需要400个以上的样本才能感应到模型「变懒」,那么对于用户平时的使用而言,可能并不明显。

图源:https://twitter.com/IanArawjo/status/1734321529117098465

目前,还没有尚无确凿数据支持所谓的「寒暑假假说」,但是 Claude 和 GPT-4都显示出了类似的「症状」。关于大型模型性能下降的真正原因,我们仍需耐心等待学术界的深入研究和解答。

阿里1688全面接入淘宝:重推源头厂货

据最新消息,阿里巴巴旗下知名B2B平台1688即将全面接入淘宝,携百万源头厂商直接入驻,为广大消费者带来更多优质源头厂货。这一战略举措的落地,意味着1688将开启全面入淘的新篇章。据悉,1688已经先期在淘宝开设了三家店铺,分别是严选淘宝店、企业自采天猫店和工业行家选天猫店,后续这些店铺将整合成一个类似天猫超市的频道,方便消费者一站式购物。站长网2024-03-25 17:34:000000安永与微软等科技巨头合作 发布EY.ai人工智能综合平台

国际专业服务领导者安永(EY)近日宣布,已投资14亿美元用于推出面向客户的人工智能综合平台EY.ai。该平台汇集了具有广泛功能的AI生态系统,旨在帮助客户加速AI技术的采用和应用。站长网2023-09-14 19:43:030000专家表示 :AI在学校作弊问题上的担忧目前尚无根据

#划重点:1.📊斯坦福教育学者的研究显示,自ChatGPT出现一年多以来,高中生作弊率虽然一直较高,但并未显著增加。2.🧠专家认为,作弊问题的根本原因通常不是技术本身,而是学生面临的压力和学校制度存在的问题。3.🤝教育专家建议家长、教师和学生进行开放对话,明确如何正确使用人工智能工具。0000巨人网络董事长史玉柱:短期内能看到 AI 经济效益的只有游戏领域

巨人集团创始人史玉柱现身公司在无锡市滨湖区拈花湾小镇举办的2023征途嘉年华。史玉柱现场发表演讲,谈及对《原始征途》下一步研发规划、AI(人工智能)、脑白金、元宇宙等话题。站长网2023-06-12 16:57:380000大模型数据标注平台Scale AI融资10亿美元,估值达138亿美元

划重点:⭐ScaleAI获得10亿美元F轮融资,估值达138亿美元,成为大模型领域独角兽。⭐ScaleAI主要提供数据标注服务,合作伙伴包括OpenAI、微软、Meta等知名公司。⭐Suno也获得1.25亿美元融资,两笔超过1亿美元的融资事件引发关注。站长网2024-05-22 18:43:120001