专家表示 :AI在学校作弊问题上的担忧目前尚无根据

# 划重点:

1. 📊 斯坦福教育学者的研究显示,自ChatGPT出现一年多以来,高中生作弊率虽然一直较高,但并未显著增加。

2. 🧠 专家认为,作弊问题的根本原因通常不是技术本身,而是学生面临的压力和学校制度存在的问题。

3. 🤝 教育专家建议家长、教师和学生进行开放对话,明确如何正确使用人工智能工具。

近期关于学生利用人工智能(AI)进行学术作弊的担忧似乎有些过于夸张。斯坦福教育学者进行了匿名调查和随访焦点小组讨论,针对高中生的使用情况,发现自ChatGPT一年多前问世以来,作弊率虽然一直相对较高,但并未呈现明显增长的趋势。

图源备注:图片由AI生成,图片授权服务商Midjourney

斯坦福研究显示,自15年前以来,学生自报作弊行为的比例一直在60%到70%之间,而自ChatGPT发布以来,这些比例并未发生显著变化。斯坦福研究生院教育学副教授Victor Lee表示:“任何人对AI产生担忧都是合理的,因为它能够完成许多任务并在我们生活中发挥重要作用。但就高中生作弊而言,我们并未观察到他们大规模转向使用AI的迹象。”

与此同时,斯坦福研究人员Denise Pope指出,技术本身通常不是驱使学生作弊的关键因素。“作弊是更大根本原因的一种症状,这是我们长期以来在学校中一直存在的问题。” 她强调,学生在感到无法承受或不理解作业时才会采取取巧的手段,他们在觉得被赋予没有实际目的的繁重任务时才会作弊。

Lee表示,AI已经成为生活的一部分,例如在Word文档中的拼写检查或短信中的自动完成等简单而良性的用途。他指出,他们关注的是剽窃行为,即让生成式AI形成文本并将其冒充为自己的工作。

虽然人工智能在创造性思维测试中表现出色,但研究者也指出,AI并不总是可靠的。即使ChatGPT在回答问题时表现得确信无疑,答案可能是错误的。然而,教育专家并不认为对学生实施人工智能禁令是正确的做法。

Lee表示,人工智能为学生提供了与几十年前计算器类似的机会和挑战。他认为,学生仍然应该知道如何完成工作,同时了解何时以及如何使用这个有价值的工具。人工智能可能对学生提供“初始想法”或帮助他们编辑论文等方面是有益的。

Pope和Lee强调,家长、教师和学生有必要就如何正确使用人工智能进行开放对话。他们建议父母与孩子谈论可用的技术以及他们对其使用的期望和背后的原因。

快2025了,电商该把流量成本打下来了

每个行业本身都有自己的发展路线,趋势使然。就像当年,大家苦于层层经销商加价,慢慢质变,电商应运而生;而这次,流量重税之下,历史的齿轮也开始转动。2024年接近尾声,回顾过去一年,电商行业经历了许多变化。0000周鸿祎开启首堂AI免费课:称PPT是忽悠人的最好工具

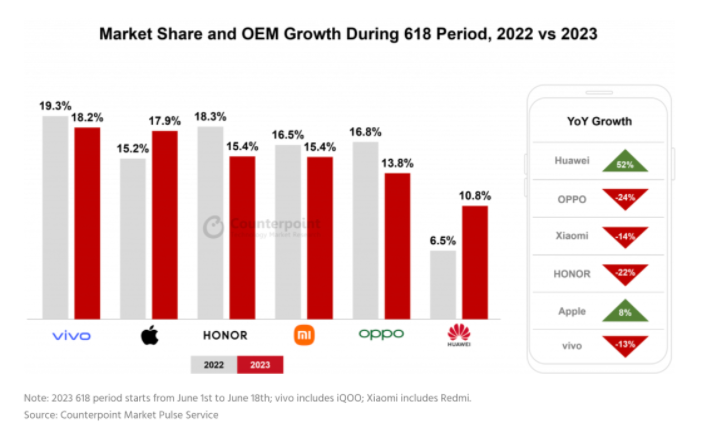

360集团的创始人及董事长周鸿祎今日在首堂AI免费课直播中分享了他对PPT的看法。他直言不讳地指出,PPT实际上是一种极具忽悠性的工具,那些内容的空洞和思想的不足,常常可以借由华丽的图像和精彩的金句得以掩饰。周鸿祎进一步表示,在他的公司内部,PPT是被禁止使用的,只有在对外交流时才会使用。他的这一观点显示了他对于真实、深入的沟通和交流的重视。站长网2024-02-29 16:23:420000数据:中国智能手机销量于2023年618促销季年同比下降8%

根据Counterpoint发布的618促销季主题报告,中国智能手机销量在2023年的618促销季(6月1日至6月18日)同比下降了8%。在智能手机品牌的竞争格局方面,vivo以18.2%的市场份额位居榜首,其次是苹果(17.9%)和荣耀(15.4%)。苹果公司在高端市场表现出色,年同比增长了8%,而在高端市场上没有强大的竞争对手。为了扩大iPhone的销量,电商网站提供了约20%的折扣。站长网2023-07-12 07:08:140001单场点赞破2亿、曹云金“相声直播”冲击线下剧场生态

“专业能力真的很厉害。直播从相声发展历史,马三立、马季、姜昆、冯巩等相声大师的特点、段子,娓娓道来,娴熟自如。非泛泛之辈能比。”“还是郭德纲最好的徒弟,云鹤九霄不如一曹。”凭借着“相声直播”,曹云金翻红了。在视频评论区,几乎全是对他专业能力的夸赞,对德云社其他人的“踩”,而昔日那段与师父郭德纲的恩怨,以及随之崩盘的人设和口碑,网络评论区刷屏的“孽徒”,也实现了反转。站长网2023-05-25 14:12:430000美国众议院众多党派领导人携手成立跨党派人工智能特别工作组

**划重点:**1.🏛️美国众议院两党领导人宣布成立人工智能特别工作组,致力于应对人工智能的迅猛崛起。2.🤝特别工作组由约翰逊(共和党)和杰弗里斯(民主党)领导,将制定关于人工智能的潜在监管框架和国会可采取的政策步骤的全面报告。3.💼特别工作组的主席是奥伯诺尔特(共和党)和刘特(民主党),成员包括来自两党的国会议员,旨在推动人工智能领域的合作和立法进展。站长网2024-02-21 10:24:250000