AI输出是否受到言论保护?法律专家警告称这是危险的提议

**划重点:**

1. 🗣️ 一些美国法律专家认为大型语言模型(LLM)的输出受到第一修正案的保护,但法律专家Peter Salib表示这将带来灾难性后果。

2. 🤯 Salib担心,如果GPT-5等模型的输出被视为受到保护的言论,将难以监管这些系统,可能导致严重后果。

3. 🚫 他提倡对AI输出进行合理监管,强调法规应该关注输出内容本身,而不是过程,以规避潜在的危险。

人工智能(AI)输出是否受到言论保护,引起了法律专家的激烈争议。美国的一些法律专家认为,大型语言模型(LLM)如ChatGPT的输出应受到第一修正案的保护,即言论自由的权利。然而,法律专家Peter Salib对此提出了警告,表示这样的观点可能会带来严重的后果。

图源备注:图片由AI生成,图片授权服务商Midjourney

Salib指出,如果将GPT-5等模型的输出视为受到保护的言论,这将给监管这些系统带来极大困难。他认为,受保护的言论是一种神圣的宪法范畴,如果AI的输出被认定为受到保护,那么我们将很难对这些系统进行有效的监管。

一些法律专家辩称,像ChatGPT这样的系统是“无可否认地有表现力的”,它们生成的内容被视为言论,有时具有说服力和高度表现力。然而,Salib反驳称,AI的输出并非来自具有第一修正案权利的任何讲话者,也不是任何人类的表达。

同时,随着AI的迅速发展,其输出变得越来越危险。Salib指出,生成AI已经具备发明比VX(一种最有毒的神经毒剂之一)更致命的新化学武器的能力,并能协助恶意人类合成它们;还能帮助非程序员入侵重要基础设施,以及进行复杂的操纵游戏。这些情况使得AI输出可能导致生命、肢体和自由的严重风险。

为了规避未来的风险,Salib主张对AI输出本身进行规范,而不是阻止系统产生有害的输出。他认为,成功的AI安全法规应包括关于模型允许“说什么”的规则。这样的规则可以多样化,例如,如果AI的输出经常具有高度危险性,法律可以要求模型保持未发布状态,甚至被销毁。这将为AI公司提供更强大的激励,投资于安全研究和严格的协议。

知乎崩了上热搜 网友称页面显示“服务繁忙,请稍候再试”

就在刚刚,知乎崩了登上微博热搜。有网友表示,在知乎无法搜索到任何信息,知乎书架也无法打开,显示“服务繁忙,请稍候再试”“似乎出了点问题···”。对此,知乎官方暂未回应。经小编测试,目前知乎可以正常访问。站长网2023-05-16 14:20:020000用视觉来做Prompt!沈向洋展示IDEA研究院新模型,无需训练或微调,开箱即用

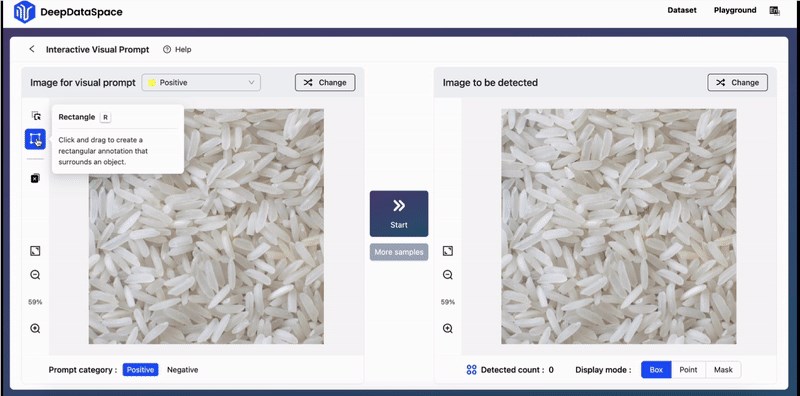

用视觉来做Prompt,是种什么体验?只需在图里随便框一下,结果秒秒钟圈出同一类别!即便是那种GPT-4V都难搞定的数米粒的环节。只需要你手动拉一下框,就能找出所有米粒来。新的目标检测范式,有了!刚刚结束的IDEA年度大会上,IDEA研究院创院理事长、美国国家工程院外籍院士沈向洋展示了最新研究成果——基于视觉提示(VisualPrompt)模型T-Rex。站长网2023-11-26 21:07:460002苹果发布全新 AR 应用 Deep Field

苹果官方宣布,推出AR应用DeepField,DeepField是一款基于iPadPro和ApplePencil的全新沉浸式艺术体验app,由澳大利亚著名艺术与创意技术二人组Tin&Ed(TinNguyen与EdwardCutting)创造。站长网2023-07-06 09:43:390003剪映已支持杜比视界HDR格式视频制作 目前仅支持苹果设备

站长之家(ChinaZ.com)5月20日消息:杜比官方宣布,剪映用户现可通过iOS、iPadOS和macOS设备,对杜比视界HDR格式视频进行剪辑和导出,轻松实现杜比视界格式视频的制作,这将进一步提升用户的视频创作品质,推动更多优质视频内容的产出。站长网2024-05-20 22:10:540000微信正式上线送礼物功能:入口与红包并列

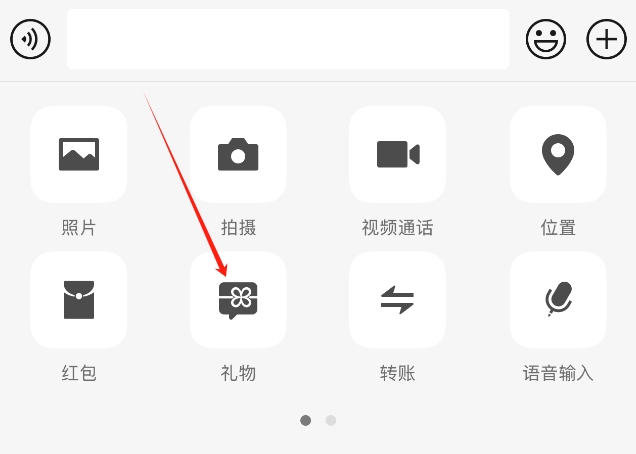

站长之家(ChinaZ.com)1月17日消息:微信近日正式推出了送礼物功能,为用户之间的社交互动增添了新的乐趣和体验。现在,当用户与好友聊天时,会注意到一个与红包功能并列的“送礼物”选项,这一功能位于显著位置,方便用户快速使用。站长网2025-01-17 09:23:470000