研究表明,AI图像生成器正在接受儿童露骨照片进行训练

划重点:

- 🚩 报告指出,人工智能图像生成器的基础中隐藏着数千张儿童淫秽照片。

- 🚩 这些图片使得 AI 系统更容易生成逼真的虚假儿童图片,并将社交媒体上全副武装的真实青少年照片转化为裸体照片。

- 🚩 这个问题没有简单的解决办法,需要公司采取行动来解决技术中的漏洞。

根据一份新报告,人工智能图像生成器的基础中隐藏着数千张儿童淫秽照片,该报告敦促公司采取行动解决技术中的缺陷。

这些图片使得 AI 系统更容易生成逼真的虚假儿童图片,并将社交媒体上全副武装的真实青少年照片转化为裸体照片,这对学校和公共安全构成了威胁。以前,反虐待研究人员认为,一些未经检查的 AI 工具生成虐待儿童的图片的唯一方法是将它们从两个不同的在线图像库中学习到的知识相结合:成人色情图片和儿童无害图片。

然而,斯坦福大学互联网观察中心在人工智能数据库 LAION 中发现了超过3200张涉嫌儿童淫秽图片。LAION 是一个包含在线图片和标题的索引,已经被用来训练领先的 AI 图像生成器,比如 Stable Diffusion。斯坦福大学观察中心与加拿大儿童保护中心和其他反虐待慈善机构合作,识别出这些非法材料,并向执法部门举报原始图片链接。

图源备注:图片由AI生成,图片授权服务商Midjourney

在斯坦福大学互联网观察中心首次发布报告的前一天,LAION 告诉美联社,他们正在暂时删除数据集。LAION 在一份声明中表示,他们 “对非法内容采取零容忍政策,为了确保数据安全,我们已经将 LAION 数据集下架,待重新发布之前。” 虽然这些图片只占到 LAION58亿张图片索引的一小部分,但斯坦福小组表示,它们很可能影响 AI 工具生成有害输出的能力,并加强以前对真实受害者的虐待。

这个问题没有简单的解决办法,根源在于许多生成型 AI 项目 “实际上是被匆忙推向市场”,并且因为领域竞争激烈,所以变得广泛可访问,斯坦福大学互联网观察中心的首席技术专家大卫・蒂尔在报告中说道。蒂尔表示:“对整个互联网进行爬取,并将其数据集用于训练模型,这本应该是一个研究操作的限制,如果有的话,并不是应该没有经过更加严格的注意就开源的东西。”

一个重要的 LAION 用户,也是对数据集开发起到推动作用的公司是 Stability AI,他们开发了 Stable Diffusion 的文本到图像模型。新版本的 Stable Diffusion 使得创建有害内容变得更加困难,但是2022年引入的旧版本仍然与其他应用和工具交织在一起,根据斯坦福报告。加拿大儿童保护中心的信息技术主任劳埃德・理查德森表示:“我们无法收回来。这个模型现在在许多人的本地机器上。”Stability AI 表示,他们只托管了 Stable Diffusion 的经过过滤的版本,并且在接手独家开发 Stable Diffusion 之后,采取了 “主动措施来减少滥用的风险。”

LAION 是德国研究员克里斯托弗・舒曼的创意,他今年早些时候告诉美联社,将如此庞大的视觉数据库公开可访问的部分原因是为了确保 AI 发展的未来不会被少数强大的公司控制。“如果我们能使其民主化,使整个研究界和广大公众受益,那么它将更安全、更公平,” 他说道。

反儿童性虐待组织 Thorn 的数据科学主任丽贝卡・波顿表示,她的组织进行的研究显示,虐待者使用 AI 生成的图片的普遍性很小,但是持续增长。开发者可以通过确保用于开发 AI 模型的数据集不包含滥用材料来减轻伤害。波顿表示,在模型流通之后也有减少滥用的机会。

亚运会“前夜”,B站、京东等大厂押注“电竞”生意经

亚运会开幕前一个月,电竞赛道已经风起云涌。8月8日,2023英雄联盟全球总决赛LPL赛区资格赛结束,JDG、BLG、LNG和WBG四支战队将作为LPL一至四号种子,代表中国参加英雄联盟全球总决赛。同日,有媒体报道称,作为过去三年S赛事独家版权方的B站,正式拿下今年英雄联盟S13全球总决赛的转播权。站长网2023-08-10 14:04:550000内容IP,流量生意之外的另一条道路

腾讯视频一开年就出了王炸。作为一部在播出前,全网总预约数超过了800万的绝对大热剧,由赵丽颖、林更新主演的仙偶大剧《与凤行》在3月18日首播,开播146分钟热度破28000,创腾讯视频最快进必看俱乐部剧集纪录。站长网2024-03-20 17:04:300000消息称iPhone15和iPhone15Plus将升级到4800万摄像头

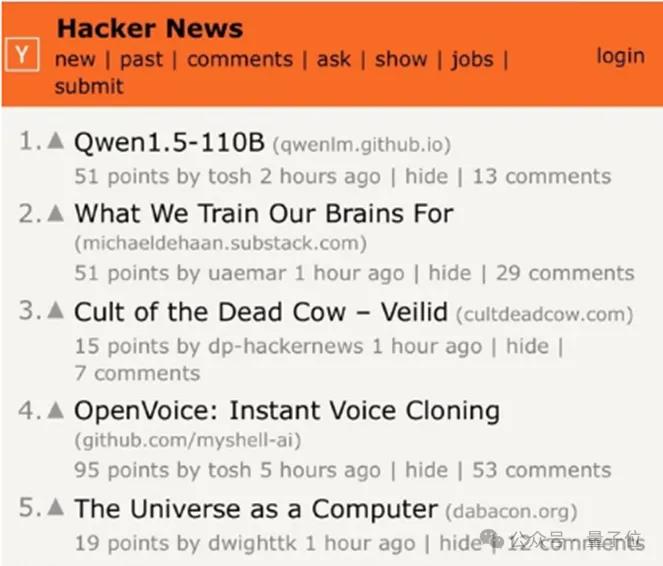

近日有外媒带来了关于标准版iPhone15和iPhone15Plus在影像方面的升级细节。据外媒PhoneArena最新消息,iPhone15和iPhone15Plus的两个标准版本将升级到与iPhone14Pro系列相同的4800万像素摄像头。这个4800万像素的主摄像头可以提供更好的暗光感光能力,从而拍摄出更好的1200万像素夜间照片。站长网2023-07-17 23:38:090000开源大模型王座再易主,通义千问1100亿参数拿下SOTA,3个月已推出8款模型

开源大模型,已经开启大卷特卷模式。全球范围,太平洋两岸,双雄格局正在呼之欲出。Llama3中杯大杯刚惊艳亮相,国内通义千问就直接开源千亿级参数模型Qwen1.5-110B,一把火上HackerNews榜首。站长网2024-05-01 17:08:430002生活服务体验员成正式职业!抖音:过去一年228.7万人靠探店获得收入

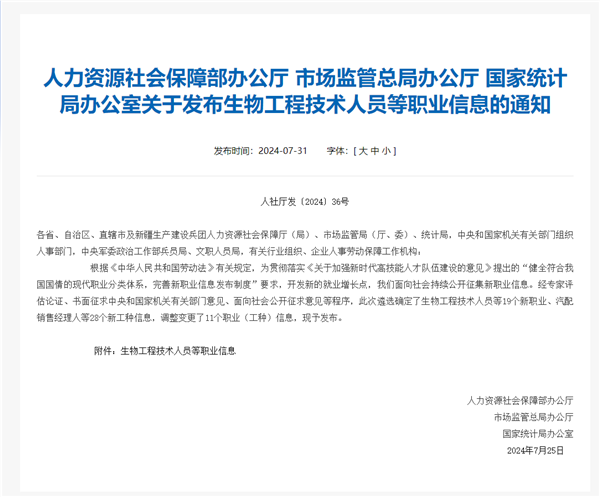

快科技7月31日消息,人力资源社会保障部、国家市场监督管理总局、国家统计局联合发布新一批新职业信息,其中包括了生活服务体验员等28个新工种。这也意味着诸多探店达人,正式成为官方认可的生活服务体验员”。抖音生活服务数据揭示了探店行业的迅猛发展:过去12个月,抖音上有228.7万人通过探店获得收入,探店达人规模同比增长40%,助力商家收入提升63%。站长网2024-08-01 10:33:400000