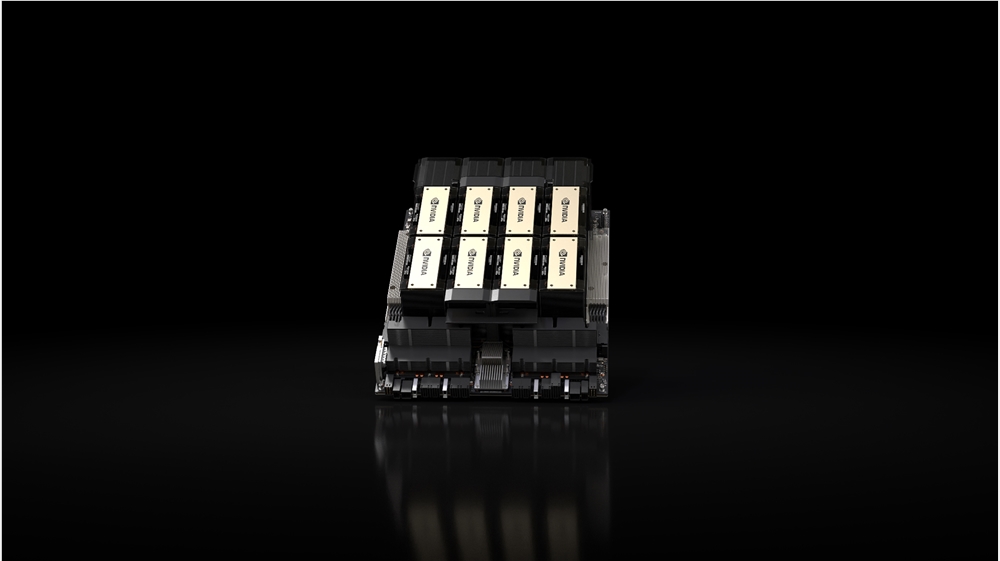

英伟达推出 AI 领域顶尖新芯片 HGX H200:以更高性能满足生成式 AI 需求

英伟达公司当地时间周一宣布,推出其 AI 工作的新一代顶级芯片 —— HGX H200。该新 GPU 在其广受欢迎的前代产品 H100 的基础上,实现了1.4 倍的内存带宽提升和 1.8 倍的内存容量增加,大幅提高了其处理密集型生成 AI 工作的能力。

然而,目前市场对于这些新芯片的可获得性仍存疑问,尤其是考虑到 H100 的供应限制。英伟达尚未就此问题提供明确答复。英伟达公司表示,首批 H200 芯片将于 2024 年第二季度发布,目前正与「全球系统制造商和云服务提供商」合作以确保芯片的可用性。英伟达发言人 Kristin Uchiyama 对生产数量不予置评。

除了内存之外,H200 在其他方面与 H100 大体相同。但内存的改进使其成为了一次有意义的升级。这款新 GPU 是首个使用新型、更快的 HBM3e 内存规格,将其内存带宽提高至每秒 4.8TB,相较于 H100 的 3.35TB 有显著提升,总内存容量也从 80GB 增至 141GB。

英伟达高性能计算产品副总裁 Ian Buck 在今天的视频演示中表示:「更快更大容量的 HBM 内存的整合,旨在加速包括生成 AI 模型和高性能计算应用在内的计算密集型任务的性能,同时优化 GPU 的利用率和效率。」

H200 还设计为与已支持 H100 的系统兼容。英伟达表示,云服务提供商在加入 H200 时无需进行任何改动。亚马逊、谷歌、微软和甲骨文的云服务部门将是明年首批提供新 GPU 的公司之一。

新芯片一经推出,定将售价不菲。虽然英伟达未公布其价格,但据 CNBC 报道,上一代 H100 的估计售价在每颗 25000 至 40000 美元之间,运行顶级水平的系统需要数千颗。Uchiyama 表示,定价由英伟达的合作伙伴决定。

随着 AI 公司仍然迫切寻找 H100 芯片,英伟达的这一公告具有重要意义。英伟达的芯片被视为高效处理生成图像工具和大型语言模型所需巨量数据的最佳选择。这些芯片足够珍贵,以至于有公司使用它们作为贷款的抵押。谁拥有 H100 成为硅谷的热门话题,初创公司甚至合作共享这些芯片的任何可用性。

Uchiyama 表示,H200 的推出不会影响 H100 的生产。「你将看到我们在今年增加整体供应,并且我们正在长期供应购买,」Uchiyama 在发给 The Verge 的电子邮件中写道。

展望明年,对于 GPU 买家来说或许是更加吉利的时期。英国《金融时报》今年 8 月报道称,英伟达计划在 2024 年将 H100 的产量增加三倍。目标是明年生产多达 200 万颗,相比之下 2023 年约为 50 万颗。但随着生成式 AI 的需求如今仍与年初一样旺盛,需求可能只会更大——这还不包括英伟达推出的更热门新芯片。

影石公司年会送5台理想L7 李想:你们公司还招人吗

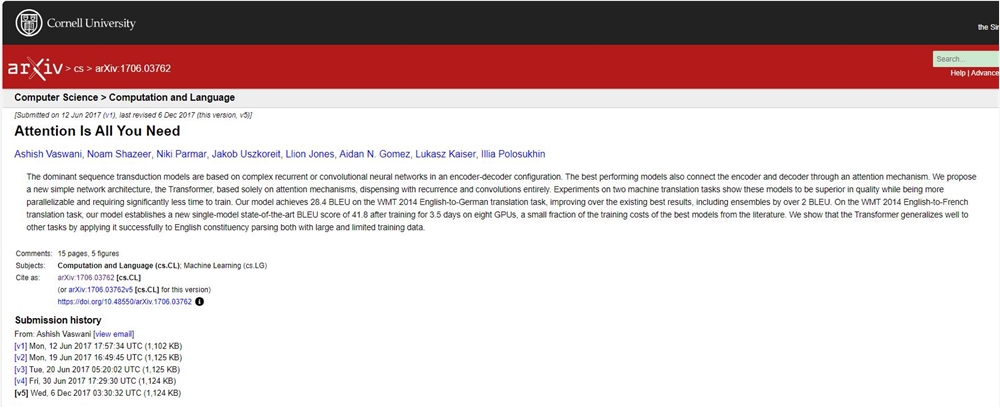

快科技2月7日消息,影石Insta360官方发文称,公司年会送出5台理想L7和超200万的奖品,其中,苹果VisionPro是年会的特等奖。看到如此丰盛的年会奖品,不少网友也酸了,理想汽车CEO李想转发该微博,并询问:你们公司还招人吗?影石Insta360”官方也相当识趣,直接@了他们老板,这里有一位老板说想入职咱们公司”。站长网2024-02-08 15:20:490000AI圈头条!谷歌Transformer开山论文惊天「翻车」

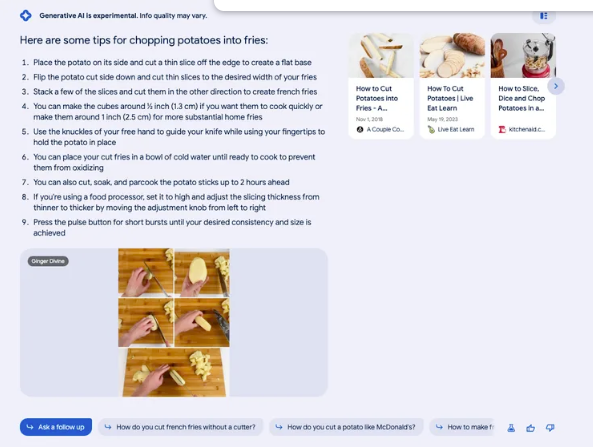

AI圈大头条!谷歌大脑的NLP奠基之作、提出Transformer架构的开山鼻祖级论文《AttentionIsAllYourNeed》竟然出现图与代码不一致的问题。站长网2023-05-10 10:02:270001谷歌AI搜索功能展示更多视频和优质链接

本文概要-谷歌的人工智能搜索生成体验正在增加图像和视频功能。-视频功能对于搜索体验非常重要,谷歌已经将YouTube逐渐整合到搜索结果中。-SGE摘要中已经开始显示发布日期和图片。谷歌的人工智能搜索正在加强图像和视频功能。如果启用基于AI的SGE功能,用户可以在搜索结果顶部的彩色摘要框中看到更多的多媒体内容。站长网2023-08-03 10:05:080000蚂蚁金融大模型已在理财和保险领域进行应用测试

蚂蚁集团宣布联合信通院发布金融大模型行业标准。蚂蚁集团表示,8月底,蚂蚁金融大模型已通过证券从业资格、保险从业资格、执业医师资格、执业药师资格等专业试题测试。站长网2023-09-20 08:32:1000002024 vivo开发者大会官宣:OriginOS 5/自研蓝河系统2降临

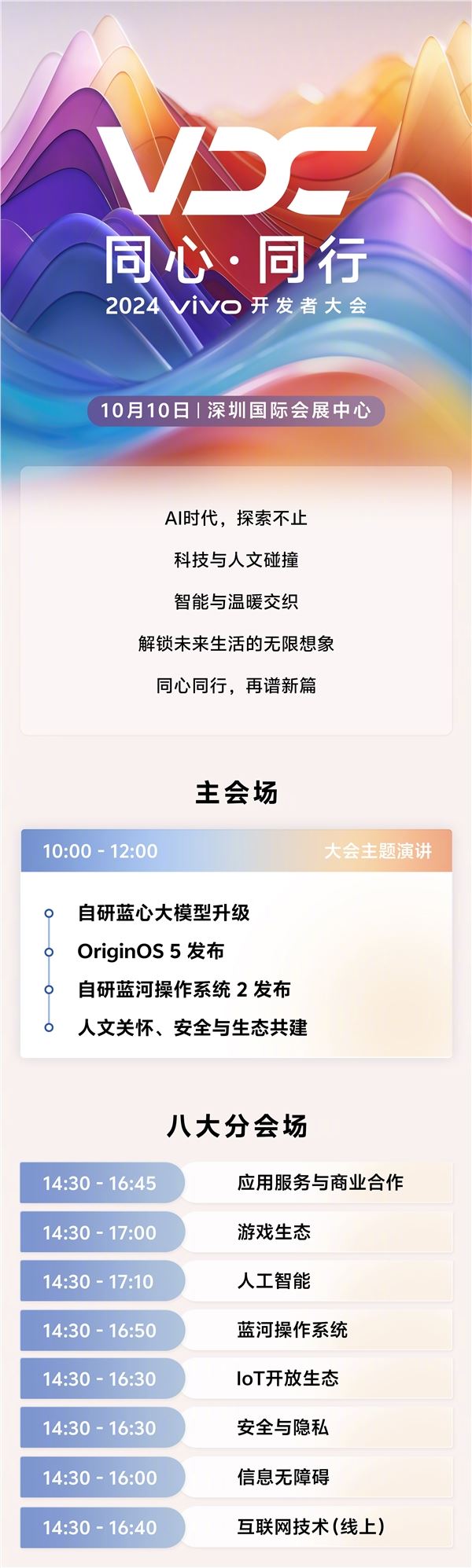

快科技9月20日消息,今天,vivo宣布将于10月10日在深圳举行2024vivo开发者大会,正式发布OriginOS5和自研蓝河操作系统2,还有人文关怀、安全及生态共建等议题。据悉,OriginOS5将带来全新的蓝心大模型,这一重要技术成果将在OriginOS中实现系统级和场景化的深度落地。蓝心大模型将涵盖语言、语音、视觉、多模态以及端侧等多个维度,全面升级用户与智能设备的交互体验。站长网2024-09-20 23:40:360000