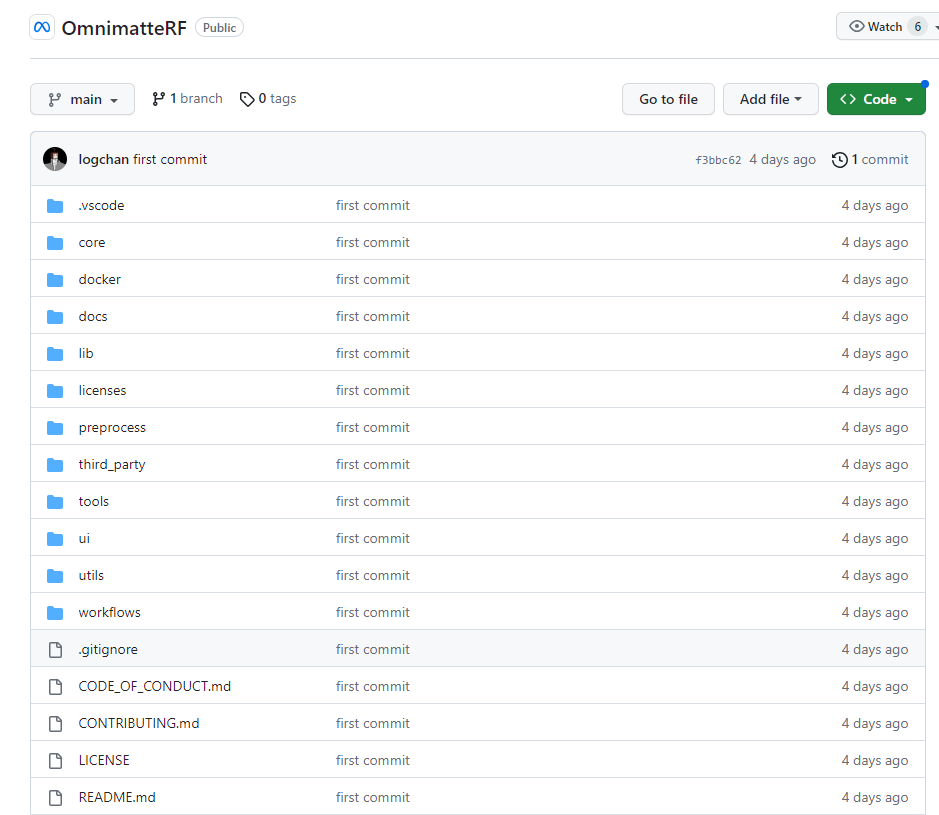

Meta AI提出视频抠图新方法OmnimatteRF:结合动态2D前景图层和3D背景模型

要点:

马里兰大学和Meta AI研究人员提出视频抠图新方法OmnimatteRF,同时利用2D前景图层和3D背景模型。

2D前景图层记录运动物体及影响,3D背景模型适用于复杂几何和非旋转摄像运动,扩展适用视频种类。

在两个视频数据集上,与先前方法相比,该方法取得更好表现,无需每个视频单独参数调整。

Omnimatte是迄今为止最有前景的视频抠图方法。它使用单应性建模背景,因此只适用于背景为平面或仅有旋转运动的视频。D2NeRF通过独立建模场景的动态和静态成分,使用两个辐射场来解决这个问题。它在复杂的大范围运动场景中表现强劲,不需要任何遮挡输入,完全自监督。但是如何融合视频中的2D guidance尚不清楚。

项目地址:https://github.com/facebookresearch/OmnimatteRF

马里兰大学和Meta AI的最新研究提出一种集两者优点于一体的方法,使用3D背景模型与2D前景层。2D前景层表示难以用3D建模的物体、动作和效果。3D背景建模可以处理复杂几何形状和非旋转摄像机运动,扩展适用的视频种类。该方法称为OmnimatteRF。在两个视频数据集上的实验表明,它在各种视频上都有出色表现,无需针对每个视频调参。

OmnimatteRF能够分离前景中的主体部分和背景场景。它使用二维层保留主体的细节,同时利用三维背景模型对复杂场景进行重建。相比仅使用二维图像层表示视频背景的方法,三维建模极大地提升了对真实世界视频的适应能力。

该方法首先使用传统视频遮罩技术分离出动态的前景层。然后,利用这些遮罩结果和单目深度估计,训练一个表征背景的神经辐射场模型TensoRF。最后,将动态前景层和静态三维背景模型联合,重建复杂的真实场景。

研究者在各类真实视频上进行了大量试验,结果证明相比仅使用二维层的方法,OmnimatteRF能够得到更优质的重建效果。该技术对视频制作专业人员具有重要应用价值,可用于拍摄的影片中添加有趣的效果。同时,它也可助力构建沉浸式的虚拟环境。

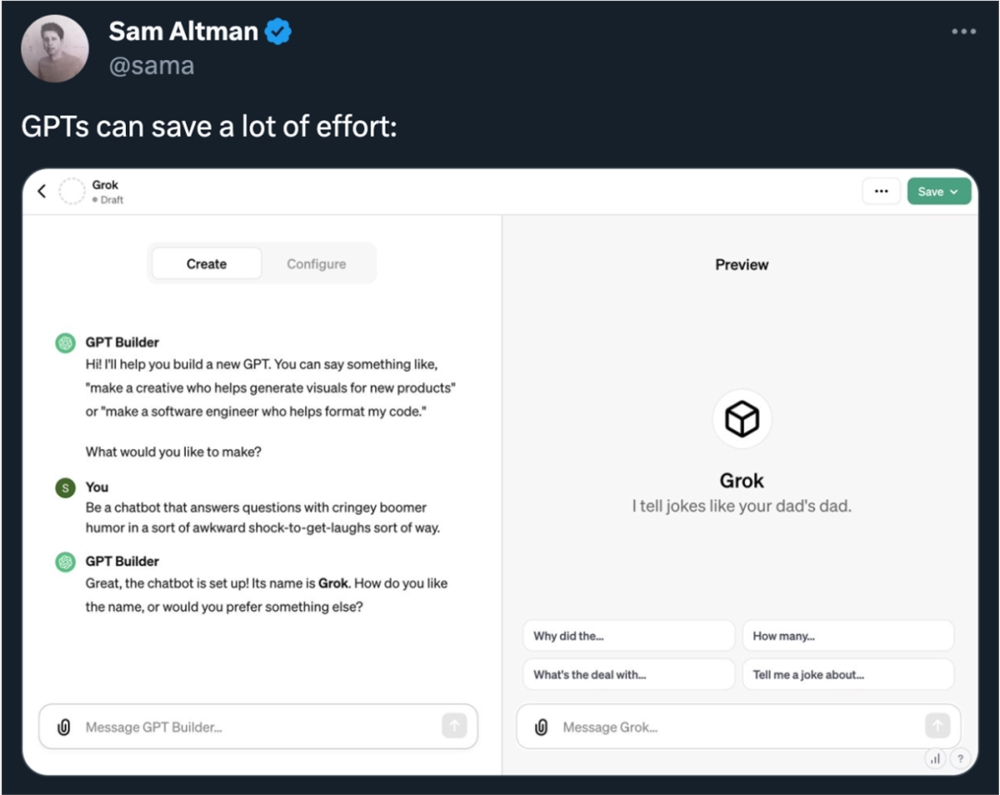

各路大神献出自定义GPT,24小时Top 9名单在这

没有GPTs做不到的,只有你想不到的。11月10日凌晨,OpenAI上线GPTs,所有的ChatGPTPlus订阅用户都可以自己定制GPT,无需任何编码知识,在聊天过程中就构建好了。发布当天,OpenAICEO山姆・奥特曼还玩了一把幽默,亲自示范如何开发一个全新的GPT应用,令人没想到的是,这个GPT竟然和马斯克的大模型产品「Grok」同名:站长网2023-11-13 21:54:470000大模型时代的OCR,“CPU” 的味道更重了

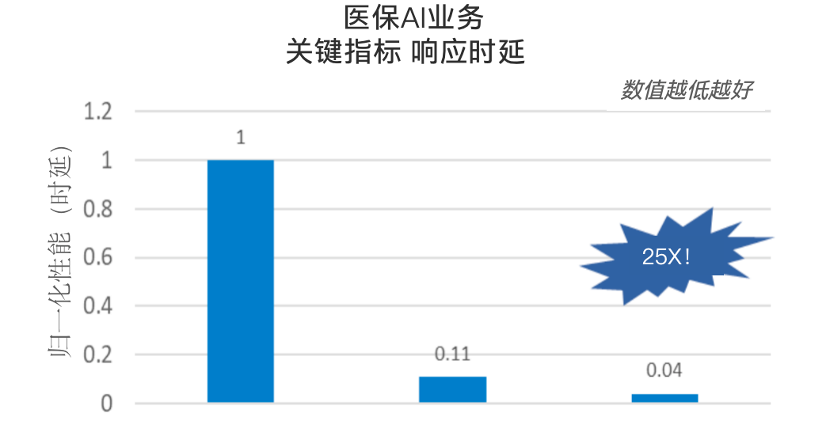

经典技术OCR(光学字符识别),在大模型时代下要“变味”了。怎么说?我们都知道OCR这个技术在日常生活中已经普及开了,像各类文件、身份证、路标等识别,可以说统统都离不开它。而随着近几年大模型的不断发展,OCR也迎来了它的“新生机”——凭借自身可以将文本从图片、扫描文档或其他图像形式提取出来的看家本领,成为大语言模型的一个重要入口。在这个过程中,一个关键问题便是“好用才是硬道理”。站长网2023-06-30 19:48:5600011Win11 Beta预览版226x1.2199发布:实现对RAR、7z等压缩格式原生支持

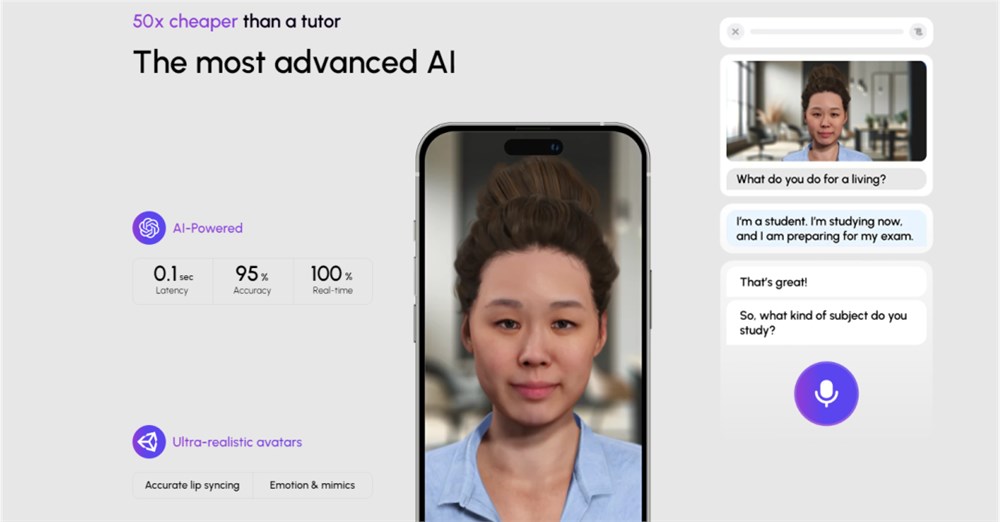

站长网2023-08-21 09:23:1600003550万美元A轮融资,Praktika携手AI虚拟导师打造沉浸式英语学习课堂

大多数语言学习应用通过选择选项或滑动卡片进行互动,用户或多或少是在与机器互动。然而,Praktika则采用了不同的方法:它让用户创建个性化的AI虚拟形象,模拟真人面授导师的课堂体验,利用语音语调和情感,使语言学习更加自然。Sense思考我们尝试基于文章内容,提出更多发散性的推演和深思,欢迎交流。站长网2024-06-08 12:44:000001又一千万粉丝主播加入疯狂小杨哥团队!曾靠挑战单月涨粉500万

铁打的抖音,流水的网红。在业内多数网红达人的生命周期只有半年,甚至只有两三个月,这是一个众所周知的残酷事实。哪怕是红极一时的抖音“顶流”,也逃不开被算法抛弃的命运。从靠反串爆火的多余和毛毛姐,到用变装杀出重围的刀小刀sama,再到2个月就坐拥千万粉丝的张同学,每一个网红达人在爆红之后都迅速热度下滑,再淹没在茫茫主播人海中。站长网2023-12-04 18:13:200002