exllamav2:一个用于在现代消费 GPU 上运行本地 LLM 的推理库

站长网2023-09-15 10:24:040阅

exllamav2是一个用于在现代消费级GPU上本地运行大型语言模型(LLM)的快速推理库。它能够利用最新的GPU技术,在不牺牲太多质量的情况下,以非常快的速度对巨大的神经网络进行推理。

项目地址:https://github.com/turboderp/exllamav2

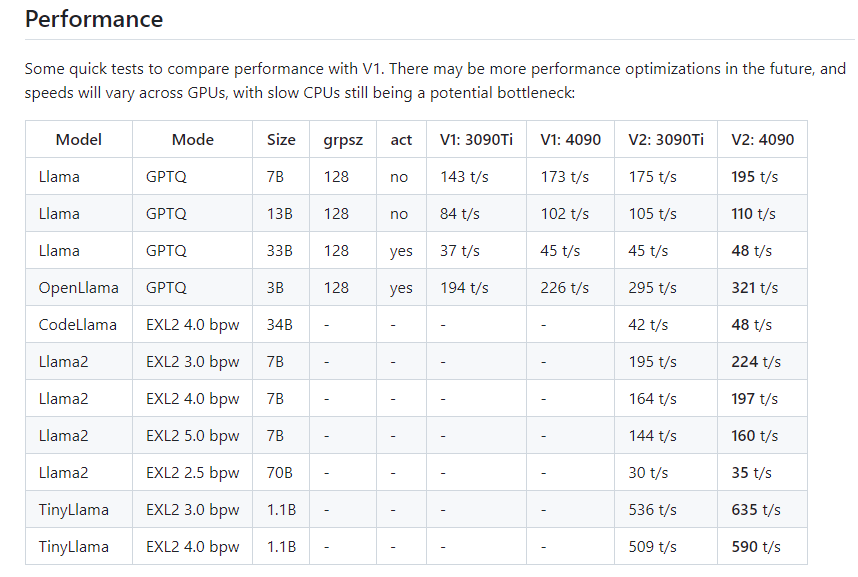

这个库采用了全新的代码库和内核实现,相比之前的版本获得了显著的性能提升。ExLlamaV2支持与 V1相同的4位 GPTQ 模型,但也支持新的“EXL2”格式。EXL2基于与GPTQ相同的优化方法,支持2、3、4、5、6和8位量化。该格式允许在模型内混合量化级别,以实现每个权重2到8位之间的任何平均比特率。这样既可以充分利用GPU的计算能力,又可以控制模型大小,适应不同的显存限制。

在测试中,利用EXL2格式,一个70B参数的模型可以在单块24GB显存的GPU上运行,一个13B参数的模型也可以在8GB显存中顺畅地进行推理。这为在普通的台式机上本地运行大模型打开了可能性。相比之前的版本,新的内核和代码架构也带来了1.5-2倍的速度提升。

这个库还集成了与HuggingFace模型的兼容性,提供了文字生成的交互式示例,以及将模型转换为量化格式的脚本。它的目标是成为一个易于入门和使用的LLM推理解决方案,让更多的人可以无障碍地体验和应用LLM带来的强大能力。

总之,exllamav2是一个非常有前景的LLM推理库。它为利用家用GPU资源运行大模型提供了一个切实可行的途径。随着它的不断发展和优化,相信它一定会让LLM的应用变得更加普及。

核心功能:

- 支持4位GPTQ模型

- 支持新的EXL22-8比特可调量化格式

- 大幅提升的推理性能

- 易于安装和使用

- 支持HuggingFace模型转换

- 提供交互式示例

0000

评论列表

共(0)条相关推荐

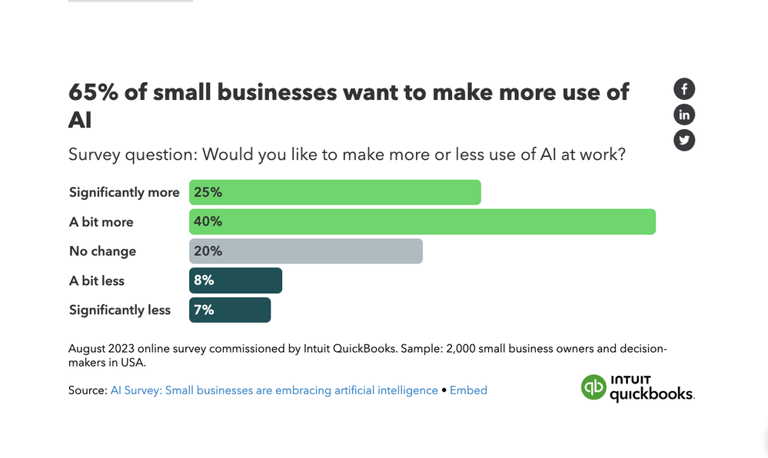

美国小型企业如何看待AI?近三分之二企业希望更多地利用AI技术

文章概要:1.根据IntuitQuickBooks委托进行的一项新调查,美国小型企业普遍认为人工智能有助于降低成本并与大型竞争对手竞争。2.这项调查揭示了小型企业对AI的积极态度,认为它可以提高效率、增加利润,并为未来的增长创造机会。3.尽管积极看待AI,小型企业也表达了对数据隐私和安全的担忧,需要解决这些问题以进一步采纳AI技术。站长网2023-10-11 18:25:010002苹果代号 Quartz 的基于人工智能的健康辅导付费服务或于 2024 年推出

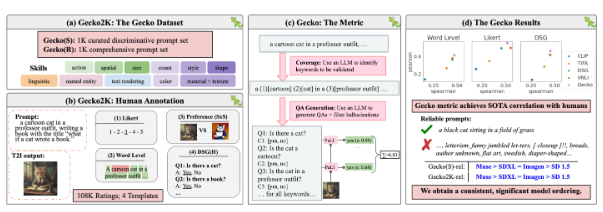

据彭博社MarkGurman报道,苹果计划在6月展示的iOS17更新将包括几个与健康有关的新功能。将会有一个跟踪情绪的功能,另外苹果计划首次将「健康」应用带到iPad上。站长网2023-04-26 14:23:160000谷歌DeepMind新方法Gecko,为测试AI图像生成器引入严格新标准

划重点:⭐谷歌DeepMind发布了新的基准Gecko,揭示了当前文本到图像AI评估方法的缺陷,并引入了一个包含超过10万份人类评分的严格新标准。⭐“Gecko”基准通过2000个文本提示对文本到图像模型全面评估,同时提供了增强的自动评估指标,揭示了先前未被发现的模型优和劣势。站长网2024-04-30 13:03:060000三星第三季度利润预计下滑 80% 人工智能高带宽内存芯片强劲需求仍是亮点

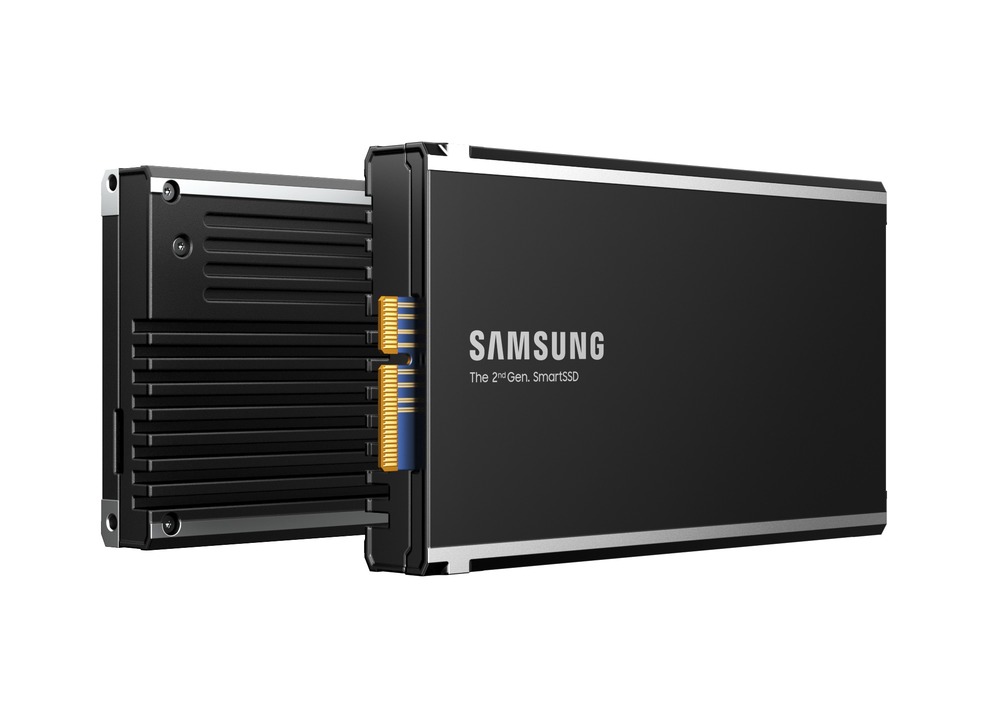

站长之家(ChinaZ.com)10月10日消息:三星电子预计,由于全球芯片供应过剩问题持续影响,第三季度利润将较去年同期下降80%。这意味着通常是韩国科技巨头的摇钱树业务将出现亏损。作为全球最大的内存芯片、智能手机和电视制造商,三星将于周三公布其第三季度初步财报。站长网2023-10-10 15:42:070001亚马逊研究人员利用深度学习增强神经网络分析复杂表格数据

划重点:🔍神经网络在处理异构列的表格数据时面临挑战🔍提出一种将表格特征转化为低频表示的方法🔍实验证明该方法能提升神经网络的性能和计算效率亚马逊的研究人员在一篇论文中介绍了一种创新方法,旨在增强神经网络处理复杂表格数据时的性能。表格数据通常由行和列组成,看似简单,但当这些列在性质和统计特征上差异巨大时,就会变得复杂起来。0000