清华提出4比特优化器 显著减少LLaMA微调的显存需求

站长网2023-09-08 14:05:230阅

要点:

1、针对优化器状态的量化方法,将优化器状态的数值精度降低至4比特

2、提出了针对一阶矩和二阶矩的量化策略,处理了零点问题等难点

3、在多个微调任务中达到全精度优化器的性能,同时可将LLaMA微调的显存需求减少超过50%

随着大模型规模的不断增大,显存需求成为模型训练的主要瓶颈之一。优化器状态中的一阶矩和二阶矩是占用大量显存的重要因素。为降低显存使用,清华大学朱军、陈键飞团队在ICLR2022的工作基础上,进一步将优化器状态的比特数降低到4比特,同时针对一阶矩和二阶矩的不同特点,提出了相应的量化策略。

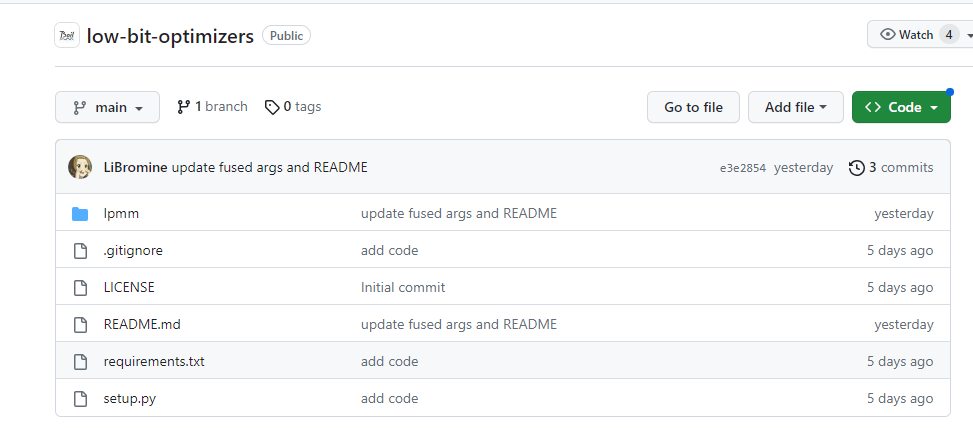

项目地址:https://github.com/thu-ml/low-bit-optimizers

对于一阶矩,由于存在按行或列分布的异常值,提出采用更小的128大小的分块进行归一化。对二阶矩,确定零点问题是主要难点,去除零点的线性映射取得了很好效果,同时提出rank-1归一化更好地处理异常值。最后,提出了4比特AdamW和Factor两种低精度优化器。

在多个经典的微调任务中进行评估,结果表明4比特优化器能够匹配甚至超过32比特AdamW的性能。同时显著减少了优化器状态的显存需求,在LLaMA-7B的微调中最高可节省57.7%的显存。提供了开箱即用的PyTorch接口,只需要一行代码即可使用。

本研究工作展示了通过压缩的思路显著减少大模型微调中的显存瓶颈的可能性。同时优化器状态的低比特设计也为进一步探索内存高效的训练算法提供了有价值的经验。这些成果将促进大模型在有限硬件条件下的高效训练与应用。

0000

评论列表

共(0)条相关推荐

科大讯飞2024大模型目标:上半年达到GPT-4 Turbo水平

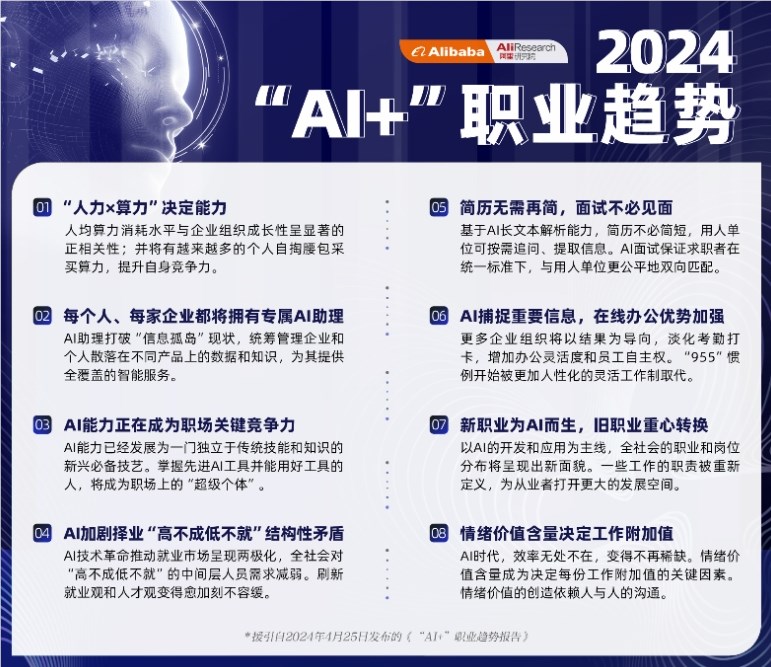

站长之家(ChinaZ.com)2月7日消息:2月6日,科大讯飞在中国科技大学隆重举行了主题为“顶天立地星火燎原”的2023-2024年公司年会。在经营业绩方面,科大讯飞经历了一季度的下滑后,在二三季度实现了企稳,到了四季度更是实现了超过20%的强劲增长。全年营收首次突破200亿大关,且现金流保持为正,展现了公司强大的盈利能力和稳健的财务状况。站长网2024-02-07 08:50:330000阿里AI职业趋势报告:AI能力正在成为职场关键竞争力

“五一”劳动节前夕,阿里巴巴发布了一份《“AI”职业趋势报告》,详细解读了我国各行各业如何运用人工智能(AI)推动职业发展。报告明确指出,AI在编程、设计、乃至养猪等多个领域都展现出强大的应用价值,预示着“人人都有一个AI助理”的时代正加速到来。在这样的背景下,AI能力正逐渐成为职场的核心竞争力,而“人机协作”则成为新的工作常态。站长网2024-04-26 04:10:510000老干妈回应被辛巴称为是预制菜:是调味料 不归类于预制菜

站长之家(ChinaZ.com)1月23日消息:近日,网红辛巴在直播间就预制菜言论进行了回应,他表示自己是被断章取义。辛巴指出,老干妈、奶粉等国民品牌都是预制菜,并强调预制菜只是执行标准的问题。针对这一争议,贵阳南明老干妈风味食品有限责任公司工作人员回应称,他们的油制产品是调味料,并不归类于预制菜。同时,公司方面表示如涉及侵权老干妈名誉,也会进行维权。站长网2024-01-23 08:17:240000299元值得买吗 小米鼠标X1规格详解

快科技10月8日消息,小米鼠标X1于今日在全渠道开售,其尺寸为125.3x63.4x40.6mm,重量65g,价格为299元,为小米在售最贵的鼠标。值得注意的是,小米鼠标X1搭载了旗舰级原相PAW3395传感器,此前的高端游戏鼠标,基本上均采用了PAW3395传感器。该传感器有着高分辨率、高加速度、多平台兼容、抗干扰能力强、多种连接模式、可个性化设置等特点。站长网2024-10-10 10:03:0900004月国产网络游戏版号下发 共95款游戏获批

今日,国家新闻出版署发布4月国产网络游戏审批信息,共95款游戏获批。在这批获批的游戏中,有几款作品格外引人注目。比如备受玩家喜爱的《大侠立志传》和《盗墓笔记:启程》。同时,雷霆公司推出的《方块大陆》也成功获批,这款游戏以其新颖的创意和丰富的游戏内容,吸引了大量玩家的关注。网易的《破碎之地》同样备受期待,其精美的画面和深度的游戏体验,让玩家们翘首以盼。0000