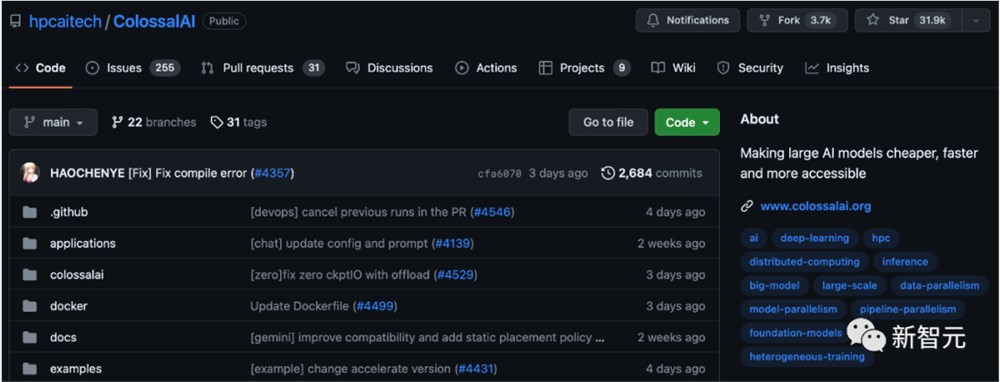

700亿参数Llama 2训练加速195%!训练/微调/推理全流程方案开源,0代码一站解决

近日,全球规模最大的大模型开发工具与社区Colossal-AI,发布了全套Llama2训练、微调、推理方案,可以为700亿参数模型的训练加速195%。

ChatGPT引发的大模型热潮愈演愈烈,全球科技巨头和明星初创争相入局,打造以AI大模型为核心的竞争力和多样化商业使用需求。

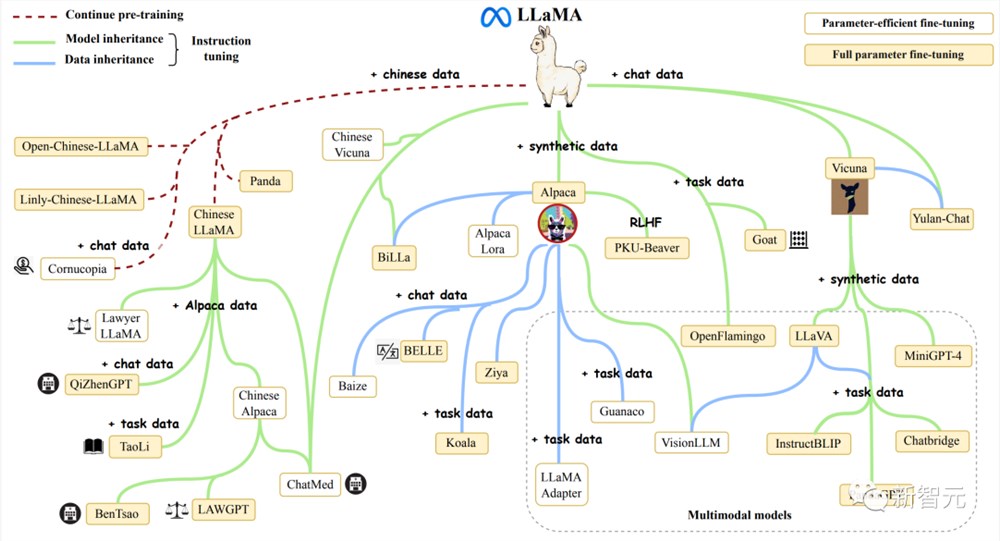

其中LLaMA系列模型,因良好的基础能力和开放生态,已积累了海量的用户和实际应用案例,成为无数开源模型后来者的模仿和竞争的标杆对象。

但如何降低类Llama2大模型预训练成本,如何基于Llama2通过继续预训练和微调,低成本构建AI大模型实际应用,仍是AIGC相关企业面临的关键瓶颈。

作为全球规模最大、最活跃的大模型开发工具与社区,Colossal-AI再次迭代,提供开箱即用的8到512卡Llama2训练、微调、推理方案,对700亿参数训练加速195%,并提供一站式云平台解决方案,极大降低大模型开发和落地应用成本。

开源地址:https://github.com/hpcaitech/ColossalAI

Llama2训练加速195%

Meta开源的LLaMA系列大模型进一步激发了打造类ChatGPT的热情,并由此衍生出了诸多项目和应用。

最新的7B~70B Llama2大模型,则进一步提高了语言模型的基础能力。

但由于Llama2的预训练预料大部分来自英文通用知识,而仅用微调能够提升和注入的领域知识和多语言能力也相对有限。

此外,高质量的专业知识和数据集通常被视为各个行业和公司的核心资产,仅能以私有化形式保存。

因此,以低成本预训练/继续预训练/微调Llama2系列大模型,结合高质量私有化业务数据积累,帮助业务降本增效是众多行业与企业的迫切需求与瓶颈。

但Llama2大模型仅发布了原始模型权重与推理脚本,不支持训练/微调,也未提供数据集。

针对上述空白与需求,Colossal-AI开源了针对Llama2的全流程方案,并具备高可扩展性,支持从70亿到700亿参数的模型,从8卡到512卡都可保持良好的性能。

在使用8卡训练/微调Llama27B时,Colossal-AI能达到约54%的硬件利用率(MFU),处于业界领先水平。

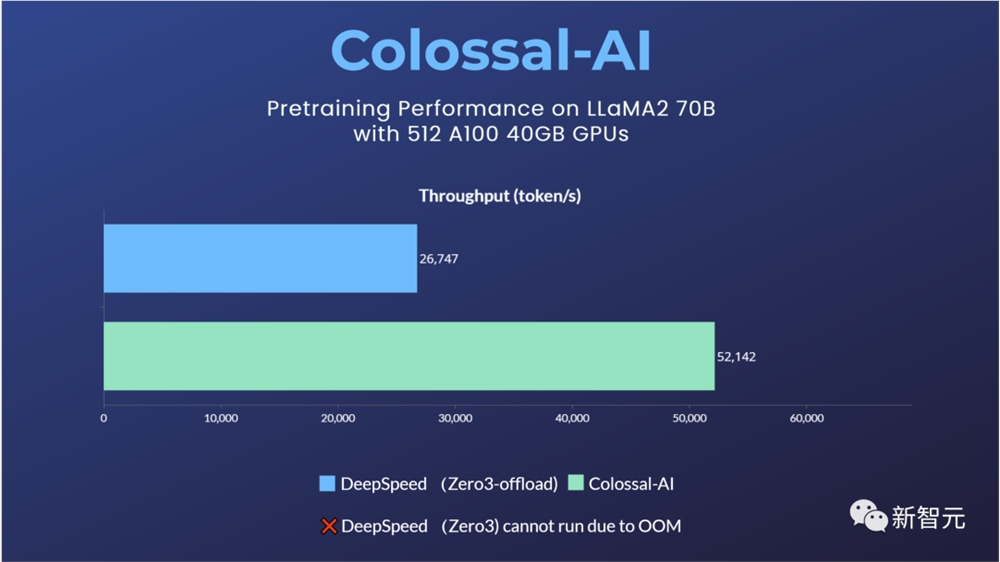

对于预训练任务,以使用512张A10040GB预训练Llama270B为例,DeepSpeed ZeRO3策略因显存不足而无法启动,仅能通过速度衰减较大的ZeRO3-offload策略启动。

相比之下,Colossal-AI则因卓越的系统优化和扩展性,仍能保持良好性能,训练提速195%。

Colossal-AI Llama2训练/微调方案的高性能来源于新的异构内存管理系统Gemini和高性能算子(包括Flash Attention2)等系统优化。

新Gemini提供了高可扩展性,高鲁棒性,高易用性的接口。其Checkpoint格式与HuggingFace完全兼容,减小了使用和转换成本。其对于切分、offload等的设置更加灵活且易用,能够覆盖更多硬件配置下的Llama2训练/微调任务。仅需数行代码即可使用:

fromcolossalai.boosterimportBoosterfromcolossalai.booster.pluginimportGeminiPluginplugin=GeminiPlugin()booster=Booster(plugin=plugin)model,optimizer,train_dataloader,criterion=booster.boost(model,optimizer,train_dataloader,criterion)

ShardFormer多维细粒度并行

虽然对于主流硬件条件和大多数模型,Colossal-AI的新Gemini已经能够提供良好的性能。但是对于一些极端硬件条件,或者是特殊模型,可能仍然需要多维并行的细粒度优化。

现有其他方案通常需要分布式系统资深专家,手动对代码进行大规模重构和调优,Colossal-AI的ShardFormer提供了开箱即用的多维并行和算子优化的能力,仅需数行代码即可使用,在单机/大规模集群上都能提供良好的性能。

fromcolossalai.boosterimportBoosterfromcolossalai.booster.pluginimportHybridParallelPluginfromtransformers.models.llamaimportLlamaForCausalLM,LlamaConfigplugin=HybridParallelPlugin(tp_size=2,pp_size=2,num_microbatches=4,zero_stage=1)booster=Booster(plugin=plugin)model=LlamaForCausalLM(LlamaConfig())model,optimizer,train_dataloader,criterion=booster.boost(model,optimizer,train_dataloader,criterion)

Colossal-AI ShardFormer支持包括LLaMA1/2、BLOOM、OPT、T5、GPT-2、BERT、GLM在内的主流开源模型,也可以直接使用Huggingface/transformers模型导入,Checkpoint格式也与HuggingFace完全兼容,对比Megatron-LM等需重写大量代码的方案,大大提升了易用性。

对于并行策略,已支持以下多种并行方式:张量并行、流水线并行、序列并行、数据并行、Zero数据并行等,并可将多种并行方式组合使用,只需通过简单的配置命令,即可适配各种复杂的硬件环境/模型。同时,其内置了各种高性能算子,免去了繁琐的兼容/配置过程。其中包括:

Flash attention2

Memory efficient attention (xformers)

Fused Normalization Layer

JIT kernels

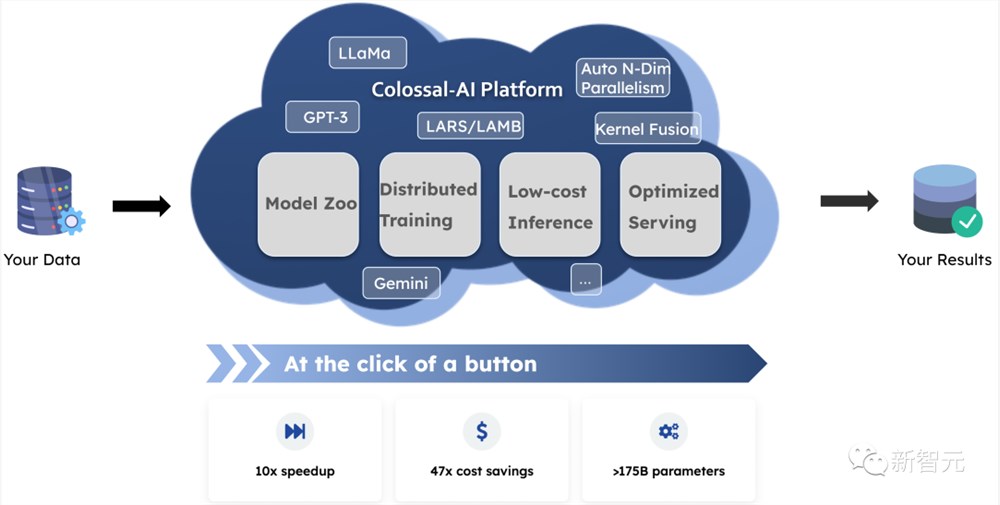

云平台大模型一站式解决

为了进一步提升开发和部署效率,Colossal-AI团队还将上述系统优势与算力结合,提供Colossal-AI云平台,提供廉价算力和开箱即用的AI主流应用,包括对话大模型,多模态模型,生物医药等,现已开启内测。

通过屏蔽大模型底层的分布式并行计算、内存、通信管理与优化等,AI开发者可以继续专注于AI模型与算法设计,以更低成本更快速度完成AI大模型助力业务降本增效。

用户只需要上传相关数据,即可无代码训练个性化私有模型,并将训练好的模型一键部署。相关的应用都经过Colossal-AI团队精心优化,得益于算法和系统的双面优化,能大大降低模型训练以及部署的成本。

Colossal-AI云平台:platform.luchentech.com

Colossal-AI开源地址:https://github.com/hpcaitech/ColossalAI

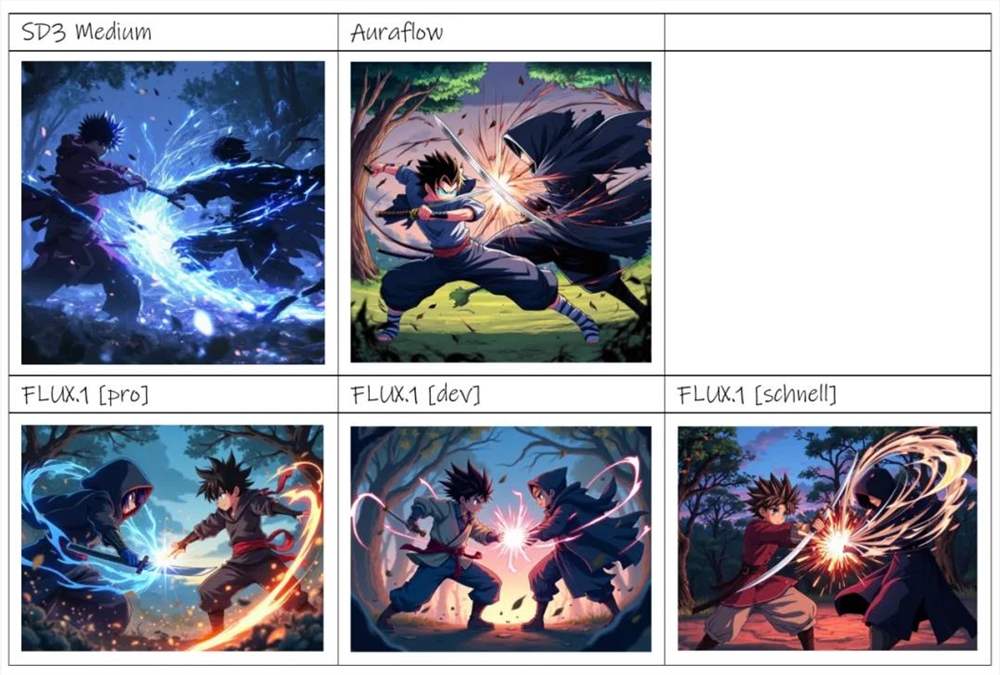

SD差点挂掉,后备军们兴奋入场,AI生图应用正在爆发?

站长网2024-08-22 09:08:100001尴尬!印度一家公司推“TruthGPT”,但完全不真实

本文概要:1.印度公司TheWholeTruthFoods推出了自己的TruthGPT,用于提供有关食物和健身的信息。2.该平台声称是经过事实核实的,但实际上与ChatGPT相比有很大差距。3.公司的真实性和可靠性值得怀疑,这可能只是一种营销策略。站长网2023-08-08 14:28:000000Stable Diffusion母公司CEO称:AI是一个1万亿美元的投资机会

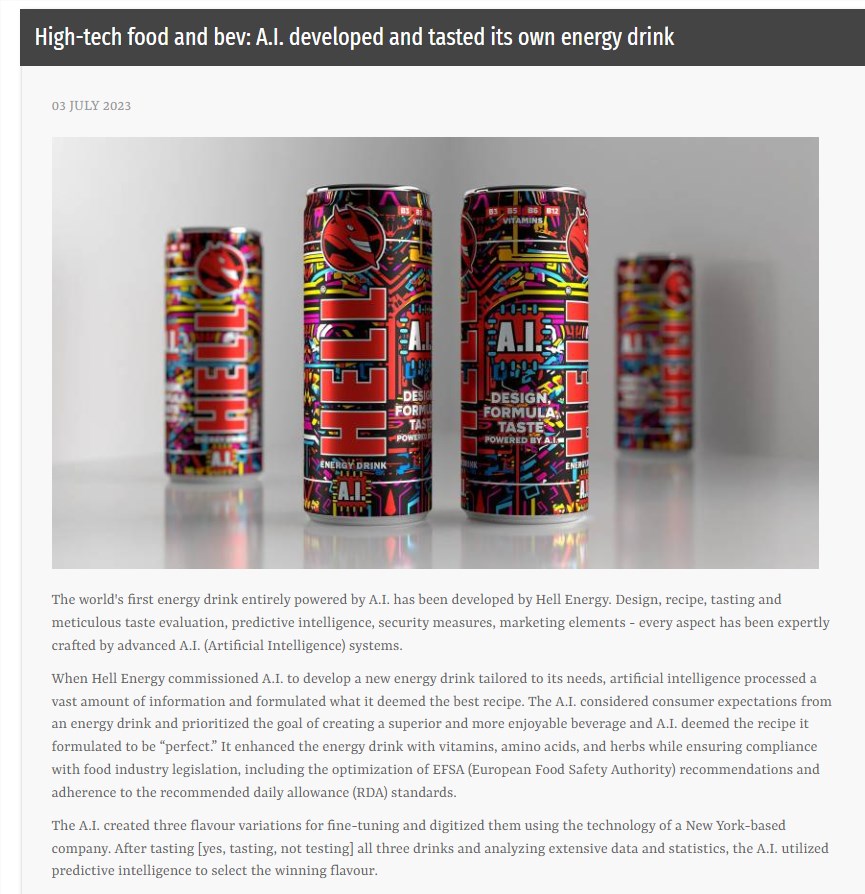

据CNBC报道,开源人工智能公司StabilityAI的首席执行官表示,人工智能将是有史以来最大的泡沫。上周,StabilityAI的首席执行官EmadMostaque在与UBS分析师的电话会议上说,关于人工智能:“我认为这将是有史以来最大的泡沫。”他补充说,它仍处于非常早期的阶段,还没有准备好在银行等行业进行大规模的应用。“我称之为‘点AI’机遇,它甚至还没有开始,”他说。站长网2023-07-18 00:04:340000全球首款AI设计的饮料面世 从口味到包装全都是AI负责

据美通社报道,匈牙利的一家功能饮料公司HELLENERGY成功研发出全球首款完全由人工智能驱动的能量饮料。据称,人工智能负责饮料制造的各个环节,包括产品设计、配方研发、口味评估、智能预测、安全措施、营销策划和包装设计等。站长网2023-07-05 19:09:070001