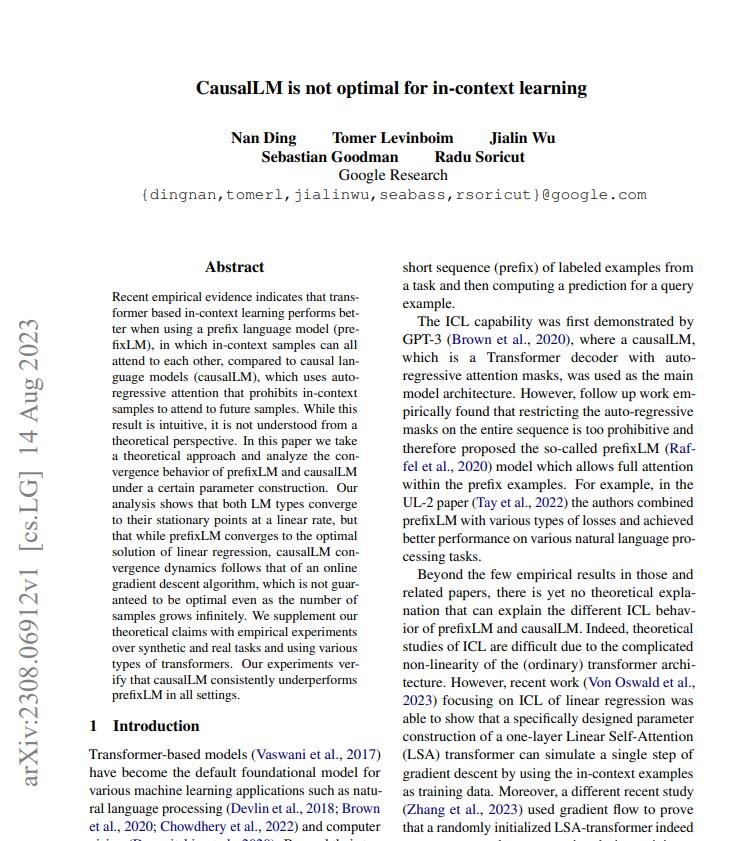

研究显示:语言模型causalLM在上下文学习中不如prefixLM

站长网2023-08-15 17:18:202阅

近期的研究发现,在上下文学习中,基于Transformer的前缀语言模型(prefixLM)表现更优于因果语言模型(causalLM),然而目前仍缺乏这一差异的理论解释。本文采用理论分析和实验验证,揭示了前缀语言模型和因果语言模型在上下文学习中的性能差异,并证明了前缀语言模型在收敛行为和优化解上的优势。

这篇论文主要解决问题是为何前缀语言模型在上下文学习中的性能更佳,以及其背后的理论原因。在前缀语言模型中,上下文样本可以相互关注,而因果语言模型则使用自回归注意力,限制上下文样本关注未来样本。

论文地址:https://arxiv.org/pdf/2308.06912.pdf

论文的关键思路是通过理论分析和实验验证,探究两种语言模型的收敛行为差异。论文指出,前缀语言模型和因果语言模型都以线性速度收敛到稳态点,但前缀语言模型收敛到线性回归的最优解,而因果语言模型的收敛动态遵循在线梯度下降算法,无法保证最优性。

值得关注的是,该论文的实验设计采用了合成任务和真实任务,使用不同类型的transformers,并验证了因果语言模型在各种设置下表现不如前缀语言模型。此外,论文还提供了开源代码,为该领域的研究提供了有价值的资源。

总而言之,论文通过理论分析和实验验证,深入探讨了前缀语言模型和因果语言模型在上下文学习中的性能差异。论文的贡献在于揭示了这一差异的理论解释,并通过实验证实了前缀语言模型在不同情境下的优越性。这一研究对于了解上下文学习中语言模型的工作原理和优化行为具有重要意义,值得进一步深入探究和应用。

0002

评论列表

共(0)条相关推荐

苹果关闭圣地亚哥AI团队,数据运营注解团队将迁至奥斯汀合并

**划重点:**1.🏢苹果关闭位于圣地亚哥的121人AI团队,将其与奥斯汀的类似团队合并。2.🤖负责提升Siri语音助手听取用户查询的团队被告知可以选择迁至奥斯汀,否则将在4月26日失业。3.🌐人工智能的崛起导致多家知名公司裁员,AI技术取代白领工作,资金转向技术发展。站长网2024-01-15 12:06:490000百度:AI伙伴是搜索代际变革的一部分 提示词工程是必修课

昨日,百度搜索正在内测的“AI伙伴”现场挑战高考语文考试,包括作文、微写作、古诗词赏析、文言文翻译、阅读填空等题型。据悉,AI伙伴是利用百度语义检索技术大语言模型的结晶,“Al伙伴”能够听懂用户的任何问题,并用语音进行互动,还能帮助用户标记答案中的重点,提供权威的来源,同时支持调用各种工具和服务,以及根据用户意图制作图片或进行文案创作。站长网2023-06-08 13:35:470000梅赛德斯奔驰考虑加入特斯拉北美充电标准

上个月,梅赛德斯-奔驰表示正在考虑为其电动汽车采用特斯拉的北美充电标准(NACS)。根据德国豪华电动汽车制造商周五的公告,梅赛德斯-奔驰似乎已经就NACS做出决定。该汽车制造商正在加入“NACS联盟”。梅赛德斯-奔驰在北美的电动汽车将从2025年开始采用特斯拉的充电标准。此举紧随美国竞争对手福特和通用汽车的脚步,这两家公司都采用了北美充电标准,以改善其电动汽车的充电选择。站长网2023-07-10 15:18:080000开源软件开发助手SoTaNa:利用AI理解开发者意图、改进软件开发流程

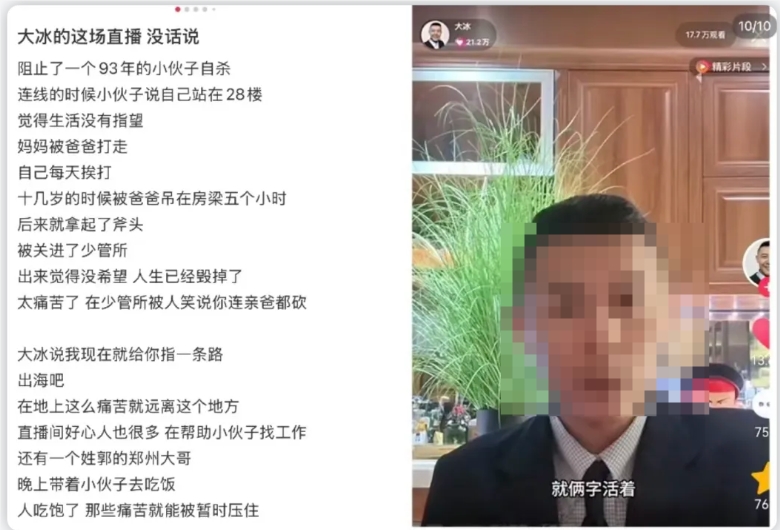

文章概要:1.SoTaNa利用AI改进软件开发2.SoTaNa基于LLM理解开发者意图3.SoTaNa效果通过StackOverflow数据集验证最近,开源软件开发助手SoTaNa引起广泛关注。SoTaNa旨在利用人工智能功能改进软件开发流程。站长网2023-09-05 10:58:1500017天涨粉130万!爆红的大冰突然停播,放弃“泼天富贵”

靠直播间口碑逆袭后,大冰停播了。10月16日,他发文表示“泼天富贵,镜花水月;莫等莫催,暂不开播;这波流量,无缘承接”,宣布自己正式停播。截至目前,大冰已经有4天未在快手开播,账号评论区里有不少留言呼唤其回归。提起大冰,许多人的印象可能还停留在那一长串的自我介绍上:作家、首席主持人、高校导师、民谣歌手、老背包客、酒吧掌柜、油画画师、手鼓艺人、业余诗人、黄金左脸、禅宗临济弟子……站长网2024-10-18 23:36:480000