AI框架LoraHub:将LoRA 模块像乐高一样组合

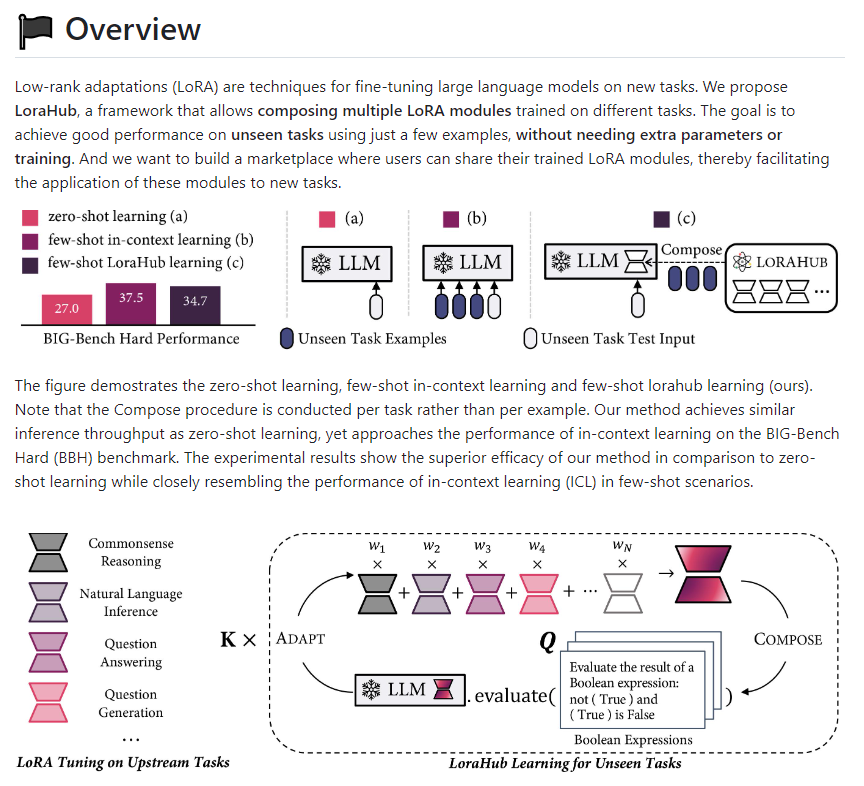

LoraHub 是一个 AI 框架,用于自动组合 LoRA 模块,以实现对新任务的适应性性能。

它可以根据之前未识别任务的少量样本,自动组织合适的 LoRA 模块,并通过 LoRA 学习的方式进行训练。LoraHub 具有高性能和灵活性,可以在只有 CPU 的计算机上运行,并通过减少推理成本提高效率。它为用户提供了一个共享、访问和应用训练过的 LoRA 模块的平台,为 NLP 任务的开发和应用提供了便利。

项目地址:https://github.com/sail-sg/lorahub

LoraHub 的核心功能是通过 LoRA 的模块化和可组合性,在不需要人工干预或专业知识的情况下,自动组合合适的 LoRA 模块。该方法可以利用仅有的几个样本自动组织适用于新任务的 LoRA 模块。与传统的假设特定任务的训练不同,LoraHub 可以集成满足要求的所有 LoRA 模块。这种学习技术称为 LoraHub 学习,因为它利用了现有的多个 LoRA 模块。

该方法通过在行业标准的 BBH 基准和 Flan-T5作为底层 LLM 的基础上进行评估。结果表明,少样本的 LoraHub 学习过程可以组合适用于新任务的 LoRA 模块,并且与少样本、上下文学习相比,取得了接近的结果。与上下文学习相比,LoraHub 学习不需要将实例作为 LLM 的输入,从而大大降低了推理成本。该学习技术采用无梯度方法生成 LoRA 模块的系数,并且仅需要少量推理步骤。使用单个 A100,在不到一分钟的时间内,该方法可以在 BBH 上实现顶级性能。

LoraHub 的学习只需要了解如何处理 LLM 推理,因此可以在只有 CPU 的计算机上进行。这种灵活性和高性能的工作方式为创建一个易于共享、访问和应用于新任务的训练过的 LoRA 模块的平台铺平了道路。研究团队希望这样的系统可以建立一个具有各种功能的可重复使用的 LoRA 模块库。该团队正在努力动态组合 LoRA 节点,以提高 LLM 的能力。

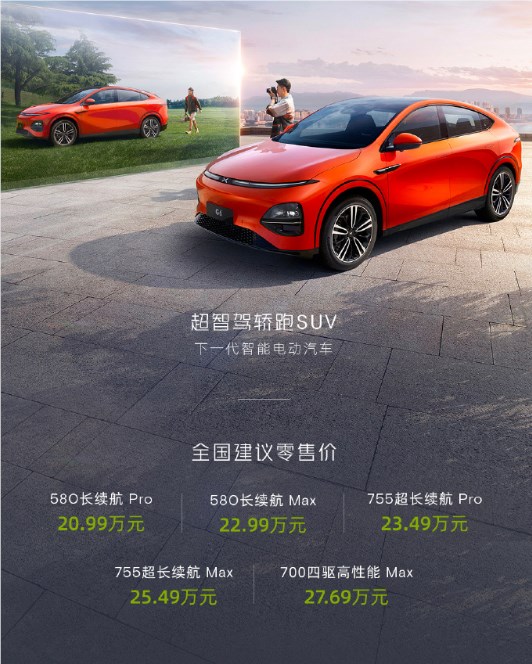

小鹏G6正式发布 售价20.99万元起

小鹏G6于2023年6月29日正式上市,580长续航版Pro——20.99万元、580长续航版Max——22.99万元、755超长续航版Pro——23.49万元、755超长续航版Max——25.49万元、700四驱性能版Max——27.69万元,提供熔云橙、新月银、星雨青、光子蓝、星阙灰、星云白六种配色可选。站长网2023-06-30 19:48:470000每周AI大事件 | 苹果下多款AI应用、黑客版ChatGPT风靡暗网、通义千问70亿参数模型开源

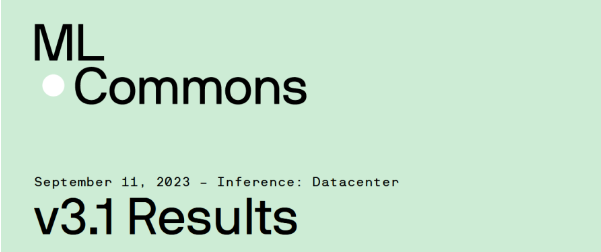

欢迎来到站长之家的[每周AI大事件],这里记录了过去一周值得关注的AI领域热点内容,帮助大家更好地了解人工智能领域的动态和发展风向。Part1动态[国内要闻]1.腾讯混元大模型开始应用内测多个业务线已接入腾讯自研的“腾讯混元大模型”已经进入应用内测阶段。多位腾讯员工表示,他们最近收到了内部邮件邀请,可以通过网页或小程序体验混元大模型。腾讯内部多个业务也已经接入混元大模型进行测试。站长网2023-08-04 09:59:370005MLPerf放榜!AI芯片公司墨芯人工智能再夺MLPerf大模型推理三项冠军

要点:MLPerf公布最新GPT大模型推理测试结果,墨芯人工智能S30计算卡单卡、4卡、8卡的算力均获得第一。墨芯通过独创的双稀疏算法与硬件协同设计,在GPT-J大模型上取得1.8倍于英伟达H100的性能优势。墨芯的成绩证明,稀疏计算是大模型时代算力发展的关键,可根本解决大模型参数增长与算力瓶颈的矛盾。站长网2023-09-15 09:32:080000Dan Ives:人工智能并不全是炒作「第四次工业革命正在上演」

AI热潮正在席卷世界,但AI繁荣并非一片虚火,Wedbush证券的DanIves表示,这是「第四次工业革命正在上演」。这位董事总经理兼高级股票研究分析师在周三接受CNBC的「SquawkBoxAsia」采访时表示:「我称之为1995年时刻,与互联网平行。我不认为这是一次炒作周期。」站长网2023-06-29 11:40:000000花1460元生成5个20秒高清视频,刚上线的Sora还只是“丐版”?

好消息:Sora终于来了!坏消息:哪轮得到我们啊今天凌晨,传闻中OpenAI最大的期货Sora正式登场。据OpenAI介绍,Sora支持用户生成最高1080p、最长20秒、多种尺寸比例的视频。用户可以使用文本、图像和视频三种方式提示Sora生成视频,并利用混合、重剪、融合和风格预设等功能对视频进行编辑修改。0000