Karpathy看好的Agents学会自动退换货了!英伟达H100加持,给LLM插入最强外接大脑

【新智元导读】全世界最有「料」的平台来了!Amazon Bedrock基础模型上新,商用Agents加快应用开发,矢量引擎赋予大模型记忆,亚马逊云科技凭借技术创新成为端到端的生成式AI领导者。

最近,AI圈依然是大事频发,几天一个爆炸性新闻。

Meta联手微软高调开源了Llama2,它在2万亿个token上训练,秒杀许多开源语言模型,并且还能免费商用。

OpenAI科学家Karpathy最近搞的明星项目「Baby Llama」,已经可以用C语言跑Llama27B了。

而就在几天前,Stability AI正式发布了下一代文生图模型——Stable Diffusion XL1.0。

这次的1.0版本是Stability AI的旗舰版生图模型,也是最先进的开源生图模型。

在目前的开放式图像模型中,SDXL1.0是参数数量最多的。官方表示,这次采用的是全新的架构,基础模型的参数规模达到35亿,同时还有一个66亿参数大小的细化模型。

而如此强大的生图模型,已经可以在Amazon Bedrock上一键访问了!

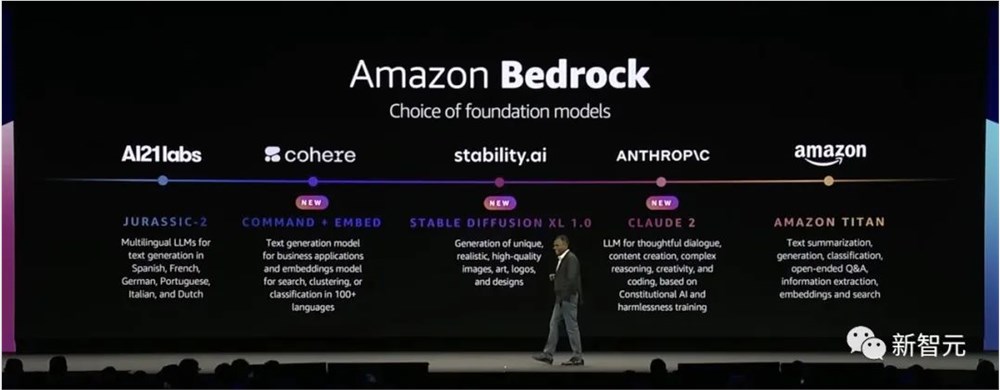

基础模型全面上新

就在上周,亚马逊云科技发布了一大波基础模型上新。

除了刚刚提到的SDXL1.0,Amazon Bedrock还增加了对Cohere基础模型以及ChatGPT最强竞品——Anthropic的Claude2的支持。

Cohere研发的大语言模型Command,是一个能够接受用户个性化命令训练的模型,专注于提供文本搜索、文本分类和文本生成三大AI能力。

另外,Anthropic推出的Claude2,其处理能力已经更新到10万个token。相较之前版本,Claude2在数学、代码、推理能力方面有明显的提升。

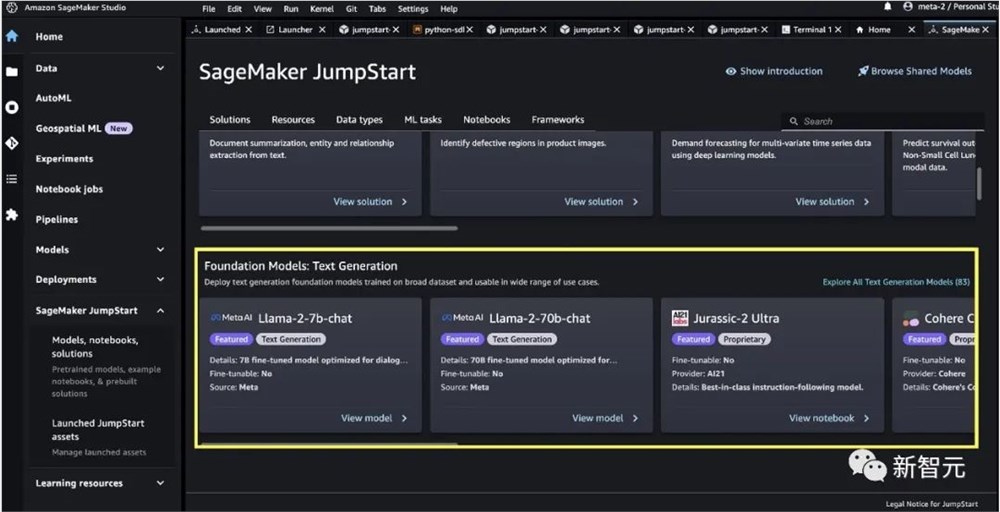

同时,开发者还可以通过机器学习中心Amazon SageMaker Jumpstart,一键开发各类热门开源模型。

比如,Meta最新的Llama2、世界最大开源社区Hugging Face托管的Falcon、Flan等等。

Agents改变游戏规则

不过,基础模型虽然在各种任务上有强大的泛化能力,但随着应用场景的不断扩展,仅靠模型本身已经很难去完成一些复杂的任务了。

比如预定航班或退回购买的商品这种简单的任务,开发者都必须经历多个步骤——通过提供特定的说明和配置、访问相关知识源、编写代码将任务分解,然后应用才能通过一系列API调用采取行动。

在这个过程中,开发者必须配置和管理基础架构,设置数据安全和隐私策略,繁琐又耗时。

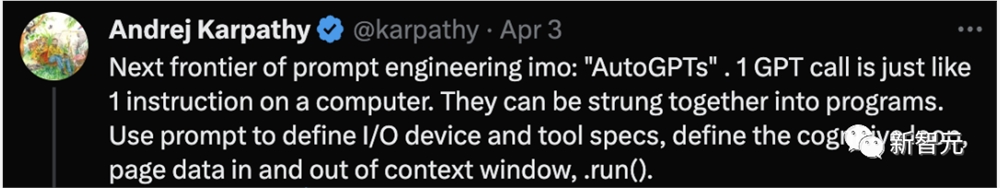

而前段时间AutoGPT的爆火,则给了学界和工业界一个全新的探索方向——集成了大语言模型的Agents。

Karpathy曾将AutoGPT称为快速工程的下一个前沿

概括来说,AI智能体可以通过最简单的形式运行循环,并且在每一次的迭代中,都会生成自主指令和操作。因此,它们既无需依赖人类来引导对话,还具有高度的可扩展性。

以AutoGPT为例,我们每分配一个任务,它都会给出一个相应的解决计划。

比如,需要浏览互联网或使用新数据,它便会调整其策略,直到任务完成。这就像拥有一个能处理各种任务的私人助手,如市场分析、客户服务、市场营销、财务等。

正如今年加入OpenAI的大牛、前特斯拉AI总监Karpathy所说:「Agents代表着AI的一种未来。」

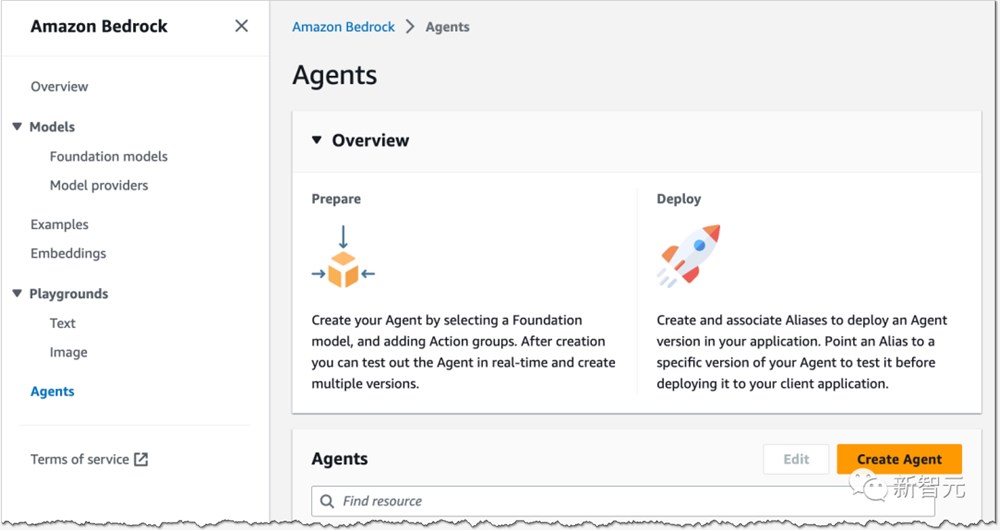

亚马逊云科技也在这个领域进行了自己的探索,并且创新性地提出了全新的Amazon Bedrock Agents。

基于Amazon Bedrock提供的Agents功能,开发者可以轻松创建各种生成式AI应用,来完成复杂任务,并根据专有知识源提供最新答案。

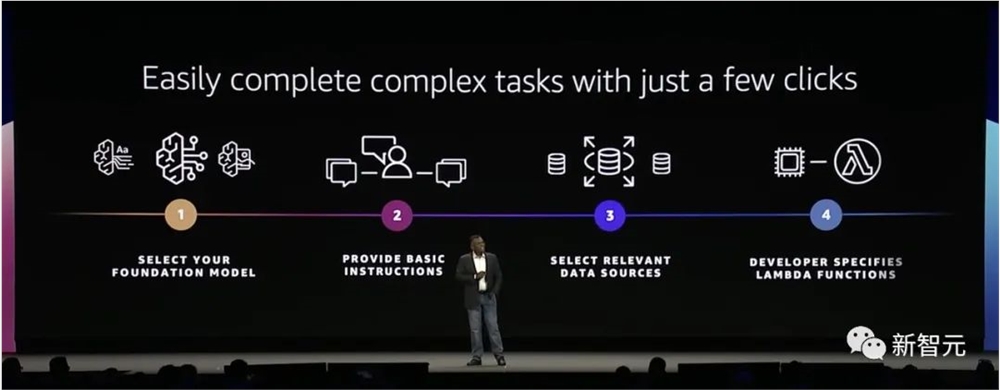

以往得耗费几个小时编码来实现的过程,现在无需任何手动编码,只要单击几下,Agents就能自动分解任务,创建计划。

这样一来,生成式AI应用程序分分钟就搞出来了。

那么,Amazon Bedrock Agents是如何让基础模型加速工作流的呢?具体可分为以下四个步骤:

第一步:定义指令和编排,将复杂任务分解为多个步骤

第二步:检索增强生成(RAG),配置FM与公司数据互动

第三步:完成交互,执行API调用以满足用户请求

第四步:在云中安全托管

Amazon Bedrock Agents可以通过简单的API链接到公司数据,将其转换为机器可读的格式,就能生成准确响应。然后自动调用API,满足用户请求。

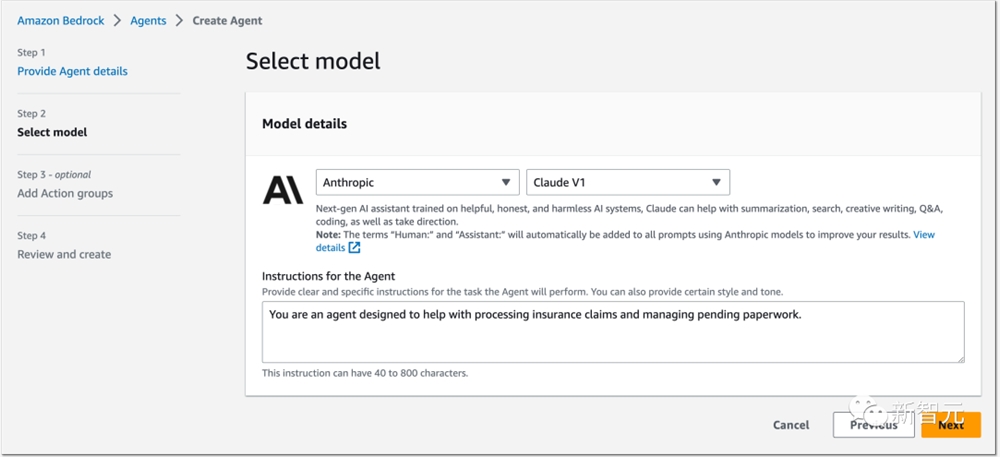

基于Amazon Bedrock,用户可以任意选择适合自己用例的基础模型,然后用自然语言给它下指令。

比如告诉它,「你现在是一个智能体,需要帮助处理保险索赔和管理待处理文书的工作」。

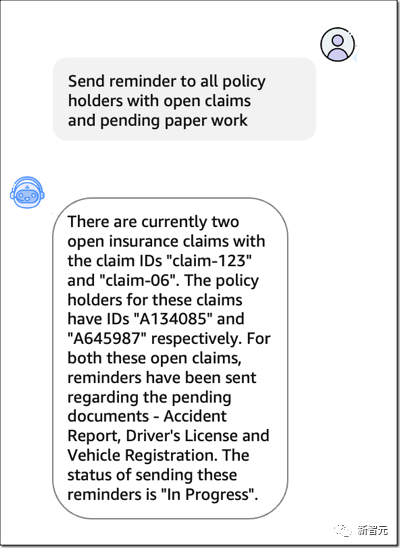

然后,对Agents发出命令「向所有有未结索赔和待处理文书工作的保单持有人发送提醒」,它马上理解了我们的请求,把任务分成多个步骤——收集未结保险索赔、查找索赔 ID、发送提醒,然后执行了相应的操作。

而且,有了Amazon Bedrock Agents的功能,用于电商的AI程序不仅可以回答简单的问题,还能完成复杂的任务,比如更新订单、管理交易。

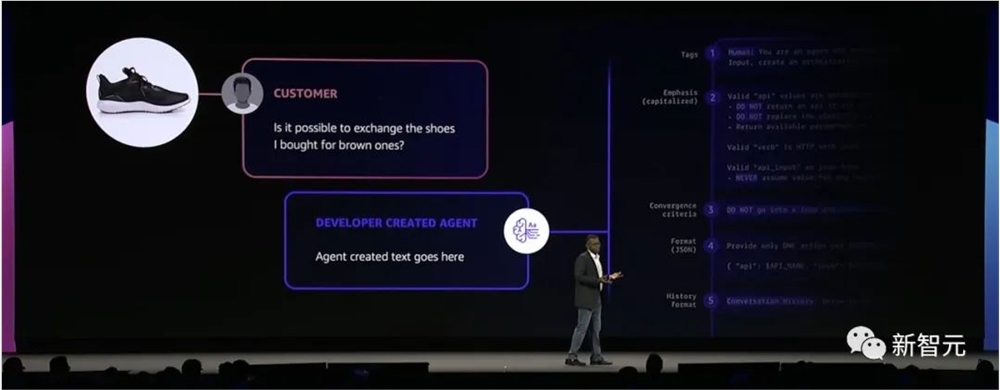

比如,客户发出想要退回一双鞋,可以直接说:「我想把这双黑色鞋换成棕色的」。

Agents收到信息后,就会连接到公司数据,自动将文本转换成机器可读格式,向模型提供相关信息,然后调用正确的API来满足这一请求。

英伟达H100最强加持

然而,基础模型性能不断提升,所带来的是动辄几百万亿的参数。

这种复杂性的暴涨,也极大地增加了模型训练和微调的时间——最新的LLM需要数月的时间来进行训练。

与此同时,HPC领域也呈现出了类似的趋势。随着精度的提高,用户收集的数据集已经达到了Exabyte级别。

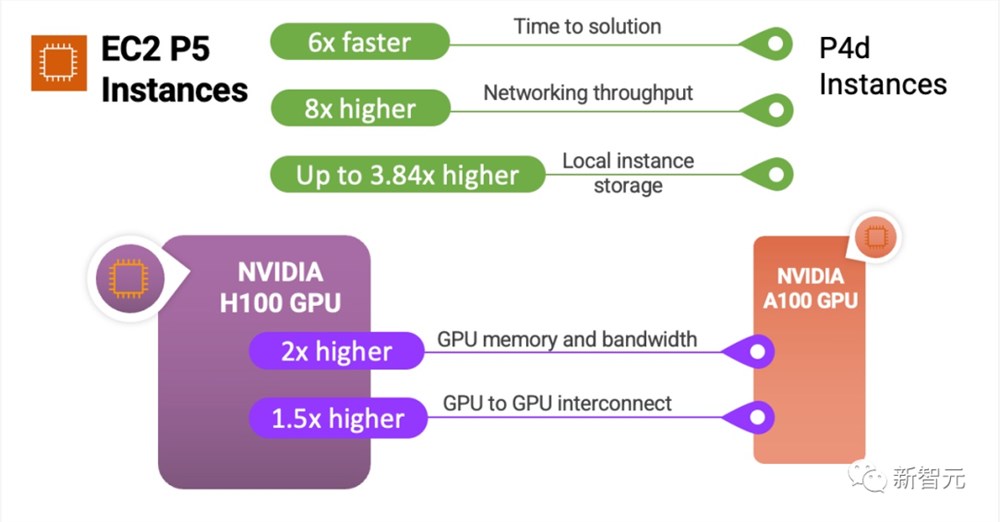

为了满足高性能和可扩展性的算力需求,亚马逊云科技全新推出了搭载英伟达最强GPU——H100的Amazon Elastic Compute Cloud(EC2)P5实例。

相较于上一代,Amazon EC2P5实例不仅可以将训练时间缩短高达6倍(从几天缩短到几小时),而且还能使训练成本降低高达40%。

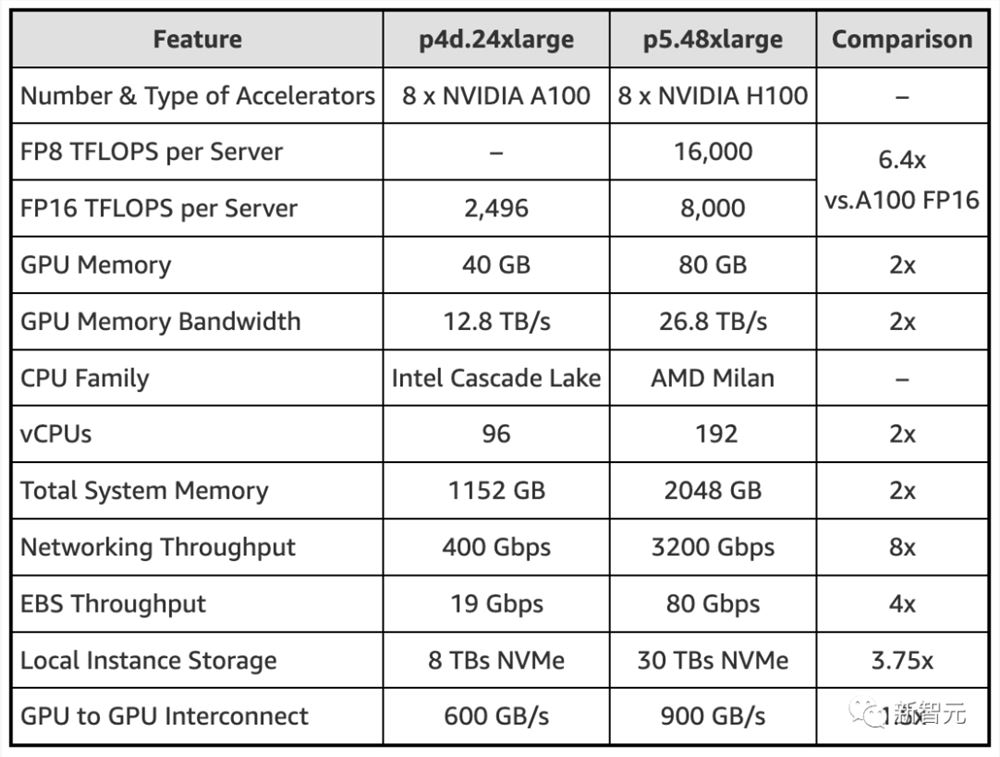

具体来说,Amazon EC2P5实例共搭载了8个NVIDIA H100Tensor Core GPU,配备640GB高带宽GPU显存,同时还有第三代AMD EPYC处理器、2TB系统内存、30TB本地NVMe存储,以及高达3200Gbps的总网络带宽。

堪称配置拉满的性能,为最苛刻、计算密集的生成式AI应用提供了支持,包括问答系统、代码生成、视频和图像生成、语音识别等,非常适合训练和运行日益复杂的LLM和CV模型。

基于全新的Amazon EC2P5实例,用户可以探索此前难以触及的问题,并且更快地迭代出解决方案。

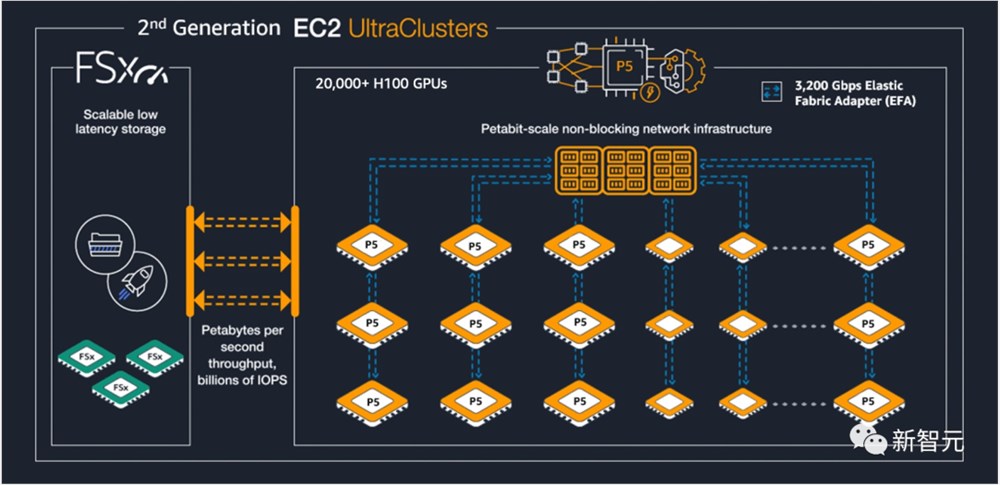

此外,为了满足用户对大规模和低延迟的需求,亚马逊云科技还推出了搭载有Amazon EC2P5实例的第二代EC2UltraClusters。

作为云中规模最大的ML基础设施,EC2UltraClusters可提供高达20exaflops的总计算能力,以及跨20,000多个NVIDIA H100GPU的低延迟。

给模型插入「外接大脑」

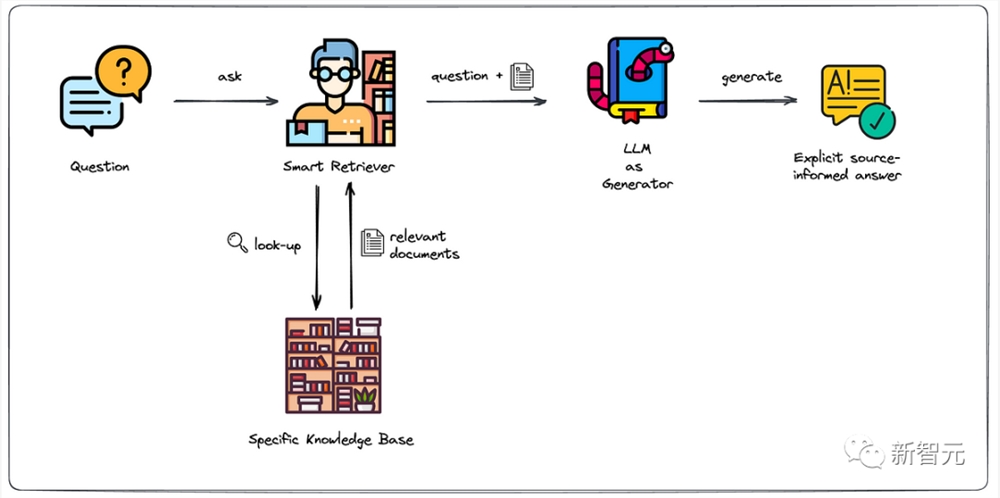

从智能体的构建中我们不难看到,所有基于大模型搭建好的应用,想要获取实时数据,都需要建立在检索增强生成(RAG)之上。

而这一技术是向量数据库能够在AI应用中发挥重要作用的根本。

为什么这样说?那就得看看,检索增强生成能实现什么。

比如,当你问ChatGPT「芭比」电影好看吗?

显然,ChatGPT是无法及时回复最新的相关信息。这对于企业来讲,用户咨询最新内容时,应用无法做出回应,大大降低了生产力。

有了检索增强生成,便能够补充特定领域的知识。大模型参数虽大,但无法记住许多长尾数据,还需要通过搜索召回相关领域的知识。

这里,对专业领域知识的补充就离不开,向量数据库、搜索引擎等。

另一方面,大模型的知识很容易过时,仅靠微调模型,让知识更新是行不通的。

微调模型需要耗费大量算力、时间,关键是天天微调根本不现实。

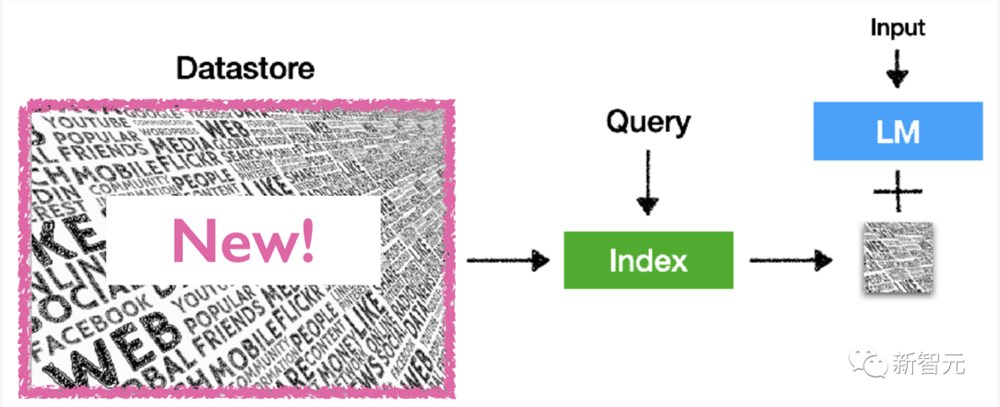

要知道,对于企业来讲,业务数据必须是实时的。因此向量数据库、搜索引擎都能够帮助模型,获得新数据,同时重训模型周期也被拉长。

由于向量数据库对「高维嵌入」有强大的检索能力,与大模型结合较为简单,因此成为RAG最常用的数据存储形式。

微软Build大会上,曾介绍了其产品如何将较少的上下文感知LLM与向量搜索结合起来,来创造更有吸引力的体验。

这其中基本的想法,也就是在LLM中,添加向量搜索,以进行检索增强生成。

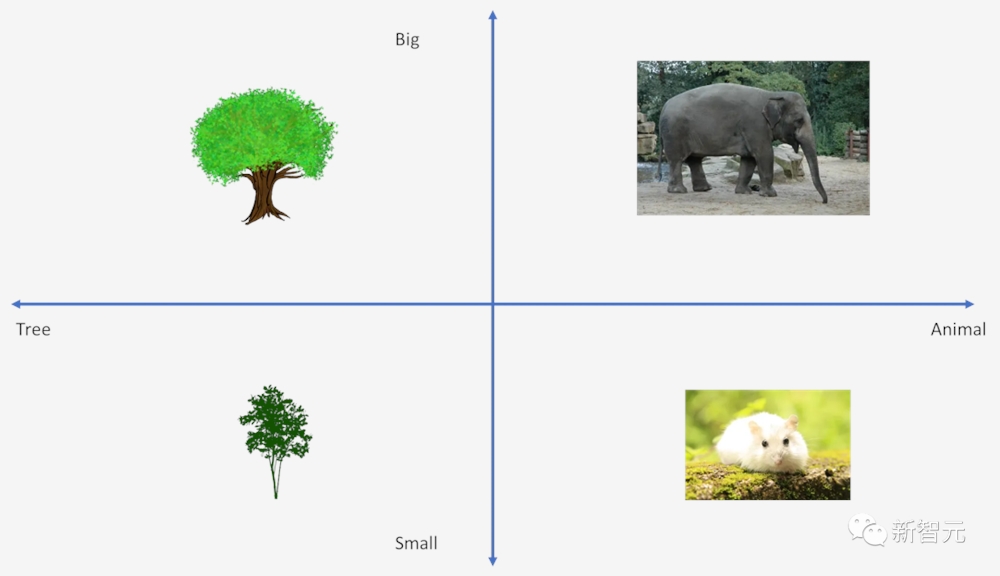

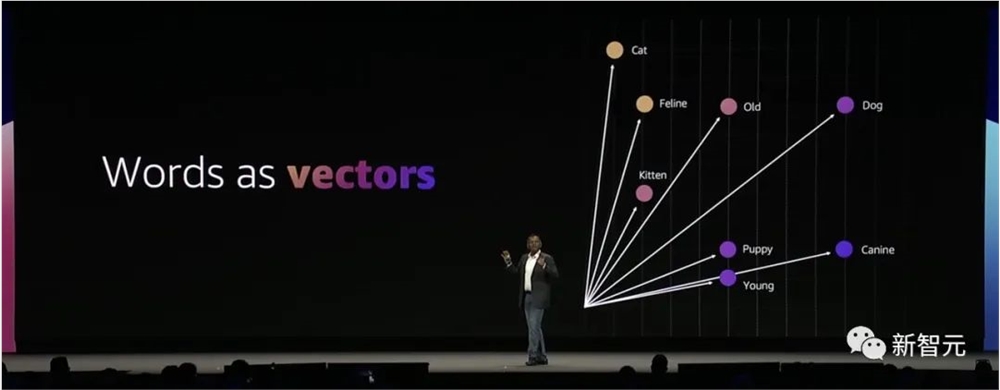

而向量化,就是将数据转化为维度,如下你可以看到两种维度:大小,和类型。

其中大小有两个值(大和小),类型有2个值(树和动物)。这只是一个概念例子,还可以扩展到更多的值。

除了图片,还可以进行单词/句子向量搜索,向量搜索能够捕捉到语义表示。

假设你有数百个,甚至数万个文档数据库作为背景,是无法放在ChatGPT提示框中,但可以通过向量搜索来缩小最有可能的包含答案的上下文。

对于数据库,既可以储存文档和嵌入,也可以用来存储查询,并根据相关查询来找到最相关文档,这样就可以通过⽂档检索增强LLM。

今年英伟达GTC大会上,黄仁勋首提向量数据库,并推出了新库RAFT,用于加速索引、数据加载和近邻检索。

其重要意义在于,向量数据库是大模型的「海马体」,能够让LLM实时进行信息召回。

通过把实时资讯、市场行情等实时变化的信息置入模型中,就能使其提供更精准的结果。

Amazon OpenSearch Serverless向量引擎

同样在亚马逊云科技峰会上,首次推出了——Amazon OpenSearch Serverless向量引擎。

开发者们通过这个工具,就可以轻松使用向量数据库,快速构建基于大模型的搜索体验。

总的来说,Amazon OpenSearch Serverless向量引擎引入了简单、可扩展和高性能的向量存储和搜索功能。

开发者可以快速存储和查询各种ML模型(包括Amazon BedRock提供的模型)生成的数十亿个向量嵌入,响应时间仅为毫秒级。

当前,生成式AI大爆发,所有垂直领域的企业都在转向这一热潮,并探索通过集成高级对话生成AI应用程序,以改变用户体验,以及和数字平台交互的方法。

亚马逊云科技推出的这项工具,通过使用向量嵌入,能够增强ML搜索和生成式AI。

向量嵌入在用户私有数据上进行训练,并能表示信息的语义和上下文属性。

这样做的优势在于,能够及时处理用户的查询,以查找最接近的向量,并将其与其他元数据组合在一起,进而无需依赖外部数据源或其他应用程序代码集成结果。

值得一提的是,向量引擎是基于Amazon OpenSearch Serverless构建,因此无需担心后端基础架构的大小、调整和扩展。

所有数据都持久保存在Amazon Simple Storage Service (Amazon S3) 中。

当向量数量从原型开发时的几千个增长到生产时的上亿个甚至更多,向量引擎将无缝扩展,无需重新索引或重新加载数据来扩展基础架构。

此外,向量引擎还为索引和搜索工作负载提供独立计算,因此开发者可以实时无缝地摄取、更新和删除向量,同时确保用户体验不受查询性能的影响。

借助对Amazon OpenSearch Serverless的向量引擎支持,开发人员将拥有一个简单、可扩展和高性能的解决方案,来构建机器学习增强的搜索体验和生成性人工智能应用程序,而无需管理向量数据库基础设施。

全球生成式AI领导者

随着数据量大爆发、可高度扩展算力的可用性、以及机器学习技术的进步,让生成式AI足以改变每个行业。

因此,越来越多的企业希望快速采用最新技术,创造价值。

选择正确的模型,使用公司数据安全定制模型,并将其集成到应用程序中是一个复杂的过程,都需要花费大量时间、和高度专业化的知识。

恰恰,亚马逊云科技Amazon Bedrock简化了这一流程,通过简单的API访问一流的基础模型。

通过Amazon Bedrock Agents这一完全托管的服务,开发者能够轻松创建基于生成式AI的应用程序,以完成各种用例的复杂任务。

其中Vector Database,能够帮助开发者的应用程序实时存储数据,及时召回信息,提供更好的用户体验。

Amazon EC2P5实例更是为模型训练节省大量时间和算力。

基于以上的创新,真正诠释了亚马逊云科技是端到端的生成式AI领导者,帮助企业开发者释放生成式AI的潜力,创造价值。

同时,亚马逊云科技不断降低生成式AI的门槛,更是致力于GenAI普惠的领导者。

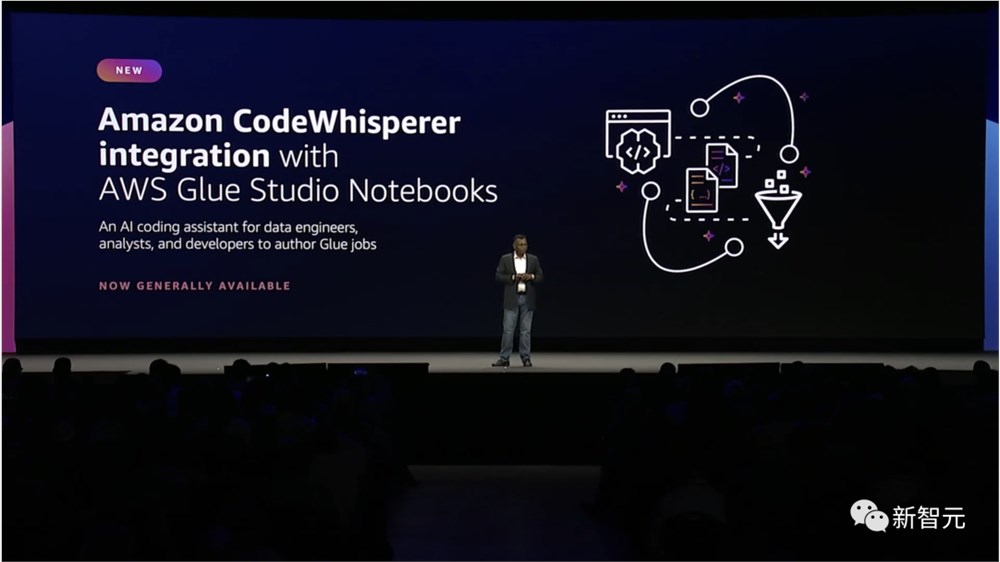

前段时间,亚马逊云科技刚刚宣布了编程助手Amazon CodeWhisperer可用,能够使用底层基础模型帮助开发人员提高工作效率。

它可以根据开发人员使用自然语言留下的注释和IDE(集成开发环境)中的历史代码实时生成代码建议。

这次,Amazon CodeWhisperer首次与Amazon Glue Studio Notebooks实现集成,能够帮助用户优化使用体验,提高开发效率。

通过Amazon Glue Studio Notebooks,开发人员用特定语言来编写任务,然后Amazon CodeWhisperer会推荐一个或多个可以完成此任务的代码片段。

Amazon CodeWhisperer针对最常用的API进行了优化,例如Amazon Lambda或Amazon Simple Storage Service(Amazon S3),使其成为构建应用程序开发者们的绝佳编码伴侣。

除此之外,亚马逊云科技还提供了7门免费的技能培训课程,帮助开发者以使用生成式AI。

其中,还联手吴恩达推出了「用大型语言模型构建生成式AI」新课程。

医疗领域已有落地应用

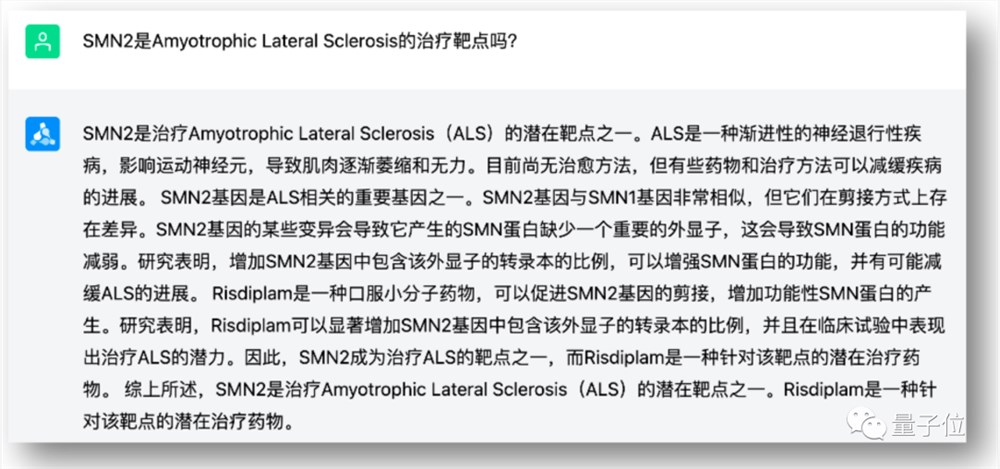

今年这波AI大模型的浪潮,也激发了人们对生成式AI在医疗行业的应用的探索。

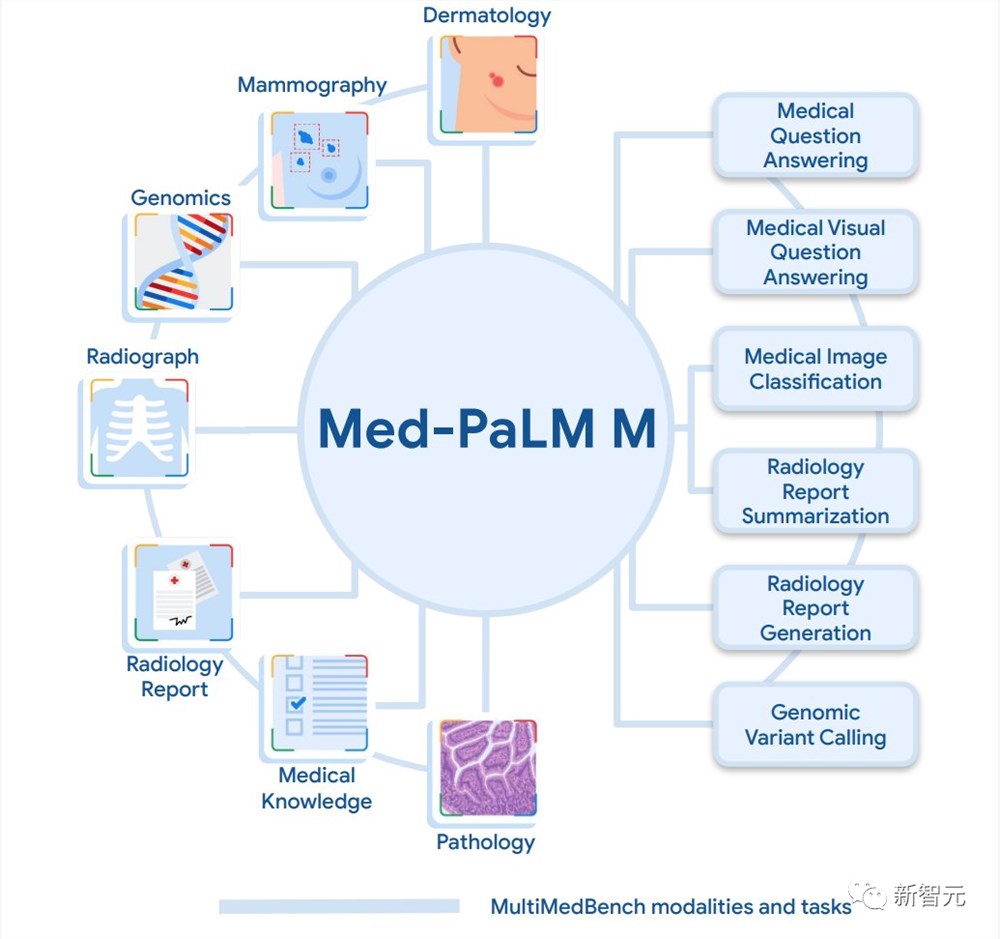

比如前几天,谷歌发布了一个「通才生物医学AI」——Med-PaLM M多模态模型。这个多模态生成模型能够利用医学的丰富数据,使用相同的模型权重集解释临床语言、医学图像和基因组学。

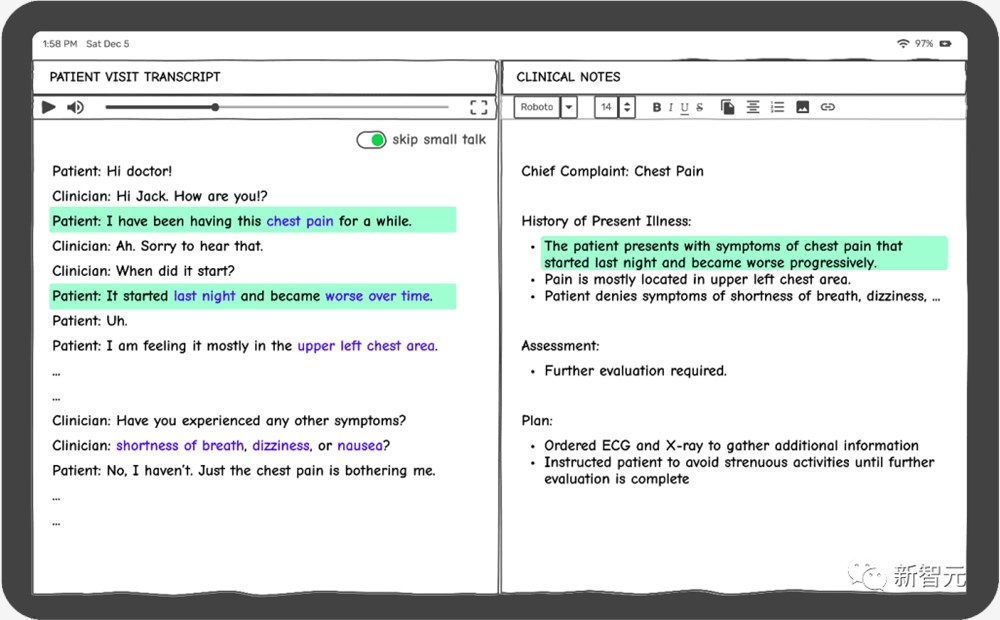

同样,对于AI在医疗行业的应用,亚马逊云科技也同样有所行动,发布了一款面向医疗保健软件提供商的全新服务——Amazon HealthScribe。

Amazon HealthScribe通过使用使用生成式AI的机器学习模型和语音识别,能自动起草临床文档,帮助临床医生转录和分析他们与患者的对话。

它的自然语言处理功能,还可以从对话中提取复杂的医学术语,比如药物和医学状况。病史、要点、就诊原因,一应俱全。

Amazon HealthScribe中的AI功能,正是由Amazon Bedrock提供支持的,通过预训练模型,用户就可以从初创公司以及亚马逊自身构建生成式AI了。

可以说,作为全球云计算的开创者,亚马逊云科技看到了AI浪潮当下,生成式人工智能的潜力和重要性。

生成式AI能够有改变每一个应用程序、每一个业务、甚至每一个行业。

数据处理、算力和机器学习的进步,正在加速许多企业从实验到部署的转变。

通过提供Amazon Bedrock等服务,以及与行业领导者的合作,这家公司正在普及对生成性人工智能的访问。

在不断创新的基础上,亚马逊云科技正在让开发者,让世界重新构想体验,把最好的产品带入生活。

网易成中国市值第四大互联网公司

截至12月13日收盘,网易的港股市值达到了5425亿港元,超过了美团的5133亿港元市值,使其成为中国的第四大互联网公司。最新的财报显示,2023年第三季度,网易的营收为273亿元,同比增长了12%。其中,核心业务游戏及关联增值服务营收同比增长了16.5%至218亿元。非公认会计准则下,归属于公司股东的持续经营净利润为86亿元。0000ConverSight 融资900万美元,利用生成式 AI 加速数据分析

总部位于印第安纳波利斯的初创公司ConverSight宣布获得900万美元的A轮融资,致力于利用生成式人工智能为企业提供更好、更快的数据分析。该公司表示,将利用新资金推动上市工作,并通过新功能扩展其产品,包括所谓的“MarketSpace”。站长网2023-08-29 11:32:340000实时AI互动平台Albus Beta 巧妙融合GPT技术和多元化功能

AlbusBeta,作为一款实时的AI互动平台,通过引入GPT技术,旨在以全新的方式从多个视角深度挖掘用户所热衷的各类主题,使探索之旅更为有趣且富有成效。该平台的核心功能在于利用GPT技术,为用户提供一个实时的探索平台,使用户能够以崭新的视角来深入研究自己感兴趣的主题。除了助力用户发现新思想、概念和观点外,AlbusBeta还能够协助用户更深入地理解和掌握他们关心的领域。站长网2023-11-30 16:42:270000文旅部与百度合作 基于AI推进非遗数字化项目建设

近日,文化和旅游部与百度签订战略合作协议,以共同推动中国文化和旅游产业的智能化发展。双方将在文旅大数据服务、智慧文旅建设、非物质文化遗产传播等多个领域展开深度合作,以提升中国文化旅游业的科技含量和国际影响力。此次合作将充分发挥百度在人工智能、大数据、云计算等领域的优势,将AI能力注入文旅建设,推动中国文旅产业智能化升级。站长网2023-08-03 08:08:140000首个千亿生物医药ChatGPT来了!清华AIR聂再清:这个行业未来的“Killer APP”

制药行业的“专家版ChatGPT”,终于来了!就在这两天,首个生物医药的千亿参数大模型产品ChatDD发布,不仅制药各阶段知识“样样通”,还能和药学专家进行对话,瞬间秒懂一些行业神秘“黑话”。这和AlphaFold2直接加个Chat功能还不太一样——现阶段大模型虽然能在药物发现上做得不错,但要么只涉及单个模态,要么不具备直接对话能力。站长网2023-09-22 16:29:260002