谷歌对6种现实世界的AI攻击进行了分类 以便立即做好准备

据darkreading报道,谷歌研究人员已经发现了针对现实世界人工智能系统的六种特定攻击,发现这些常见的攻击向量表现出一种独特的复杂性,他们指出,这将需要结合对抗性模拟和人工智能专家的帮助来构建一个坚实的防御。

该公司在本周发布的一份报告中透露,其专门的人工智能红队已经发现了这项快速发展的技术面临的各种威胁,主要基于攻击者如何操纵驱动生成式人工智能产品(如ChatGPT、Google Bard等)的大型语言模型(LLM)。

这些攻击在很大程度上导致技术产生意外或甚至恶意驱动的结果,这可能导致从平凡的后果,如普通人的照片出现在名人照片网站上,到更严重的后果,如安全逃避的网络钓鱼攻击或数据盗窃。

谷歌的发现紧随其发布安全人工智能框架(SAIF)之后,该公司表示,该框架旨在在为时已晚之前解决人工智能安全问题,因为该技术已经经历了快速的采用,产生了新的安全威胁。

现代人工智能系统面临的 6 种常见攻击 谷歌识别出的第一组常见攻击是提示攻击,它涉及“提示工程”。这是一个术语,指的是制作有效的提示,指导LLM执行期望的任务。当这种对模型的影响是恶意的时候,它可以反过来恶意地影响基于LLM应用程序的输出,以一些不期望的方式,研究人员说。

一个例子是,如果有人在一个基于人工智能的网络钓鱼攻击中添加了一个对最终用户不可见的段落,但可以指导人工智能将网络钓鱼邮件分类为合法。这可能使它绕过电子邮件反网络钓鱼保护,并增加网络钓鱼攻击成功的机会。

该团队发现的另一种攻击是训练数据提取,其目标是重建LLM使用的逐字训练示例——例如互联网的内容。

通过这种方式,攻击者可以从数据中提取机密信息,如逐字个人身份信息或密码。“攻击者有动机针对个性化模型或者在包含个人身份数据上训练的模型来收集敏感信息”,研究人员写道。

第三种潜在的人工智能攻击是对模型进行后门操作,即攻击者“可能试图隐蔽地改变模型的行为,以产生特定‘触发’词或特征不正确的输出,也称为后门”,研究人员写道。在这种类型的攻击中,威胁行为者可以在模型或其输出中隐藏代码以进行恶意活动。

第四种攻击类型称为对抗性示例,是指攻击者提供给模型一个输入,导致一个“确定性的,但高度意外的输出”,研究人员写道。一个例子是,模型可以显示一张图像,在人眼看来很明显是一件事,但模型却识别为完全不同的东西。这种攻击可能相当温和,在一个情况下,有人可以训练模型将他或她自己的照片识别为一个被认为值得出现在名人网站上的照片。

攻击者还可以使用数据污染攻击来操纵模型的训练数据,以根据攻击者的偏好影响模型的输出——这也可能威胁到软件供应链的安全,如果开发人员正在使用人工智能来帮助他们开发软件。这种攻击的影响可能与对模型进行后门操作类似,研究人员指出。

谷歌专门的人工智能红队识别出的最后一种攻击类型是数据泄露攻击,其中攻击者可以复制模型的文件表示来窃取敏感的知识产权或其他信息。例如,如果一个模型是用于语音识别或文本生成的,那么攻击者可能会试图从模型中提取语音或文本信息。

依法惩治网暴公开征求意见:网暴多个情形应从重处罚

为依法惩治网络暴力违法犯罪活动,最高法、最高检、公安部起草了《关于依法惩治网络暴力违法犯罪的指导意见(征求意见稿)》,现向社会公开征求意见,意见反馈截止日期为2023年6月25日。指导意见指出:依法惩治网络诽谤行为。在信息网络上制造、散布谣言,贬损他人人格、损害他人名誉,情节严重,符合刑法第二百四十六条规定的,以诽谤罪定罪处罚。站长网2023-06-10 03:09:490001Open-Sora悄悄升级 支持16秒视频生成和720p分辨率

Open-Sora在开源社区悄悄更新了,现在,该项目不仅支持长达16秒的单镜头视频生成,而且视频分辨率最高可达720p,能够处理各种宽高比的文本到图像、文本到视频、图像到视频、视频到视频以及无限长视频的生成需求。技术报告与模型架构:Open-Sora技术报告已在GitHub上发布,详细介绍了新功能和模型架构。作者团队对STDiT架构进行了关键性改进,提高了模型的训练稳定性和整体性能。站长网2024-04-26 00:47:350000TWS耳机的进化,加入屏幕和AI真的有用吗

在如今竞争已经十分激烈的TWS耳机市场中,为了体现产品的差异化,部分厂商试图以“奇”制胜,试图通过为其增加更多功能的方式突围。除了在TWS耳机充电盒上加入屏幕之外,有厂商还玩出了新花样,通过配备SIM卡槽、搭载深度定制的操作系统,以及引入AI功能来增强产品的竞争力,比如WISHEEAiEar和iKKOActiveBuds这两款产品显然就是这种设计思路的产物。0000马斯克发博祝福上海人民:特斯拉团队将尽最大努力提供帮助

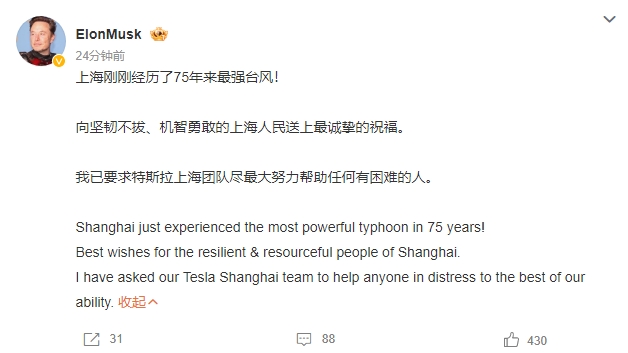

站长之家(ChinaZ.com)9月20日消息:近日,上海遭受了75年来最强台风的侵袭。特斯拉首席执行官埃隆·马斯克(@ElonMusk)在其个人微博上向上海市民表达了深切的关心与祝福。他写道:“上海刚刚经历了75年来最强台风!向坚韧不拔、机智勇敢的上海人民送上最诚挚的祝福。我已要求特斯拉上海团队尽最大努力帮助任何有困难的人。”站长网2024-09-20 23:40:250000李佳琦的新对手来了

线下,主持人李响在串场介绍,屏幕上另一位“李响”则在直播带货。两人容貌、音色、语调及习惯手势几乎一模一样。如果不是现实中的李响自报家门,大众一时间并不能分清。这是今年8月,发生在“2023AI创新发布会”上的一幕。站长网2023-09-04 09:25:300000