苏黎世大学研究员开发SwissBERT多语言模型 针对瑞士小语种

站长网2023-07-18 19:02:050阅

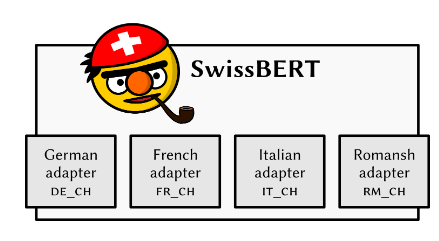

瑞士苏黎世大学的研究人员开发了一种名为 SwissBERT 的多语言语言模型,用于瑞士的四种官方语言。

之前,瑞士研究人员在多语言任务上面临困难,因为每种语言都需要单独的语言模型,而且其中一种语言甚至没有独立的神经语言模型。SwissBERT 通过组合这些语言的文章并隐式利用新闻中的实体和事件来创建多语言表示,解决了这一问题。

SwissBERT 模型是基于跨语言模块化(X-MOD)转换器进行改造的,该转换器已经在81种语言上进行了预训练。研究人员通过训练自定义的语言适配器将 X-MOD 转换器应用于他们的语料库中。他们为 SwissBERT 创建了瑞士特有的子词词汇表,生成的模型包含多达1.53亿个参数。

该模型在任务上的表现良好,例如命名实体识别和检测用户对瑞士政治的评论中的立场。在评估模型在罗曼什语上的能力时,发现 SwissBERT 在零样本跨语言迁移以及单词和句子的德语-罗曼什语对齐方面远远优于未使用该语言进行训练的模型。然而,该模型在识别 OCR 处理的历史新闻中的命名实体方面表现不佳。

通过微调下游任务,该模型在未来的研究和非商业用途中可能具有潜力。

论文:https://arxiv.org/pdf/2303.13310.pdf

项目介绍:https://vamvas.ch/introducing-swissbert

模型网址:https://huggingface.co/ZurichNLP/swissbert

0000

评论列表

共(0)条相关推荐

vivo OriginOS 4下周发布!行业首发虚拟显卡:系统更流畅 支持光追

快科技10月29日消息,2023vivo开发者大会将于11月1日(下周三)举行,届时,全新系统OriginOS4会正式发布,Slogan为流畅好用,智有妙用”。vivo品牌副总裁贾净东透露,OriginOS4在计算机算法技术上更进一步。据介绍,OriginOS4行业首发虚拟显卡、异构计算空间等算法技术。站长网2023-10-29 09:09:520000云从科技AI子公司众数信科完成数千万Pre-A轮融资

云从科技子公司众数信科近日获得了由知名投资机构诚美资本和火炬兴业科创基金数千万Pre-A轮融资。众数信科由云从科技、创始团队和厦门火炬创投等机构共同发起设立。公司致力于成为“AI智能体”行业先行者,聚焦AI大模型的轻量化和行业模型打造,基于自研的知识提炼和AI智能体编程技术,将客户的私域数据、行业知识与AI技术深度结合,形成客户专属的AI业务智能体,提供创新的AI大模型解决方案。0000B站影视区,正在成为“活人”观影风向标

昨天下午两点,电影《从21世纪安全撤离》正式上映,豆瓣开分打到7.7分,比起点映时的口碑两极化,可谓风评逆转。这波风向里,B站罕见地成了关键。电影正式上映前,就有人将这部电影与B站挂钩,“这是看了多少B站鬼畜混剪才能拍出来的片子”。B站也专门举办了观影团,带动UP主与主创团队互动。站长网2024-08-04 11:00:120000独家|微信蚂蚁押注AI应用商店,巨头争抢千亿“苹果税”

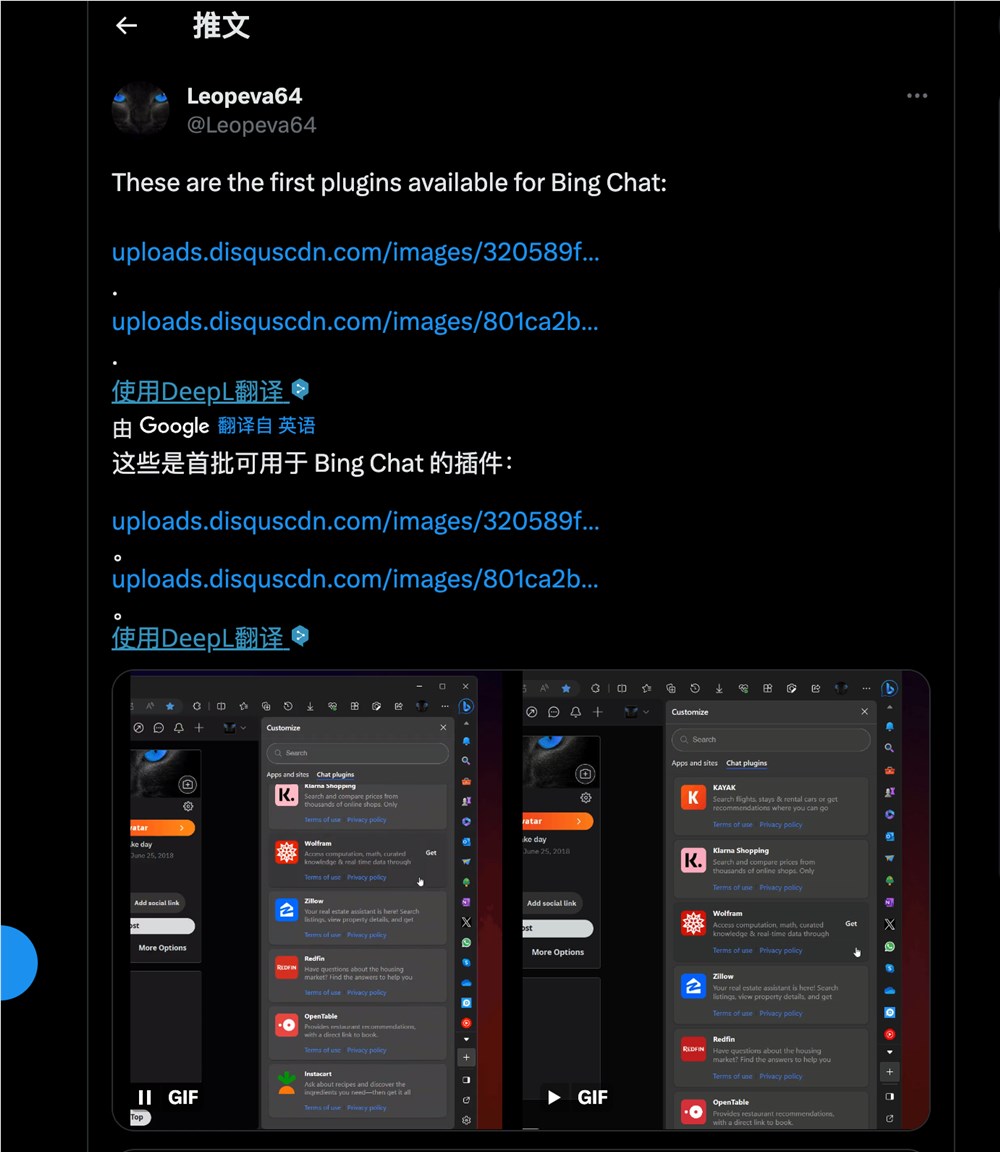

Tech星球独家获悉,微信的云开发团队正在打造一款名为“云开发AI智能体”的应用平台,这是一个多平台AI智能体开发框架,用于企业和小程序提供专属的智能体平台。通过该平台,用户可以实现0代码开发,打造专属个性化智能助手产品。图注:微信云开发AI智能体平台。站长网2024-08-16 14:10:110000微软开始测试 Edge 浏览器中添加的首批 Bing Chat 插件

站长之家(ChinaZ.com)8月8日消息:微软宣布对其人工智能驱动的BingChat进行了一系列更新,意味着微软将进一步努力使聊天机器人在各个平台上更易于访问和功能更丰富。站长网2023-08-08 16:36:120000