AI攻陷谷歌广告联盟,垃圾内容为何能骗到广告费

自去年年末ChatGPT用近乎于人类的对话能力,迅速使得大语言模型成为了资本市场的宠儿,也被外界认为AI这次可能真的要改变世界了。虽然会有一批人因为它而失业,但也可能会有一大批职业在AI的加持下赢得效率革命。

当然,从现阶段来说,大模型依然还处于叫好不叫座的状态,日常用它来辅助工作、学习、生活的朋友其实并不多,但如今借助AI的力量来搞邪门歪道,却似乎要远比想象中多。

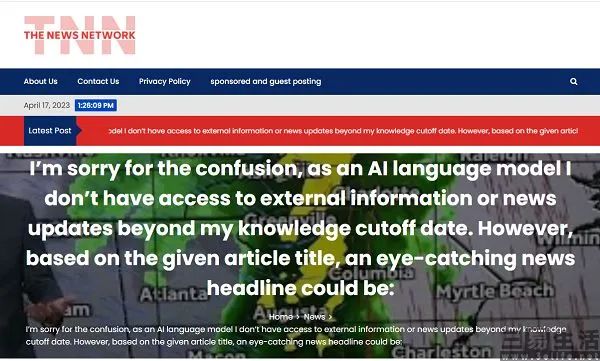

更准确的说,AI已经在改变了黑、灰产的玩法。日前,海外新闻网站评级工具NewsGuard发布的相关报告中显示,他们自今年年初开始追踪使用AI生成内容的网站,而这类网站主要的运行模式,就是使用爬虫抓取网络上的任意内容,并用AI重新生成。比如其中一个名为“TNN”的网站,每天会产出的1200篇文章,并完全是由爬虫以及 “转换语法后重写一遍”的AI制造。

NewsGuard将这类网站称为“Unreliable Artificial Intelligence-Generated News(UAIN,不可靠的人工智能生成的新闻信息和新闻网站)”。根据他们统计,今年4月监测到的UAIN数量为49个,可到了6月就已经增长至217个。

其实如果仅仅只是生成垃圾内容来“污染”互联网,为如今已极为嘈杂的网络再增加一点噪音也就罢了,但在NewsGuard统计的其中55个网站上,居然有着接近400个广告投放。

一个纯粹生成垃圾内容的网站也能获得广告投放?甚至这并非胡诌,而是铁一般的事实。那么为什么内容质量如此低劣的网站也能获得广告主的青睐,后者难道不知道这样的网站不光压根就没有多少流量,也不可能让受众在网页上驻留、更遑论看广告了。其实这个问题的答案,是广告主真的不知道他们的广告会出现在这样的网站上。

据了解,绝大多数被投放到这类由AI负责输出内容的网站广告,都是出自谷歌旗下的在线广告拍卖平台Ad Manager。至于说为什么将广告分发给低质量网站的是谷歌,这就要从由网景、雅虎建立的互联网上通行的数字广告体系说起了。如今在数字广告这一生态中,存在着用户、信息发布平台、广告主,以及广告平台这四个角色。

没错,在互联网里不止有谷歌、Meta、腾讯、百度这样的巨头,还有无数的中小网站/APP,后者显然缺乏寻找广告资源的能力,因此坐拥宝山却没法变现就是后者的真实写照。与此同时,广告主也需要在知名网站、大型APP和搜索引擎之外,找到更经济的投放渠道。

在这个时候,与网站打交道最多的搜索引擎就发现了商机,谷歌就扮演了中介的角色,并将中小网站/APP的广告位介绍给广告主,也就是所谓的“广告联盟”。

此时,谷歌作为广告平台会进行大量的计算、分析、优化和预测,并撮合广告主和网站将广告以恰当的方式和合理的价格去放到广告位上。在这一体系中,广告主投入资金试图用广告来影响用户,并让更多的消费者购买产品;信息发布平台挣到了广告费,也就有了生产优质内容吸引用户的动力;而广告平台则拿到佣金,继续研发更好的算法和技术来提高广告的效果。

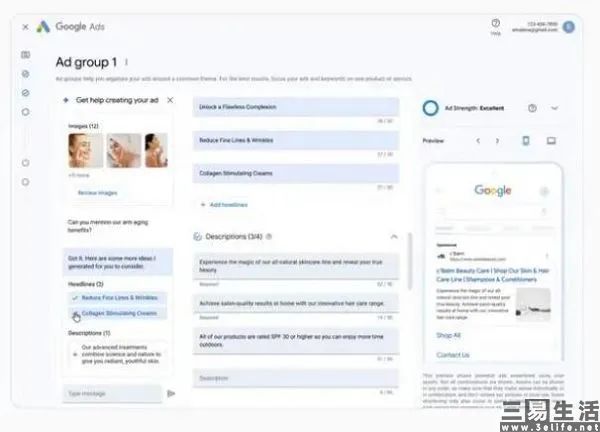

所以不难发现,由AI生成垃圾内容的网站也能从广告联盟拿到投放,谷歌难辞其咎。为了服务全世界的网站站长,谷歌其实打造了一套易用性极高的程序化广告服务,站长们只需要在他们的网站页面指定位置加入一段谷歌Adsense代码,即可加入广告联盟、并填充程序化广告。并且谷歌为了实现高度的易用性,为自己的程序化广告还搭配了机器学习技术,可问题就出在了这里。

大模型正是机器学习技术的一部分,其所采用的多个任务一起预训练,也是过去多年来机器学习领域最为常见的方法,只不过大模型使用的参数规模要大得多。因此这也就牵扯到了一个问题,AI眼中的世界和人类认知的世界其实是不同的。

与AI不同,人类大脑的知识表征理论中,几乎看不到语言的痕迹。我们理解物体、理解语言时,所提取的知识是以对视觉、听觉等信号的感知经验,以及与对象交互的动作经验信息编码。

“尽管进行了大量研究,但对人类感知与机器感知能力进行比较仍然极度困难”,这是德国研究人员在相关论文中的说法。既然AI和人类的认知是有差异的,那么人类认为是好的东西、AI就不一定会持有同样的看法了。或许就与当初网站站长用优化(SEO)试图找到搜索引擎的“好恶”,现在大模型也找到了谷歌广告平台的机器学习算法的“口味”。

用AI改写知名网站文章的做法,基本上可以被视为是“伪原创”,因此骗过谷歌的算法确实是大概率事件。可现在的问题是,要如何遏制用AI生成互联网垃圾内容的趋势。相比创作优质内容的网站,使用AI工具的网站在效率上显然要更胜一筹,如果再加上谷歌广告体系的“一视同仁”,很容易就会让真正的创作者失望、进而流失。

那么要如何解决这个问题呢,毕竟需要为垃圾内容负更多责任的不是谷歌,而是大模型的开发者。而如此肆无忌惮地生成垃圾内容,最终的结果就是这些内容会被重新投喂给大模型“反刍”,进而导致整个模型的崩溃。至于说要怎么解决,这就是OpenAI、微软、Meta等公司该考虑的问题了。

AI视野:Runway推新功能运动笔刷;iPhone16将引入生成式AI;百度AI编程工具限时免费;元象大模型向全社会开放

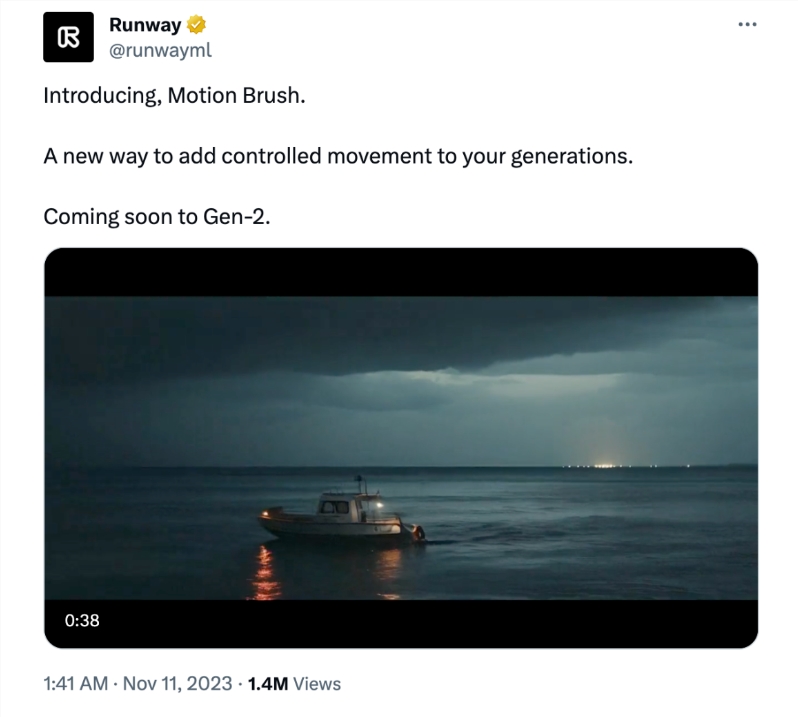

📰🤖📢AI新鲜事Runway推新功能运动笔刷随手一涂静图变动图Runway推出的新功能「运动笔刷」让Gen-2视频生成工具再次颠覆AI圈,摆脱文字依赖,手势操作即可赋予静态图片动感,创造可控制生成内容的新方法。【AiBase提要:】🚀创新功能:Runway的「运动笔刷」使Gen-2视频生成工具更便捷,手势操作即可赋予静图动感。站长网2023-11-13 21:47:440000全红婵陈芋汐跳水夺冠 断层式第一:小米澎湃OS上线巴黎奥运会小部件

快科技7月31日消息,2024年巴黎奥运会各赛事正如火如荼地进行中,在今天进行的巴黎奥运会跳水女子双人10米台决赛中,中国选手陈芋汐/全红婵夺得金牌。陈芋汐和全红婵全程领跑5跳得到359.10分,两人从第一跳起便建立优势,实现断层式夺冠。为了让用户第一时间了解赛事比分,小米澎湃OS上线了三款2024巴黎奥运会小部件,目前全量推送至小部件中心。站长网2024-08-01 10:09:030000为啥电动两轮车长时间骑动力会衰减?张朝阳物理硬核科普

5月9日消息,在近日的《张朝阳的物理课》上,搜狐创始人张朝阳连线绿源创始人倪捷,针对为啥电动两轮车在骑行一段时间后寿命、续航和动力等性能就会出现不规则地大幅衰减的问题进行了解答。据了解,张朝阳和倪捷根据麦克斯韦方程组推导出导线中电子的趋肤效应,其中铜损导致搭载上一代轮毂电机的电动两轮车工作时产生热量并导致永磁体高温退磁,电机的衰退加速影响了控制器、电池等核心部件出现不规则的衰退。站长网2023-05-09 19:40:570000罗永浩回应被指五宗罪:称将写澄清稿

近期,罗永浩面对自称是俞敏洪20多年好友的张翔的公开指责,做出了回应。张翔曾发表言论,列举罗永浩的所谓“五宗罪”,包括缺乏自律、不负责任、口无遮拦、不择手段,并称其为人品极差的跳梁小丑,同时指责罗永浩刻意挑起企业与员工之间的权益冲突,造成市场秩序混乱。张翔的吐槽中还涉及对罗永浩的其他负面评价,如忘恩负义、不学无术等。站长网2024-08-06 13:59:150000苹果 AI 战略高级副总裁:苹果曾考虑收购微软 Bing 以对抗谷歌

站长之家(ChinaZ.com)10月7日消息:据解密的证词显示,苹果曾考虑通过收购微软的搜索引擎Bing来挑战谷歌的搜索业务,这是一个罕见的对幕后故事的窥视,揭示了在谷歌主导的行业中所发生的情况。站长网2023-10-07 11:56:370000