视频生成模型 Zeroscope开源 免费无水印

据huggingface 页面显示,一款名为 Zeroscope_v2_576w 的视频生成模型现已开源。

Zeroscope_v2_576w 基于 Modelscope 打造,是一个具有17亿个参数的多级文本到视频扩散模型。它根据文本描述生成视频内容。并且提供更高的分辨率,没有 Shutterstock 水印,并且宽高比更接近16:9。

Zeroscope 具有两个组件: Zeroscope_v2567w,专为以576x320像素的分辨率快速创建内容以探索视频概念而设计。然后可以使用 Zeroscope_v2XL 将优质视频升级到1024x576的“高清”分辨率。

对于视频生成,该模型需要7.9GB 的 VRam(分辨率为576x320像素、帧速率为每秒30帧)和15.3GB 的 VRam(分辨率为1024x576像素、帧速率为每秒)。因此,较小的型号应该可以在许多标准显卡上运行。

Zeroscope 的训练涉及将偏移噪声应用于9,923个剪辑和29,769个标记帧,每个帧包含24帧。偏移噪声可能涉及视频帧内对象的随机移动、帧时序的轻微变化或轻微的失真。

训练期间引入的噪声增强了模型对数据分布的理解。因此,该模型可以生成更多样化的真实视频,并更有效地解释文本描述的变化。

根据拥有 Modelscope 经验的 Zeroscope 开发者“Cerspense”的说法,用24GB VRam 微调模型并不“超级困难”。他在微调过程中删除了 Modelscope 水印。

他将自己的模型描述为“旨在挑战 Gen-2”,即 Runway ML 提供的商业文本到视频模型。根据 Cespense 的说法,Zerscope 完全免费供公众使用。

目前,文本到视频仍处于起步阶段。人工智能生成的剪辑通常只有几秒钟长,并且存在许多视觉缺陷。然而,图像人工智能模型最初面临类似的问题,但在几个月内就实现了照片级真实感。但与这些模型不同的是,视频生成无论是训练还是生成都需要消耗更多的资源。

谷歌已经推出了Phenaki 和 Imagen Video,这两种文本到视频模型能够生成高分辨率、更长、逻辑连贯的剪辑,尽管它们尚未发布。Meta 的Make-a-Video(文本转视频模型)也尚未发布。

目前,只有Runway 的 Gen-2已商用,并且现已在 iPhone 上提供。Zeroscope 标志着第一个高质量开源模型的出现。

京东2023年收入破万亿!人力资源支出超千亿 今年大幅涨薪

快科技3月6日消息,京东集团今天公布了2023年四季度及全年业绩。财报显示,2023年,京东全年收入达10847亿元,同比增长3.7%。全年Non-GAAP净利润352亿元,同比增长24.7%。2023年,京东集团人力资源总支出(包括自有员工和外部人员)1047亿元,持续推动高质量就业。截至2023年底,京东集团为社会创造近62万就业业岗位。0000东方甄选入驻拼多多:农产品销售平台拓展新渠道

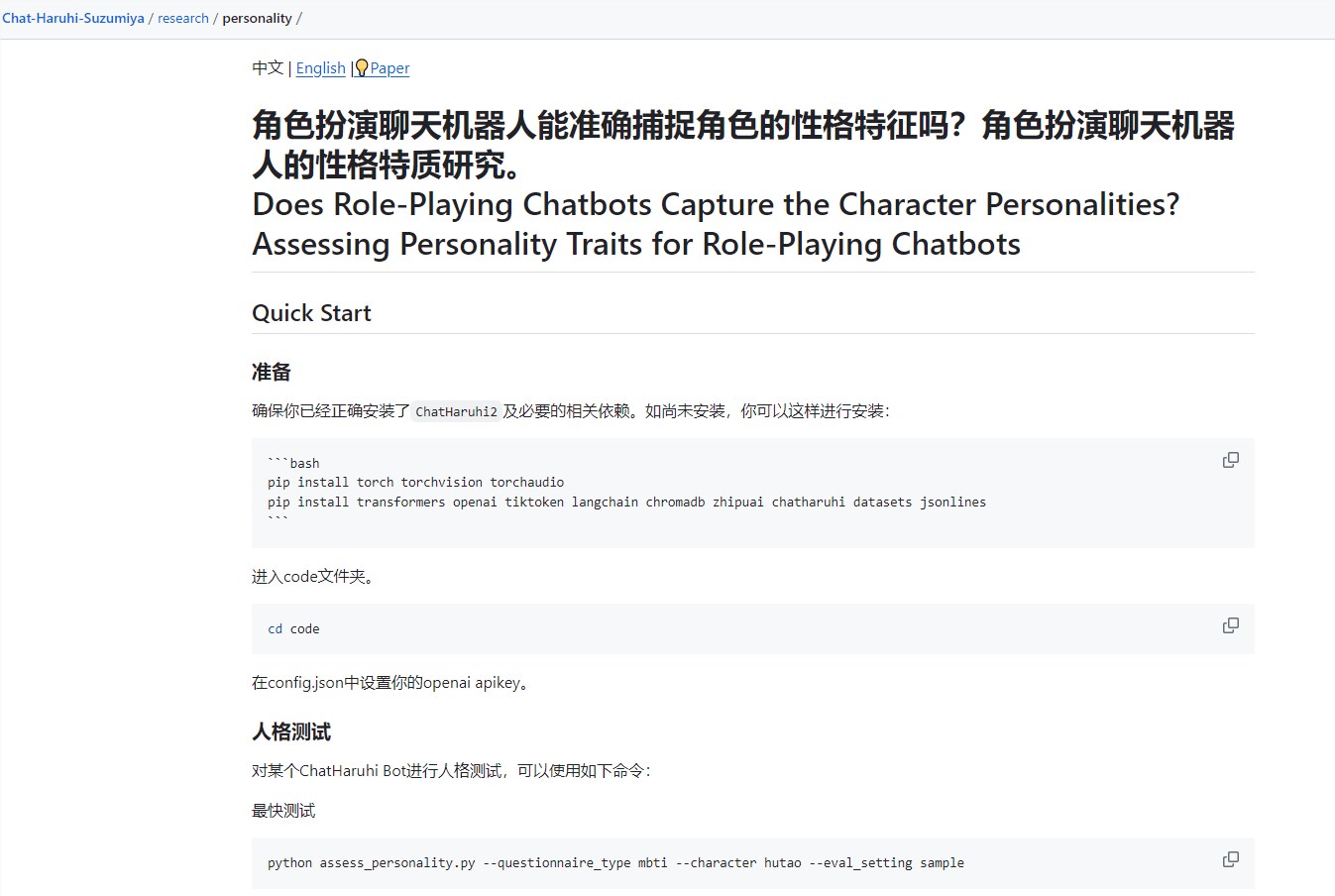

近日,有网友发现,东方甄选已在拼多多上开设了网店,其店铺简介标注为“新东方在线农产品销售平台”。根据@东方财经的搜索结果显示,该店目前已拼出1880件商品。针对此举,东方财经进行了询问,店铺客服回复称,拼多多店铺是最近开设的,虽然产品与App上相同,但只上架了部分商品。虽然目前仅有部分商品上架,但随着时间的推移,预计东方甄选将逐步完善其在拼多多上的店铺,并提供更多优质的产品供消费者选择。站长网2024-03-01 15:22:420000复旦、人大等发布大五人格+MBTI测试 角色扮演AI特质还原率达82.8%

要点:复旦大学和中国人民大学联合Chat凉宫春日团队发布的研究强调,评价AI角色扮演的关键在于良好的人设还原度,其特质还原率达到82.8%。使用大五人格的NEO-FFI问卷和MBTI的16Personalities测试,研究人员通过LLM进行引导式开放式问答,对AI角色进行全面的人格测试,从心理学的角度研究角色扮演AI的行为模式。站长网2023-11-20 12:05:390001据报道,苹果因需求低迷而削减 Vision Pro 产量

划重点:⭐️苹果因预期之外的低需求削减VisionPro生产。⭐️预计2024年销量仅为40万至45万台,远低于市场预期。⭐️调整头戴设备路线图,可能推迟低成本混合现实头盔的推出。据苹果分析师郭明錤称,苹果在VisionPro推出美国以外市场之前就已削减了订单。站长网2024-04-24 11:40:1900006款产品总流水过亿、出海厂商上榜,谁在领跑混合休闲赛道?

给流量大的超休玩法调控数值保证留存,再配上一套IAP系统拉高流水做混合变现,由此“改造”出一款混合休闲产品,是2024年全球手游市场的一大现象,不少原来的超休大厂凭借这套操作,拿下了不错的成绩。最近Rollic又沿用这种模式,跑出了一款产品、爬上了美国iOS手游畅销榜。0000