Meta发布AI图片学习模型I-JEPA:可自我学习推理

Meta的首席人工智能科学家Yann LeCun已经讨论了几年能够在很少或完全不需要人类的帮助下学习世界模型的深度学习系统。现在,这个愿景正在慢慢实现,因为 Meta 刚刚发布了 I- JEPA 的第一个版本,这是一个机器学习 (ML) 模型,通过对图像的自我监督学习来学习世界的抽象表示。

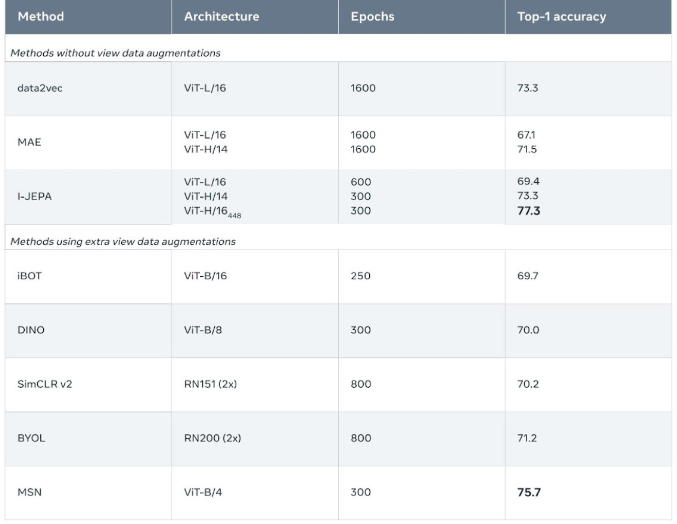

初步测试显示,I-JEPA在许多计算机视觉任务上表现优秀。它也比其他最先进的模型更高效,仅需要训练的计算资源的十分之一。Meta已经公开了训练代码和模型,并将在下周的计算机视觉和模式识别(CVPR)会议上展示I-JEPA。

自我监督学习

自我监督学习的想法受到人类和动物学习的启发。我们很多知识都是通过观察世界获取的。同样,人工智能系统应该能够通过原始观察学习,而无需人类标记他们的训练数据。

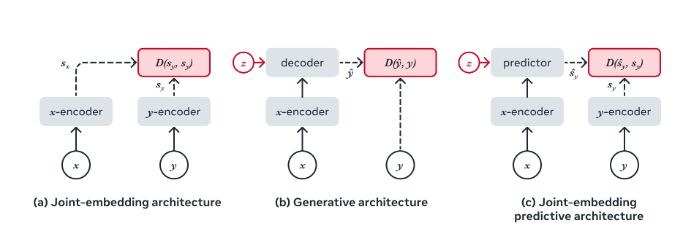

自我监督学习已经在一些人工智能领域取得了显著的进展,包括生成模型和大型语言模型(LLMs)。在2022年,LeCun提出了“联合预测嵌入架构”(JEPA),这是一种可以学习世界模型和常识等重要知识的自我监督模型。JEPA在重要方面不同于其他自我监督模型。

生成模型(例如DALL-E和GPT)旨在进行细致的预测。例如,在训练期间,文本或图像的一部分被遮盖,模型尝试预测确切的缺失单词或像素。尝试填补每一个细节的问题是,世界是不可预测的,模型经常陷入许多可能的结果中而无法前进。

相比之下,JEPA不是关注像素级的细节,而是试图学习和预测高层次的抽象,例如场景必须包含什么以及对象如何相互关联。这种方法使模型在学习环境的潜在空间时不易出错,成本也大大降低。

“通过在高抽象级别上预测表示,而不是直接预测像素值,我们希望直接学习有用的表示,并避免了生成方法的局限性,”Meta的研究人员写道。

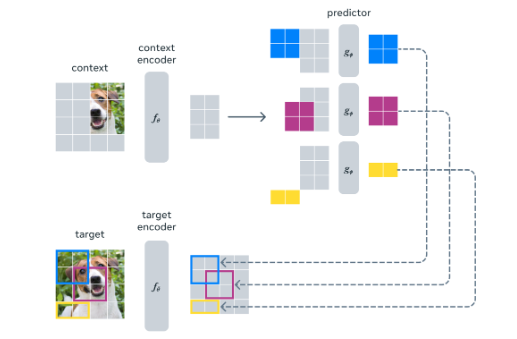

I-JEPA是LeCun提出的架构的基于图像的实现。它使用“抽象预测目标”来预测缺失信息,可能会消除不必要的像素级细节,从而使模型学习更多的语义特征。

I-JEPA使用Vision Transformer(ViT)对现有信息进行编码,这是一种用于LLM中的Transformer架构的变体,但是对图像处理进行了修改。然后,它将此信息作为上下文传递给预测器 ViT,该预测器为缺失的部分生成语义表示。

Meta的研究人员训练了一个生成模型,用于从I-JEPA预测的语义数据中创建草图。在下图中,I-JEPA在蓝色框外的像素作为上下文,然后预测了蓝色框内的内容。生成模型然后创建了I-JEPA预测的草图。结果显示,I-JEPA的抽象匹配了场景的真实情况。

虽然I-JEPA不会生成写实的图像,但它可以在机器人和自动驾驶汽车等领域中具有许多应用,其中AI机器人必须能够理解其环境并处理一些非常合理的结果。

一个非常有效的模型

I-JEPA的一项明显好处是其内存和计算效率。预训练阶段不需要其他类型的自我监督学习方法中使用的计算密集型数据增强技术。研究人员能够使用16个A100GPU在不到72小时内训练出一个拥有632百万参数的模型,约为其他技术的十分之一。

“经验证明,我们发现I-JEPA可以不使用手工制作的视图仿真来学习强大的即插即用的语义表示,”研究人员写道。

他们的实验表明,I-JEPA在图像分类、物体计数和深度预测等计算机视觉任务中需要远远较少的微调,即可超越其他最先进的模型。研究人员能够使用仅占1%的训练数据在ImageNet-1K图像分类数据集上进行微调,每类仅使用12至13个图像。

“通过使用具有较少刚性感应偏置的更简单的模型,I-JEPA适用于更广泛的任务,”研究人员写道。鉴于互联网上未标记数据的高可用性,I-JEPA 等模型对于以前需要大量手动标记数据的应用程序来说非常有价值。

项目网址:https://ai.facebook.com/blog/yann-lecun-ai-model-i-jepa/

小米Civi 3将于5月25日发布 首发天玑8200 Ultra

小米今日宣布,将于5月25日下午2点发布全新的小米Civi3。小米Civi3将采用全球首发的联发科天玑8200Ultra芯片,由小米与联发科联合设计,旨在提升影像性能。天玑8200Ultra单核得分为1148分,多核得分为3356分,内存方面搭载12GB。据爆料,小米Civi3将配备双3200万像素前置镜头,后置主摄像头为5000万像素IMX800,支持OIS光学防抖。站长网2023-05-22 09:57:290000尽管有 Bing Chat 人工智能工具 微软必应的市场份额仍在下降

尽管BingChat成功推出,但微软公司的搜索引擎Bing仍然在市场份额和营收方面远远落后于Google。根据Statcounter,2023年4月,微软Bing在桌面搜索市场份额为7.14%,而Google搜索占据了86.71%的市场份额。站长网2023-05-15 16:57:450001Llama 3突然来袭!开源社区再次沸腾:GPT-4级别模型可以自由访问的时代到来

Llama3来了!就在刚刚,Meta官网上新,官宣了Llama380亿和700亿参数版本。并且推出即为开源SOTA:Meta官方数据显示,Llama38B和70B版本在各自参数规模上超越一众对手。8B模型在MMLU、GPQA、HumanEval等多项基准上均胜过Gemma7B和Mistral7BInstruct。站长网2024-04-19 09:21:180000谷歌的人工智能搜索体验增加了 AI 驱动的摘要、生词定义和编码改进

Google今天对其在近三个月前推出的SearchGenerativeExperience(SGE)进行一些新的更新。这是该公司基于人工智能的对话式搜索模式,旨在帮助用户更好地学习并理解他们在网络上发现的信息。这些功能包括查看生词的定义的工具,提高对跨语言编码信息的理解,以及在浏览时利用SGE的人工智能能力的有趣功能。站长网2023-08-16 09:05:140000陪伴我88天后,我终于能来聊聊这个3000块买的AI宠物了。

我养了一个新宠物,但不是活的那种。88天之前,好基友汗青从日本回国的时候,帮我带了一个心心念念很久的AI宠物,Moflin。花了我将近三千大洋。这个Moflin之前火到离谱,线上几乎就买不到货,线下只能在日本买,国内闲鱼直接炒到7000多。很多人可能还不太知道Moflin是个啥,可能也是第一次听说,AI宠物。0000