互联网时代下 AI 与人类创造力的角逐:当 AI 向 AI 生成数据学习时「模型崩溃」将引发混乱

在大型语言模型(LLM)越来越多地依赖于 ChatGPT 和其他工具来提高效率的情况下,我们可以预见到未来很大一部分网络内容将由人工智能生成。然而,这可能对大型语言模型的未来构成严重风险,因为目前它们依赖于从网络上抓取的人类生成数据。

剑桥大学、牛津大学、多伦多大学和伦敦帝国理工学院的一组研究人员发表了一篇研究论文,对 LLMs 最终使用人工智能生成数据作为训练数据提出了警告。这篇名为《递归的诅咒:在生成数据上训练会让模型遗忘》的论文描述了一种退化过程,称为「模型崩溃」,在这种过程中,模型与现实脱节,并被自己的输出内容所破坏。

随着人工智能工具的广泛使用,这种情况很可能会发生。广泛使用人工智能将导致人工智能生成的内容被作为大型语言模型的训练数据,从而导致其输出的不准确和失真。

这个问题在大型语言模型、变分自编码器和高斯混合模型中都有观察到,随着时间的推移,它们开始「遗忘真实的基础数据分布」,因为它们所训练的数据变得污染程度很高,不再与真实世界的数据相似。

鉴于模型崩溃的严重风险,研究人员强调了获得原始分布数据的重要性,这些数据通常由人类生成。毕竟,人工智能语言模型旨在与人类进行交互,因此需要与现实保持联系,以正确模拟我们的世界。

为解决这个问题,研究人员提出了几种更智能的大型语言模型训练方法。其中一种方法是「先发优势」,强调保留对原始人工生成数据源的访问权限。

然而,由于很难区分 AI 生成的数据和人类生成的数据,该研究论文明确提出,「社区范围的协调」对于确定数据来源至关重要,以确保涉及 LLM 创建和部署的各方共享所需的信息。

论文补充说,但在人们越来越广泛地使用生成式人工智能和对技术占据岗位的担忧之间,对于人类创作者来说也存在一线希望。

研究论文推测,随着互联网上生成式人工智能数据的增加,人类创造的内容将变得越来越有价值,即使只是作为训练大型语言模型时的无污染数据来源。

尽管需求激增,过去一年只有 13% 的员工接受AI培训

文章概要:-最新调查显示,尽管员工渴望接受人工智能(AI)培训,但企业在此方面进展缓慢。-Randstad的调查发现,全球范围内有20倍增长的AI技能需求,但仅有13%的员工在过去一年中接受了雇主提供的AI培训。-尽管员工对AI充满期待,但企业却未能提供足够的支持,导致技能需求与培训机会之间存在不平衡。站长网2023-09-07 12:00:510000英伟达第四季度营收221亿美元 CEO:人工智能活动“显着加速”

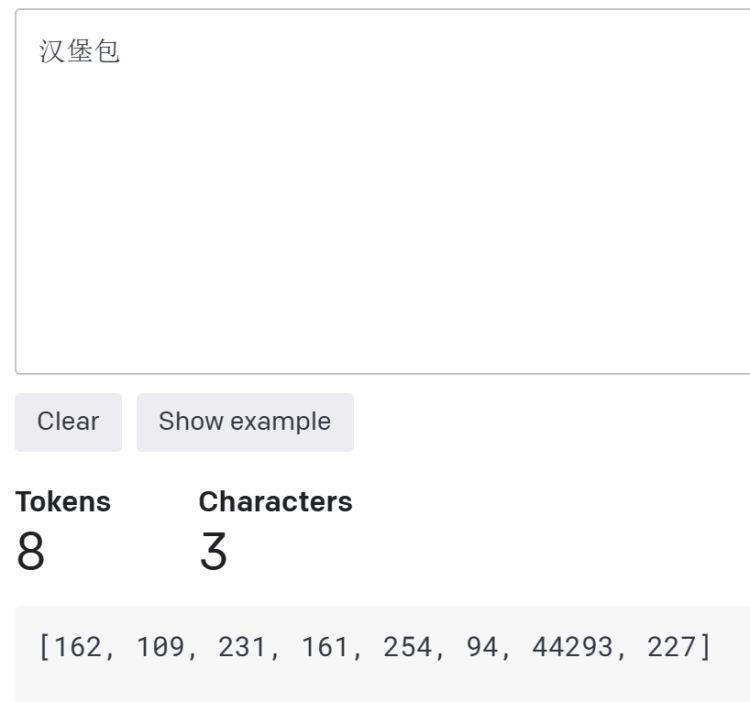

划重点:💰Nvidia第四季度报告营收暴涨265%,净收入激增769%。🚀JensenHuang宣布NvidiaAI作为服务,将由主要云服务提供商托管。💻NvidiaAI超级计算机DGX通过浏览器访问,已在OracleCloud、MicrosoftAzure和GoogleCloud上提供。站长网2024-02-22 10:15:010000中文大模型比英文更烧钱,这居然是AI底层原理决定的?

ChatGPT等AI工具的使用正越来越普遍。在与AI交互时,我们知道,输入的提示词差异会对输出结果产生影响。那么,如果相同意思的提示词,用不同语言分别表述,结果差异是否较大?另外,提示词的输入和输出是和模型背后的计算量直接挂钩的。因此,不同语言之间在AI输出和成本消耗方面是不是有着天然的差异性或者说是“不公平性”?这种“不公平性”又是如何产生的呢?站长网2023-09-07 09:01:330000网易云十年听歌报告上线 可查看最钟爱的艺人

今日,网易云音乐十年关注报告正式上线,用户在网易云音乐APP搜索“关注报告”即可查询。报告将展示2013年至今的十年间,用户关注最久的艺人、播放时长最长的艺人等信息。站长网2023-07-04 17:12:150000云从科技发布国内首款AI原生数据分析产品DataGPT

今日,云从科技发布了国内首款AI原生数据分析产品——DataGPT。该产品基于云从自主研发的从容多模态大模型,采用新颖的“对话即分析”交互模式,改变了企业对复杂数据的认知和应用方式,使数据解析变得简单自然。DataGPT具备以下六大亮点:1.领先的大模型驱动:运用从容大模型的领先技术,确保数据分析的高效与准确性,能够及时准确地回答任何复杂的统计需求。站长网2024-02-01 17:30:080000