英伟达多元化供应链:人工智能芯片需求激增 部分产品或交由英特尔代工

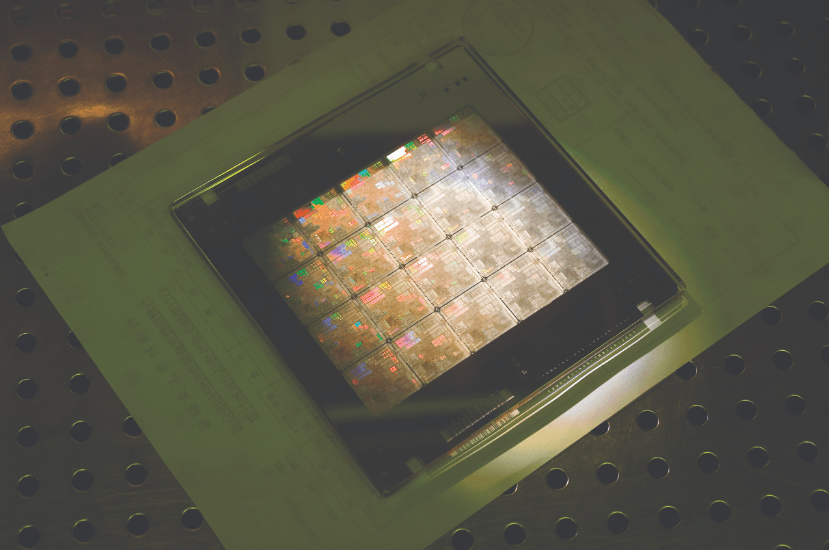

英特尔有可能成为英伟达未来 GPU 的制造商。英伟达 CEO 黄仁勋在 Computex 的全球媒体圆桌会议的问答环节时表示,公司正在努力多元化其芯片制造,并且最近已经获得了一款基于英特尔下一代工艺节点的测试芯片的良好测试结果。

他的这番言论是在多个问题集中讨论英伟达如何确保在人工智能芯片需求激增的情况下供应,并且公司完全依赖位于台积电来制造其最先进的 GPU。

黄仁勋表示:「你们知道我们还和三星合作制造,我们也愿意与英特尔合作制造。Pat [Gelsinger] 过去曾表示我们正在评估这一工艺,我们最近收到了他们下一代工艺的测试芯片结果,结果看起来不错。」

黄仁勋的讲话是在他首次表示英伟达正在与英特尔的制造服务部门(IFS)进行谈判,以制造其一些芯片的近一年之后。这得益于英特尔最近转向了 IDM 2.0 模式,将使用其最新的工艺节点为其他公司代工制造芯片。

当然,英特尔将根据自己的设计创建自己的测试芯片,以与客户分享有关工艺节点状况的数据,因此不能确定该芯片是否采用了英伟达的设计。黄仁勋没有具体说明测试芯片的结果是基于英伟达的架构设计,还是测试了哪个工艺节点。

但这款芯片有可能是基于英伟达的设计。今年 1 月,英特尔意外宣布已签署了一份基于其 Intel 3 节点的芯片订单。该公司最初表示其首批 IFS 芯片将基于其 20A、18A 和「Intel 16」节点。

英特尔首席执行官 Pat Gelsinger 表示:「我们非常高兴能够将领先的云端、边缘和数据中心解决方案供应商作为 Intel 3 的领先客户。」英特尔没有透露该客户的名称,但我们知道 Intel 3 节点计划在 2023 年下半年开始制造成品。

英伟达肯定符合英特尔新客户的描述,但其他公司也可能是这个新的未透露名称的英特尔客户。无论哪种情况,黄仁勋的言论可能会引发关于英伟达是否是新的未透露名称的英特尔客户的猜测。这并不确定,而且英伟达最初不太可能选择 Intel 作为英伟达的代工伙伴有助于帮助英伟达在芯片供应方面建立韧性和冗余性,但也存在其他挑战。

正如黄仁勋在会议期间指出的那样,一台 DGX 系统(一台带有八个 GPU 的服务器)包含来自众多供应商的 35000 多个组件。由于在生成式人工智能浪潮中对 GPU 的需求激增,英伟达目前也正在努力增加所有这些组件的供应,但同时还必须在供应链方面寻求长期的冗余性。

黄仁勋还重申,该公司已经增加了对台积电的 A100 和 H100 GPU 的订单,以满足对这些产品的巨大需求。

打工人又被 AI “误伤”!印度 CEO:“我裁了 90% 的技术支持团队,都外包给了 AI”

自ChatGPT爆火后,但凡AI领域有任何最新进展,人们总会习惯性调侃一句:“人类距离被AI取代已经不远了。”说者或许无心,但现在看来,“AI将取代打工人”的调侃似乎真的在逐渐成为现实。站长网2023-07-16 10:43:500000谷歌 DeepMind 推出 NaViT 模型 可显著减少训练时间

最近,GoogleDeepMind推出了NaViT:一种新的ViT模型,它在训练过程中使用序列打包来处理任意分辨率和宽高比的输入。该模型将图像分割成小块,并线性投影到令牌上,形成了这个模型的基础。站长网2023-07-18 06:37:250001华为理想懵了!何小鹏:为什么说小鹏的智驾才是真正全国都能开

快科技7月26日消息,小鹏将于本月底举行AI智驾技术发布会,今日小鹏汽车CEO何小鹏回答了为什么说小鹏的智驾才是真正全国都能开?”何小鹏称,现在市场上有不同的高阶自动驾驶解决方案,因为很多方案都是我们曾经经历过的,因此很多鹏友横向测试看到不同结果是很正常的。算法规则时代:站长网2024-07-26 17:58:100001东软推出添翼医疗领域大模型 及多款AI+医疗行业应用

据东软集团官方消息,近日,东软面向医疗领域推出多款AI医疗行业应用,包括添翼医疗领域大模型、飞标医学影像标注平台4.0、基于WEB的虚拟内窥镜等。添翼医疗领域大模型是东软基于30多年的医疗行业积累,构建的医疗垂直领域大模型,全面融入医疗行业解决方案、产品与服务,赋能医院高质量发展,引领医疗智能化转型。面向医生,添翼让诊疗更高效。站长网2023-06-21 14:36:200000抖音对AIGC明牌!虚拟人带货,危还是机?

火爆的ChatGPT,不仅重新点燃人们对人工智能的热情,也打开新技术的潘多拉魔盒。一年来,AIGC(AIgeneratedcontent,人工智能生成内容)逐渐从概念走向行业应用,争议和风险也如影随形。5月9日,抖音官方发布重磅消息,首次对AIGC提出平台规范和行业倡议。其中两方面内容格外引发关注,一是对AIGC内容的标注,二是虚拟人的注册认证。抖音在公告里提到:站长网2023-05-17 18:12:380001