清华开源图文对话模型!表情包解读有一手,奇怪的benchmark增加了

丰色 萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

什么,最懂表情包的中文开源大模型出现了??!

就在最近,来自清华的一个叫VisualGLM-6B的大模型在网上传开了来,起因是网友们发现,它连表情包似乎都能解读!

像这个腊肠犬版蒙娜丽莎,它不仅准确理解了这是腊肠犬与蒙娜丽莎的“合体照”,还点出了这只是一幅虚构作品:

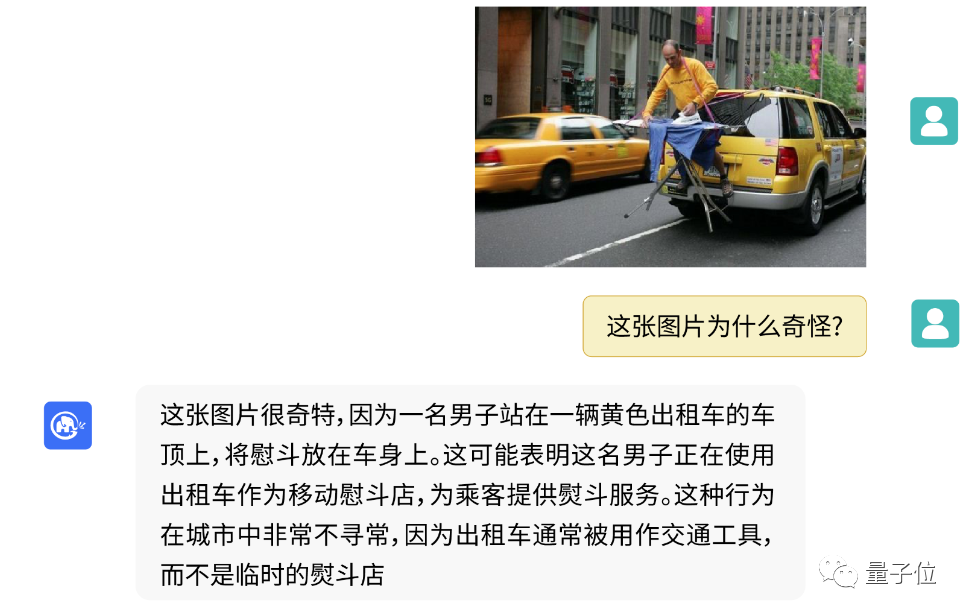

又像是这个正在出租车后熨衣斗的男子,它也一眼看出了“不对劲”的地方:

值得一提的是,在此前GPT-4刚发布时,网友们也同样将它用来测了测常识理解能力:

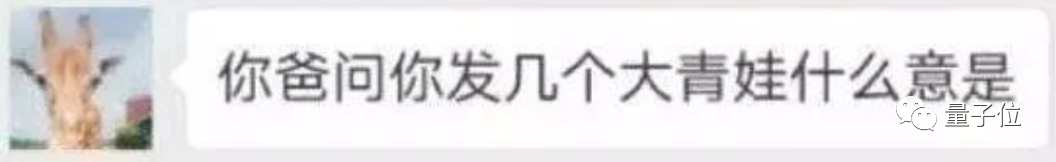

就如同弱智吧问题是大模型语言理解能力的benchmark一样,表情包简直就是大模型图片理解能力的benchmark。

要是它真能理解网友们奇奇怪怪的表情包,那AI简直没有什么不能get到的信息点了啊!

我们赶紧测试了一波,看看它究竟效果如何。

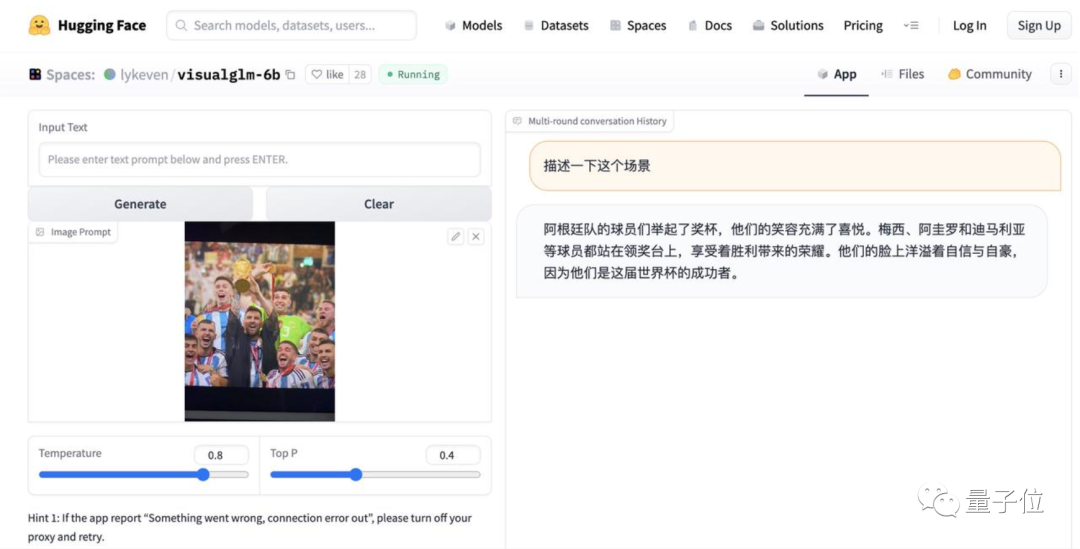

目前,VisualGLM-6B已经推出了网页端试玩版。

只需要在Hugging Face的试玩界面上传图片,再与它进行“对话”,它就能生成理解图片的结果:

先试试初级难度的表情包。

官方给出了几个问题示例,例如“描述一下这个场景”、“这是什么东西”、“这张图片描述了什么”,我们就先尝试一下这几个问题。

输入一只正在听歌的小猫,让VisualGLM-6B描述一下表情包中的场景:

还不错,VisualGLM-6B准确get了小猫享受音乐或使用电子设备这个过程!

再输入一个章鱼哥表情包,问它“这是什么东西”:

也没问题。看起来能拿给爸妈用了(手动狗头)。

再试试用吃饭小狗,让VisualGLM-6B解读一下这张图片描述了什么:

看起来初级表情包都没什么问题,是时候加大力度了。

上传一个gif试试?第一眼似乎没有问题:

但再换一个gif试试就会发现,它似乎只理解了第一帧图像,猜测是不是“主角在试图抓住或捕捉它”,但实际上只是在扔钞票:

与之前的一些图片理解AI不同,VisualGLM-6B在解读时会着重介绍表情包角色中的面部表情,例如“它看起来不舒服或者紧张”:

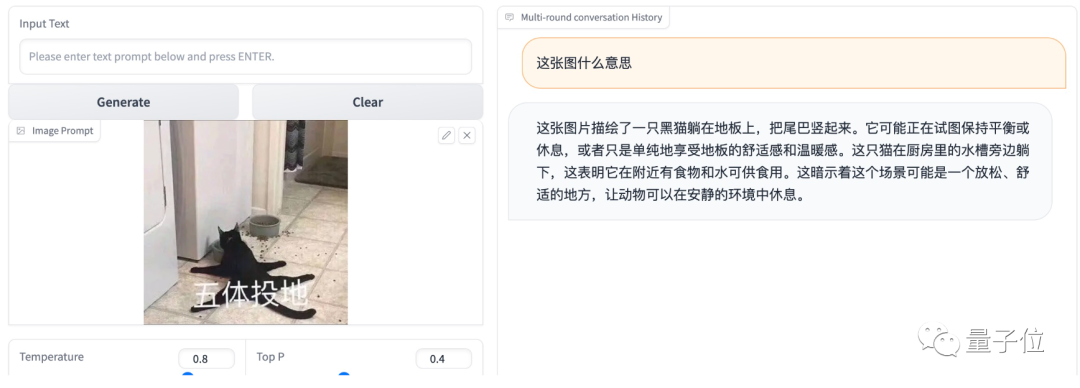

BUT!当我们再上一点难度,给表情包配上文字之后,它就无法理解表情包的含义了:

尤其是这种靠配文传达表情包精髓的,VisualGLM-6B就会开始展现“瞎解读”的功底:

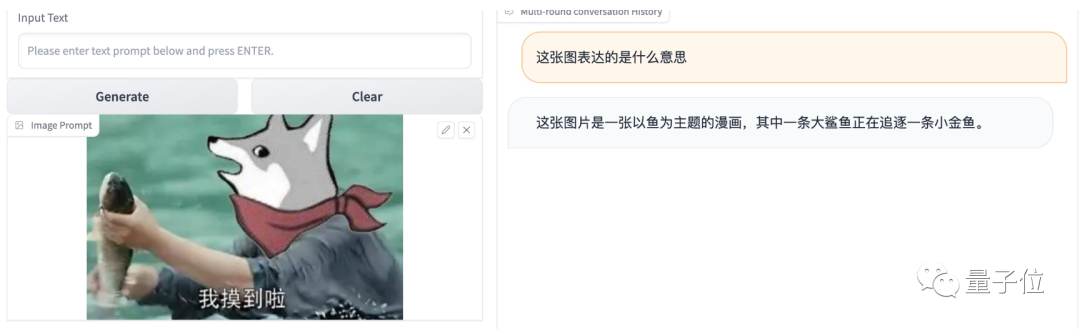

如果图像拼接太多,它还会出现奇怪的bug,例如把摸鱼狗头人认成大鲨鱼:

而且,它在描述表情包的时候整体比较正经,不会解读图像以外的“用意”。

例如,有网友测试了一下经典的“熊猫人显卡”表情包:

以及周星驰的经典“我全都要”表情包:

显然VisualGLM-6B能大致理解图片的场景,但对于表情包的配文就无法理解了。

总结一下,对于包含经典作品角色的表情包,或是经过文字加工前的“原始”表情包,VisualGLM-6B能说出这个角色的名字,或是描述出其中的场景:

虽然也可以让它描述情绪,不过AI看出来的情绪,可能和最终表情包表达的情绪不太一样:

但一旦表情包加上了文字、或是被P进了新场景,VisualGLM-6B就会因为无法解读图片中文字的意思,而变得“看不懂梗”了。

那么,拥有一部分解读表情包能力的VisualGLM-6B,究竟是什么来头?

事实上,VisualGLM-6B并非专门为“表情包解读”而开发。

它是由智谱AI和清华大学KEG实验室打造的开源多模态对话模型,主要用于中文图像理解,解读表情包可以说只是它被开发出来的一个“副业”。

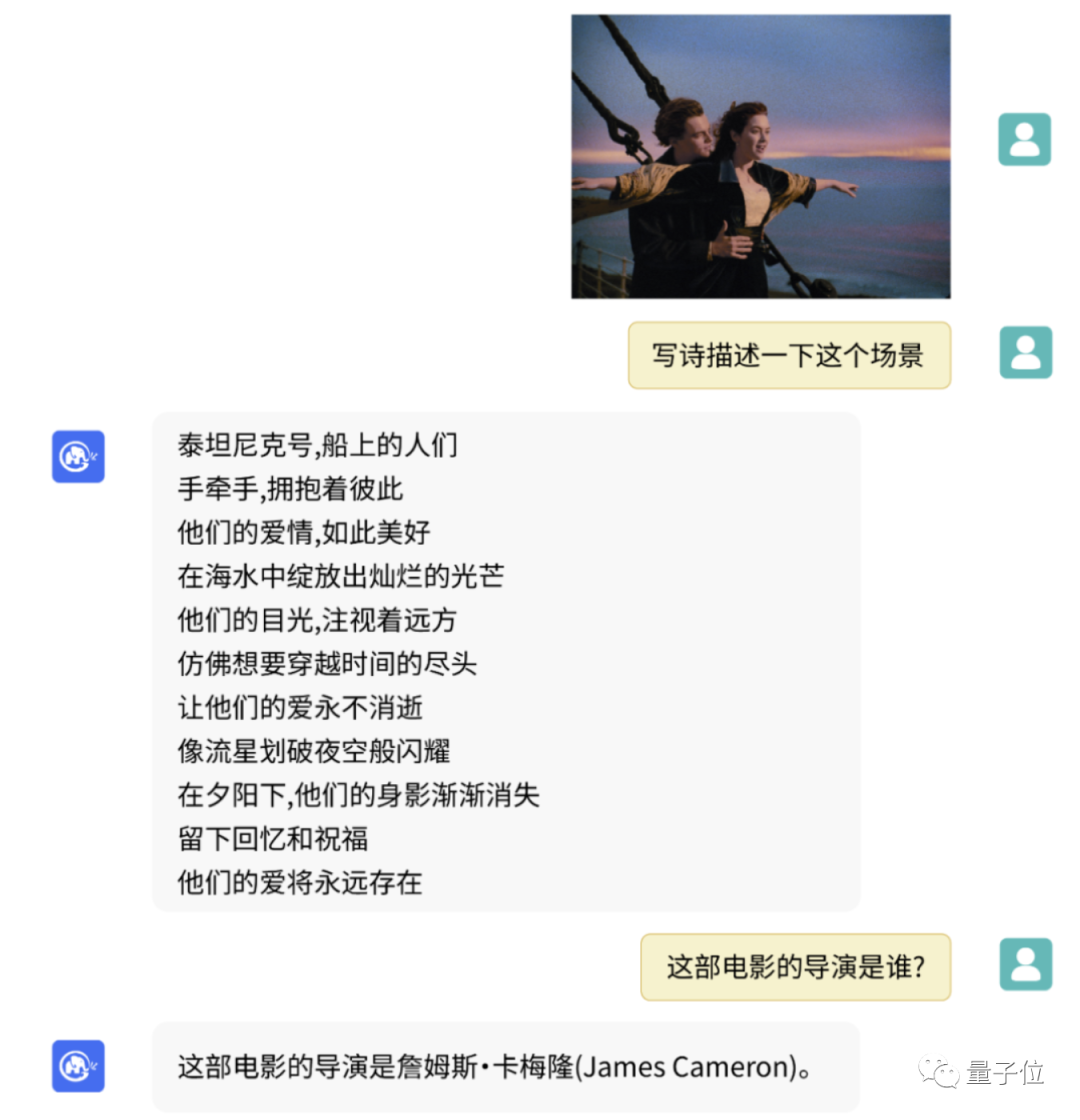

它的正经用法,一般是酱婶的:

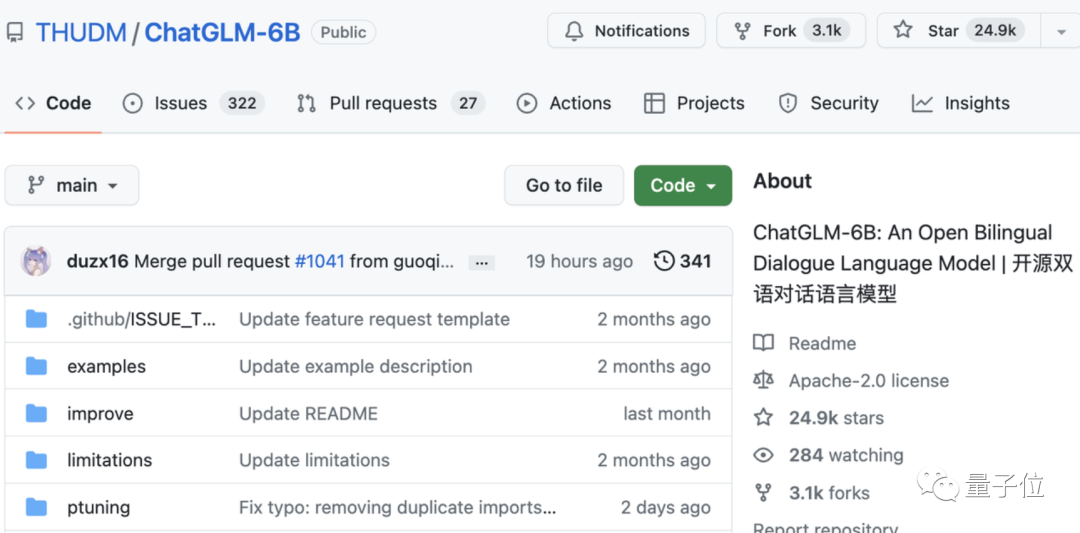

提起这个团队,大家更熟悉的可能是ChatGLM-6B大模型。

后者此前我们有作介绍:

它是“清华系ChatGPT”的一员,2022年8月发布,共62亿规模参数,支持中英双语对话。

上线4天就突破6k star,目前已经近25k。

据介绍,VisualGLM-6B正是在ChatGLM-6B的基础上完成:

ChatGLM-6B负责它的语言模型部分,图像部分则通过训练BLIP2-Qformer构建起视觉模型与语言模型的“桥梁”。

因此,VisualGLM-6B整体模型共78亿参数。

具体而言,VisualGLM-6B的预训练在中英文权重相同的情况下,在30M高质量中文图文对和300M经过筛选的英文图文对上完成(来自CogView数据集)。

这一训练方法可以将视觉信息对齐到ChatGLM的语义空间。

微调阶段,VisualGLM-6B又在长视觉问答数据上训练,以生成符合人类偏好的答案。

与此同时,VisualGLM-6B由SwissArmyTransformer (简称“sat” ) 库训练,这是一个支持Transformer灵活修改、训练的工具库,支持Lora、P-tuning等参数高效微调方法。

最终,本项目既提供了HuggingFace接口,也提供了基于sat的接口。

要说VisualGLM-6B最大的特点,便是结合模型量化技术,可以让大家在消费级的显卡上进行本地部署,INT4量化级别下最低只需8.7G显存。

具体包含三种部署工具:

一是命令行Demo。执行命令:

python cli_demo.py

然后程序便自动下载sat模型,大家就可以在命令行中进行交互式的对话了。

输入指示并回车即可生成回复,输入clear可以清空对话历史,输入stop终止程序。

二是基于Gradio的网页版Demo。

需要先安装Gradio:pip install gradio,然后下载并进入本仓库运行web_demo.py,最后在浏览器中打开系统输出的地址即可使用。

三是API部署。需要安装额外的依赖:pip install fastapi uvicorn,然后运行仓库中的api.py。

更多细节和推理、量化部分的方法就不赘述了,可戳参考链接[1]查看官方介绍。

需要注意的是,如官方所述,VisualGLM-6B正处于V1版本,视觉和语言模型的参数、计算量都较小,因此会出现相当多的已知局限性,像图像描述事实性/模型幻觉问题、图像细节信息捕捉不足,以及一些来自语言模型的局限性等等。

就如下面这张测试,VisualGLM-6B描述得还挺到位的,能看出是阿根廷和世界杯,但别被蒙了:图上并没有阿圭罗和迪马利亚这两位球星。

因此,官方也称将在后续继续针对以上问题进行一一改进。

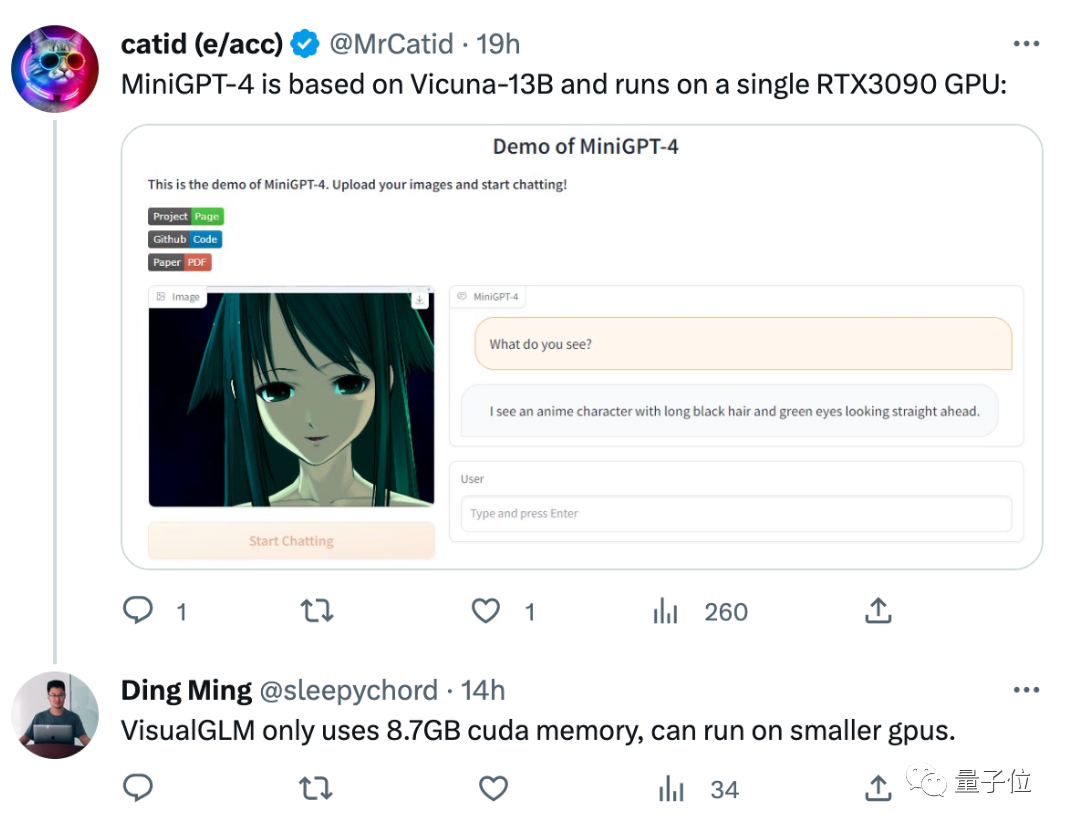

不过,拥有图片解读能力的大模型,也并不只有VisualGLM-6B一个。

目前来看,表现比较好的“表情包杀手”还是GPT-4,从网友测试来看,它已经能根据表情包中的文字解读meme:

开源大模型方面,基于Vicuna-13B开发的MiniGPT-4也能解读图片,同样只需要一张单卡RTX3090就能搞定:

不过在这批大模型中,VisualGLM-6B强调的则是“中文开源”特点,换而言之,它在中文描述上可能会比其他大模型更准确一些。

你试玩过这些“表情包解读AI”了吗?感觉谁更能get人类思想精华?(手动狗头)

VisualGLM-6B试玩地址:

https://huggingface.co/spaces/lykeven/visualglm-6b

参考链接:

[1]https://mp.weixin.qq.com/s/SzS6Gx8ZjtBXXQ7cs8-zLQ

[2]https://twitter.com/thukeg/status/1659079789599248386

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

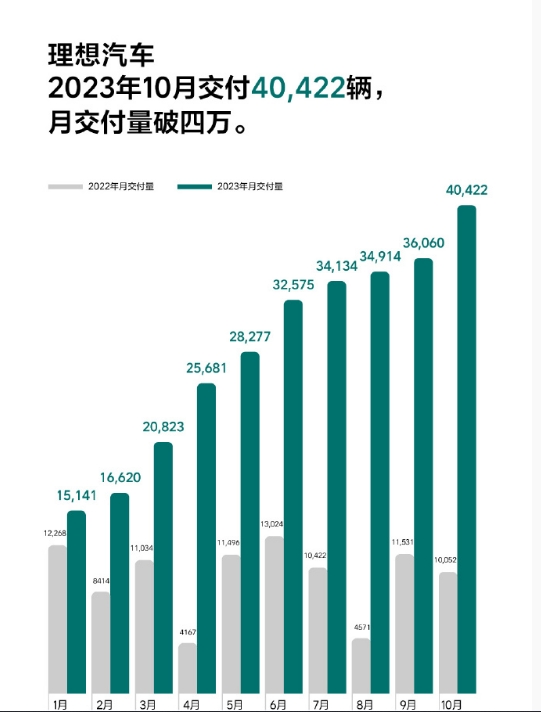

理想汽车10月共计交付新车40422辆 同比增长302.1%

理想汽车宣布,月交付量破四万,理想汽车2023年10月交付40,422辆。2023年10月,理想汽车共计交付新车40,422辆,同比增长302.1%,月交付首次突破四万辆大关。截至2023年10月31日,理想汽车全年累计交付284,647辆。此外,截至2023年10月31日,理想汽车在全国已有372家零售中心,覆盖133个城市;售后维修中心及授权钣喷中心315家,覆盖210个城市。站长网2023-11-01 16:58:250000中国互联网协会:警惕AI换脸新骗局

今年以来,ChatGPT和GPT-4等技术的应用,成为了信息科技领域的热点,引起公众对AI技术的广泛关注和热情。但伴随着深度合成技术的开放开源,深度合成产品和服务逐渐增多,利用“AI换脸”“AI换声”等虚假音视频,进行诈骗、诽谤的违法行为屡见不鲜。站长网2023-05-24 17:01:570000微软首席执行官表示可能在 Windows 12 中使用 Copilot AI 取代「开始」按钮

在高通的SnapdragonAI活动中,微软CEO萨提亚·纳德拉(SatyaNadella)与高通CEO克里斯蒂亚诺·阿蒙(CristianoAmon)一同讨论了「下一代AIPC」的潜力,并正式宣布了SnapdragonXElite芯片组的推出。站长网2023-10-26 17:09:080000苹果Vision Pro国行版来了!已开始在中国招聘销售

快科技3月21日消息,苹果公司今日更新了官方招聘信息,新增了位于北京的BriefingExperienceSpecialist(简报体验专员)”职位,主要负责VisionPro头显的销售和业务发展。据工作描述,该职位的主要职责包括向客户进行AppleVisionPro产品和解决方案的演示,并负责管理相关产品的展示体验。同时,通过与客户的直接交流,为苹果产品团队提供关键的反馈和意见。站长网2024-03-22 02:31:590000微软画图程序或整合人工智能辅助工具 Windows Copilot

站长之家(ChinaZ.com)8月8日消息:我们已经到处都能看到WindowsCopilot。微软夸耀说这个人工智能辅助工具可以在其Microsoft365应用程序如Word、Excel、PowerPoint和Outlook中帮助您简化任务。站长网2023-08-08 20:05:120001