OpenAI大逃亡,AGI安全团队半数出走!奥特曼:攘外必先安内

尽管不断招兵买马,依旧挡不住OpenAI的安全团队「集体出走」。半数员工已离职、公司处在风口浪尖,奥特曼却在此时选择对内部员工展开安全监控。

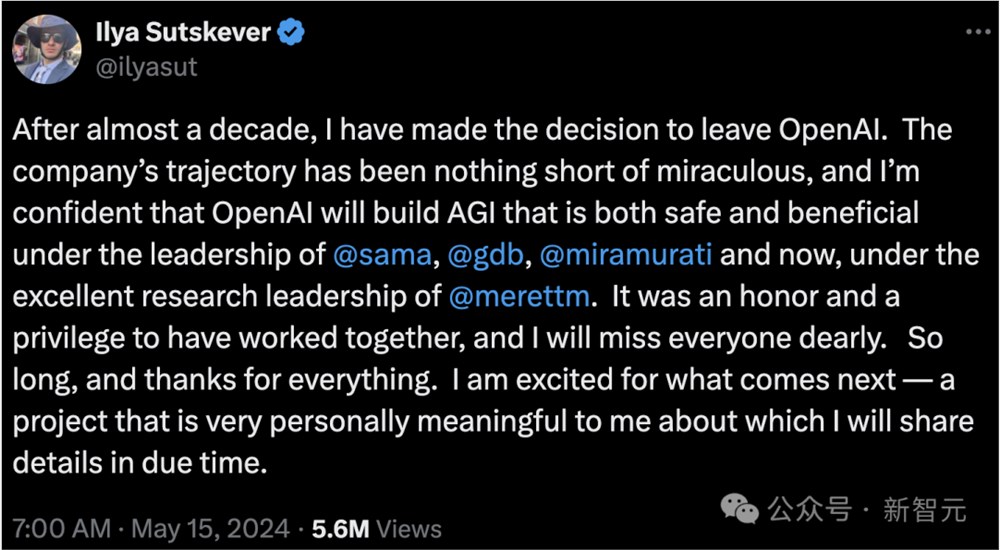

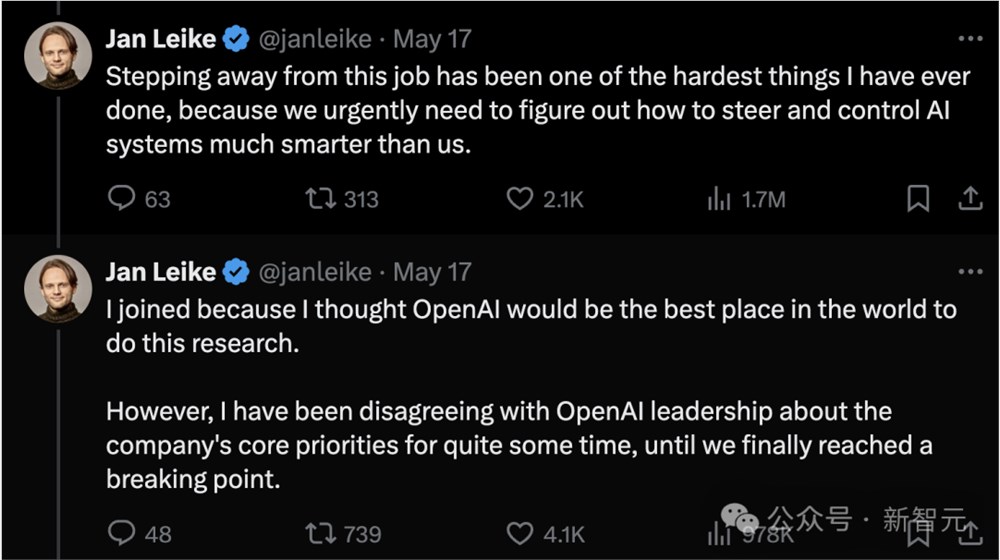

今年5月发布会后,安全团队负责人Ilya Sutskever和Jan Leike曾前后脚在推特上官宣离职。

加入Anthropic的Jan Leike曾公开指责OpenAI没有对AI安全投入足够的重视,「安全文化和流程已经让位于闪亮的产品」。

奥特曼曾经承诺的20%计算资源迟迟不到位到位,让他的团队始终在「逆风航行」。

Ilya和Jan Leike的离职,宣告着OpenAI「超级对齐」团队的正式解散。

几个月来,关于OpenAI安全团队的人事新闻也始终不断,包括雇用前陆军上将Paul M. Nakasone,以及CMU教授Zico Kolter任职于董事会新成立的安全和保障委员会,还有「打包」挖来AI安全公司Indent。

种种招兵买马之举,让人好奇,奥特曼是否真的「良心未泯」、仍对AI安全有所关注,还是仅仅为了平息两位大佬离职后全网的指责。

在如此多的「大动作」之下,OpenAI安全团队的现状究竟如何?

最近,前OpenAI研究员Daniel Kokotajlo接受了《财富》杂志的独家专访。他表示,情况并不乐观,原AGI安全团队中近一半的员工已经离职。

由于部分研究人员担心,AGI可能逃脱人类控制并对全人类构成生存威胁,因此OpenAI自成立以来就雇用了大量研究人员,专注于「AI安全」领域。

根据Kokotajlo的说法,这支队伍最近正因辞职而人数锐减,其中包括OpenAI联合创始人、ChatGPT架构师John Schulman和Scaling Law论文共同作者之一Jeffrey Wu。

John Schulman已入职Anthropic,Jeff Wu的领英显示他7月已离职,目前未透露去向。

此外,离职的还包括以下员工:

- Jonathan Uesato,GPT-4o的核心贡献者之一,曾在DeepMind Gemini团队工作

- Jan Hendrik Kirchner,GPT-4技术报告的共同作者之一,8月已入职Anthropic

- Yuri Burda,已在OpenAI任职8年,今年7月后离职并加入Anthropic

- Todor Markov,GPT-4o的核心贡献者之一,已在OpenAI任职近6年,今年6月离职

- Steven Bills,曾参与ChatGPT的开发,已加入Anthropic

Kokotajlo本人是一名哲学专业的博士生,于2022年加入OpenAI担任治理研究员,并于4月辞职,因为他对公司在「构建通用人工智能系统方面的负责任行为失去了信心。」

他在接受采访时表示,2024年出现了缓慢而稳定的离职潮。大约30名AI安全方面的员工中,现在只剩下16人左右。

「(离职潮)并不是一个协调一致的事情,我认为只是大家在个体层面上放弃。」

这些离职背后的意义可能不止于科技公司中常见的跳槽。这可能说明,OpenAI对技术风险的谨慎程度逐渐滑坡,以及奥特曼主导的盈利动机可能导致危险行为。

根据The Information之前的披露,OpenAI尚未实现收支平衡,2024年度的净亏损可能高达50亿美元。因此,奥特曼强烈的盈利动机也是事出有因。

纽约时报在今年6月的报道中也提到,Kokotajlo认为科技巨头们开发AGI的竞赛是鲁莽的。

他担心,「OpenAI会不顾一切地向前推进,并合理化我们的行动」,但「世界还没有准备好,我们也没有准备好」。

OpenAI是从什么时候开始变化的?在Kokotajlo看来,事情还要追溯到去年11月的那场「宫斗」。

作为CEO的奥特曼被解雇后又迅速复职;随后,董事会中专注于AGI安全的三名成员被撤换。

「那件事算是尘埃落定。之后就没有回头路了。」

Kokotajlo还补充说,虽然他无法接触到幕后发生的事情,但感觉自那时起,奥特曼和最近请长假休息的总裁Greg Brockman一直在「巩固权力」。

「那些主要关注AGI安全和准备工作的人正在被日益边缘化……从某种意义上说,这背叛了我们在2022年制定的计划。」

尽管如此,Kokotajlo并不后悔最初加入OpenAI,只是后悔自己离开得太迟:「我在那里学到了很多有用的东西,我觉得自己可能产生了积极的影响。」

目前,Kokotajlo还有朋友留在OpenAI继续从事AGI安全相关的工作。

但对于那些留在公司的人,Kokotajlo警告说,在科技巨头竞相开发AGI的过程中,要防止「群体思维」,即所谓的「合理」观点是由大多数人的观点和公司高层制定的激励措施所决定的。

正因如此,大多数科技公司会认为——他们赢得AGI竞赛会造福人类。这看似荒谬,但正是激励措施所导出的结果。

OpenAI正在招人调查内部员工

就在「离职潮」的进行时中,Business Insider又爆出了一则猛料——OpenAI开始监控调查内部员工,以应对「内部的安全威胁」。

他们最近发布了一则招聘信息,寻找一名技术方面的内部风险调查员,以「强化组织对内部安全威胁的防御」。

招聘信息称,工作职责包括分析异常活动、检测和缓解内部威胁,并与人力资源和法律部门合作「调查可疑活动」。

OpenAI如今正处于AI安全的风口浪尖,内部员工和立法者都纷纷表示担忧,质疑公司是否采取足够措施确保其技术不会被用于造成伤害。

与此同时,OpenAI表示,已发现来自某些国家的关联行为者试图利用自己的AI模型进行恶意行为。OpenAI称已中断这些行动并终止了相关方的账户。

根据《纽约时报》2023年的报道,曾经有黑客入侵OpenAI内部的消息系统,并窃取关于AI技术设计的机密信息。公司高管在去年4月的全体会议上向员工透露了这件事。

除了黑客组织外,这则招聘信息似乎表明,OpenAI也担心来自内部员工的威胁,尽管尚不清楚这到底是哪种形式的威胁。

一种可能性是,OpenAI只是想保护与技术有关的商业机密。

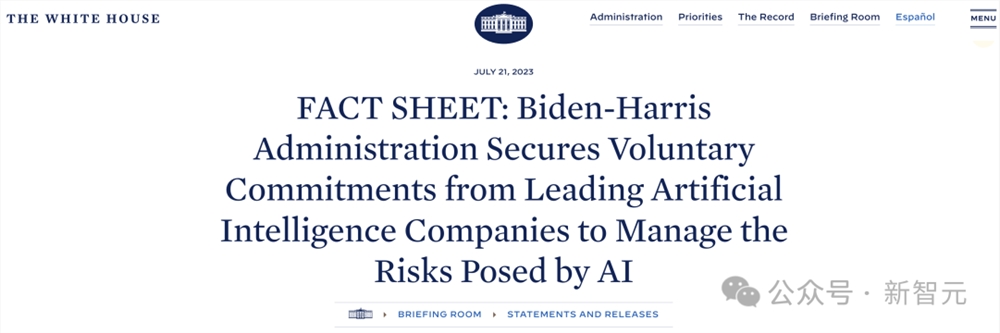

招聘信息显示,内部风险调查员是OpenAI向白宫做出的「AI安全自愿承诺」的一部分,即投资于「内部威胁防护措施,以保护专有和未发布的模型权重。」

在去年6月的一封公开信中,现任和前任OpenAI员工表示,他们感到在表达对AI安全的担忧时受到了阻碍。信中呼吁 OpenAI保证公众对其产品危险的「警告权」。

尚不清楚风险调查员负责实施的「数据丢失防护控制」是否涵盖这种类型的员工告密行为。

B站云剪辑功能将于5月31日停止运营

B站最近宣布,其云剪辑功能将于2023年5月31日停止运营。据悉,bilibili云剪辑是B站提供的在线视频剪辑工具,支持多轨道剪辑、滤镜、特效等功能,并能够直接上传到B站。以下为B站公告全文:由于业务调整,bilibili云剪辑将于2023年5月31日下线。届时,云剪辑访问入口将关闭,无法查看、编辑项目和从云剪辑投递稿件请注意提前查看、处理云剪辑内的个人项目。站长网2023-05-12 15:45:200000苹果下一代Vision Pro至少还要18个月才会推出

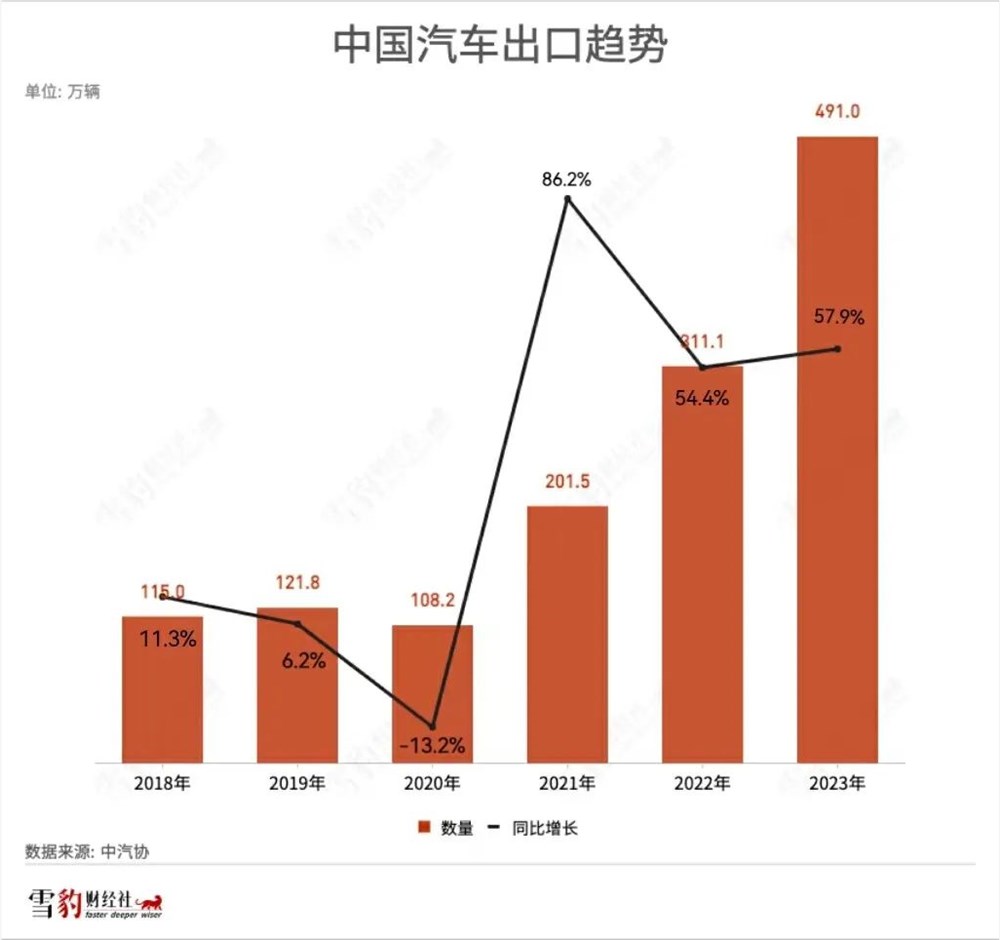

2月19日的消息显示,苹果已正式进军头显市场并开启了全新产品线,这得益于VisionPro在1月19日凌晨5点开始在美国市场接受预订,并于2月2日正式上市。随着VisionPro在美国市场的成功推出,公众对其何时拓展至更多市场以及下一代产品的推出时间充满了期待。站长网2024-02-21 11:19:570000我在TikTok上卖车给老外,三个月入账2000万

抱着“反正亏不了多少钱”的心态,安岚(化名)在TikTok上试着把中国汽车卖给老外。短短一个季度,她就拿下了2000万元的营收,而投入仅2000元左右。在此之前,她从未有过任何销售工作经验。去年8月初,安岚带着一身的疲惫从某互联网大厂裸辞,“想躺一段时间”。但一条新闻让她打消了休息的念头:2023年上半年,中国汽车出口量同比增超70%。“我一直以为,中国汽车在国外卖不动的。”站长网2024-03-14 14:05:270001今年春节的社交密码,竟然藏在美团里?

年轻人开始整顿春节后,过年的画风也变了。拜年送的礼变成了榴莲、蟹黄面、螺蛳粉,见面后的娱乐方式变成了组团玩游戏,聚餐时的食物则是奶茶、炸鸡、小蛋糕……吃不到的人,如今也能被远程投喂了。但在投喂过程中,对方喜欢什么?对方目前在哪?食物何时能到?往往让人陷入纠结。0000批量复制爆款短剧

频繁曝出“造富神话”、被贴上“2023年最盈利赛道”标签的短剧,正遭遇监管风暴。近期,被传24小时充值破2000万的《黑莲花上位手册》在上线几天后被下架。微信、抖音、快手等平台相继发布打击违规短剧的公告,并在一周内下架数万部作品。站长网2023-11-29 20:55:400000