Meta 推出 LayerSkip:提升大语言模型推理速度

站长网2024-04-28 17:54:521阅

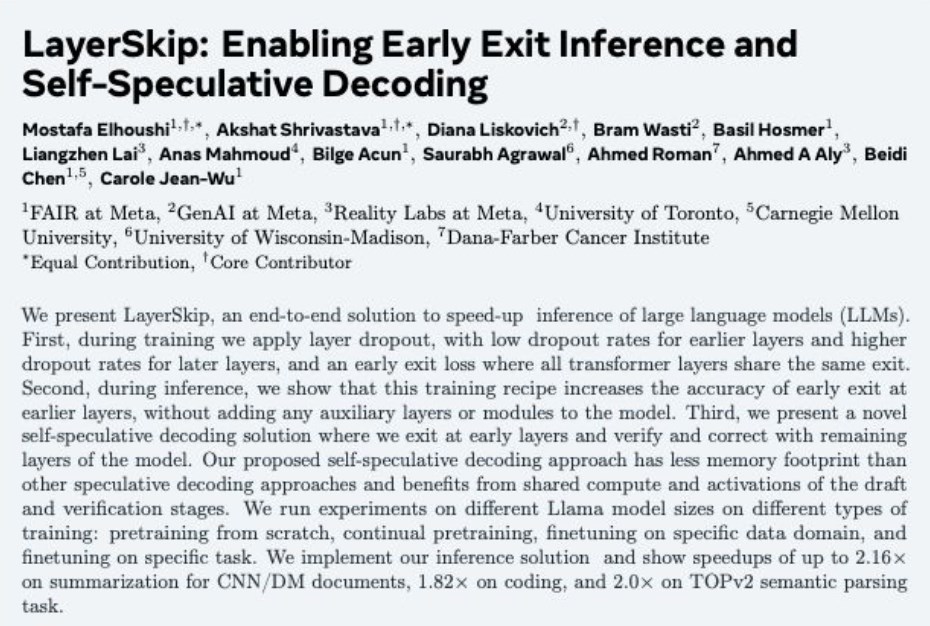

Meta公司最新发布了LayerSkip,这是一款端到端的解决方案,专门设计用于提升大型语言模型(LLM)的推理速度。这一技术在不同规模的Llama模型上经过了广泛的训练实验,并在多个任务上展现了显著的性能提升。

LayerSkip的主要成就包括:

CNN/DM文档摘要任务:在这一任务上,LayerSkip将推理速度提升了2.16倍,显著提高了文档处理的效率。

编程任务:在编程相关的语言任务中,LayerSkip实现了1.82倍的速度提升,这可能极大优化编程辅助工具的性能。

TOPv2语义解析任务: 在语义解析这一关键的自然语言处理任务上,LayerSkip的推理速度提升达到了2.0倍。

LayerSkip技术的优势:

LayerSkip通过优化大型语言模型的推理过程,减少了计算资源的消耗,同时保持了模型的性能。这对于需要快速响应的应用场景,如实时语音识别、自动翻译或复杂查询的即时反馈等,尤为有价值。

此外,LayerSkip的推出也反映了Meta在提升AI模型效率方面的持续投入和创新,有助于推动大型语言模型在更广泛领域的应用。

未来展望:

随着LayerSkip技术的不断完善和应用,预计将为大语言模型的部署和使用带来更多可能性,特别是在需要快速处理大量语言数据的场合。

论文地址:https://huggingface.co/papers/2404.16710

0001

评论列表

共(0)条相关推荐

雷军:看完车展很绝望 各大厂商缺乏独特性和创新

小米CEO雷军在近期举办的2024中关村论坛年会上分享了自己参观2024北京车展后的深刻感受。他直言不讳地表达了对当前汽车市场产品同质化现象的忧虑,认为这种趋势正在侵蚀行业的创新力。站长网2024-05-06 17:52:500000vivo推出蓝心大模型BlueLM 上线AI对话机器人“蓝心千询”

vivo推出自研通用大模型矩阵——蓝心大模型(BlueLM),包含十亿、百亿、千亿三个参数量级共5款。其中,蓝心大模型7B和1B支持高通和联发科双平台,是面向端侧的大模型;而70B、130B和175B则是面向云端服务和复杂逻辑推理等应用场景的大模型。站长网2023-11-01 11:03:420000蚂蚁百灵大模型通过备案 多款产品即将向公众开放

蚂蚁百灵大模型已按照国家七部委联合公布的《生成式人工智能服务管理暂行办法》完成备案,基于该大模型的多款产品也已陆续完成内测,即将向公众开放。蚂蚁百灵语言大模型,它采用Transformer架构,经过万亿级Token语料的训练,支持窗口长度达到32K,并在主流推理类榜单中名列前茅。站长网2023-11-06 10:41:080001可验证大模型输出、训练来源,斯坦福提出“统一归因”框架

随着ChatGPT等大模型被广泛应用在实际业务中,其输出内容的真实、可靠、安全性成为了重点。学术界则使用“归因”来表示追查、证实内容。目前,在“归因”研究领域有两大派系,一种是协同归因,主要追查引用数据和训练数据来源;另外一种是贡献归因,证明模型输出内容的真实性以减少幻觉。这两种归因方法对于法律、医疗、金融等,对于内容准确率要求极高的行业应用大模型至关重要。0000AMD 赢得重大合同:与 Oracle 和 IBM 两家主要云提供商合作加速人工智能发展

站长之家(ChinaZ.com)10月24日消息:尽管AMD与其竞争对手英伟达相比在人工智能(AI)领域的资本运作上尚未显著突破,但最近的报道显示,该公司将与云服务领先提供商签下重要合同。站长网2023-10-24 23:28:050000