无需AI PC也能跑AI应用?背后的原因你知道吗

最近关注PC市场的朋友想必会注意到,“AI PC”已经成为了诸多厂商最新的宣传口号。

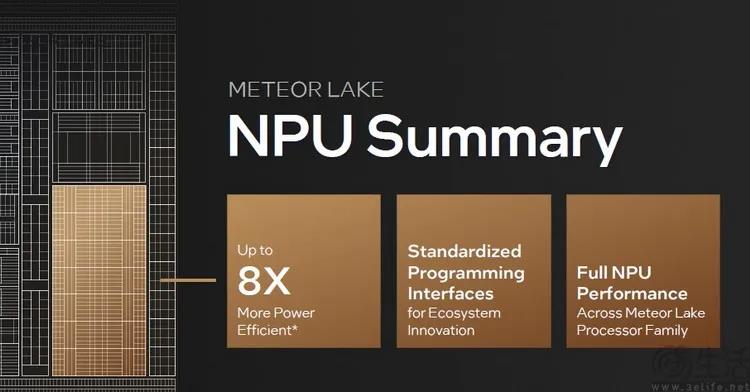

在更进一步的产品介绍里,这些厂商往往会宣称他们的新品使用了全新内置NPU(神经网络单元)的处理器,因此它可以运行老旧设备所不能支持的各种AI应用,提供从语音助手到用户感知、从生成式绘图到文本辅助编辑在内的众多新功能。

乍看之下这似乎有些诱人,而且按照手机行业的经验,最新的“生成式AI”功能往往仅限于最近的两代硬件平台可以适配。所以对于更早之前、被认为“AI算力不足”的机型,它们即便更新到了最新的系统或软件版本,往往也不能看到相关的AI功能和选项。

那么这是否意味着,如今各种各样的AI功能也都必须要使用这些内置NPU新款处理器的新电脑才能用到呢?毫无疑问,这是一个很微妙的问题。因为从最近的一些行业动向来看,答案似乎是否定的。

多款AI PC软件上新,但都不需要新硬件就能使用

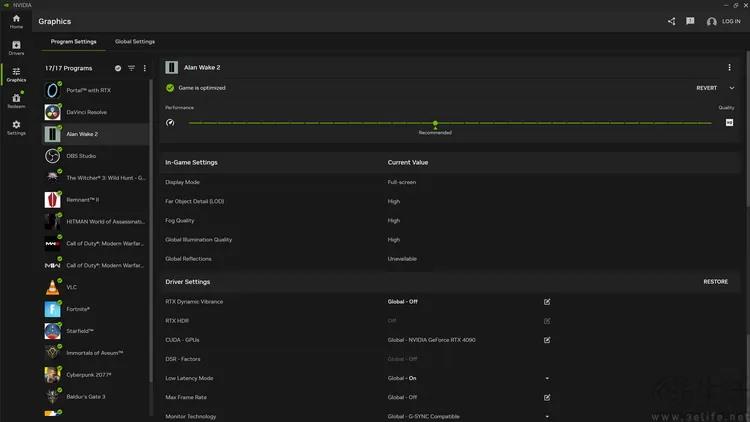

比如在2024年2月23日,NVIDIA推出了最新的551.61版显卡驱动、以及与之搭配的“NVIDIA App”。在这个新的控制界面里,NVIDIA新增了多个基于显卡AI算力的游戏画面优化功能。理论上只要使用的是最近几代的RTX显卡就都可以启用,然后让AI来自动处理游戏画面,使得它看起来色彩更生动、纹理更清晰。

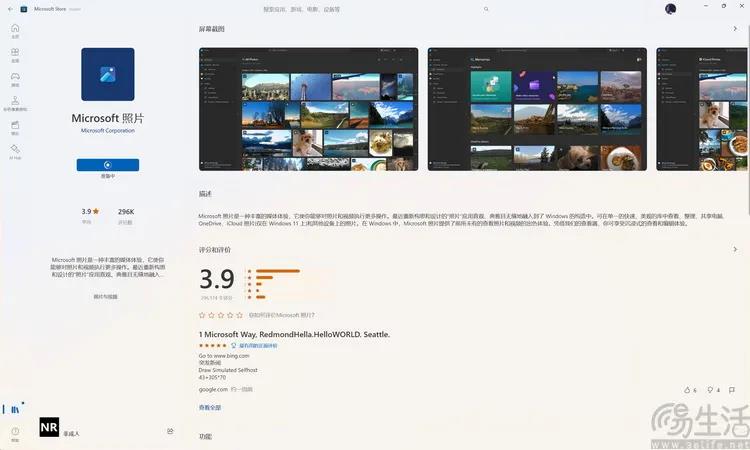

又比如说,差不多就在同一天,微软方面也更新了旗下“照片”软件的最新版本。其最大的改变就是新增了“AI擦除”功能。据称,这一功能类似于现在很多新款旗舰手机上的AI照片路人消除,也就是可以擦除照片背景上的小范围异物,同时使用AI算法来自动补全背景。

但问题在于,微软的新版“照片”软件完全没有限定电脑的硬件。换句话说,它所使用的这套“生成式绘图AI”,哪怕是使用最普通的x86CPU也能运行,并不需要用户非得换用“AI处理器”或“AI PC”。

为什么会这样?其实这背后涉及到了两个问题,一是AI计算的本质,二是PC相比智能手机在基本思路上的区别。

AI计算并不神秘,也不绝对非要NPU才行

首先,我们来说说AI计算的性质。大家都知道,如今PC有所谓的“位数”概念,比如8位、16位、32位和64位,而这个位数通常指的是每一次计算所使用的数据字长。字长越长就意味着计算的结果越精确,但与此同时也会占据更多的计算资源。

对于主流的通用CPU来说,它们的内部结构通常是为32位和64位计算而设计。同时为了应对一些特别高性能的计算任务(比如多媒体编解码、游戏渲染),如今CPU也会具备额外的256位、甚至512位浮点单元和指令集,以加速这部分任务的计算速度。

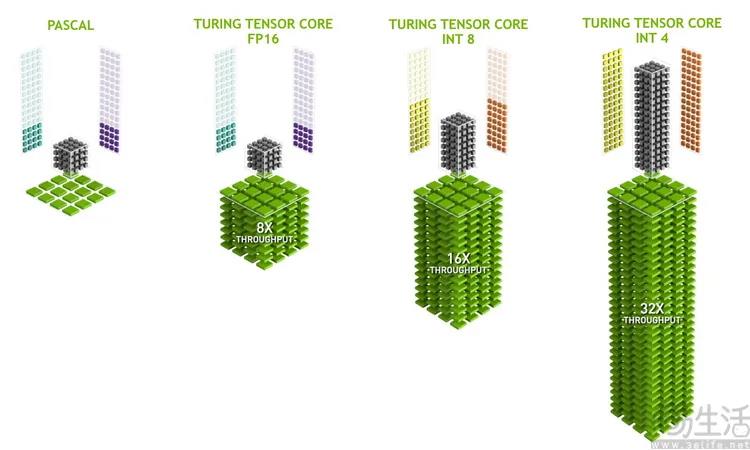

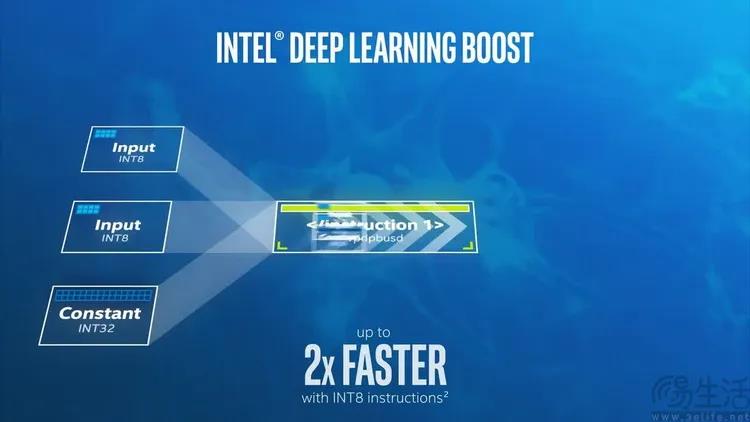

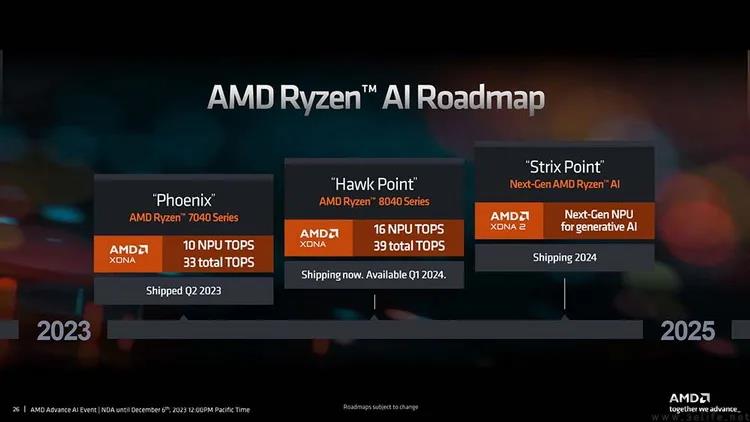

但是AI推理(注意我们的用词,它不是“计算”)并非如此,对于AI处理的场景来说,它其实更像是在做无数次的猜测,因此计算的次数要远比计算精度更重要。这就是为什么越是先进的AI处理单元(也就是NPU),它们往往会支持越低精度、短字长(比如8bit、4bit)的计算格式。

这样一来,问题就出现了。假如现在有两颗处理器,一颗是32位的CPU、每秒可以完成2次运算,而另一颗是4位的NPU、每秒能完成10次运算。那么从总体的数据吞吐量来说,肯定是CPU更高(32*2>4*10),但因为CPU不能将自己的运行模式变成4位字长为最小单位进行运算,所以如果强行让它去进行AI推理,那么它实际上每秒还是只能算2次,而不是16次。这时候,CPU的“AI性能”自然就比NPU来得慢了。

没错,虽然这个例子举得相当粗浅,但它的关键在于,传统CPU并不是“彻底不能用来算AI”,它顶多只是速度低一点罢了。况且很多稍近代一点的CPU(比如10代酷睿-X,11代到14代移动和桌面酷睿),实际上也适配了专用于强化AI计算效率的指令集,也不会像这个例子里效率那么低。

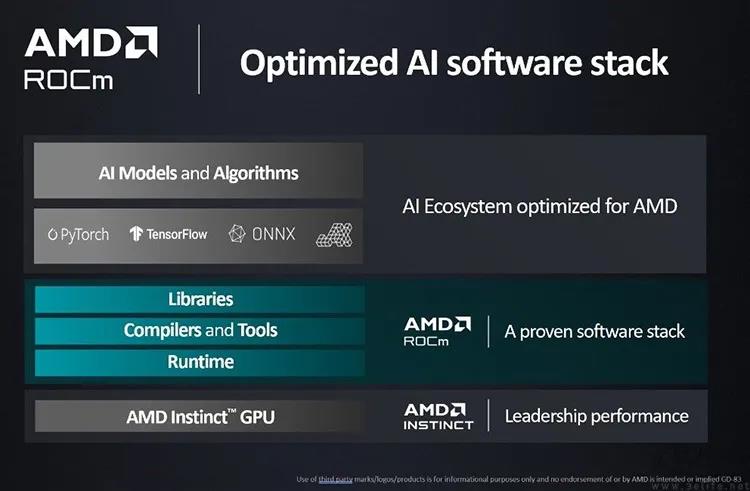

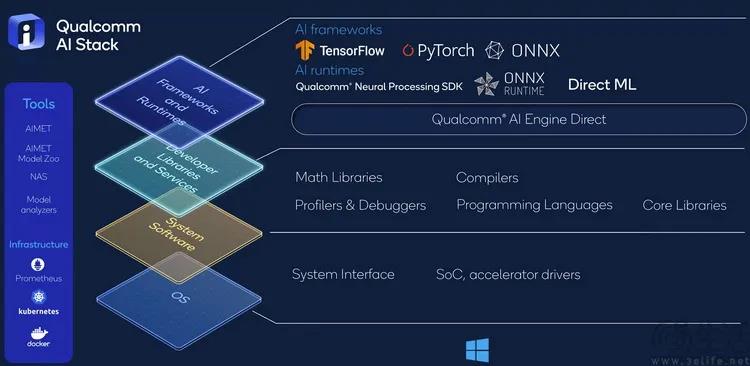

更不要说就像我们前面所提到NVIDIA的情况那样,PC上的AI功能有时候也未必就适配了最新型的NPU硬件,它们反而可能是针对部分显卡优化得更好。毕竟在PC领域,显卡可是早就支持AI加速运算、相当于早就有内置“NPU”,而且是性能数十倍、数百倍于智能手机里的NPU了。

因此这实际上也就解释了,为什么没有NPU的电脑一样可以运行AI程序的原因。

AI PC的现有优势是能效,但性能还得看未来

可能有的朋友看到这里就会问,那是不是对于如今配备有NPU的“AI PC”来说,它们运行AI程序的速度还是会更快一些呢?

其实也不一定。这是因为NPU固然在架构上是专为AI推理而设计、计算效率会更高,但问题在于,“效率高”并不完全等于“速度快”。实际上对于现在的消费级NPU来说,它们更大的意义其实是在于降低设备进行AI推理、感知时的功耗,而并非追求更高的绝对AI性能。

这很好理解,毕竟消费级NPU的设计远本就最早源自智能手机这类、功耗敏感型的终端形态,而且目前的AI PC和PC的AI处理器,绝大多数还都是为笔记本电脑,甚至可以说是为轻薄本而生。

打个比方,就好比现在有一段AI代码,如果我们用台式PC里的“线程撕裂者”192核CPU、或者是RTX4090显卡去运行,那么它很有可能会比智能手机、比轻薄本里的NPU算得更快。但前者计算过程中的设备功耗会高达好几百、甚至上千W(瓦),后者则可能会只消耗10W、甚至不到1W就能完成运算。

很显然,对于前一种设备来说,是没法让这种AI代码一直处于运行状态的,但后者就可以做到。

所以在某种程度上,这也就引出了未来“AI PC”可能的两种发展方向。要么就是将来AI PC会继续强调能效比,主打AI计算的效率。在这种情况下,需要随时启动、感知型的AI功能就会成为主要的体验差异。

要么,如果真的可以迎来“高性能NPU”的进化,让NPU在AI推理速度上彻底压倒顶级CPU和GPU。那么诸如AI绘图甚至是视频生成这样的高算力AI使用场景,才有可能真正在端侧落地,并且深度地改变我们使用PC进行学习、工作的方式。

开源「AI史上最重要闭门会议」 马斯克、小扎等AI大佬密会探讨AI监管

要点:1.舒默参议员主持召开AI闭门峰会,汇集AI领域大佬。2.与会者就AI如何改变生活进行预测,呼吁政府参与AI监管。3.马斯克和小扎支持政府监管AI,但也关注创新。站长网2023-09-15 16:06:360001小米汽车 SU7 宣布 3 月 28 日正式发布 售价即将公布

小米创始人雷军宣布,小米SU7将在3月28日正式发布。雷军表示,如果你想拥有一台车,要有最先进的智能科技,还要有出色的驾驶质感,小米SU7将会是首选。站长网2024-03-12 09:28:040000以技术助力增进人类社会福祉,腾讯入选“中国ESG榜样”企业

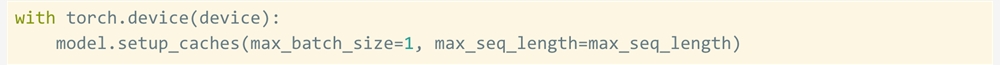

近年来,由环境、社会和公司治理构成的ESG理念日益成为评价企业可持续发展和社会责任的世界通用体系。12月9日,中央广播电视总台首届“中国ESG榜样”年度盛典在央视财经频道播出。腾讯入选十大“中国ESG榜样”企业,是唯一一家入选的互联网公司。站长网2023-12-10 15:10:330000使用PyTorch加速生成式 AI模型

PyTorch团队发布了一篇名为《AcceleratingGenerativeAIwithPyTorchII:GPT,Fast》的博文,重点介绍如何使用纯原生PyTorch加速生成式AI模型。站长网2023-12-01 12:02:110000破解「反AI」情绪,德国马普所揭秘:人类更喜欢自我定制AI艺术

自去年DALL-E2,StableDiffusion,Midjourney等高质量AI绘画工具发布以来,关于「AI艺术家」的争论一直都没停过,比如AI作品是否能参加比赛、模型的训练侵犯版权、辛苦学习的画师沦为语料库等诸多问题。不过,大部分人还是达成了共识,如果一幅精美的AI作品和大师手笔放在一起,我们还是会认为人类的作品要更好,愿意去了解作品背后的故事、表达的情感等等。站长网2023-09-01 14:28:140003