微软新工具LLMLingua-2:可将 AI 提示压缩高达80%,节省时间和成本

划重点:

🔍 微软研究发布了 LLMLingua-2,一种用于任务不可知压缩提示的模型,可以将原始长度减少高达20%,从而降低成本和延迟。

📊 LLMLingua-2通过智能压缩长提示,去除不必要的词语或标记,同时保留关键信息,使得提示长度可减少至原长度的20%。

🚀 LLMLingua-2在多个数据集上进行了评估,显示出与强基线相比的显著性能改进,并在不同 LLM 之间展现了稳健的泛化能力。

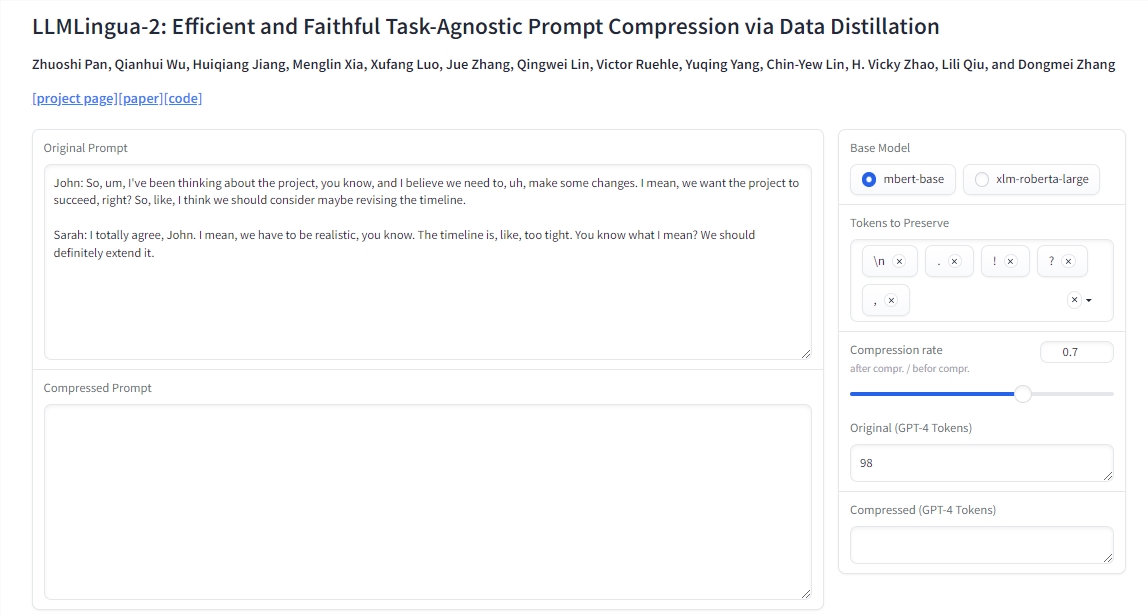

微软研究发布了名为 LLMLingua-2的模型,用于任务不可知的提示压缩。该模型通过智能地去除长提示中的不必要词语或标记,同时保留关键信息,使得提示长度可减少至原长度的20%,从而降低成本和延迟。研究团队写道:“自然语言存在冗余,信息量不尽相同。”

LLMLingua-2比其前身 LLMLingua 和类似方法快3到6倍。LLMLingua-2使用了 MeetingBank 中的示例进行训练,该数据集包含会议记录及其摘要。要对文本进行压缩,首先将原始文本输入训练好的模型。模型对每个词语进行评分,根据周围语境为其分配保留或移除的点数。然后选择具有最高保留值的词语,以创建缩短的提示。

微软研究团队在多个数据集上对 LLMLingua-2进行了评估,包括 MeetingBank、LongBench、ZeroScrolls、GSM8K 和 BBH。尽管模型规模较小,但在各种语言任务(如问答、摘要和逻辑推理)中,它始终优于原始的 LLMLingua 和选择性上下文策略。同样,相同的压缩策略对不同 LLM(从 GPT-3.5到 Mistral-7B)和语言(从英语到中文)都有效。

LLMLingua-2只需两行代码就可以实现。该模型还已集成到广泛使用的 RAG 框架 LangChain 和 LlamaIndex 中。微软提供了演示、实际应用示例以及说明提示压缩的好处和成本节省的脚本。该公司认为这是一个有前途的方法,可以通过压缩提示实现更好的泛化能力和效率。

论文地址:https://arxiv.org/abs/2403.12968

项目入口:https://top.aibase.com/tool/llmlingua-2

清北爸爸辅导数学崩溃瞬间,这个国产大模型有解!AI启发问答关键情绪稳定

【新智元导读】辅导孩子写作业这件事,竟难倒了一众清北爸爸、海淀妈妈。不过,最近爆火的这个国产大模型,让无数家长疯狂冲进视频留言,直接把它评为国内家长最想要的AI!前几天,微博热搜上的这个话题,可以说是让家长们哭笑不得。既然补习老师不靠谱,那亲自上阵辅导孩子写作业呢?让清北毕业的爸爸都崩溃的这个难题,恐怕没有这么简单。毕竟,自己会做一道题和能把孩子教会,是完全不同的两件事。站长网2024-06-06 21:01:220001大模型总结摘要靠谱吗?比人类写的流畅,用GPT-4幻觉还少

以后文本摘要总结任务,可以放心交给大模型了。文本摘要,作为自然语言生成(NLG)中的一项任务,主要用来将一大段长文本压缩为简短的摘要,例如新闻文章、源代码和跨语言文本等多种内容都能用到。随着大模型(LLM)的出现,传统的在特定数据集上进行微调的方法已经不在适用。我们不禁会问,LLM在生成摘要方面效果到底如何?站长网2023-09-20 15:37:510002永辉门店将增设“正品折扣店” APP/小程序增设折扣专区

永辉近日表示,将在全国范围的门店中增设“正品折扣店”,并同步在线上APP/小程序增设折扣专区,提供食品、用品惊喜折扣价。据介绍,在折扣商品选择方面,区别于传统的临期商品折扣价的运营逻辑,永辉以提高商品效率为核心,通过自有供应商系统、YHDOS数字化系统等数字化手段,科学地对商品绩效进行评估。站长网2023-10-10 11:32:150000贵州茅台:i茅台累计注册用户超4000万

据贵州茅台公布数据显示,截至5月18日,i茅台的注册用户已超过4000万,并且累计销售额已经超过了230亿元。据了解,2022年5月19日,i茅台APP宣布正式上线。“i茅台”是贵州茅台官方推出的数字营销APP,支持消费者在线注册、实名认证、线上线下支付、取消退款、门店提货等。站长网2023-05-19 16:07:410001快手:将于12月31日停止第三方微短剧小程序商业投放

快手宣布,为引导付费短剧业务健康发展、夯实自身短剧内容和产业生态建设,将于12月31日20:00正式停止第三方微短剧小程序的商业推广和投放。快手官方称,从12月22日起,第三方小程序微短剧广告主可逐步迁移到快手小程序以及快手自建链路进行投放。期间,为了降低迁移对广告主的影响、保障投放效果,平台将给予一定的政策扶持。0000