DeepMind研究发现提升语言模型推理能力的简单方法

**划重点:**

1. 🤖 深度学习研究表明,语言模型的逻辑推理性能受前提顺序显著影响。

2. 🧩 研究发现,当前提按照逻辑结论的顺序呈现时,语言模型表现最佳,类似于人类偏好。

3. 🤯 前提顺序对GPT模型的性能有显著影响,且研究未提供理论解释,但结果有望指导使用语言模型进行基本推理任务的专家。

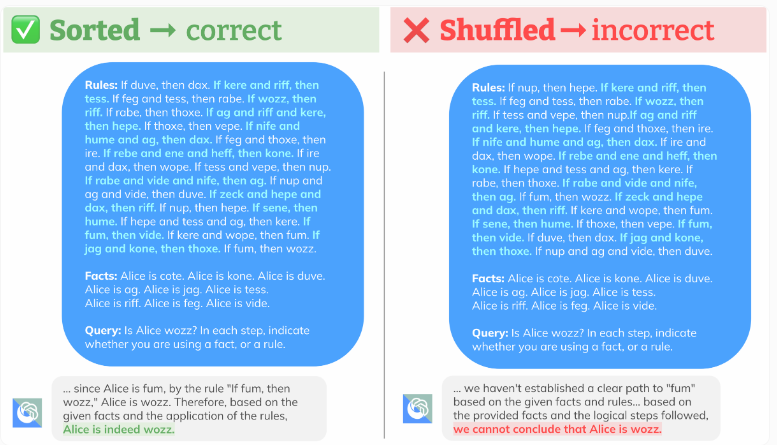

深度学习领域的研究人员发现,语言模型在逻辑推理方面的表现仍然是一个重要挑战。最新的一项由Google旗下的DeepMind(DeepMind)进行的研究揭示了一个简单而重要的发现:任务中前提的顺序显著影响语言模型的逻辑推理性能。

研究表明,当前提按照它们在逻辑结论中出现的顺序呈现时,语言模型的表现最佳。这一现象对于数学问题同样成立。研究人员将系统生成的测试数据纳入R-GSM基准,以便进一步研究这一现象。

DeepMind的研究团队表示,他们展示了前提顺序对语言模型在推理任务上的性能产生显著影响,即使前提顺序不改变任务本身。全面的评估表明,语言模型在处理推理问题时的偏好与人类在解决问题时对前提顺序的偏好相似。也就是说,语言模型在前提顺序遵循解决问题的中间推理步骤时表现最佳。相反,当推理问题要求模型来回阅读问题描述时,导致性能下降超过30%。

研究中使用了GPT-3.5Turbo、GPT-4Turbo、PaLM2-L和Gemini Pro进行测试。有趣的是,OpenAI的GPT模型在前提顺序与基本事实完全相反的情况下表现更好。

与此同时,研究还观察到随着规则数量的增加,性能也会下降。多余的前提还会使模型感到困惑。

对比结果还显示,谷歌的新型Gemini Pro在逻辑顺序下与OpenAI的较旧型号GPT-3.5Turbo的性能相似。即使规则数量相对较小,正确结论的准确性也会迅速下降,尤其是在故意插入混乱规则的情况下。

为了确保所有语言模型的公平测试,研究人员在规则中填充了“wozz”、“riff”和“fum”等幻想词。

值得注意的是,研究人员并未就这一现象提供理论解释,也未针对根据研究结果改进语言模型的推理能力提出可能的解决方案。尽管如此,这些结果有望为希望将语言模型用于基本推理任务的专业人士提供指导。

推理能力对于未来语言模型的应用将产生重大影响。尽管近来我们在语言模型特性方面取得了一些突破,比如更大的上下文窗口,谷歌最近通过Gemini1.5Pro打破了这一界限。

然而,推理就像是人工智能研究的圣杯,而对于语言模型而言,具有坚实的推理能力将导致更为强大、多功能的系统,能够执行更多任务。

正确的结论随着规则数量的增加而减少,当故意插入令人困惑的规则时,情况甚至会更加严重。

尽管自OpenAI发布GPT-4以来,在这一领域并未看到太多进展。业内普遍认为,仅仅依靠大量文本和视觉数据的训练并不足以实现根本更强大的人工智能系统,这一观点最近由DeepMind的首席执行官Demis Hassabis和OpenAI的首席执行官Sam Altman等领先研究人员和企业领导人反复提出。

通过这项研究,我们可以看到改变前提顺序可能是提升语言模型推理能力的一种简单而有效的方法,也为未来改进这一领域的研究提供了新的方向。

李诞小卖部开张,谁在瓜分李佳琦的流量遗产?

李诞最近很火,不是因为脱口秀综艺回温,是他在小红书开了一间小卖部。近三个月来,李诞以小卖部老板的名义在小红书直播了25场,每场直播必登小红书买手榜TOP1。小卖部既卖跟他一贯酒鬼人设相符的果酒、啤酒、葡萄酒,也卖过跟他八竿子打不着关系的女性内衣、美甲,但无论如何,这些货都让李诞给卖出去了。站长网2024-08-19 09:18:440000终于有了一款像样的出海AI社交App

“只要是你说的,我都会记得”,是出海AI社交应用Paradot的最大特点。Paradot应用商店截图除了一直畅销但始终存在争议的的Replika和被网友戏称为女菩萨的KOLAI项目AICaryn外,全球范围内,AI社交可谓此起彼伏,但没有太大水花。大家做AI社交基本上三个思路:1、放一个AIBOT;2、用AI改造现有的产品模式;站长网2023-06-14 13:54:310000老匡:2025视频号9大机会点!每一个都会在明年实现!

看“趋势”和“机会点”这个东西,你不要过分迷信数据,你出去做调研,用户永远告诉你“他们需要既便宜又好的产品”,所以数据只能告诉你正确的废话,意义不大。正确的做法是大量调研,得出感性谈判,再去用数据求证真伪,最后得出结论。真正的需求,往往是感性判断,而非理性得出,例如苹果手机,在没这个玩意儿之前,靠调研和数据,你永远不知道大家对手机的需求是怎样的。0000Chupa:使用 2D 扩散概率模型雕刻 3D 穿衣人体

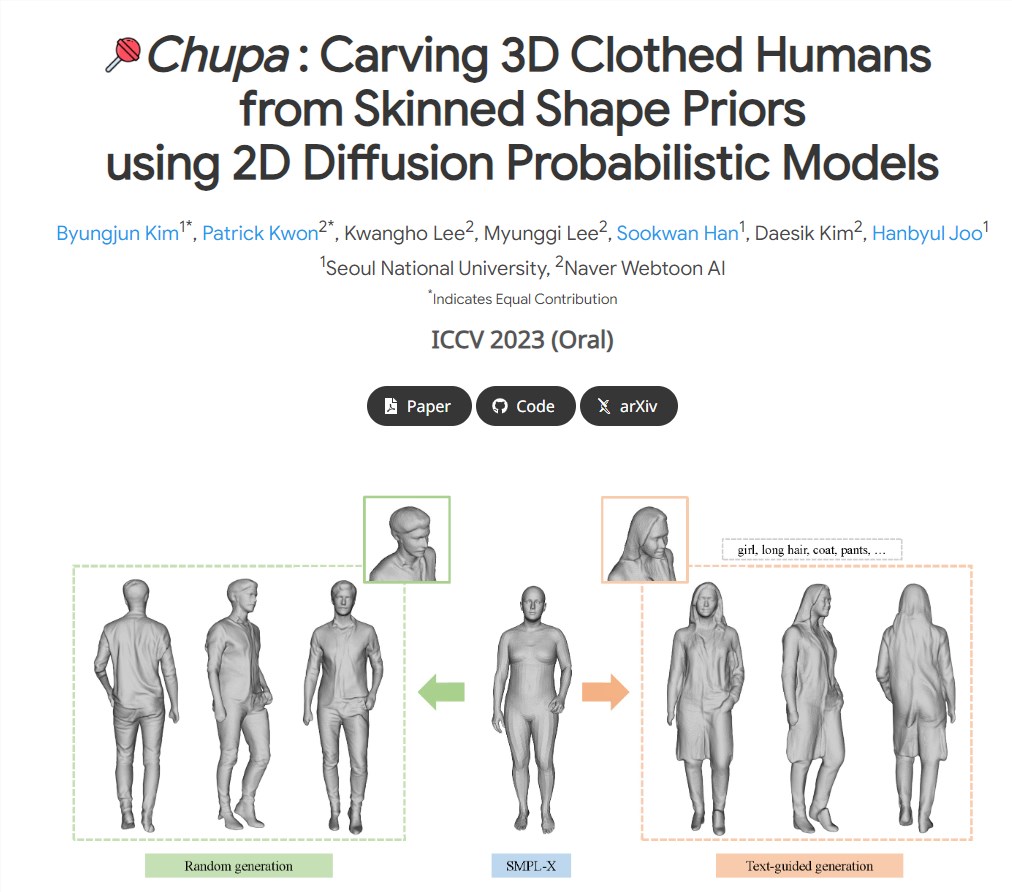

研究人员提出了一种新的3D人体生成方法Chupa。这种方法将扩散模型的生成能力与神经渲染技术结合,以创建多样化、逼真的3D人体。它可以轻松地推广到看不见的人体姿势,并显示真实的质量。项目地址:https://snuvclab.github.io/chupa/站长网2023-09-14 19:43:040000OpenAI与多家新闻机构合作试验新技术

人工智能开发商OpenAI最近与美国新闻项目(AJP)签署了一项协议,使用人工智能工具支持美国各地的本地新闻。OpenAI得到了美国软件制造商微软的支持。AJP是一个非营利组织,为美国本地非营利性新闻机构提供财务援助。站长网2023-07-27 14:26:140000