微软推EgoGen:创新性3D数据合成模型 可生成丰富多模态数据

划重点:

1. 🚀 EgoGen是微软与苏黎世联邦理工学院合作推出的创新3D数据合成模型,解决第一人称视角训练数据生成的难题。

2. 🌟 该模型采用双阶段强化学习方案,通过高效的自我感知视觉代理和“注意”奖励,优化生成模型,使虚拟人物更自然、逼真地感知环境。

3. 📊 经过综合评估,EgoGen生成的高质量合成数据显著提升了在头戴式摄像头建图与定位、摄像头跟踪以及第一人称视角恢复人体网格等任务上的算法性能。

站长之家(ChinaZ.com) 2月23日 消息:微软近期推出的EgoGen引起了广泛关注,这是一项创新的3D数据合成模型,旨在应对第一人称视角训练数据生成中的各种挑战。随着AR、VR等设备的广泛应用,第一人称应用越发增多,但相关研发面临着图像模糊、视觉混乱、遮挡等问题,给视觉模型的训练带来了重大挑战。

为了解决这一问题,微软与苏黎世联邦理工学院的研究人员共同推出了EgoGen。该模型不仅具备高效的数据生成流程,而且适用于多个自我中心感知任务,例如能够生成用于恢复自我中心视角下人体网格的数据。

EgoGen的创新之处在于采用了双阶段强化学习方案来训练生成模型。在第一阶段,研究人员使用生成模型训练虚拟人物的行为,将身体运动和感知过程巧妙结合。关键点在于使虚拟人能够通过自我感知的视觉输入看到周围的环境,并通过学习控制一组避免碰撞的运动基元的策略来做出反应,进而合成多样化的人类动作。

为了提高训练的稳定性,EgoGen采用了高效的自我感知视觉代理和“注意”奖励。这一奖励机制在强化学习优化阶段发挥关键作用,通过引导奖励函数,使虚拟人物的运动更加自然和逼真。具体而言,当虚拟人物朝着期望的方向观察时,将获得“注意”奖励的正向反馈,鼓励其在感知任务中更加专注和准确。

经过强化学习优化,研究人员成功改进了生成模型,使虚拟人物能够以最佳方式感知环境、规避障碍并达到目的地。这一过程中,“注意”奖励的实现方式根据具体情况进行调整,确保虚拟人物的注意力与任务目标保持一致。

为了验证EgoGen方法的有效性,研究人员在头戴式摄像头建图与定位、摄像头跟踪以及第一人称视角恢复人体网格等三个第一人称感知任务上进行了综合评估。通过使用EgoGen生成的高质量合成数据,并提供精确的地面真实标注,已有算法在这些任务上的性能得到了显著增强。

EgoGen的推出标志着在解决第一人称视角训练数据生成难题方面迈出了重要一步,为AR、VR等领域的发展提供了有力支持。未来随着该模型的开源,相信将有更多的开发者参与其中,共同推动该领域的发展。

产品特色和亮点包括:

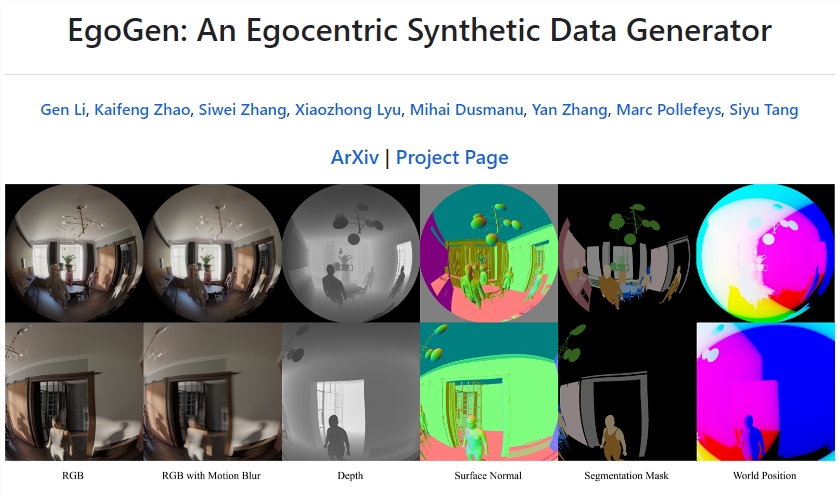

多模态数据生成: EgoGen能够生成丰富的多模态数据,包括逼真的RGB图像、带有模拟动态模糊的RGB图像、深度图、表面法线、分割蒙版以及在头戴设备广泛使用的鱼眼相机的世界位置等。

摄像机仿真: 该系统模拟了头戴设备上的摄像机配置,包括摄像机传感器的位置和角度。用户可以从摄像机佩戴者的视角进行渲染。

准确标注: EgoGen提供准确的注释,有助于训练深度学习模型。这对于主观感知任务中的监督学习至关重要。

可扩展性: 产品具备可扩展性,使其能够适应不同的主观感知任务和场景,提供了更灵活的数据生成解决方案。

论文地址:https://arxiv.org/abs/2401.08739

项目入口:https://top.aibase.com/tool/egogen

开源中国获7.75亿元B+轮战略融资

据36氪消息,2023年6月,开源中国/Gitee(开源共识(上海)网络技术有限公司)完成了B轮战略融资。此轮融资由天际资本领投,浦东科创联合泰达投资、浦东软件园、张江科创、君联资本、上海国际创投、瑞力资本、容亿资本、中移动、中网投、国调科改、联想创投及上海科创等机构共同出资,融资总额达7.75亿元。站长网2023-06-28 15:35:270000多亲 AI 精灵学生手机正式发布:搭载前沿 AI 大模型 Qin3 Ultra(增强版)

据duoqin多亲微博消息,多亲AI精灵学生手机正式发布,搭载前沿AI大模型Qin3Ultra(增强版)全网首发价1399。据介绍,多亲AI精灵手机采用联发科G99处理器,拥有8GB256GB的存储配置,机身厚度为8.7mm,重量仅为118g。该手机支持侧面指纹解锁和红外遥控。站长网2023-07-17 23:38:120001老机型重生!华为手机内存升级限时8.8折:仅需342元起

快科技9月9日消息,如果手机存储空间不足,会导致应用、系统的正常运行受到影响,流畅度也会下降,这时就需要优化空间或升级存储空间。据华为终端官方公众号介绍,华为老机型内存(官方解释为存储内存,实际就是存储空间)升级服务正在进行限时8.8折活动,方便老机型用户升级。站长网2024-09-10 13:43:300001锤子便签发布4.0内测版 新增 AI 助手等会员功能

近日,锤子便签应用迎来了重要的更新——4.0内测版正式发布。此次更新最大的亮点在于新增了“便签会员”功能,其中尤以AI助手功能最为引人注目。用户升级后,将能无限享受AI助手的强大功能,不过具体的价格暂时还未公开。站长网2024-04-08 12:41:410001TICD:清华新文生3D方法引领SOTA,多视角一致性再突破

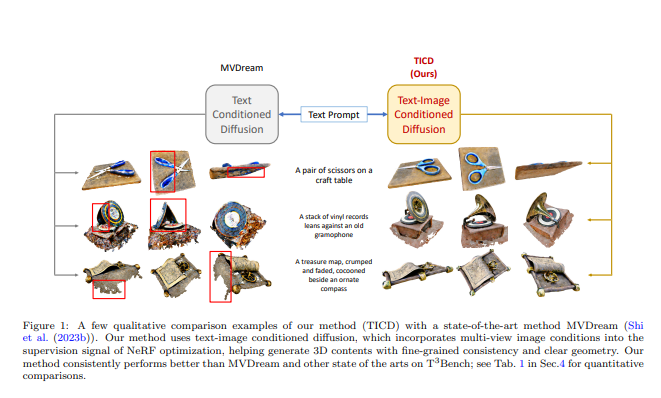

要点:清华大学刘永进教授课题组提出的TICD模型在文生3D领域取得SOTA成绩,通过多视角一致性先验提升了生成的3D模型质量。TICD方法在T3Bench数据集上经过定性和定量测试,显示其在单对象、单对象带背景、多对象提示集上均达到最佳成绩,凸显整体优势。TICD通过以文本和图像为条件的多视角图像纳入NeRF监督信号,有效解决了预训练扩散模型的局限性,提高了生成3D模型的一致性和质量。站长网2023-12-29 14:17:000000