DrugAssist:基于LLM的分子优化模型 可以用自然语言与人类实时交互

**划重点:**

- 🧪 **背景:** 近年来,大型语言模型(LLMs)在语言处理领域取得显著进展,但在药物发现的分子优化方面存在挑战。

- 🌐 **项目介绍:** Tencent AI Lab 和湖南大学计算机科学系的研究人员发布了MolOpt-Instructions和DrugAssist,旨在通过人机互动优化分子。

- 🚀 **成果与特点:** DrugAssist在多属性优化中表现出色,具有在零样本和少样本情景下的优秀可迁移性,为药物发现提供实时互动和迭代优化的可能性。

随着近年来大型语言模型(LLMs)在语言处理领域的显著进展,研究人员尝试将这些模型应用于药物发现,以优化相关任务。然而,在药物发现的分子优化方面,LLMs并未取得显著进展。现有方法通常侧重于利用数据中提供的化学结构的模式,而忽视了领域专家的反馈和经验。这在问题上造成了困扰,因为药物发现流程涉及整合来自领域专家的反馈,以进一步完善流程。

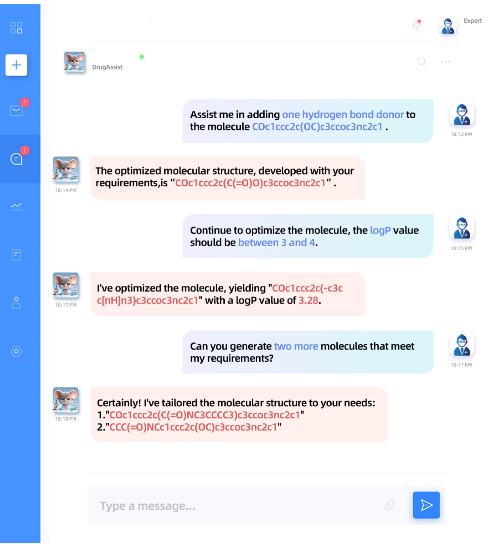

为填补先前工作中的差距,研究人员着重于人机交互,利用强大的LLMs的交互性和通用性。他们发布了MolOpt-Instructions,这是一个用于在分子优化任务上对LLMs进行微调的大型基于指令的数据集。此数据集涵盖了与分子优化相关的任务,确保了分子之间的相似性约束和性质之间的实质性差异。此外,他们还提出了DrugAssist,这是一个基于Llama-2-7B-Chat的分子优化模型,能够通过人机对话进行交互式优化。通过这些对话,专家可以进一步引导模型并优化最初生成的结果。

为了评估,研究人员将DrugAssist与两个先前的分子优化模型和三个LLMs进行了比较,评估指标包括溶解度和BP以及成功率和有效性等。根据结果显示,DrugAssist在多属性优化方面持续取得有希望的成果,并在给定范围内保持了优化的分子性质值。

此外,研究人员还通过案例研究展示了DrugAssist的卓越能力。在零样本设置下,模型被要求同时将两个属性BP和QED的值至少增加0.1,即使在训练过程中仅暴露于数据,该模型也成功完成了任务。此外,DrugAssist还成功地将给定分子的logP值增加了0.1,即使这个属性没有包含在训练数据中。这展示了模型在零样本和少样本设置下的良好可迁移性,使用户有可能同时结合个别属性并进行优化。最后,在交互过程中,模型生成了一个不符合要求的分子的错误答案。然而,它通过人类反馈纠正了错误并提供了正确的响应。

总体而言,DrugAssist是一种基于Llama-2-7B-Chat模型的分子优化模型,能够实时与人类进行互动。它在单属性和多属性优化中展现了出色的结果,表现出很强的可迁移性。

论文地址:https://arxiv.org/abs/2401.10334?

项目地址:https://github.com/blazerye/DrugAssist

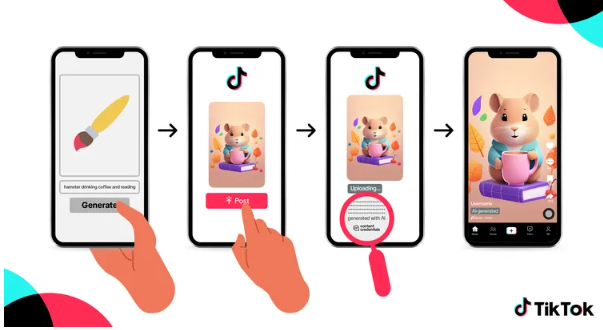

TikTok新增 “AI生成” 标签,识别标注第三方生成的AI内容

划重点:-🤖TikTok将为使用第三方平台生成的内容添加“AI生成”标签-🌐支持Adobe的ContentCredentials标记系统-📱实现多阶段自动识别和标签功能站长网2024-05-10 17:23:100000推理性能飙升1.5倍!微软疯狂下单GB200芯片提升其AI算力

快科技10月20日消息,分析师郭明錤的最新报告指出,NVIDIAGB200芯片订单量迎来爆炸性增长,其中微软第四季度订单量激增3到4倍,超过所有其他云服务商的总和。他指出,NVIDIABlackwell芯片的产能扩张预计将于2024年第四季度初启动,预计第四季度出货量在15万到20万块之间,而2025年第一季度出货量将增长200%到250%,达到50万到55万块。0000SQLCoder:将自然语言问题转化为 SQL 查询的先进模型

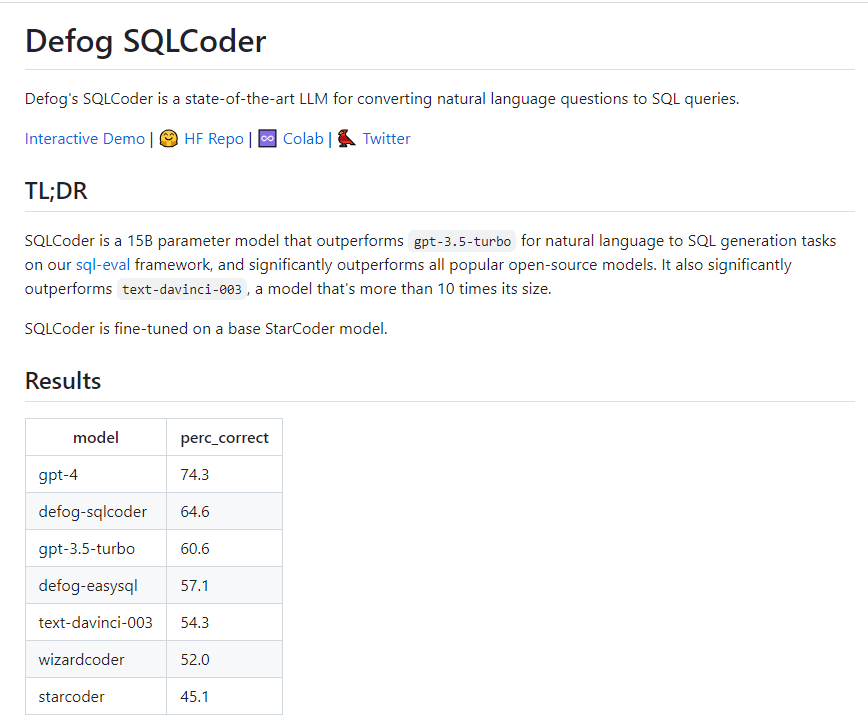

SQLCoder是由Defog.ai开发的一款先进模型,用于将自然语言问题转化为数据库查询。它在通用SQL架构中表现出色,并且在针对特定数据库架构进行优化时,性能超过了gpt-4。项目地址:https://github.com/defog-ai/sqlcoder站长网2023-08-23 16:26:510004Nomic AI发布开源嵌入模型Nomic Embed,击败OpenAI的Ada-002

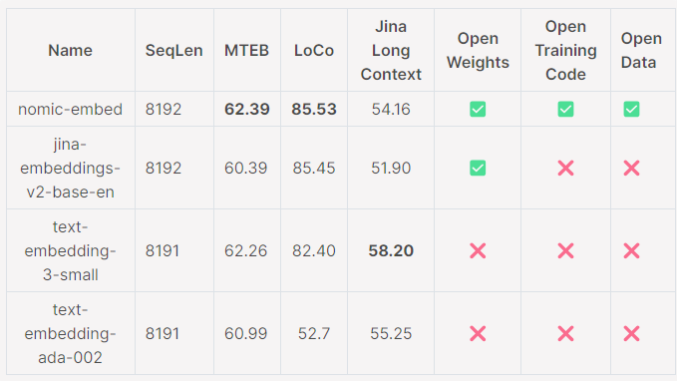

**划重点:**1.🏆NomicEmbed在短文和长文任务中胜过OpenAI的Ada-002和text-embedding-3-small模型。2.🔍模型支持最大8192的上下文长度,通过MassiveTextEmbeddingBenchmark(MTEB)和LoCoBenchmark表现优异。站长网2024-02-02 14:38:300000魔搭社区上线Mistral AI 首个开源 MoE 模型 Mixtral8x7B

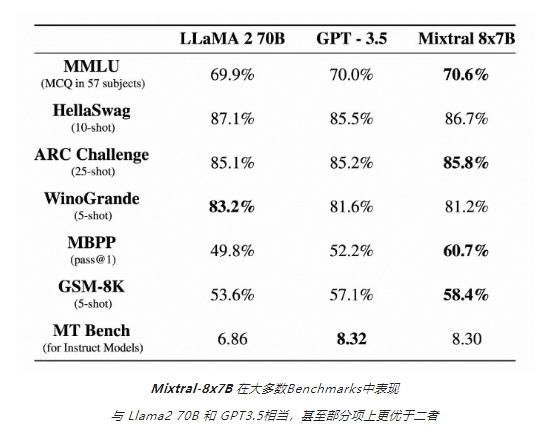

MistralAI近日发布了首个开源MoE模型Mixtral8x7B,并宣布在魔搭社区上线。Mixtral-8x7B是一款混合专家模型(MixtrueofExperts),由8个拥有70亿参数的专家网络组成,在能力上,Mixtral-8x7B支持32ktoken上下文长度,支持英语、法语、意大利语、德语和西班牙语,拥有优秀的代码生成能力,可微调为指令跟随模型。站长网2023-12-14 09:42:420000