OpenAI新模型用的嵌入技术被网友扒出来了

前几天,OpenAI 来了一波重磅更新,一口气宣布了5个新模型,其中就包括两个新的文本嵌入模型。

我们知道,嵌入是表示自然语言或代码等内容中概念的数字序列。嵌入使得机器学习模型和其他算法更容易理解内容之间的关联,也更容易执行聚类或检索等任务。

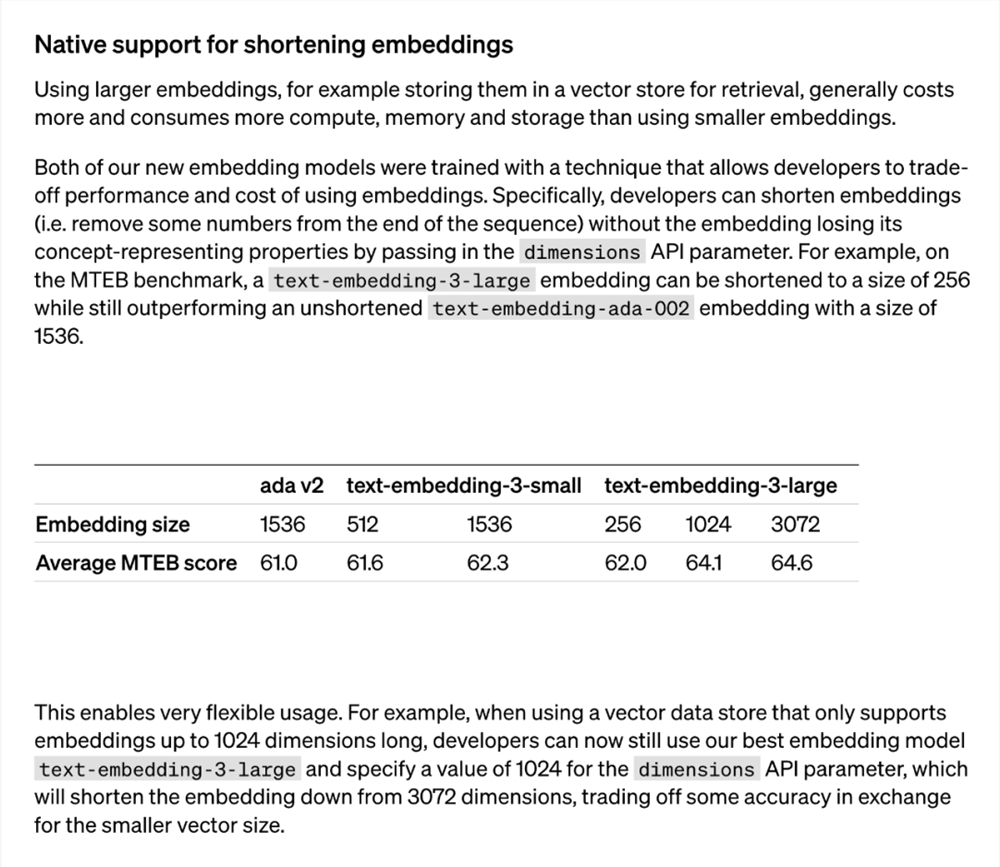

使用更大的嵌入(比如将它们存储在向量存储器中以供检索)通常要比更小的嵌入消耗更高的成本、以及更多的算力、内存和存储。而 OpenAI 此次推出的两个文本嵌入模型分别是更小且高效的 text-embedding-3-small 模型和更大且更强大的 text-embedding-3-large 模型。

这两个新嵌入模型都使用一种技术进行训练,允许开发人员权衡使用嵌入的性能和成本。具体来说,开发者通过在 dimensions API 参数中传递嵌入而不丢失其概念表征属性,从而缩短嵌入(即从序列末尾删除一些数字)。例如在 MTEB 基准上,text-embedding-3-large 可以缩短为256的大小, 同时性能仍然优于未缩短的 text-embedding-ada-002嵌入(大小为1536)。

这一技术应用非常灵活:比如当使用仅支持最高1024维嵌入的向量数据存储时,开发者现在仍然可以使用最好的嵌入模型 text-embedding-3-large 并指定 dimensions API 参数的值为1024,使得嵌入维数从3072开始缩短,牺牲一些准确度以换取更小的向量大小。

OpenAI 所使用的「缩短嵌入」方法,随后引起了研究者们的广泛注意。

人们发现,这种方法和2022年5月的一篇论文所提出的「Matryoshka Representation Learning」方法是相同的。

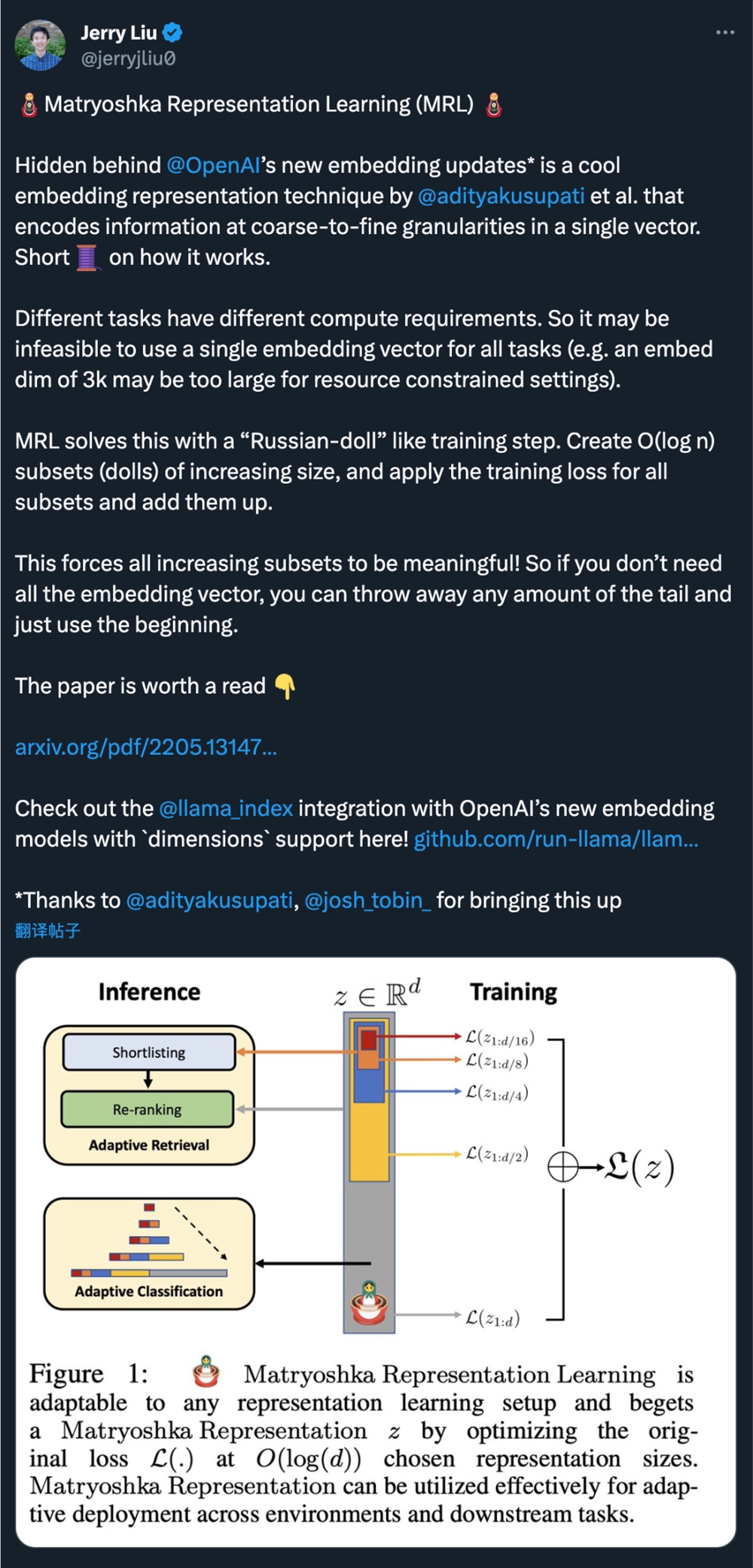

OpenAI 的新嵌入模型更新背后隐藏的是 @adityakusupati 等人提出的一种很酷的嵌入表征技术。

而 MRL 的一作 Aditya Kusupati 也现身说法:「OpenAI 在 v3嵌入 API 中默认使用 MRL 用于检索和 RAG!其他模型和服务应该很快就会迎头赶上。」

那么 MRL 到底是什么?效果如何?都在下面这篇2022年的论文里。

MRL 论文介绍

论文标题:Matryoshka Representation Learning

论文链接:https://arxiv.org/pdf/2205.13147.pdf

研究者提出的问题是:能否设计一种灵活的表征方法,以适应计算资源不同的多个下游任务?

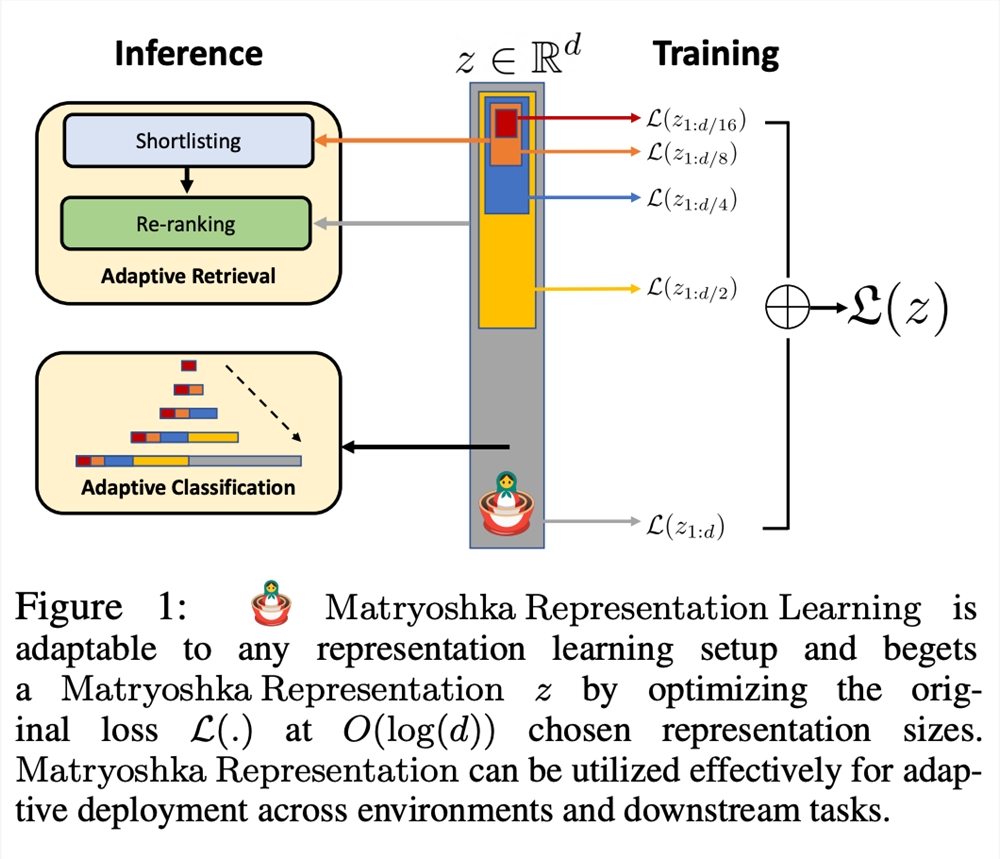

MRL 通过以嵌套方式对 O (log (d)) 低维向量进行显式优化在同一个高维向量中学习不同容量的表征,因此被称为 Matryoshka「俄罗斯套娃」。MRL 可适用于任何现有的表征 pipeline,并可轻松扩展到计算机视觉和自然语言处理中的许多标准任务。

图1展示了 MRL 的核心理念以及所学习 Matryoshka 表征的自适应部署设置:

Matryoshka 表征的第一个 m-dimensions(m∈[d])是一个信息丰富的低维向量,不需要额外的训练成本,其精确度不亚于独立训练的 m 维表征法。Matryoshka 表征的信息量随着维度的增加而增加,形成了一种从粗到细的表征法,而且无需大量的训练或额外的部署开销。MRL 为表征向量提供了所需的灵活性和多保真度,可确保在准确性与计算量之间实现近乎最佳的权衡。凭借这些优势,MRL 可根据精度和计算约束条件进行自适应部署。

在这项工作中,研究者将重点放在了现实世界 ML 系统的两个关键构件上:大规模分类和检索。

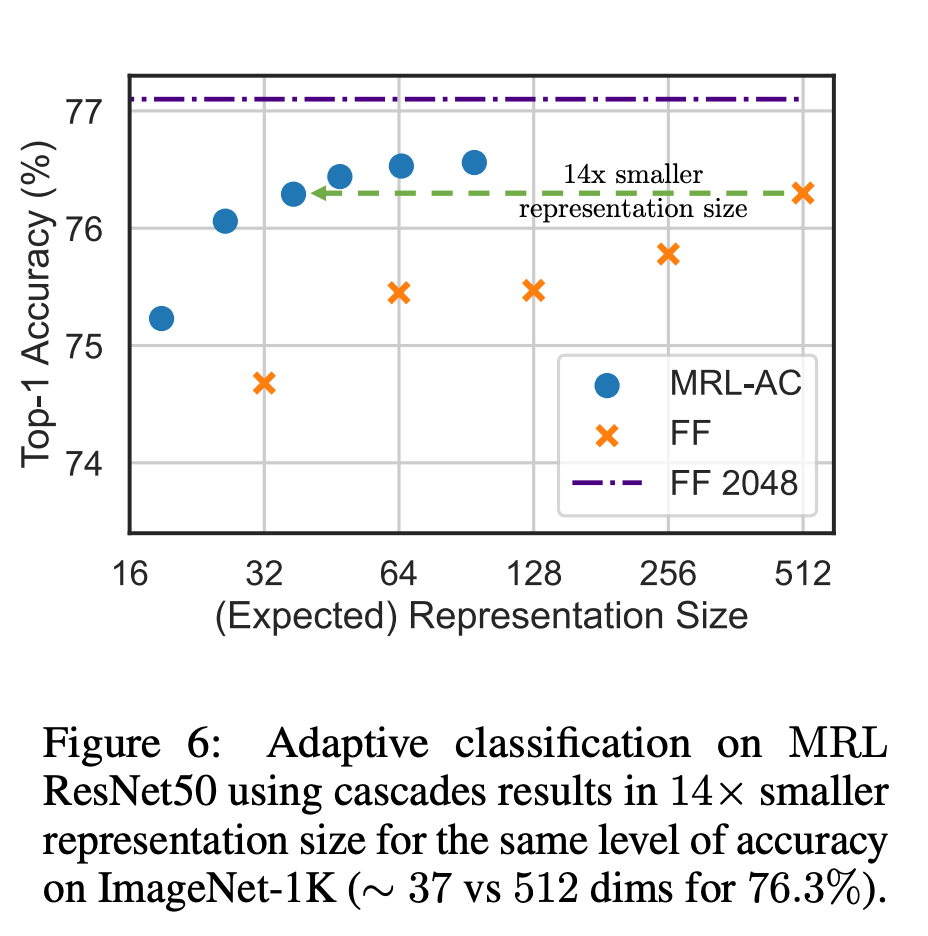

在分类方面,研究者使用了自适应级联,并使用由 MRL 训练的模型产生的可变大小表征,从而大大降低了达到特定准确率所需的嵌入式平均维数。例如,在 ImageNet-1K 上,MRL 自适应分类的结果是,在精度与基线相同的情况下,表征大小最多可缩小14倍。

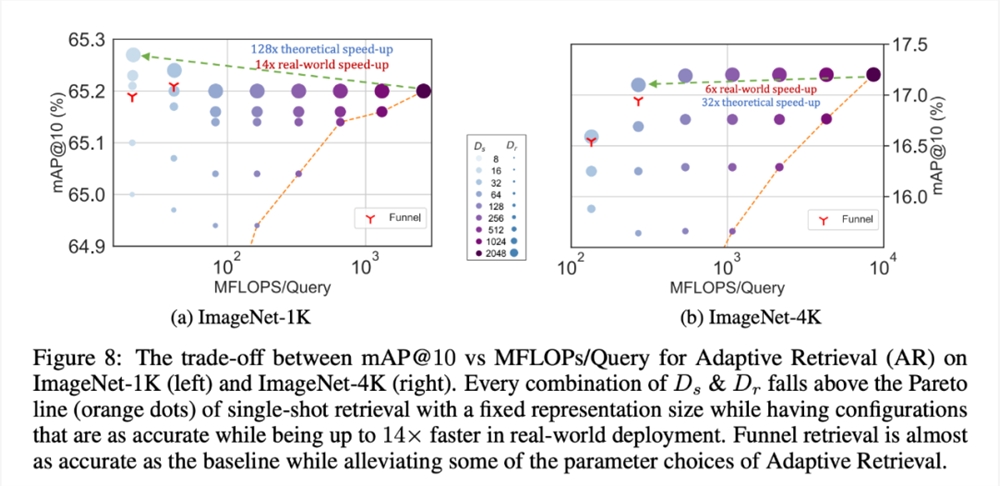

同样地,研究者在自适应检索系统中也使用了 MRL。在给定一个查询的情况下,使用查询嵌入的前几个 dimensions 来筛选检索候选对象,然后连续使用更多的 dimensions 对检索集进行重新排序。与使用标准嵌入向量的单次检索系统相比,这种方法的简单实现可实现128倍的理论速度(以 FLOPS 计)和14倍的墙上时钟时间速度;需要注意的是,MRL 的检索精度与单次检索的精度相当(第4.3.1节)。

最后,由于 MRL 明确地学习了从粗到细的表征向量,因此直观地说,它应该在不同 dimensions 之间共享更多的语义信息(图5)。这反映在长尾持续学习设置中,准确率最多可提高2%,同时与原始嵌入一样稳健。此外,由于 MRL 具有粗粒度到细粒度的特性,它还可以用作分析实例分类难易程度和信息瓶颈的方法。

更多研究细节,可参考论文原文。

AI视野:微软推自主研发AI芯片Maia100;WPS AI开启公测;OPPO发布安第斯大模型AndesGPT;DeepMind发布新模型Mirasol3B

📰🤖📢AI新鲜事微软正式宣布其首款人工智能芯片Maia100微软宣布推出首款自主研发的AI芯片Maia100,旨在训练大型语言模型,并推出基于Arm架构的通用计算芯片Cobalt100,以优化云计算工作负载。【AiBase提要:】😊Maia100AI芯片:微软推出首款自主研发的AI芯片,支持云AI工作负载,包括大型语言模型的训练和推理,采用5纳米TSMC工艺制造。站长网2023-11-16 15:28:080000官宣美国平台业务,SHEIN为此没少努力

4月5日,SHEIN在官网宣布既巴西平台业务后,下一站会在美国做平台。外界多次的猜测终于被官方盖章了。从2022年有消息指出SHEIN正在巴西试点平台模式,鼓励第三方卖家及品牌入驻,到SHEIN的平台试点扩展到了墨西哥,到3月份,SHEIN正式在巴西推出平台,再到官宣美国,看得出SHEIN做平台的决心还是很强的。站长网2023-05-06 09:39:320002天玑!联发科天玑9400参数尘埃落定:vivo全球首发

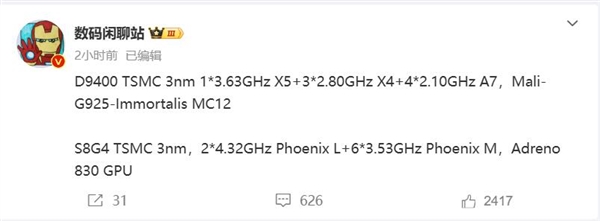

快科技9月12日消息,博主数码闲聊站曝光了天玑9400的详细配置,这是联发科迄今最强悍的手机芯片。据悉,天玑9400延续了上一代的全大核架构方案,由1颗3.63GHzCortex-X925超大核3颗2.8GHzCortex-X4超大核4颗2.1GHzCortex-A7系列大核组成。站长网2024-09-13 17:31:290000调查:仅有4%青少年和年轻人几乎每天使用AI工具

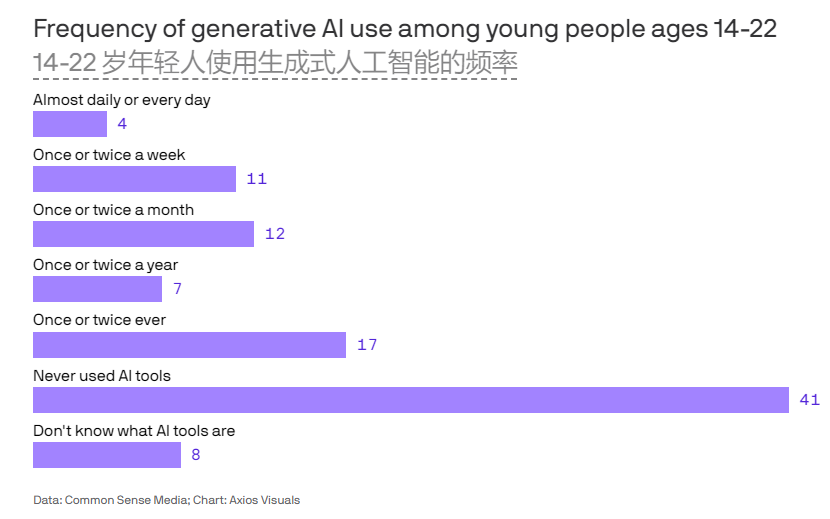

划重点:-📊仅有4%的受访者称他们每天或几乎每天使用人工智能工具-📚AI的两种最常见用途是获取信息和头脑风暴-🌐41%的受访者预计未来10年人工智能将产生积极和消极影响站长网2024-06-03 20:16:330000一句话搞定3D模型纹理贴图,全程只需30秒,港大港中大TCL出品 | ICCV'23 Oral

用上扩散模型,3D物体生成纹理一句话就能搞定!像是输入“一张带有棕色和黑色几何图案的椅子”,扩散模型就能立刻给它复个古,贴上颇具年代感的纹理:甚至只是丢给它一张看不出桌面长啥样的“截图”,AI也能立刻凭借想象力,给桌面加上木质的细节纹理:要知道,给3D物体加上纹理,可不只是“变变颜色”这么简单。站长网2023-08-27 13:43:090000