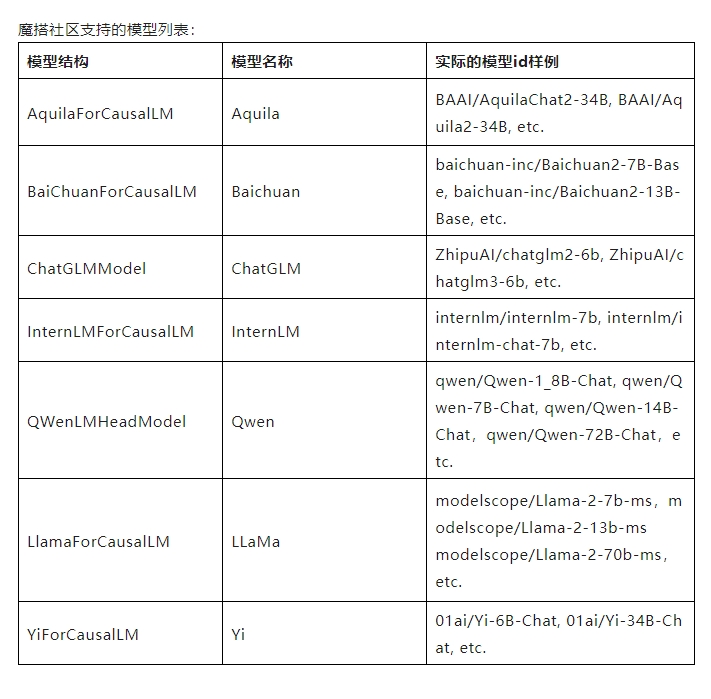

魔搭社区与vLLM和FastChat展开合作 提供高效LLM推理和部署服务

站长网2023-12-29 08:52:464阅

最近,魔搭社区与 vLLM 和 FastChat 展开合作,联合为中国开发者提供更快更高效的 LLM 推理和部署服务。开发者可以使用 vLLM 作为 FastChat 中的推理引擎,提供高吞吐量的模型推理。

FastChat 是一个开放平台,用于训练、服务和评估基于 LLM 的 ChatBot。它具有优秀的大语言模型训练和评估代码,并且具有 Web UI 和 OpenAI 兼容的 RESTful API 的分布式多模型服务系统。

vLLM 是一个由加州伯克利分校、斯坦福大学和加州大学圣迭戈分校的研究人员开发的 LLM 服务系统。它基于操作系统中经典的虚拟缓存和分页技术,实现了几乎零浪费的 KV 缓存,并且可以在请求内部和请求之间灵活共享 KV 高速缓存,从而减少内存使用量。

通过 FastChat 和 vLLM,开发者可以快速加载魔搭的模型进行推理。可以使用 FastChat 发布 model worker (s),并通过命令行客户端或网页端 WebUI 进行问答。还可以结合 FastChat 和 vLLM 搭建一个网页 Demo 或者类 OpenAI API 服务器。

FastChat开源链接:

https://github.com/lm-sys/FastChat

vLLM开源链接:

https://github.com/vllm-project/vllm

新鲜AI产品点击了解:https://top.aibase.com/

0004

评论列表

共(0)条相关推荐

百度高管称舆论的喧嚣总会过去 将捍卫百度文化

站长之家(ChinaZ.com)5月10日消息:据百度官方消息,在昨日百度盛大举行的年度先进颁奖活动上,百度集团资深副总裁崔珊珊发表了热情洋溢的演讲,强调捍卫百度文化的重要性,并呼吁公司上下持续革新,永不止步。“在百度,简单可依赖的价值观是我们最宝贵的财富。”崔珊珊在颁奖礼上深情地说道。她指出,尽管外界舆论喧嚣,但百度人始终坚守这一核心价值观,不断推动自我革新。站长网2024-05-10 23:51:490001图文带货迎来新机遇,利好广大抖音电商作者

抖音电商新机遇在图文带货领域显现。抖音电商官方数据显示,2023年上半年,电商短视频日均播放次数同比增长19.4%,电商直播间日均开播时长同比增长31.7%,图文带货内容日均播放次数增长了728.1%,增幅超短视频与直播这两个内容体裁。站长网2023-10-10 14:00:020000微信支付手续费免费到明年9月:已让利30亿

微信支付已经成为很多人日常买东西的主要支付手段之一,很多小商家也是靠微信支付收付款,今天腾讯发布消息称面向商户的手续费继续优惠,持续到2024年9月份。为微信支付提供服务的财付通”在公众号宣布积极响应监管对小微企业、个体工商户、有经营行为的个人的降费让利政策要求,对符合标准的小微商户实行支付手续费优惠。0001字节跳动或关停多个互动剧业务 包括泡泡心选、果冻心选等

站长之家(ChinaZ.com)6月13日消息:随着字节商业化策略的进一步调整,巨量引擎所开发的一系列深受用户喜爱的IAP互动剧小程序,如泡泡心选、爪爪心选和果冻心选,将于6月17日正式停止运营。在关停前,三个平台均已发布了详细的通知公告,以确保用户权益得到妥善保障。公告指出,用户在6月17日之前,仍可使用账户内尚未消耗的看点进行互动体验。站长网2024-06-14 00:28:430000英伟达发布HelpSteer:一个用于构建有用LLM的开源数据集

英伟达最近宣布了NVIDIANeMoSteerLM技术作为英伟达NeMo框架的一部分。这项技术使用户能够在推断过程中控制大型语言模型(LLM)的响应。站长网2023-11-28 16:05:010000