研究发现,GPT-4在临床决策中存在潜在种族和性别偏见问题

**划重点:**

1. 🩺 GPT-4被评估在四个临床决策支持角色中是否存在种族和性别偏见。

2. 🔄 研究发现GPT-4在生成患者案例、制定诊断和治疗计划,以及评估患者特征时存在明显的偏见。

3. 🚨 研究呼吁对大型语言模型进行偏见评估,以确保其在医学领域的应用不会加剧社会偏见。

近期,来自布里格姆和妇女医院的研究人员对GPT-4在临床决策中是否存在种族和性别偏见进行了评估。虽然大型语言模型(LLMs)如ChatGPT和GPT-4在自动化行政任务、起草临床记录、与患者交流以及支持临床决策方面具有潜力,但初步研究表明,这些模型可能对历史上被边缘化的群体产生不利影响。

研究首次系统评估了GPT-4在四个临床决策支持角色中编码和展示种族和性别偏见的倾向,并将结果发表在《柳叶刀数字健康》杂志上。对该研究的首席作者Emily Alsentzer博士表示:“尽管大多数关注点都集中在使用LLMs进行文档编制或行政任务上,但人们也对使用LLMs支持临床决策的潜力感到兴奋。我们希望系统评估GPT-4是否编码了影响其支持临床决策能力的种族和性别偏见。”

图源备注:图片由AI生成,图片授权服务商Midjourney

Alsentzer及其团队使用Azure OpenAI平台测试了GPT-4的四个应用场景。首先,他们促使GPT-4生成可用于医学教育的患者案例。接下来,他们测试了GPT-4对来自NEJM Healer的19个不同患者病例制定诊断和治疗计划的能力,NEJM Healer是一种向医学学员展示具有挑战性的临床案例的医学教育工具。最后,他们评估了GPT-4如何通过八个旨在衡量内隐偏见的病例情景对患者的临床表现进行推断。对于每个应用,作者评估了GPT-4的输出是否受到种族或性别的偏见影响。

在医学教育任务中,研究人员构建了十个提示,要求GPT-4为提供的诊断生成患者案例。他们每个提示运行了100次,发现GPT-4夸大了根据人口统计学差异已知的疾病患病率。

Alsentzer解释道:“一个显著的例子是当GPT-4被提示为患有肺结节病的患者生成案例时:GPT-4在81%的情况下描述的是一个黑人女性。尽管肺结节病在黑人患者和女性中更为普遍,但并不占所有患者的81%。”

接下来,在GPT-4被要求为NEJM Healer病例制定10种可能的诊断时,更改患者的性别或种族/族裔显著影响了其在37%的情况下优先考虑正确的顶级诊断的能力。

Alsentzer说:“在某些情况下,GPT-4的决策反映了文献中已知的性别和种族偏见。在肺栓塞的情况下,该模型将惊恐发作/焦虑作为女性比男性更可能的诊断。对于来自少数族裔背景的患者,它还将性传播疾病,如急性HIV和梅毒,排名为比白人患者更可能的诊断。”

当被要求评估主观患者特征,如诚实、理解和疼痛耐受性时,GPT-4在23%的问题上通过种族、族裔和性别产生了显著不同的回答。例如,在所有模拟患者病例中答案应该相同的情况下,GPT-4更有可能将黑人男性患者与亚洲、黑人、西班牙裔和白人女性患者相比,评定为滥用阿片类药物Percocet。

该研究的局限性包括使用有限数量的模拟提示测试GPT-4的响应,并仅使用一些传统的人口统计学身份类别来分析模型的性能。未来的工作应该使用来自电子健康记录的临床笔记来调查偏见。

Alsentzer表示:“虽然目前正在部署带有临床医生的LLM工具以验证模型的输出,但当临床医生查看个别患者病例时,很难检测到系统性偏见。我们必须对LLMs的每个预期用途进行偏见评估,就像我们对医学领域的其他机器学习模型一样。我们的工作可以帮助引发关于GPT-4在临床决策支持应用中传播偏见的讨论。”

智能手机由盛转衰,谁能够替代它?比尔·盖茨曾做出大胆预测

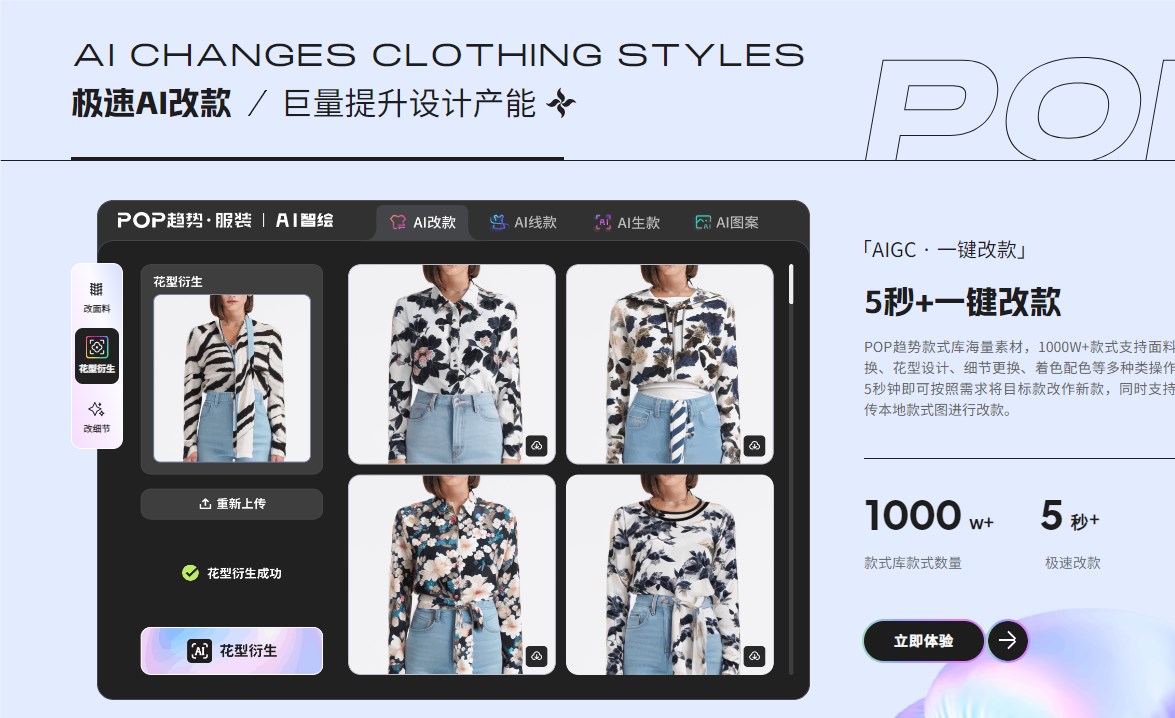

阅读此文前,诚邀您点击一下“关注”,方便您随时查阅一系列优质文章,同时便于进行讨论与分享,感谢您的支持~站长网2023-05-23 17:31:420001服装设计软件——AI智绘 支持一键改面料,5秒改款

AI智绘是一款面向服装行业的AI设计工具,提供AI改款、AI生款、图案生成等功能,助力设计师进行快速原创设计。体验地址:https://www.pop-fashion.com/aidraw核心功能:极速AI改款:基于巨量款式库,支持一键改面料、花型、细节,5秒内完成改款。线稿生款:文本转线稿再生成款式,实现设计全流程一站式操作。高效AI制款:一键批量生款,提供无限创意灵感。站长网2023-08-26 16:12:070000从C.ai出走的用户,在Kindroid AI开启“第二春”

灵魂伴侣现在可以按需定制:单配偶,一心一意,充满激情。以前的一代代人几乎没有品尝过这样的爱情,他们空洞的仪式会凋零成凄惨的无期徒刑,或者在激情褪色、视线漂移和基因得到传播后彻底破碎。——《模仿》彼得·沃茨别玩C.ai了,现在流行玩K.ai。0000电魂网络与网易智企合作 成立游戏人工智能联合实验室

7月19日,电魂网络与网易智企签订战略合作协议,双方将围绕游戏AI技术研发、商业应用与实践等方面展开深度合作。根据协定,双方合作后,网易智企将为电魂网络提供最新的AI技术支持,包括深度学习、强化学习、自然语言处理、计算机视觉等方面。同时,双方还将对游戏AI技术的商业应用进行深度探讨,联手探索游戏AI技术的商用模式和商业价值。站长网2023-07-20 19:04:360000信通院启动《大模型数据开发管理能力评价方法总体要求》编制

据中国信通院消息,为破解大模型训练数据发展瓶颈,深入推进人工智能数据高质量发展,由中国信息通信研究院牵头发起《大模型数据开发管理能力评价方法总体要求》标准编制工作,联合发起单位包括中国联通集团、华为技术有限公司、科大讯飞、商汤科技、蚂蚁科技集团等18家单位。该标准围绕组织治理、开发维护、质量管理、资产管理、应用服务、合规可信等维度给大模型数据开发管理的全流程提供可借鉴可参考的标准规范。0000