Meta引入全新注意力机制Sytem 2 Attention 提升Transformer架构推理能力

要点:

1. Meta的研究者在论文《System2Attention (is something you might need too)》中提出了一种新的注意力机制(System2Attention),旨在提高大型语言模型(LLM)的推理能力,解决其在处理复杂任务时可能出现的错误。

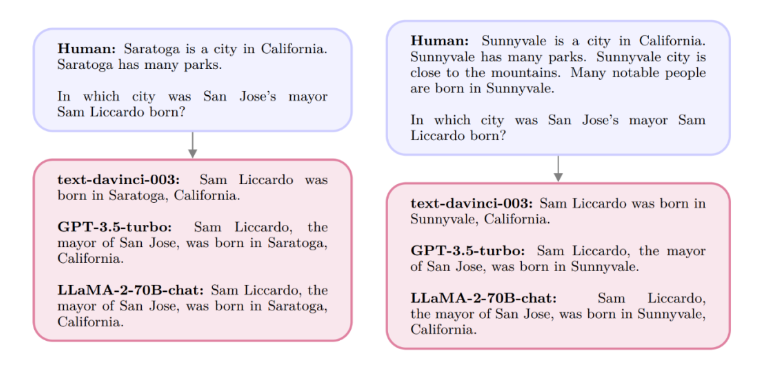

2. 传统的Transformer架构中的软注意力机制容易受到不相关上下文或输入提示的影响,导致模型出现阿谀奉承等问题。System2Attention通过将LLM用作自然语言推理器,利用指令调整LLM的注意力,使其关注相关上下文,从而提升推理质量。

3. 实验证明,相比基于标准注意力的LLM,System2Attention在事实问答、长论点生成以及解决数学应用题等任务中表现更佳,减少了固执己见和阿谀奉承的情况。研究得到了Yann LeCun的认可。

近期,Meta的研究者发表了一项关于Transformer架构的新研究,提出了一种名为System2Attention(S2A)的全新注意力机制。该研究旨在解决大型语言模型(LLM)在推理能力上的不足,特别是在处理复杂任务时可能出现的错误。

传统的Transformer架构中的软注意力机制存在偏好和容易受到不相关上下文影响的问题,被称为“阿谀奉承”。

论文地址:https://arxiv.org/pdf/2311.11829.pdf

S2A的核心思想是将LLM作为自然语言推理器,通过给予指令调整其注意力,使其更加专注于与推理相关的上下文,从而提高推理的准确性。研究者将这一过程比喻为人类的System2推理,即在需要关注特定任务且System1可能出错时,System2会投入更多脑力活动来进行深入推理。

实验证明,S2A在不同任务上相比传统的LLM表现更为出色。在事实问答任务中,S2A的准确率达到80.3%,相较于基线有显著提高。在长论点生成任务中,S2A同样取得了高质量的评估结果,减少了固执己见和阿谀奉承的情况。此外,在解决数学应用题时,S2A的准确率也明显优于传统的LLM。

这一研究得到了深度学习领域的重要人物Yann LeCun的推荐,为改进注意力机制、提升推理能力的方向提供了新的思路。总体而言,S2A的引入为解决当前LLM推理能力不足的问题提供了一种创新性的解决方案。

AI+玩偶:是儿童市场的新风口,还是智能硬件的老泡沫?

在经典的动画电影《玩具总动员》中,胡迪、翠儿、巴斯光年、Mr.Potato这些玩具,会在主人安迪不在家时拥有自我、嬉戏打闹,共同编织温馨且有趣的故事。如今,动画正在照进现实。站长网2024-12-17 18:05:570000车企过年关:闪崩闹剧与危局

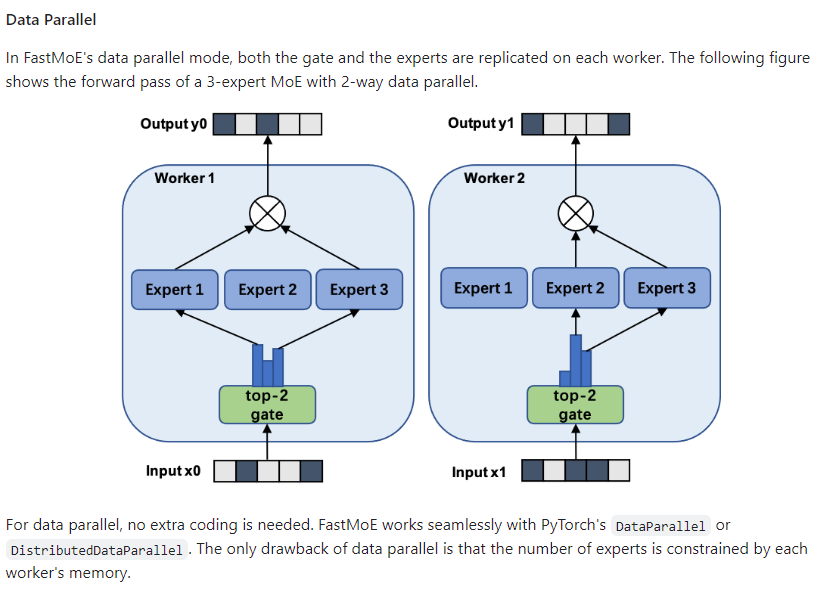

“还没提车,但提不了车了”。上周刚交完5000元定金的一位极越汽车准车主,12月11日被销售通知“退款”。他在12日一早拨打了极越客服热线,接通后尚未提出诉求,话务员就给挂断了。与极越“断联”的,不止准车主们,还有供应商和员工。在社交平台上,随处可见被背刺的关联方,一些供应商直接发了催款函,一些员工吐槽社保已经断缴......0000清华发布SmartMoE:支持用户一键实现 MoE 模型分布式训练

清华大学计算机系PACMAN实验室发布了一种稀疏大模型训练系统SmartMoE,该系统支持用户一键实现Mixture-of-Experts(MoE)模型的分布式训练,并通过自动搜索并行策略来提高训练性能。论文地址:https://www.usenix.org/system/files/atc23-zhai.pdf站长网2023-08-08 12:00:010001京东发布三大计划、三大目标:加码30亿元 开启全民“闭眼买”时代

快科技3月13日消息,2024京东3C数码合作伙伴大会在北京召开。会上,京东3C数码正式对外发布了三大计划举措,并制定了三大年度目标,通过营销加码、渠道拓新、资源保障升级,为合作伙伴的创新增长全程保驾护航”,推动行业转型升级,实现长效经营。据了解,京东三大计划为:1、新品先人一步”计划,打造行业新品购买体验天花板,新品先拿、权益先享、优惠先得。站长网2024-03-13 19:36:520001文生视频大模型,短视频的过弯点?

随着今年初Sora的横空出世,这个可以创建长达一分钟视频的文生视频模型就成为了国内厂商追逐的焦点。6月初,快手自研的视频生成大模型“可灵”正式上线。可灵AI采用了与Sora相似的技术路线,能够生成具有合理运动和模拟物理世界特性的视频。截至目前,已有超百万人排队申请内测资格,其中超30万人已获得试用资格,累计生成超700万条短视频。近日,可灵AI终于宣布全面开放内测,同时上线付费会员体系。站长网2024-07-30 08:59:480000