UC伯克利研究人员推出Ghostbuster:用于检测 LLM 生成文本的最先进 AI 方法

划重点:

🔍 加州大学伯克利分校的研究人员开发了一种名为 Ghostbuster 的新方法,用于检测 LLM 生成的文本。

🧠 Ghostbuster 使用结构化搜索和线性分类的三阶段训练过程,表现出强大的性能。

📈 Ghostbuster 在不同数据集上均表现出色,优于 DetectGPT 和 GPTZero。

LLM,如 ChatGPT,可以轻松地产生各种流利的文本,但是它们的准确性有多高呢?语言模型容易产生事实错误和幻觉,这让读者在决定是否相信一个信息来源时知道是否使用了这些工具来做新闻文章或其他信息文本的幽灵写作。这些模型的发展也引发了对文本的真实性和原创性的担忧,许多教育机构也限制了 ChatGPT 的使用,因为内容很容易生成。

目前存在许多用于检测 LLM 是否生成内容的框架,如 DetectGPT 和 GPTZero。然而,这些框架在原本未经评估的数据集上的性能有所下降。

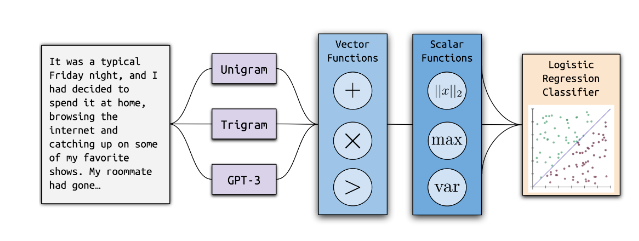

近日,加利福尼亚大学伯克利分校的研究人员推出了一种名为Ghostbuster的先进人工智能方法,旨在检测大型语言模型(LLM)生成的文本。这一方法基于结构化搜索和线性分类,通过三个阶段的训练过程,名为概率计算、特征选择和分类器训练,取得了显著的性能提升。

Ghostbuster首先将每个文档转换为一系列向量,通过在一系列语言模型下计算每个令牌的概率来实现。接下来,它通过在向量和标量函数空间上运行结构化搜索过程,选择特征。这些特征通过定义一组操作,将这些概率结合起来,并运行前向特征选择。最后,Ghostbuster在最佳的基于概率的特征和一些额外手动选择的特征上训练一个简单的分类器。

Ghostbuster的分类器是根据通过结构化搜索选择的基于概率的特征和基于词长和最大令牌概率的七个额外特征的组合进行训练的。这些其他特征旨在包含观察到的关于人工智能生成文本的定性启发。

在性能方面,Ghostbuster在训练和测试数据集相似性方面表现稳健。在所有条件下,Ghostbuster的F1分数平均达到97.0,比DetectGPT高出39.6,比GPTZero高出7.5。

Ghostbuster 在除创意写作领域以外的所有领域中优于 RoBERTa 基线,而 RoBERTa 的越域表现要差得多。F1分数是一种常用的衡量分类模型性能的指标。它将精确度和召回率结合成一个单一的值,特别适用于处理不平衡的数据集。

Ghostbuster的出现填补了在非原始评估数据集上性能不佳的检测框架的空白,为更可靠地判断LLM生成文本的真实性提供了新的工具。这对于那些依赖于AI生成内容做出决策的用户来说,具有重要的意义。

论文网址:https://arxiv.org/abs/2305.15047

官网博客:https://bair.berkeley.edu/blog/2023/11/14/ghostbuster/

为什么说DeepSeek是2025年的Kimi

DeepSeek是否能定义“低成本训练”概念?岁末年初,杭州的大模型创业公司“深度求索”DeepSeek不断放出大新闻。它所公布的一个开源模型DeepSeek-V3,在各种基准测试等方面,能够大致打平需要付钱的GPT-4o。而一个更重要的问题是,这是中国公司在受到制裁,算力有限,不能购买足够数量显卡的基础上,使用小数据集蒸馏等方法,而得到的一个更节省成本的模型。0000有人用SD生成照片骗过银行实名认证!推文浏览量已破400万

昨天一则关于利用SD生成可以欺骗银行等实名认证系统的手持身份照片的消息在社交媒体上引起了热议,原推文获得了400万次曝光。博主称,他将两个Lora模型结合在一起,并进行了实验,直到达到一致性和审美效果。其他人提到Faceswap更快,但作者还没有尝试过。站长网2024-01-05 18:31:370001AI时代新风口!吴恩达亲授智能体四大设计模式

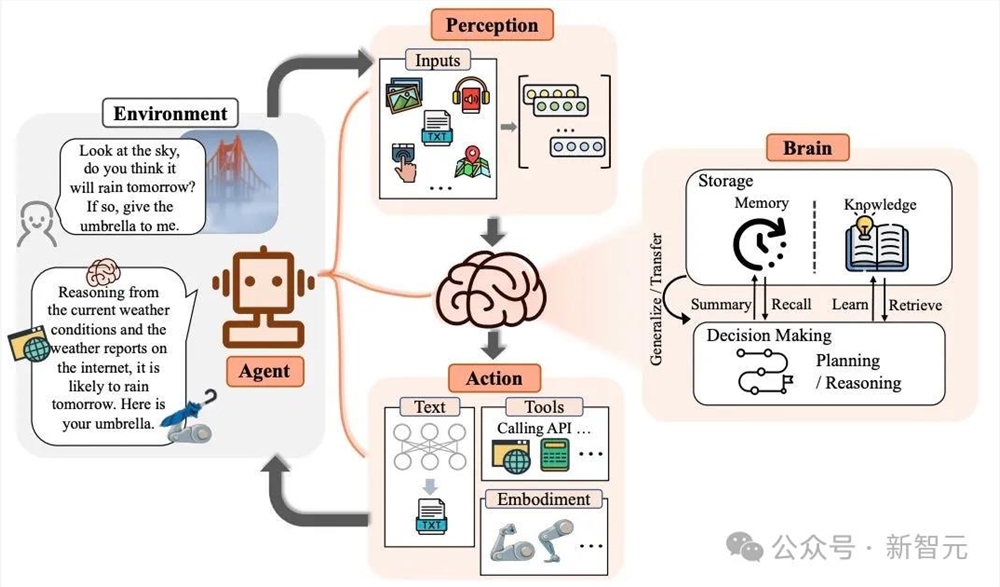

【新智元导读】吴恩达认为,智能体的发展将会成为AI时代重要的力量,甚至比基础模型还要重要。工作之余,「吴老师」连发多篇博客,向大家介绍了AI智能体的四大设计模式。AI时代的风口在哪里?吴恩达认为,AIAgent将在今年推动人工智能的大规模进步。——甚至,有可能超过下一代基础模型所带来的影响。他希望所有从事人工智能工作的人,都能关注AI智能体的发展。站长网2024-04-19 14:08:170002人工智能进入财务领域 最大的障碍仍是传统的 Excel

站长之家(ChinaZ.com)4月20日消息:对于那些风险规避型的会计师和首席财务官来说,改变是很难的。但是,随着人工智能和其他先进技术的出现,那些适应不了的财务官可能会发现自己越来越落后于时代。站长网2023-04-20 18:01:5800001stAI Machine:由Runway支持的AI生成视频硬件设备

1stAIMachine是一台由RunwayML软件支持的AI生成视频的硬件设备,由SGX和1stAveMachine的团队在马德里制作。该设备是一个原型,源于一个未成功的汽车广告概念,旨在将故事板和概念草图转化为具有独特风格的AI生成视频。站长网2023-11-14 16:50:390000