Vicuna Makers打造小型AI模型Llama-rephraser,130亿参数、性能媲美GPT-4

**划重点:**

1. 🌐 Vicuna Makers的研究团队成功构建了一个只有130亿参数的小型语言模型(LLM),在性能上与OpenAI的GPT-4相媲美。

2. 🔄 利用新工具LLM Decontaminator,研究人员通过改写测试集,使得LLM能够在主要基准测试中达到GPT-4的性能水平。

3. 🌟 Llama-rephraser的研发不仅在性能上取得突破,而且通过挑战对语言模型中数据污染的理解,为业务提供了性能与成本平衡的可能性。

Vicuna Makers的研究团队在构建Vicuna语言模型的基础上,成功推出了一款新型的小型人工智能模型(LLM),该模型在性能上与OpenAI的GPT-4相媲美,仅包含130亿个参数。

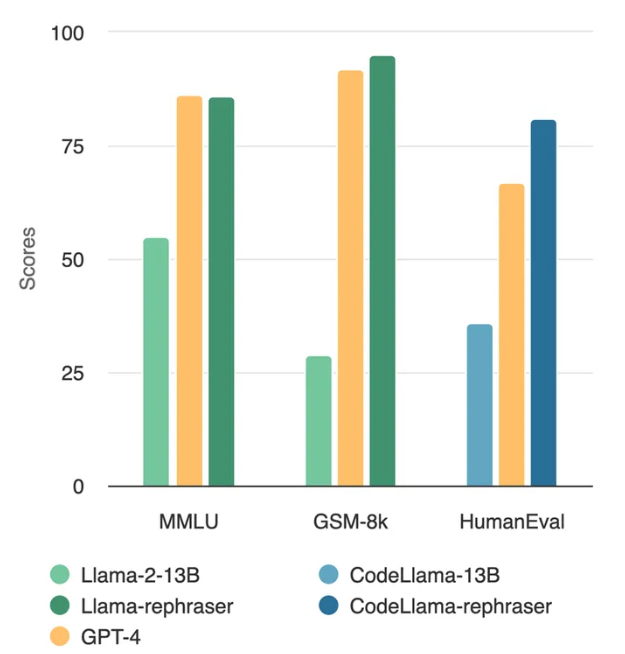

这一新模型被命名为Llama-rephraser,由LMSYS Org揭示。尽管规模相对较小,但该模型在主要基准测试中达到了GPT-4的性能水平。这一成就的关键在于团队采用了一种独特的方法:通过改写测试集,即对测试样本进行释义,使模型能够进行泛化并实现高性能。

通过在数据集中改变句子,Llama-rephraser不仅帮助模型记住文本,更能理解其含义。通过用变化的短语提示模型,研究团队验证了模型是否真正理解了材料。结果表明,Llama-rephraser能够返回正确的响应。

这一创新性的方法让这个拥有130亿参数的Llama-rephraser在基准测试中取得了GPT-4级别的成绩,包括涵盖基本数学、计算机科学、法律等多个领域的流行MMLU基准测试,以及人工评估模型代码生成的HumanEval基准测试。

这一研究的最大成就之一是挑战了对语言模型中数据污染的理解。数据污染指的是测试集的信息泄漏到训练集中,可能导致对模型性能的过于乐观的估计,尤其是对于一个只有130亿参数的模型能够达到GPT-4的成果。

在构建Llama-rephraser的研究过程中,他们发现类似CodeAlpaca的GPT生成的合成数据可能导致微妙的污染,这是难以检测的。为了解决这个问题,他们引入了一个名为LLM Decontaminator的新工具,用于量化数据集的释义样本与基准的对比,使开发人员能够估计数据集中释义样本的污染程度,并将其删除。

对于企业而言,这意味着在采用人工智能解决方案时,有必要使模型规模更小,以保持运营成本的低廉。像Llama-rephraser这样性能媲美GPT-4的小型模型的出现,有助于企业在性能和成本之间取得平衡。此外,LLM Decontaminator这样的工具还可以帮助企业完善其现有系统,使当前一代模型得以改进,而无需在开发成本上投入大量资金构建全新的模型。

LMSYS Org在博客文章中呼吁社区重新思考在大型语言模型背景下的基准测试和数据污染,并在对大型语言模型进行公共基准测试时采用更强大的去污染工具。

AWS推出“AI Ready”计划,到2025年免费为200万人提供技能提升

**划重点:**1.🚀AWSIndia推出“AIReady”计划,旨在到2025年为2百万人提供免费AI培训,以满足不断增长的对AI人才的需求。2.💼由AWS的数据与AI副总裁SwamiSivasubramanian领导,“AIReady”旨在为现有和未来的劳动力提供易于接触的AI教育。站长网2023-11-23 16:31:140000VanceAI发布了一款图像生成器 可轻松生成电商产品图

划重点:📷VanceAI发布AI产品图像生成器,包括AI背景生成器等功能。🛒VanceAI背景生成器现在可以生成精美的产品特定场景图像。🔜即将推出更多面向电子商务的AI功能,包括AI素描转图像生成器、AI时尚模特生成器和AI图像变化生成器。站长网2023-11-02 16:24:130000视频号开卷本地生活

近日(4月23日),视频号官方正式发布公告称,本地生活行业商家可申请入驻【本地生活】业务类型的视频号小店。在去年,陆陆续续有商家收到视频号本地生活业务的内测邀请,而在现在,视频号终于对外全面上线。具体内容如下:01开店规则一、本地生活行业准入资质规则视频号官方将准入资质规则划分为单店入驻资质标准以及连锁入驻资质标准。站长网2024-04-26 04:35:240000SpaceX星舰第三次试飞任务提前结束 马斯克称星舰让生命多行星化

国外媒体近日报道,人类最强火箭“星舰”的第三次试飞任务已提前结束,而失去信号的它很可能已经解体。据了解,“星舰”在此次试飞中同时失去了与SpaceX的互联网服务Starlink以及TDRSS(跟踪和数据中继卫星系统)的通信联系。这种双重失联的情况,让人不禁猜测“星舰”可能遭遇了严重的解体。站长网2024-03-15 08:21:460000电影院「副业」进击:映前广告大降价、遍地都是按摩椅

“现在哪还有影城只靠票房,无论小影城大影城,都在推非票。”广东某影院经理李明告诉「深响」。所谓非票,是指电影票房之外的如爆米花、饮品等卖品,影院广告,以及按摩椅、娃娃机、唱吧机等娱乐消费设施带来的收入。影院的非票收入其实是老生常谈的话题,但电影市场在经历了“大落大起”后,不少影城意识到多种经营的重要性,纷纷谋划观影之外的衍生收入,非票在当下也有了新的变化与升级。站长网2023-08-10 15:56:440000