微软研究员推LoRAShear技术:高效对大语言模型结构化剪枝

划重点:

- 🚀 LoRAShear:一种高效的LLMs结构化剪枝与知识恢复方法。

- 🧠 LLMs:快速处理文本数据,助力搜索引擎和问答系统。

- 💡 知识更新:微软研究人员提出结构剪枝方法,提高知识保存率。

微软的研究人员近日推出了一项名为LoRAShear的创新技术,旨在剪枝大型语言模型(LLMs)并实现知识的高效恢复。LLMs在处理文本数据和迅速检索相关信息方面表现出色,广泛应用于搜索引擎和问答系统。这项技术的问世将有望帮助用户更轻松地找到所需信息,极大地促进了人工智能的发展。

在LLMs的日常维护工作中,知识的更新和恢复是至关重要的任务之一。目前,一种常见的知识更新方法是通过精细调整(fine-tuning)。开发人员可以取得一个预训练的模型,然后在特定数据集上进行精细调整,从而更新其知识。这使得模型能够了解最新事件或特定领域的信息,为研究人员和专业人士提供了有力的工具。

微软的研究人员在这一领域取得了新的突破,他们开发了LoRAShear技术,这是一种高效的LLMs剪枝与知识恢复方法。所谓的“剪枝”是指通过移除或减少神经网络架构中的某些组件或元素,从而使其更加高效、紧凑和计算要求更低。

LoRAShear采用了Lora Half-Space Projected Gradient(LHSPG)方法,实现了渐进式结构剪枝,实现知识的高效传递,同时引入了动态知识恢复阶段,使其在预训练和指导性微调的方式下执行多阶段的精细调整。

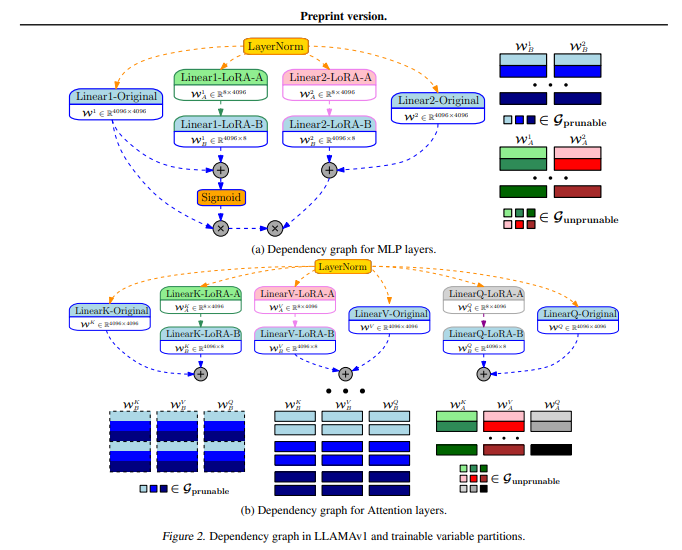

研究人员表示,LoRAShear技术可以应用于通用的LLMs,通过分析LLMs与LoRA模块的依赖图,实现结构剪枝和知识恢复。他们提出了一种独特的算法,用于创建原始LLMs和LoRA模块的依赖图,还引入了一种结构稀疏优化算法,利用LoRA模块的信息来更新权重,从而提高了知识的保存率。

LoRAPrune技术将LoRA与迭代结构剪枝相结合,实现了高效的参数微调和直接硬件加速。他们表示,这种方法在内存使用效率上非常高,仅依赖于LoRA的权重和梯度来进行剪枝标准。

研究人员通过在开源LLAMAv1上实施LoRAShear技术来证明其有效性,他们发现,20%的LLAMAv1剪枝后,性能下降了1%,而50%的剪枝模型在评估基准上保持了82%的性能。

尽管LoRAShear技术在LLMs的知识恢复方面取得了显著的进展,但仍然面临着大规模计算资源的需求和缺乏预训练和指导性微调数据集的挑战。未来的工作将集中在解决这些挑战,为人工智能领域的发展提供更多的支持。

论文网址:https://arxiv.org/abs/2310.18356

没电话卡也没装支付宝,孩子还能为手游充值万余元?游戏方回应了

近年来,未成年人手游充值问题成为不少家长的困扰,泉州的陈女士就是其中之一。未成年人充值手游频繁选择“最高消费”今年5月初,陈女士的丈夫突然收到一条扣款提醒,账单显示向广东欢太科技有限公司支出648元。陈女士顺着这条扣款信息往前一查,发现从4月份开始,丈夫的支付账户上陆续有51笔转向该家公司的开支,金额更是高达18232元。站长网2023-05-24 07:58:520000真全面屏迈入1.5K分辨率时代!曝中兴首发新一代屏下前摄方案

快科技12月2日消息,对于追求真全面屏”的用户来说,屏下前摄无疑是最好的解决方案;不过遗憾的是,目前绝大部分厂商都使用的是挖孔屏,苹果还在使用胶囊屏”,国内坚持在自家手机上采用屏下镜头的只有中兴系一家。博主数码闲聊站透露,中兴系正在测试1.5K高分辨率前摄方案,屏幕供应商是京东方,明年正式商用。相比行业主流的1.5K、2K挖孔屏方案,目前商用的屏下前摄技术,其屏幕分辨率还不到1.5K。0000快手:严厉打击借欧洲杯赛事传播赌球、诈骗信息行为

近日,快手发布关于严厉打击借欧洲杯赛事传播赌球、诈骗信息的公告称,为倡导风清气正的社区氛围,保障用户财产安全,快手将针对欧洲杯赛事期间的各类赌博、诈骗行为开展专项治理,通过加固识别策略、丰富处置维度等方法加强对相关违法违规行为和不良内容的打击。快手称,平台严厉打击通过引流或欺骗性手段骗取其他用户信任,将用户引导至站外平台进行赌球或诈骗的行为,包括但不限于:站长网2024-06-21 16:44:050000深圳充电宝收费统一标准:免费时长不少于5分钟

快科技3月12日消息,虽然共享充电宝在外使用很方便,但越来越贵的价格也让很多人望而却步,成为明码标价新型刺客”。日前,深圳市消费者委员会发布《深圳市共享充电宝行业自律公约》。要求商家承诺,充电宝租借免费时长不少于5分钟;租借的计价时间单位不超过半小时;因所在地难以及时归还充电宝时,企业核实后可暂停计费等内容。站长网2024-03-12 12:06:110001赚钱,其实就是卖一个机会。

各位村民好,我是村长。互联网上有许多赚钱的项目,但不管是社群、搞淘客、搞微商、搞社交电商还是搞抖客、搞抖音、搞IP培训,本质上都是在卖一个机会。今天你若能把这个道理想明白了,你在今后做许多项目,不管是招商加盟、亦或是写作、做社群、搞培训、招徒弟等,你就明白了赚钱的内核。01大多数人都在找机会很多人也许对这个概念理解的不够深刻或者说不够直观,我们以现实生活中的例子来和大家分析。0001