亚马逊 AWS 推出 Amazon EC2 Capacity Blocks 服务,为人工智能项目提供按需 Nvidia H100 GPU 资源

站长网2023-11-02 16:54:470阅

为了解决大型语言模型运行所需的 GPU 资源短缺问题,亚马逊 AWS 今日推出了 Amazon Elastic Compute Cloud (EC2) Capacity Blocks for ML 服务。该服务允许客户按照定义的时间购买 Nvidia H100 Tensor Core GPU 资源,用于执行特定的 AI 相关任务,如训练机器学习模型或运行现有模型的实验。

AWS 的 Channy Yun 在博客中写道:「这是一种创新的 GPU 实例调度方式,您可以预订未来日期所需的实例数量,仅按您需要的时间长度计费。」

客户可以按集群大小购买 1 至 64 个实例,每个实例含 8 个 GPU,并可预订最长 14 天的使用时间,最多可提前 8 周预订。预定时间结束后,实例将自动关闭。

这种新的购买方式让客户能够像预订酒店房间一样,预定一段时间内所需的实例数量。这种方式为客户提供了成本确定性,他们将清楚地知道任务的运行时长、需要使用的 GPU 数量以及前期的费用。

对于亚马逊来说,它们可以在类似拍卖的环境中投放这些炙手可热的资源,确保收入(前提是有客户购买)。资源的价格将根据供需关系动态变化。

用户在注册该服务时,系统会显示预定时间和资源的总成本。用户可以根据自己的资源需求和预算来调整这个数字,然后再决定是否购买。

该新功能从今天开始在 AWS 美国东部(俄亥俄州)区域提供。

0000

评论列表

共(0)条相关推荐

Google 升级安全浏览功能:实时 URL 检查和 AI 增强保护帮助 Chrome 用户避开恶意网站

站长之家(ChinaZ.com)3月16日消息:Google日前宣布升级其Chrome安全浏览保护功能(SafeBrowsing),将实时检查用户访问的网址URL为Chrome浏览器用户提供防护,以避免访问恶意网站。安全浏览旨在通过与一个主列表比对URL,以防范网络钓鱼攻击、恶意软件和不需要的软件。站长网2024-03-16 11:18:400000淄博烧烤北京“变形记”

2023年春天,淄博一跃成为互联网世界的“顶流”城市。年轻人涌向淄博,把烧烤店老板吓得不敢开门;以淄博为名的烧烤店也在反向涌入一线城市,试图用这个春天的热度,兑换成实打实的营业额。距离淄博400多公里的北京,以淄博烧烤为名的新店陆续开张营业,成为这股热潮在异地的验证。站长网2023-05-09 10:56:330000日本岸田首相将宣布国际框架,规范生成式人工智能

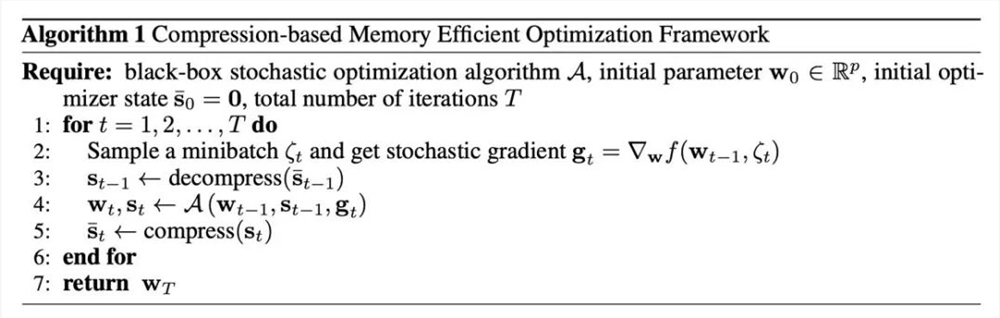

划重点:⭐️岸田首相将在经济合作与发展组织会议上宣布国际框架,规范和使用生成式人工智能。⭐️日本旨在在创建国际人工智能规则方面取得领先地位,预计将有40多个国家参与。⭐️国际框架将邀请各国支持广岛人工智能进程成果,呼吁全球人民安全、可靠地使用人工智能。站长网2024-04-25 21:40:590000LLaMA微调显存需求减半,清华提出4比特优化器

大模型的训练和微调对显存要求很高,优化器状态是显存主要开销之一。近日,清华大学朱军、陈键飞团队提出了用于神经网络训练的4比特优化器,节省了模型训练的内存开销,同时能达到与全精度优化器相当的准确率。4比特优化器在众多预训练和微调任务上进行了实验,在保持准确率无损的情况下可将微调LLaMA-7B的显存开销降低多达57%。论文:https://arxiv.org/abs/2309.01507站长网2023-09-08 18:15:500000新视频分割技术SAM 可高效识别移动物体

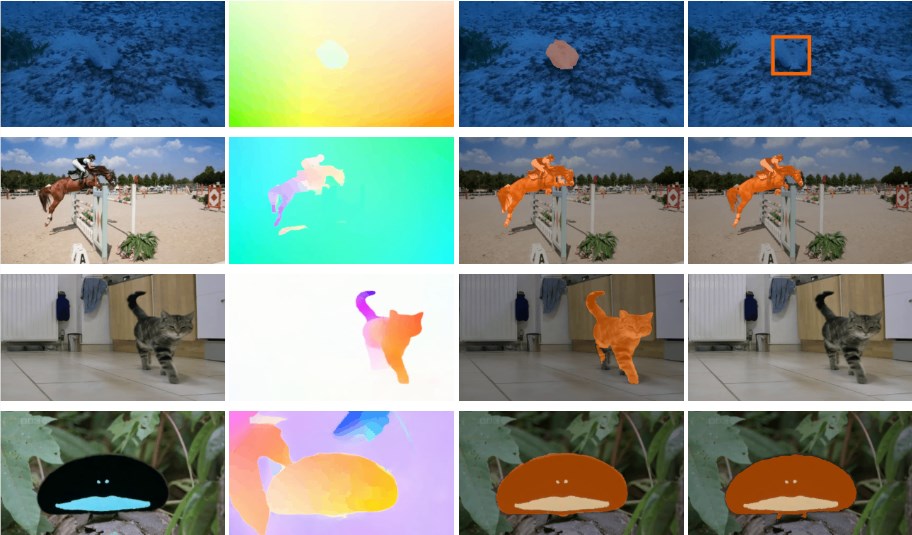

在视频分割领域,SegmentAnything模型(SAM)被用于探索新的视频对象分割技术。研究团队测试了两种不同的模型,旨在结合SAM的分割能力和光流技术的优势,以提高视频分割的性能。站长网2024-04-23 15:11:250001