英伟达发布430亿参数大模型ChipNeMo

站长网2023-11-01 09:21:040阅

要点:

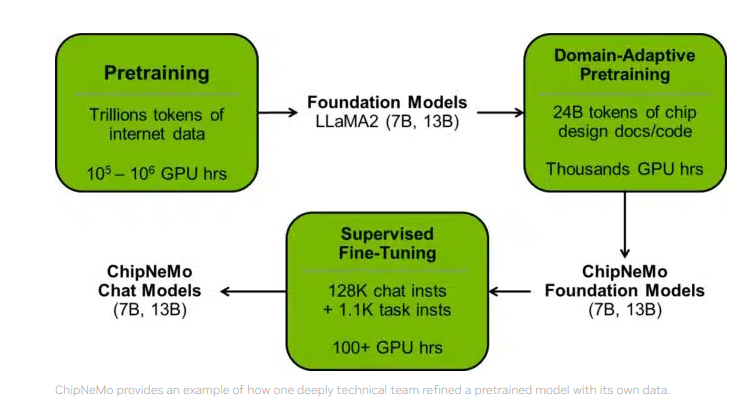

1. 英伟达发布了拥有430亿参数的大语言模型ChipNeMo,专注于辅助芯片设计,提高工作效率。

2. ChipNeMo支持问答、EDA脚本生成、Bug总结和分析等任务,帮助芯片设计师完成工作。

3. ChipNeMo的研发采用了领域自适应技术,提升了性能并减小模型大小。

英伟达最新发布的430亿参数大语言模型ChipNeMo专注于辅助芯片设计,旨在提高工程师的工作效率。这一大语言模型的应用范围广泛,包括问答、EDA脚本生成和Bug总结等任务,使芯片设计变得更加便捷。

英伟达首席科学家Bill Dally强调,即使提高生产率的幅度不大,使用ChipNeMo仍然是值得的。ChipNeMo的数据集包括Bug总结、设计源、文档以及硬件相关的代码和自然语言文本,经过数据采集、清洗和过滤后,共有241亿个token。

英伟达采用了领域自适应技术,包括自定义标记器、领域自适应持续预训练、带有领域特定指令的监督微调等方法,以提升大语言模型在工程助理聊天机器人、EDA脚本生成和Bug摘要和分析等领域的性能。

结果显示,这些领域自适应技术不仅提高了性能,还减小了模型大小,但仍有改进空间。英伟达的这一举措标志着大语言模型在半导体设计领域的应用迈出了重要的一步,为专业化领域提供了有用的生成式AI模型。

0000

评论列表

共(0)条相关推荐

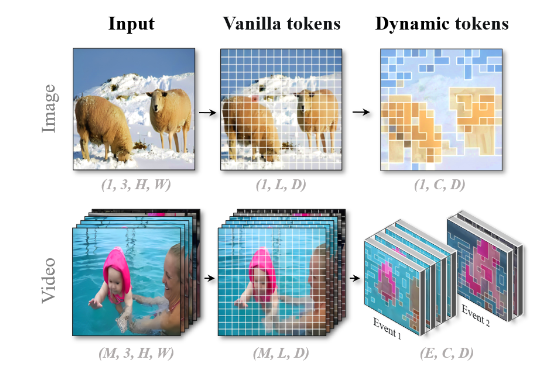

北大提出统一的视觉语言大模型Chat-UniVi 3天训练成果惊艳众人

要点:北大和中山大学研究者提出的Chat-UniVi是一种统一的视觉语言大模型,能够在统一的视觉表征下同时处理图片和视频任务,且仅需三天训练即可获得130亿参数的通用视觉语言大模型。Chat-UniVi采用动态视觉token来统一表示图片和视频,通过最近邻的密度峰聚类算法获取动态视觉token,多尺度表征提高了模型的性能,使其在图片和视频的各种任务中取得卓越性能。站长网2023-11-29 14:42:290003老黄一口气解密三代GPU!粉碎摩尔定律打造AI帝国,量产Blackwell解决ChatGPT全球耗电难题

【新智元导读】刚刚,老黄又高调向全世界秀了一把:已经量产的Blackwell,8年内将把1.8万亿参数GPT-4的训练能耗狂砍到1/350;英伟达惊人的产品迭代,直接原地冲破摩尔定律;Blackwell的后三代路线图,也一口气被放出。就在刚刚,老黄手持Blackwell向全世界展示的那一刻,全场的观众沸腾了。它,是迄今为止世界最大的芯片!眼前的这块产品,凝聚着数量惊人的技术站长网2024-06-03 15:36:170000OPPO Reno10系列今日开售 标配长焦镜头售价2499元起

OPPO官方宣布,OPPOReno10系列,今日开售,至高24期分期免息。OPPOReno10系列包括了Reno10、Reno10Pro、Reno10Pro三款手机。分别搭载骁龙778G、天玑8200、骁龙8处理器。据悉,OPPOReno10全系列标配长焦镜头,标准版和Pro版本上搭载了3200万超光影长焦镜头;Pro版本则搭载6400W超光影潜望长焦。站长网2023-06-01 16:39:400000英国育儿论坛Mumsnet用OpenAI技术创建了AI聊天机器人

本文概要:1.育儿论坛MumsnetOpenAI技术创建了一个AI聊天机器人,名为MumsGPT,可用于分析网站上用户留下的评论和帖子。2.MumsGPT将用于指导决策者在育儿问题上并为广告商提供更精准的营销目标。3.MumsGPT目前只是一个研究工具,但未来可能对公众开放。站长网2023-08-22 14:14:320000大模型混战背后:科技“食物链”顶端是否会出现新霸主?

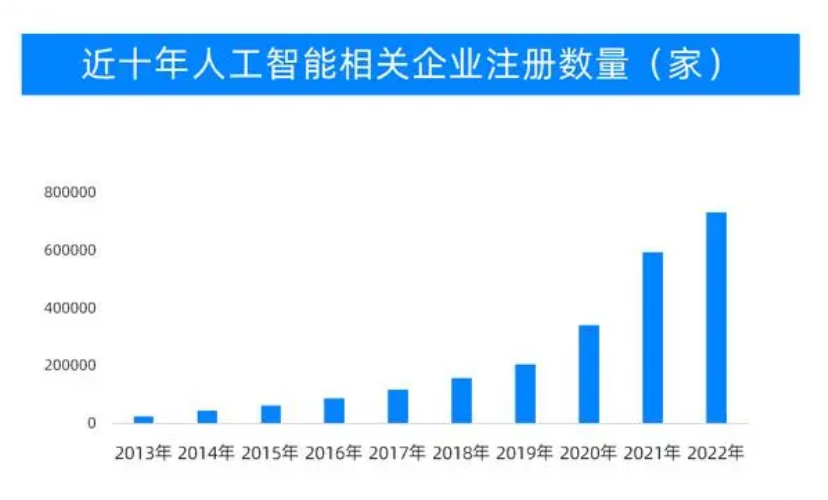

如果说,现在的我们正处于一个巨大的软件互联网生态系统中。那么,未来我们或许会进入一个巨大的人工智能互联网生态系统。从谷歌的阿尔法狗到OpenAI的ChatGPT,人工智能掀起了一波新的狂欢,国内的互联网科技圈的“颠覆”暗潮也在不断涌动。新诞生的AI大模型越来越多,“参战”AI大模型的玩家也有些数不过来。站长网2023-05-25 17:18:370000