AgentTuning:通过多智能体任务调整语言模型

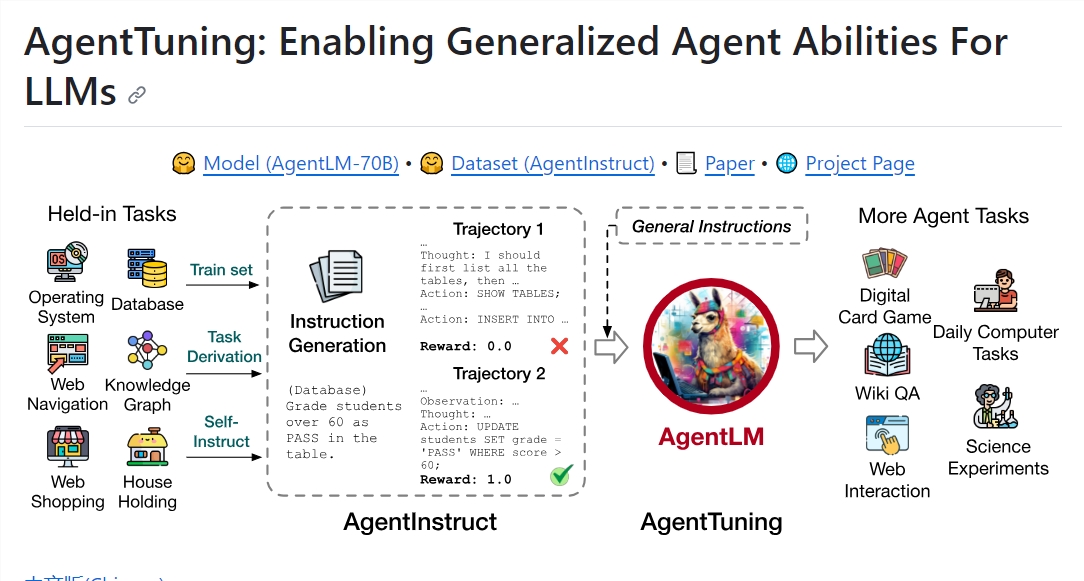

最近,研究人员在 GitHub 上开源了一个名为 AgentTuning 的项目。该项目提供了一种新的方法来调整语言模型,通过多个智能体任务中的交互轨迹来训练和调整语言模型,以更好地适应不同的任务和场景。

这种方法可以提高语言模型的效果和泛化能力,同时减少手动调整的工作量。AgentTuning 已经在对话生成、问答系统、摘要生成等多个自然语言处理任务中得到了验证。需要注意的是,这种方法不仅适用于语言模型,也适用于其他类型的模型。

项目地址:https://github.com/THUDM/AgentTuning

主要功能:

AgentInstruct数据集:AgentInstruct是一个经过精心筛选的数据集,包括1,866个高质量互动场景,旨在提升AI代理在6个不同的现实世界任务中的性能。这些场景覆盖了从日常家庭事务到数据库操作的6个不同领域,具有5到35个平均回合数,确保了多样性和复杂性。

AgentLM模型:AgentLM模型是通过对AgentInstruct数据集和Llama2-chat系列的ShareGPT数据集进行混合训练而创建的。这些模型遵循Llama-2-chat的对话格式,其中系统提示已固定为“您是一个有帮助、尊重和诚实的助手”。AgentLM提供了7B、13B和70B模型,可以在Huggingface模型库上获取。

快速部署:AgentTuning使用文本生成推理技术加速评估过程,用户可以轻松地启动AgentLM-70B实例,并在端口30070上访问客户端。这使得用户能够快速生成文本响应。

全面的评估:AgentTuning提供了6个“持有”任务和6个“持有外”任务的详细评估信息,以验证AgentLM的性能。这些任务来自不同的框架,包括SciWorld、MiniWoB 、HotpotQA、ReWOO、WebArena和数字卡牌游戏,涵盖了各种任务类型。

引用支持:如果用户发现AgentTuning的工作对他们有用,他们可以引用相关论文,为团队的努力提供支持。

总的来说,AgentTuning是一个具有巨大潜力的项目,为改善LLMs的通用智能能力提供了重要的工具和资源。通过AgentInstruct数据集和AgentLM模型,用户可以在各种现实世界任务中获得更强大的AI代理,同时保持良好的通用语言能力。

Doly:让你可以用iPhone 生成3D产品视频

划重点:-📱AniML推出的Doly应用帮助用户使用手机生成3D模型并制作专业的产品视频。-🤖Doly利用高斯光斑技术将2D图像转换为逼真的3D模型,采用了新兴的神经网络技术。-💰AniML已经获得200万美元的种子轮融资,吸引了多家投资者,包括知名天使投资人。站长网2024-05-28 19:35:430000辛巴抖音账号被封 页面显示违反自律公约相关规定

近日,有网友发现抖音平台对知名网红辛巴的账号进行了封禁。在被封禁之前,辛巴在抖音上拥有高达415万的粉丝。据悉,辛巴的账号被封禁的原因是他屡次发布不实信息并参与拉踩引战。据知情人士透露,辛巴曾在直播中发表不当言论,对平台和其他主播进行侮辱和谩骂,并参与拉踩引战。除了在抖音上多次被封禁,辛巴在快手上也遭遇过类似的情况。站长网2023-11-02 14:51:340000在淘宝,山寨机永不落幕

辩证看,山寨机十多年来依旧存在,自然有它存在的理由。但并不意味着,消费者对产品质量好坏,甚至是否假冒伪劣没有要求。“6.5英寸高清屏、灵动岛前摄、7800mAh电池、双卡多模、4800W像素……”如果仅看淘宝天猫上宣传,这部558元起,月销500的“23款14promax”手机,外形与iPhone14promax几乎一样,硬件堆料也相当吸引人,甚至不输给很多主流品牌。站长网2023-07-27 10:50:330000知网与华为成立人工智能联合创新实验室 共创“华知”大模型

8月20日,同方知网与华为公司联合筹建的人工智能联合创新实验室在知网总部揭牌成立。知网表示,双方将充分发挥各自优势,积极开展联合创新和技术攻关,共建人工智能联合创新实验室,共创“华知”大模型,重点研究大模型在知识服务领域的应用,合作开发各类行业大模型和场景大模型,力争实现人工智能关键核心技术的突破和赶超,更好地服务我国科技创新跨越式发展。站长网2023-08-25 16:16:000000苹果发布iOS18.1正式版:iPhone能通话录音了

苹果公司今日推送了iPadOS18.1的正式版更新,继iOS18之后,这是一次重大的系统升级。海外用户期待已久的AppleIntelligence功能终于面向iPhone15Pro、iPhone16全系列等机型正式上线。站长网2024-10-29 12:08:290002