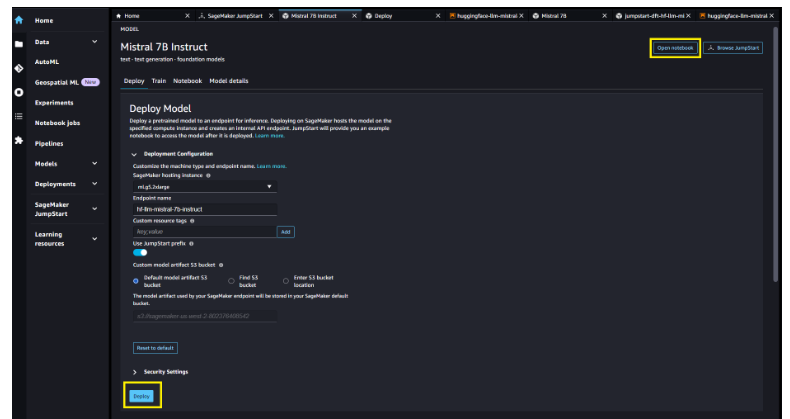

亚马逊机器学习团队推出 Mistral 7B 基础模型 支持8000个token上下文长度

文章概要:

- Mistral7B 是Mistral AI开发的英文文本和代码生成基础模型,参数规模70亿。

- SageMaker JumpStart提供一键部署Mistral7B进行推理,可快速自定义。

- Mistral7B具有8000个token的上下文长度,表现低延迟和高吞吐量。

亚马逊机器学习团队近日宣布,Mistral AI开发的Mistral7B基础模型现已在亚马逊SageMaker JumpStart上提供,用户可以通过该平台一键部署模型进行推理。

Mistral 7B是Mistral AI开发的英文文本和代码生成基础模型,拥有70亿个参数,支持文本摘要、分类、文本补全和代码补全等多种用例。为展示模型的易于自定义性,Mistral AI还发布了Mistral7B Instruct对话模型,使用各种公开对话数据集进行了优化。

Mistral 7B采用transformer架构,通过grouped-query attention和sliding-window attention实现更快的推理速度和处理更长序列的能力。该模型具有8000个token的上下文长度,表现出低延迟和高吞吐量,与更大模型相比性能出色,参数量只有70亿,显存需求较低。Mistral7B基于宽松的Apache2.0许可发布,可无限制使用。

亚马逊SageMaker JumpStart是一个机器学习中心,提供各种预训练好的算法和模型,用户可以快速上手机器学习。现在,用户可以通过几次点击在SageMaker Studio中发现并部署Mistral 7B,或者通过SageMaker Python SDK以编程方式部署,利用SageMaker的各项功能如管道、调试器对模型性能及MLOps进行控制。模型部署在AWS安全环境下、用户的VPC控制之中,有助于确保数据安全。

SageMaker JumpStart为机器学习从业者提供了越来越多性能最好的基础模型。它们帮助降低训练和基础设施成本,并支持自定义以适应特定用例。

总结Mistral7B的主要特色功能点大致如下:

1. 参数规模达70亿,支持多种自然语言处理任务。Mistral 7B是一个具有70亿参数的基础模型,支持文本摘要、分类、补全等多种英文NLP任务。

2. 推理速度快,具有8000个token的上下文长度。Mistral 7B使用了transformer架构,可以实现低延迟和高吞吐量推理,支持长达8000个token的上下文长度。

3. 易于部署使用,提供一键体验。用户可以通过Amazon SageMaker JumpStart一键部署Mistral7B,并便捷获得其推理服务,无需训练即可使用。

4. 模型开源,基于Apache2.0协议。Mistral7B的模型权重已在宽松的Apache2.0许可下开源,用户可以无限制地使用。

SageMaker JumpStart体验网址:https://aws.amazon.com/cn/sagemaker/jumpstart/

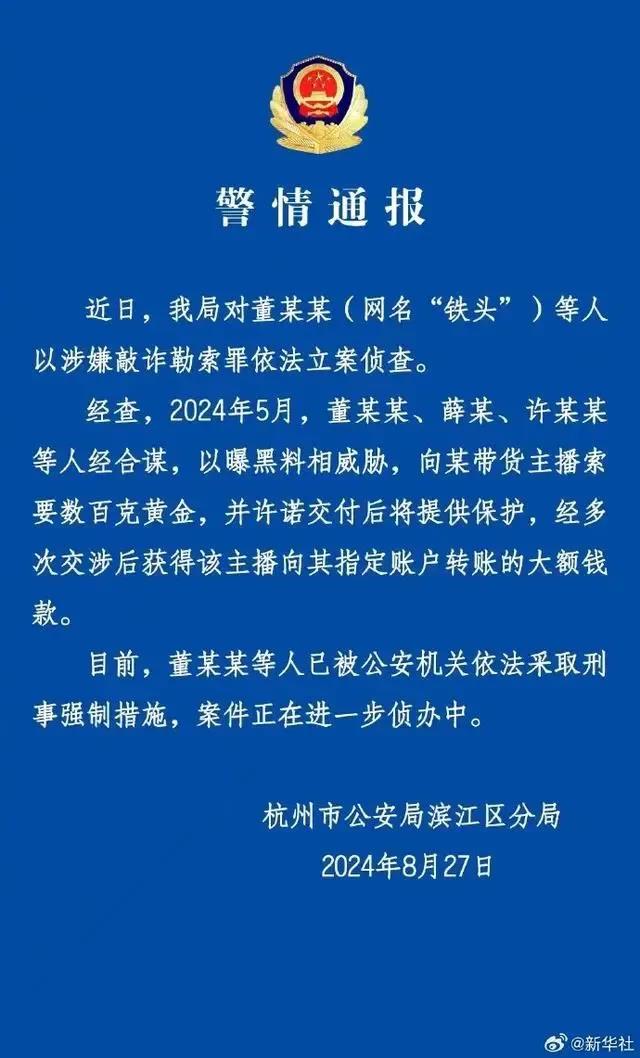

当打假网红被打假

打假网红铁头,终于迎来了人生中最大的一次翻车。8月27日,杭州市公安局滨江区分局通报,已对董某某(网名“铁头”)等人以涉嫌敲诈勒索罪依法立案侦查。在此之前,铁头就曾因在直播间自曝涉黄而遭遇全网封禁。被封禁后不久,铁头还曾奔赴日本整了一个颇具争议性的“大活”。但如今,铁头再度被人看见,已经是出现在一张蓝底白字的通告里。站长网2024-09-05 16:50:440000iPhone15Pro系列满意度创新低 用户满意度下滑至72%

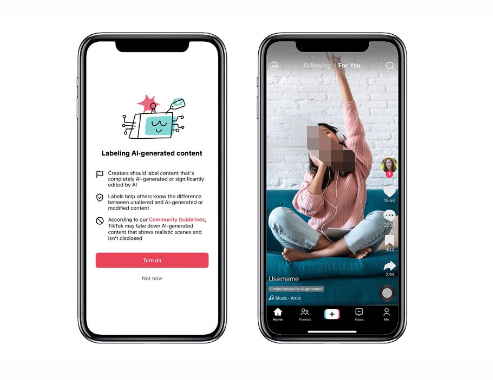

据调查机构PerfectRec收集的69.5万条用户评价显示,iPhone15Pro系列机型的满意度正逐渐下滑,只有72%的用户打出五星好评。相比之下,iPhone13Pro机型的满意度最高,有84%的人打出了五星好评。iPhone14Pro机型的满意度为76%,而iPhone15Pro的表现甚至低于74%的iPhone8,创下历史新低。站长网2023-10-25 09:38:140001TikTok 推出了一种标记人工智能生成内容的方法

文章概要:1.TikTok将推出标记AI生成内容的方法,要求创作者在相关的视频和照片上使用该标签。2.公司还将更名使用AI工具的滤镜和效果,在名称中包含“AI”。3.TikTok希望通过这些举措提高内容的透明度,确保观众了解何时使用了人工智能工具。TikTok最近宣布引入一种新方式,以标记和识别使用人工智能工具制作的内容。该举措旨在增强内容的透明度,让观众了解何时使用了AI技术。站长网2023-09-20 14:57:190000抖音治理通过虚构资质等“仿冒假冒账号” :7月1日起生效

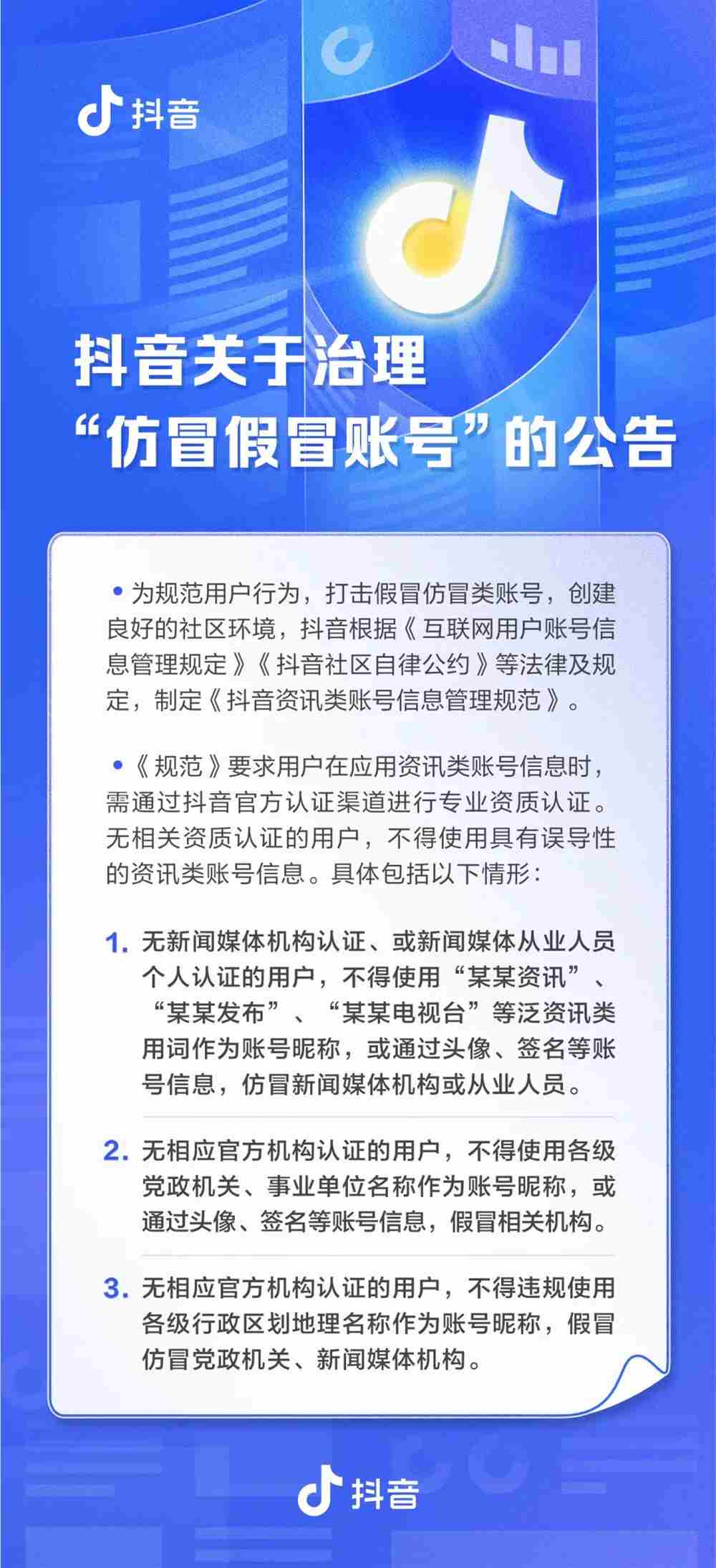

日前,抖音关于治理“仿冒假冒账号”的公告称,有部分自媒体账号,通过“仿造昵称”“虚构资质”等形式,假冒仿冒官方机构、新闻媒体或其他专业资质类从业人员,发布误导性内容。站长网2023-06-22 11:27:210000高德地图功能升级:无灯路口有来车能提醒了

快科技6月8日消息,高德地图今日宣布带来独家功能升级,车道级安全预警功能覆盖了10大安全风险较高的行车场景。升级点如下:前方有车辆急刹:当道路上有车辆出现急刹行为的时候,可在第一时间通知其后方用户注意,预防因急刹产生的追尾事故,提升行车安全。无灯路口有来车:实时监测路口盲区来车情况,精准预知货车、快速车的会车风险。站长网2024-06-11 17:13:120000