揭开多模态神经元的秘密:从 Molyneux 到 Transformers 的过程

要点:

1. Transformers是人工智能领域最重要的创新之一,通过自注意机制实现并行处理,从而能够捕捉信息序列中的隐藏关系,加速训练并提高性能。

2. 通过跨模态任务,人工神经网络在语言和视觉等领域展现出强大的潜力,能够集成不同感官输入,取得出色的性能。

3. 最新研究表明,多模态神经元在Transformer模型中出现,可以处理图像和文本信息,对于实现多模态理解具有重要作用,对于游戏策略预测到蛋白质设计等多个任务具有广泛的应用前景。

近年来,Transformers成为了人工智能领域最重要的创新之一。这种神经网络架构于2017年推出,彻底改变了机器理解和生成人类语言的方式。

与它们的前身不同,Transformers依靠自注意机制并行处理输入数据,使它们能够捕捉信息序列中的隐藏关系和依赖性。这种并行处理能力不仅加速了训练时间,还为开发具有高度复杂性和性能的模型打开了道路,比如著名的ChatGPT。

论文地址:https://arxiv.org/pdf/2308.01544.pdf

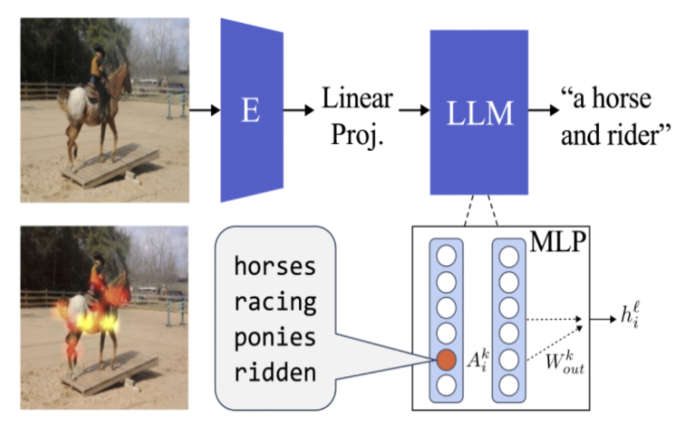

近年来,我们已经看到人工神经网络在各种任务中的出色表现。它们改变了语言任务、视觉任务等领域。但真正的潜力在于跨模态任务,它们整合了各种感觉模态,如视觉和文本。这些模型已经通过额外的感觉输入进行增强,在需要理解和处理来自不同信息源的任务上取得了令人印象深刻的性能。

这一研究揭示了深度网络中个体单元内部运作的丰富信息。正如图像分类器中的卷积单元可以检测颜色和图案,随后的单元可以识别物体类别一样,Transformers中出现了多模态神经元。这些神经元对具有相似语义的图像和文本具有选择性。

此外,即使视觉和语言分别学习,多模态神经元仍然可以出现。它们能够有效地将视觉表示转化为连贯的文本。这种在不同模态之间对齐表示的能力具有广泛的影响,使语言模型成为各种需要序列建模的任务的强大工具,从游戏策略预测到蛋白质设计。这一研究不仅揭示了多模态模型的内部机制,还为机器跨模态理解和生成提供了深刻的见解。这有望推动人工智能在多模态智能应用中的发展。

华为手机回来了!曝麒麟芯片回归:首发机型成悬念

快科技7月24日消息,由于众所周知的原因,在Mate40系列之后,华为新机基本都是骁龙芯片,自家麒麟芯片几乎绝版”,只有偶尔在官方部分翻新机上才能看见老款麒麟芯片的身影。麒麟芯片无法迭代,对华为手机业务确实造成了一些影响,不过,情况似乎在慢慢好起来,麒麟芯片或将重出江湖。今日,数码博主数码闲聊站”发文称麒麟芯片回归”,虽然该博主没有再透露更详细的内容,但对消费者来说,这已经是个重磅的好消息。站长网2023-07-25 12:20:4000016倍溢价,亏损百万,珠宝直播谁在暴富?

“停不下来,根本停不下来”,最近入坑珠宝直播间的刘静,半个月购买了10条水晶项链。尤其是,直播间的秒抢产品就像“抓娃娃”游戏一样,激发她的好胜心,五彩斑斓的首饰,吸引她不断下单。0000华为鸿蒙智行宣布问界M9上市7个月大定超11万台

7月19日,鸿蒙智行宣布其问界旗舰SUV车型M9自上市以来7个月的订单量已超过11万台,这一成绩使其在50万元以上价格区间的所有车型和动力形式中销量排名第一。截至7月14日的数据显示,问界M9在今年已交付6.13万台,目前还有近5万台的订单储备。客户对M9的忠诚度非常高,他们宁愿等待也不愿意选择其他品牌的车型。站长网2024-07-20 03:30:390000百度AI原生应用开发工作台“千帆AppBuilder ”全面开放

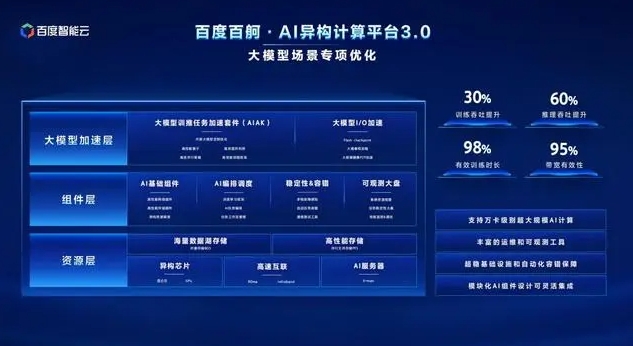

百度智能云于12月20日举办的2023百度云智大会・智算大会上发布了20多款全栈产品,旨在重构云计算服务以满足大模型落地需求。会议以「大模型重构云计算,CloudforAI」为主题,探讨大模型引发的云计算变革。百度智能云已完成从底层基础设施到大模型开发与应用再到AI原生应用开发的端到端升级重构。站长网2023-12-21 08:36:170000抢「.AI」域名,成了 3000 万美元的大生意

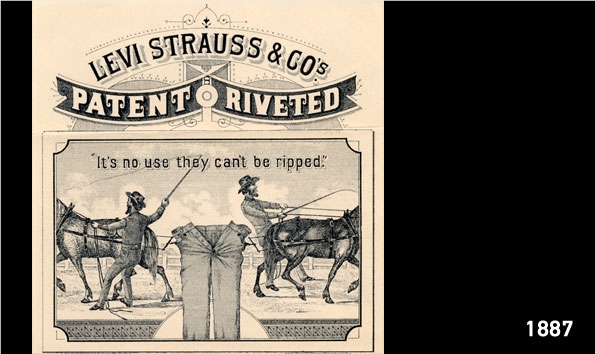

1848年,一个木匠在加利福尼亚州科罗马地区的一条河中偶然发现了金箔。尽管他曾试图保守这个秘密,但是金子不会说谎,一场席卷全美的淘金热就此开始,许多人怀揣着一夜暴富的梦想涌入加利福尼亚。1847到1870年间,圣弗朗西斯科的人口从500暴涨至了15万,这个城市也被冠以了「金山」的称号。站长网2023-09-11 09:22:490000