不用4个H100!340亿参数Code Llama在Mac可跑,每秒20个token,代码生成最拿手|Karpathy转赞

【新智元导读】现在,34B Code Llama模型已经能够在M2Ultra上的Mac运行了,而且推理速度超过每秒20个token,背后杀器竟是「投机采样」。

开源社区的一位开发者Georgi Gerganov发现,自己可以在M2Ultra上运行全F16精度的34B Code Llama模型,而且推理速度超过了20token/s。

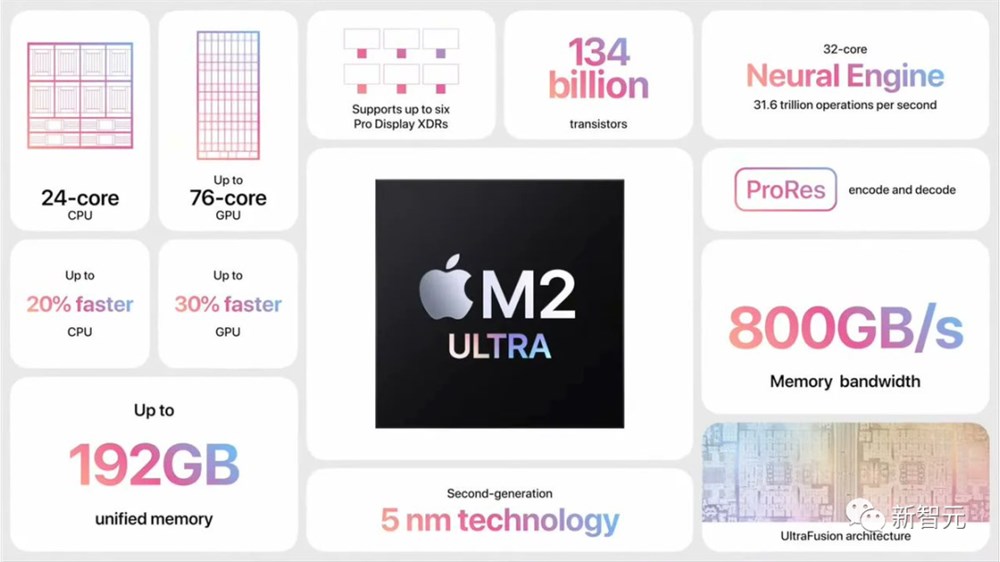

毕竟,M2Ultra的带宽有800GB/s。其他人通常需要4个高端GPU才能做到!

而这背后真正的答案是:投机采样(Speculative Sampling)。

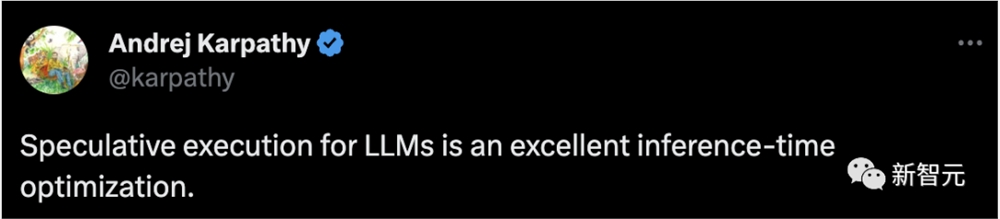

Georgi的这一发现,瞬间引爆AI圈大佬的讨论。

Karpathy转发评论道,「LLM的投机执行是一种出色的推理时间优化」。

「投机采样」加速推理

在这个例子中,Georgi借助Q47B quantum草稿模型(也就是Code Llama7B)进行了投机解码,然后在M2Ultra上使用Code Llama34B进行生成。

简单讲,就是用一个「小模型」做草稿,然后用「大模型」来检查修正,以此加速整个过程。

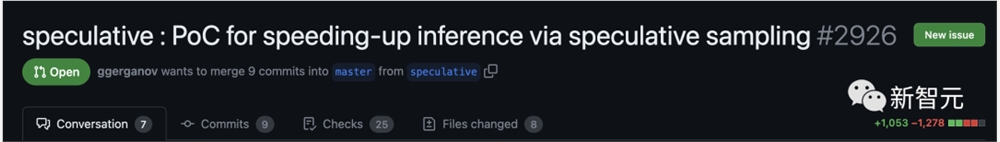

GitHub地址:https://twitter.com/ggerganov/status/1697262700165013689

根据Georgi介绍,这些模型的速度分别为:

- F1634B:~10token/s

- Q47B:~80token/s

如下是没有使用投机采样,标准F16采样示例:

然而,加入了投机采样策略后,速度可达~20token/s。

Georgi表示,当然,速度会因生成的内容而异。但这种方法在代码生成方面似乎效果很好,因为大多数词库都能被草稿模型正确猜出。

如果使用「语法采样」的用例也可能从中受益匪浅。

投机采样能够实现快速推理的背后具体如何实现?

Karpathy根据此前谷歌大脑、UC伯克利、DeepMind的三项研究,做出了解释。

论文地址:https://arxiv.org/pdf/2211.17192.pdf

论文地址:https://arxiv.org/pdf/1811.03115.pdf

论文地址:https://arxiv.org/pdf/2302.01318.pdf

这取决于以下不直观的观察结果:

在单个输入token上转发LLM所需的时间,与在K个输入token上批量转发LLM所需的时间相同(K比你想象的要大)。

这个不直观的事实是因为采样受到内存的严重限制,大部分「工作」不计算,而是将Transformer的权重从VRAM读取到芯片上缓存中进行处理。

因此,如果要完成读取所有权重的工作,还不如将它们应用到整批输入向量中。、

我们之所以不能天真地利用这一事实,来一次采样K个token,是因为每N个token都取决于,我们在第N-1步时采样的token。这是一种串行依赖关系,因此基线实现只是从左到右逐个进行。

现在,巧妙的想法是使用一个小而廉价的草稿模型,首先生成一个由K个token组成的候选序列——「草稿」。然后,我们将所有这些信息一起批量送入大模型。

根据上述方法,这与只输入一个token的速度几乎一样快。

然后,我们从左到右检查模型,以及样本token预测的logits。任何与草稿一致的样本都允许我们立即跳转到下一个token。

如果有分歧,我们就会扔掉草稿模型,承担做一些一次性工作的成本(对草稿模型进行采样,并对后面的token进行前向传递)。

这在实践中行之有效的原因是,大多数情况下,draft token都会被接受,因为是简单的token,所以即使是更小的草稿模型也能接受它们。

当这些简单的token被接受时,我们就会跳过这些部分。大模型不同意的困难token会「回落」到原始速度,但实际上因为有额外的工作会慢一些。

所以,总而言之:这一怪招之所以管用,是因为LLM在推理时是受内存限制。在「批大小为1」的情况下,对感兴趣的单个序列进行采样,而大部分「本地 LLM」用例都属于这种情况。而且,大多数token都很「简单」。

HuggingFace的联合创始人表示,340亿参数的模型在一年半以前的数据中心之外,看起来非常庞大和难以管理。现在是笔记本就可以搞定了。

现在的LLM并不是单点突破,而是需要多个重要组件有效协同工作的系统。投机解码就是一个很好的例子,可以帮助我们从系统的角度进行思考。

参考资料:

https://twitter.com/ggerganov/status/1697262700165013689

自媒体变现要趁早,越晚越不赚钱!

各位村民好,我是村长。多数人做自媒体不赚钱,除了内容不好以外,就是变现太矜持,文绉绉,最终什么钱都没有赚到。村长业余写作近4年,见过很多粉丝量比村长多,内容质量比村长好的博主,竟然不赚钱。同样也有见过粉丝量不如村长,但一个粉丝收益一二百块钱,才1万多粉丝,就能靠公众号变现了一二百万。所以今天村长要和各位正在做以及想要做自媒体的朋友们,聊一聊自媒体变现的事。01不赚钱别做自媒体站长网2023-08-06 10:45:280001Adobe将Firefly生成式AI功能整合到Substance 3D工作流程中

划重点:⭐Adobe将Firefly生成式AI功能整合到Substance3D设计和创意工作流程中。⭐新功能包括生成逼真或风格化纹理的功能以及从文本提示生成背景图像和将对象合成到场景中。⭐更新的Substance3DSampler和Stager版本将于3月18日向用户提供。站长网2024-03-20 18:56:370001雅虎重新计划IPO 财务上已做好准备

近日,雅虎首席执行官JimLanzone表示,公司已实现盈利,计划进行IPO作为重新崛起的一部分。2015年和2017年,Verizon收购了雅虎和AOL,并在2021年9月将它们以50亿美元的价格出售给Apollo。此次出售使雅虎声誉下降,市场份额被谷歌和Facebook等平台吞噬。Lanzone表示,雅虎的总流量仍然位于全球前五,公司将继续在金融、体育、新闻等领域发展,并寻求并购机会。站长网2023-07-04 16:18:000000快手直播:将严厉打击直播间展示、传播色情低俗内容

快手直播发布《关于集中整治色情低俗问题的公告》称,将对在直播间展示、传播色情低俗的内容集中整治、严厉打击,包括借低俗擦边内容在直播间博取关注、进行违规涨粉甚至获利的行为,对部分严重违规或累犯用户进行无限期回收其直播权限以及账号永久封禁处置。以下是平台重点打击的直播色情低俗问题类型:1.衣着暴露:主播穿着过于暴露、紧身的服装,刻意展示身体敏感部位,如胸部、大腿根部等,以吸引观众。站长网2024-07-01 18:15:450000报告称苹果计划终止与高盛的信用卡合作

**划重点:**1.🚫苹果计划终止与高盛的信用卡合作,据《华尔街日报》报道,合同预计将在接下来的12-15个月内结束。2.💳受影响的产品包括苹果卡、苹果储蓄账户和苹果“以后付款”服务。3.🔄高盛或曾考虑将合作转交给美国运通,但目前尚不清楚是否会实现,因为美国运通似乎担心该项目的贷款损失率。站长网2023-11-29 20:45:220000