Stability AI 开源聊天机器人 Stable Chat 采用新的「解释微调」技术

站长之家(ChinaZ.com) 8月30日消息:Stability AI 是图像生成 AIStable Diffusion 的开发商,其最近推出了开放访问的语言模型 Stable Beluga 的基于 Web 的聊天界面 Stable Chat。在发布时,Stable Beluga 是 HuggingFace 排行榜上表现最好的开放大型语言模型(LLM)。

Stable Beluga 基于 Meta 发布的 LLaMA 基础模型,并使用由 GPT-4 生成的合成数据集进行微调。最大的Stable Beluga 模型包含 70B 个参数,在多个基准测试中优于 ChatGPT,包括 AGIEval,该测试基于 LSAT 和 SAT 等常见考试。为了帮助评估Stable Beluga,Stability AI 创建了Stable Chat Web 界面来帮助用户与模型交互并对其输出提供反馈。根据 Stability AI:

作为我们在构建世界上最值得信赖的语言模型方面所做努力中一部分,我们已经设置了一个仅用于研究目的网站来测试和改进我们技术。随着我们研究迅速进展,我们将继续更新新模型。请避免将此网站用于实际应用或商业用途。

Stable Beluga 模型受到微软关于 Orca 论文启发而产生,该论文介绍了一种称为解释微调(explanation tuning)的技术。像指导微调(instruction tuning)一样,最近许多开放 LLM 都使用了这种技术,包括 ChatGPT 和 Vicuna。

解释微调使用由教师生成的示例输入和期望模型输出的数据集。在 ChatGPT 的情况下,教师是实际使用该模型的人类用户。相比之下,在 Orca 和 Stable Beluga 中,解释微调数据集是通过提示 GPT-4 解释为什么会生成它所做出的输出来生成的内容。

Stability AI 创建了自己的 600,000 个示例组成的解释微调数据集——只有微软数据集大小十分之一。然后他们训练了两个版本 Stable Beluga:基于 65B 参数原始 LLaMA 模型的 Stable Beluga 1 和基于 70B Llama 2 模型的 Stable Beluga 2。两者均以非商业许可证发布。尽管这些模型在发布时在排行榜上取得第四名和第一名,但目前基于 LLaMA 进行微调模型已经推动 Stable Beluga 2 退出前十名,并将 Stable Beluga 1 甩到更低位置。

根据 Stability AI 公司表示,这些模型以非商业许可证发布旨在鼓励研究人员协作迭代并改进技术。然而,该公司指出,这需要超出普通研究人员的资源,并决定创建 Stable Chat 网站。用户可以创建免费登录或使用 Google 帐户访问聊天界面。模型的响应可以被投票、反对或标记;这些用户反馈将用于未来改进模型。

另外,Stability AI 最近还宣布他们的 LLM 将在 DEF CON 31 举办的 AI 红队活动中使用。此次活动由白宫赞助,涵盖了「Anthropic, 谷歌, Hugging Face, 微软, 英伟达, OpenAI 和 Stability AI」,目标是帮助识别模型中的风险和漏洞。

访问 Stable Chat:

https://research.stability.ai/chat

微软推出 Bing Chat 移动端新功能:实现 PC 与移动设备之间无缝连续对话

微软本月初刚刚宣布了一系列基于GPT-4的BingChat更新,如今又推出了一些针对移动用户的大幅改进。在谷歌刚刚将其Docs和Gmail的AI工具更名为DuetAI几天后,微软现在专注于移动端,为Edge移动版提供上下文聊天、为iOS和Android提供Bing小组件,甚至在移动和桌面之间实现了持续的BingChat对话。站长网2023-05-17 16:09:320001百度大模型又拿了个冠军!全部8个维度均、7项满分

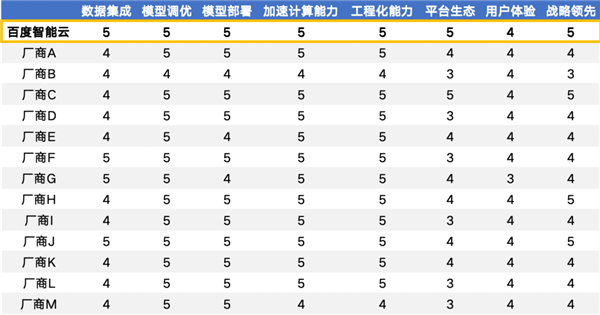

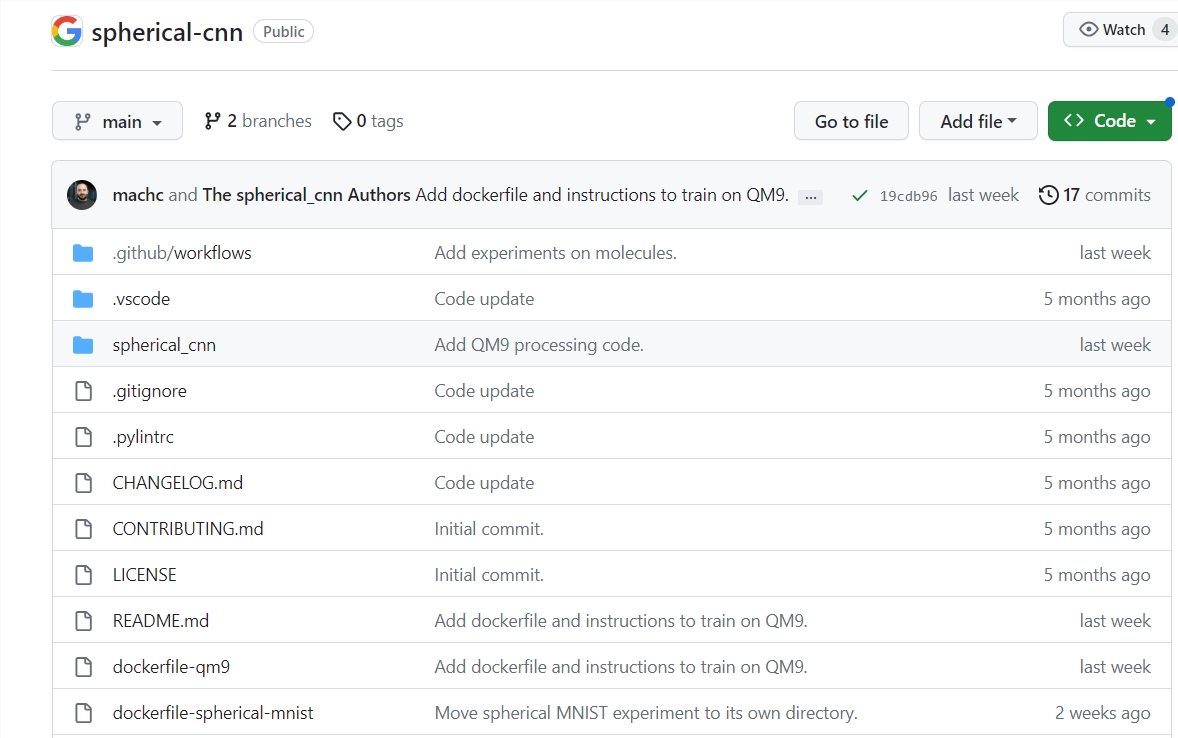

11月26日,快科技报道,百度大模型在IDC报告中再次拔得头筹。IDC发布了《中国生成式AI应用开发平台市场:企业统一AI开发平台的雏形》报告。作为业内首份生成式AI应用开发平台报告,该报告对14家中国主流厂商进行了8维度的全面评估,包括数据集成能力、模型调优能力、模型部署能力、加速计算能力、工程化能力、平台生态、用户体验和战略领先。站长网2024-11-30 10:34:420000谷歌研究人员在 JAX 中引入了一个开源库 用于在球面上进行深度学习

Google研究人员最近推出了一个基于JAX的开源库,旨在解决在球面上进行深度学习的挑战。传统的深度学习模型通常处理平面数据,例如图像,但科学应用中的数据通常是球面数据。这个新库利用了球面卷积和交叉相关操作,以更有效地处理球面数据。站长网2023-10-11 16:46:230000AI解放生产力?部分群体表示:几乎使工作量增加了一倍

近期推出的一批人工智能工具承诺能够简化任务、提高效率和提升工作场所的生产力。然而,许多员工对此表示不同意见并认为,AI反而增加了他们的工作量。一位编辑兼出版商NeilClarke表示,他的团队被大量人工智能生成的投稿淹没,导致工作量几乎翻倍,他甚至不得不关闭在线投稿表格。类似的情况也发生在其他行业,如法律和媒体,人工智能工具的实施带来了更多的工作量和压力。站长网2023-07-24 15:44:460001斯嘉丽·约翰逊起诉AI应用开发者侵权使用其名字和形象

划重点:-斯嘉丽·约翰逊起诉一家AI应用开发者,称其在在线广告中使用了她的名字和形象。-广告中展示了一个由AI生成的约翰逊的声音,并声称该应用不仅限于角色扮演,还可以创建图像和视频。-这可能是未来类似案例中的一个例子,随着AI越来越容易获得,音乐家已经面临着声音克隆和深度伪造技术的挑战。站长网2023-11-02 10:50:380000