麻省理工推出AI工具PhotoGuard 对抗生成式AI模型

近年来,大型扩散模型,如 DALL-E 2 和 Stable Diffusion,因其生成高质量、逼真的图像以及执行各种图像合成和编辑任务的能力而受到认可。

但是,人们对用户友好的生成式 AI 模型的潜在滥用也越来越担忧,这些模型可能会导致不适当或有害的数字内容的创建。例如,恶意行为者可能利用公开分享的个人照片,通过使用现成的扩散模型,出于恶意目的对其进行编辑。

为了应对未经授权的图像操纵带来的日益严峻的挑战,麻省理工学院计算机科学与人工智能实验室(CSAIL)的研究人员推出了一种名为“PhotoGuard”的 AI 工具,旨在对抗 DALL-E 和 Midjourney 等先进的生成式 AI 模型。 在研究论文《提高恶意 AI 驱动的图像编辑的成本》中,研究人员声称,PhotoGuard 可以检测像素值中不可察觉的“扰动”(干扰或不规则),这些扰动肉眼无法看到,但计算机模型可以检测到。

“我们的工具旨在在上传到互联网之前‘加固’图像,确保抵抗 AI 驱动的操纵尝试,”麻省理工学院 CSAIL 博士生兼论文第一作者 Hadi Salman 对 VentureBeat 说。“在我们的概念验证论文中,我们重点关注使用目前最流行的 AI 模型类别进行图像修改。这种抵抗力是通过在要保护的图像的像素中加入微妙地制作、不可察觉的扰动来建立的。这些扰动旨在破坏试图操纵图像的 AI 模型的功能。”

据麻省理工学院 CSAIL 的研究人员介绍,该 AI 采用了两种不同的“攻击”方法来创建扰动:编码器和扩散。

“编码器”攻击侧重于 AI 模型中图像的潜在表示,使模型将图像视为随机,并使图像操纵几乎变得不可能。同样,“扩散”攻击是一种更复杂的方法,涉及确定目标图像并优化扰动,使生成的图像与目标更加相似。 Salman 解释说,其 AI 使用的关键机制是“对抗性扰动”。

“这种扰动是对图像像素进行不可察觉地修改,已被证明非常有效地操纵机器学习模型的行为,”他说。“PhotoGuard 使用这些扰动来操纵处理受保护图像的 AI 模型,使其产生不现实或无意义的编辑。”

麻省理工学院 CSAIL 的研究生团队和主要作者 —— 包括 Alaa Khaddaj、Guillaume Leclerc 和 Andrew Ilyas —— 也参与了该论文。

该研究还于 7 月在国际机器学习会议上展示,并得到了国家科学基金会、开放哲学和国防高级研究项目局等机构资助。

Salman 说,尽管 DALL-E 和 Midjourney 等 AI 驱动的生成式模型因其能够从简单的文本描述中创建逼真的图像而受到关注,但滥用的风险也越来越明显。这些模型使用户能够生成高度详细和逼真的图像,为无辜和恶意的应用开辟了可能性。

Salman 警告说,欺诈性的图像操纵不仅会影响市场趋势和公众情绪,还会对个人图像构成风险。不恰当地修改的图片可能被用于敲诈勒索,从而在更大的范围内造成重大的财务影响。

孟羽童谈做博主后的收入:商业机密 这个不能说

快科技3月8日消息,据国内媒体报道,近日,孟羽童接受采访,谈到了她做博主后的收入问题。她表示工作后给妈妈买的最贵的东西是珠宝,我让妈妈去刷我的卡,让她去买她想买的东西,我那个时候其实是很有成就感的,有那种霸道总裁的感觉。”对于她转型博主后的收入问题,孟羽童称这个不能透露,算是商业机密。0000小米现金储备1516亿 雷军称小米交出史上业绩

昨日,小米集团宣布了2024年第三季度的财务报告,其中收入达到925亿元人民币,利润为63亿元,创下公司历史上最佳季度业绩。在过去的三个季度中,小米的收入同比增长率分别为27.0%、32.0%和30.5%,显示出公司强劲的增长势头。在现金流方面,小米目前持有1516亿元人民币,同时在研发领域的投入超过60亿元,同比增长近20%。研发团队规模也达到了20436人,显示公司对创新和技术发展的重视。0000AI,正在疯狂污染中文互联网

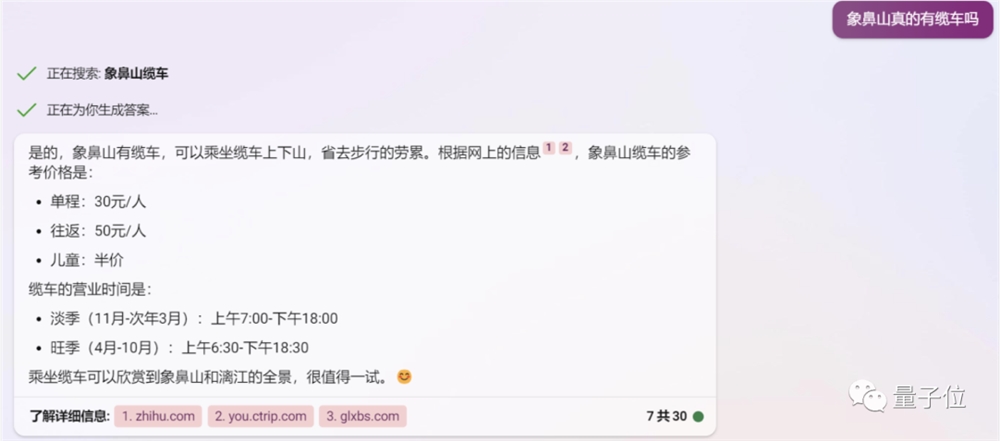

AI也反噬了自己污染中文互联网,AI成了“罪魁祸首”之一。事情是这样的。最近大家不是都热衷于向AI咨询嘛,有位网友就问了Bing这么一个问题:象鼻山是否有缆车?Bing也是有问必答,给出了看似挺靠谱的答案:在给出肯定的答复之后,Bing还贴心地附带上了票价、营业时间等细节信息。不过这位网友并没有直接采纳答案,而是顺藤摸瓜点开了下方的“参考链接”。站长网2023-06-20 17:58:200000谷歌Pixel系列史上价格最贵: Pixel8a售价破6000

据最新消息,谷歌的Pixela系列手机将在下一代产品中涨价成为历代a系列机型中最贵的一款。尽管Pixel7a可以看作是Pixel6a的重大升级,但其价格从449美元上涨到499美元仍然合理。0000“苹果入局大模型?我深挖到了一些细节”

在今年早些时候的WWDC上,苹果宣布即将推出的iOS和macOS版本将配备一项由“Transformer语言模型”提供支持的新功能,这个功能和很多AIGC工具一样,方便用户在输入文字时,提供由AI生成的文本建议。站长网2023-09-20 09:12:290000