击败Llama 2,抗衡GPT-3.5,Stability AI新模型登顶开源大模型排行榜

一眨眼,开源大模型又进步了。谷歌、OpenAI真的没有护城河?

「我就午休了30分,我们的领域又变了?」在看到最新的开源大模型排行榜后,一位 AI 领域的创业者发出了灵魂追问。

排行榜链接:https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard

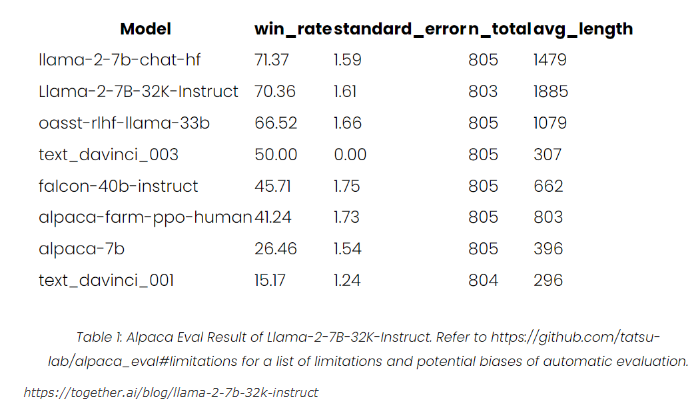

上图红框中的「新秀」是来自 Stability AI 和 CarperAI lab 的两个大模型:FreeWilly1和 FreeWilly2。刚刚,它们超越了 Meta 三天前发布的 Llama-2-70b-hf,成功登顶 HuggingFace 的 Open LLM 排行榜榜首。

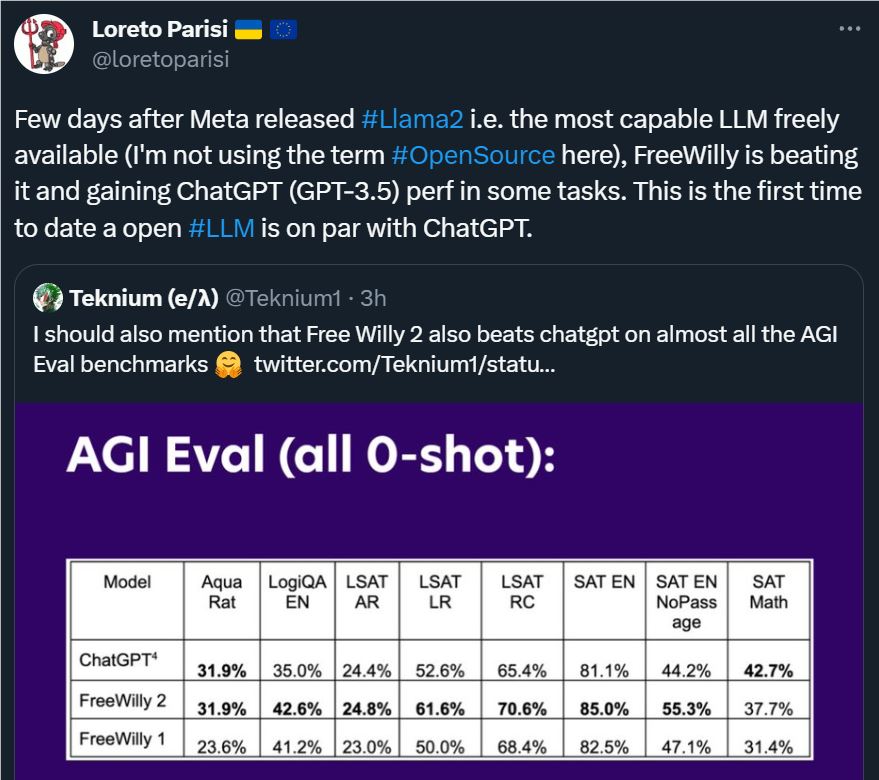

更引人注目的是,FreeWilly2在很多基准上还击败了 ChatGPT(GPT-3.5),成为首个真正可以和 GPT-3.5相抗衡的开源大模型,这是 Llama2都没有做到的事情。

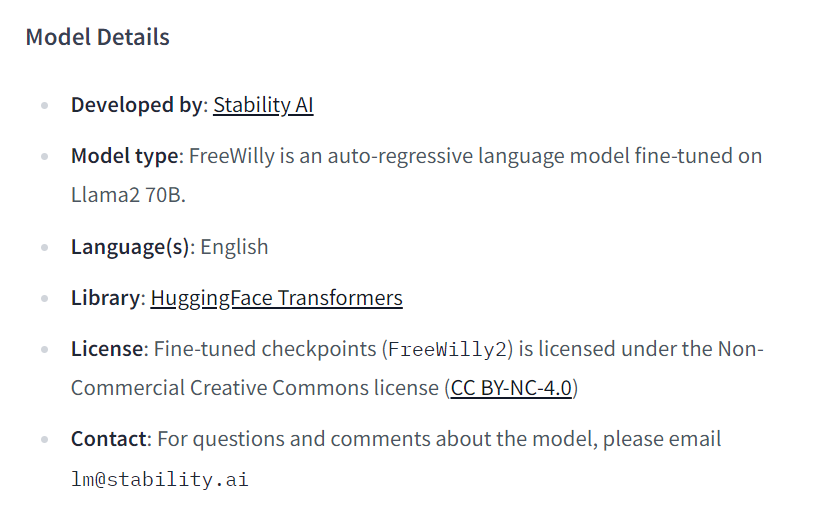

FreeWilly1基于原始的 LLaMA65B 基础模型构建,并且在标准 Alpaca 格式下,使用新的合成数据集进行了仔细的有监督微调(SFT)。FreeWilly2则基于最新的 LLaMA270B 基础模型构建。

从 Stability AI 发布的博客中,我们可以看到这两个新模型的一些细节:

数据来源

FreeWilly 模型的训练方法直接受到了微软在其论文《Orca: Progressive Learning from Complex Explanation Traces of GPT-4》中首创的方法的启发。虽然 FreeWilly 的数据生成过程与之相似,但二者在数据来源方面存在差异。

FreeWilly 的数据集包含了60万个数据点(大约是原始 Orca 论文使用的数据集大小的10%),它是通过以下由 Enrico Shippole 创建的高质量指令数据集来启发语言模型生成的:

COT Submix Original

NIV2Submix Original

FLAN2021Submix Original

T0Submix Original

采用这种方法,研究者使用了一个较简单的 LLM 模型生成了50万个示例,并使用一个更复杂的 LLM 模型生成了额外的10万个示例。为了确保公平比较,他们仔细筛选了这些数据集,并删除了来源于评估基准测试的示例。尽管训练样本数量仅为原始 Orca 论文的1/10(相比原始论文大大降低了训练模型的成本和碳排放),但由此产生的 FreeWilly 模型在各种基准测试中表现出色,验证了他们采用合成数据集的方法的有效性。

性能数据

为了对这些模型进行内部评估,研究者使用了 EleutherAI 的 lm-eval-harness 基准,并加入了 AGIEval。

其中,lm-eval-harness 基准由 EleutherAI 非盈利人工智能研究实验室创建,前面提到的 HuggingFace Open LLM 排行榜背后运行的就是该基准,它会在 Hugging Face 计算集群的空闲周期中运行评估,并将结果存储在数据集中,然后在在线排行榜空间上显示。

AGIEval 则由微软创建,专门用于评估基础模型在「以人为本」(human-centric)的标准化考试中的表现,比如数学竞赛、律师资格考试。

在许多方面,两个 FreeWilly 模型表现都非常出色,包括复杂的推理、理解语言的微妙之处,以及回答涉及专业领域(如法律和数学问题)的复杂问题。

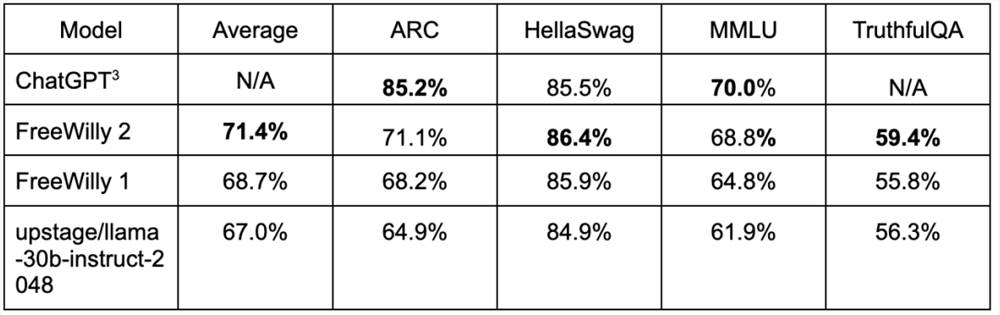

两个模型在 lm-eval-harness 基准上的评估结果如下(这些 FreeWilly 测试结果是由 Stability AI 研究人员来评估的):

二者在 AGIEval 基准上的表现如下(全部是0-shot):

此外,他们还在 GPT4ALL 基准上对两个模型进行了测试(全部是0-shot):

总体来看,这两个模型的性能表现都非常优秀,进一步缩小了与 ChatGPT 等顶级 AI 大模型的差距。想要获取模型的同学可以点击以下链接。

FreeWilly1:https://huggingface.co/stabilityai/FreeWilly1-Delta-SafeTensor

FreeWilly2:https://huggingface.co/stabilityai/FreeWilly2

从各方反应来看,FreeWilly 模型的出现给大家带来了一点小小的震撼,因为它们来得实在是太快了,毕竟 Llama2才刚刚推出3天,排行榜位置都没坐热。有位研究者表示,他最近刚做了眼科手术,一个星期没看新闻,但感觉自己已经昏迷了一年。所以,这是一段「不能眨眼」的时期。

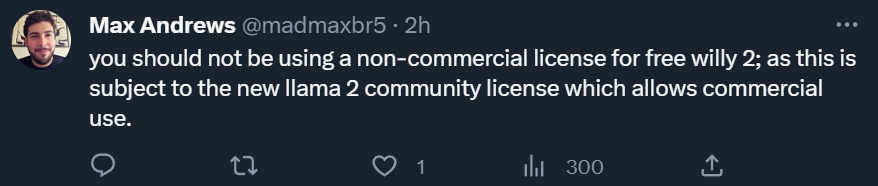

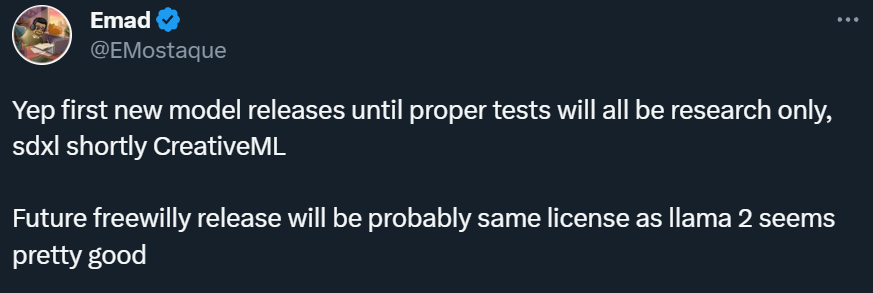

不过,需要注意的是,虽然两个模型都是开放获取的,但和 Llama2不同,它们是以非商业许可的形式发布的,仅可用于研究目的。

然而,这样的做法引起了网友质疑。

对此,Stability AI的研究者回复说,这种情况(仅用于研究目的)只是暂时的,未来,FreeWilly 有望像 Llama2一样允许商用。

此外,也有人对测试采用的基准产生了质疑:

这也是当前一个比较棘手的问题。此前,Falcon 模型在 HuggingFace 排行榜上碾压 Llama 的事件备受争议,后来,该事件彻底反转,事实证明 Llama 并未被 Falcon 碾压,HuggingFace 也为此重写了排行榜代码。在大模型层出不穷的今天,如何有效地评估这些模型依然是一个值得讨论的问题。因此,对于这些登顶排行榜的模型,我们有必要保持更加谨慎的态度,等待更多的评测结果出炉。

参考链接:https://stability.ai/blog/freewilly-large-instruction-fine-tuned-models?utm_source=twitter&utm_medium=website&utm_campaign=announcement

骁龙8 帧率反超骁龙8 Gen2!荣耀X50 GT发布:1999元起

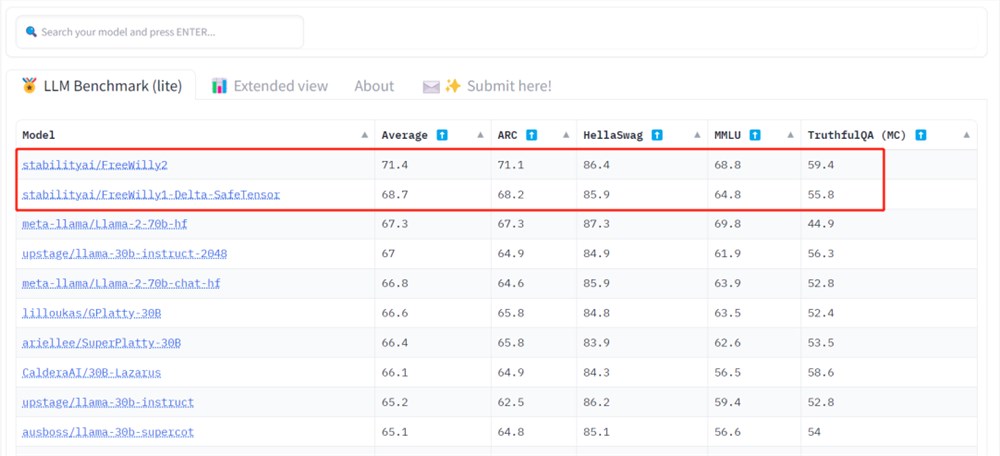

快科技1月4日消息,今晚19:30,荣耀正式发布了荣耀X50GT机型,这是一款主打越级性能的产品。外观设计上,荣耀X50GT延续了此前荣耀X50的整体方案,正面是一块居中开孔的双曲面屏,背部则是传承了旗舰的星环”模组设计,这次还专门配备了象征性能的龙爪”纹理。机身首创太极缓震架构,借鉴了水利工程的技术原理,让跌落实现软着陆,屏幕整体强度提升3倍,在1.5m高度情况下可以实现多角度防摔。0000Together AI 推出 Llama-2-7B-32K-Instruct:扩展上下文语言处理能力

TogetherAI发布了Llama-2-7B-32K-Instruct:一项在语言处理中扩展上下文的突破。这项创新具有重大意义,特别是在需要对复杂上下文细微差别有深刻理解的任务中。该模型通过巧妙地利用TogetherInferenceAPI的能力,成功地处理了长篇指令,同时在短篇情境下表现出色。站长网2023-08-22 11:53:11000000后华人大模型创业,组队7人挑战langchain,硅谷顶级创始人给了天使投资

2个华人牵头拉起一支7人队伍,创业大模型???没错,Cortex就是这样一个项目,被曝还拿下了还拿下了Zoom系,Getty家族和快手系的天使投资。这是一个集成诸多大模型API后,让大模型更懂你的中间件。主打特色有二:一是外接私有数据,包括Notion、Slack、GoogleDrive等,做特定领域的私有版GPT;另一件事是在每个企业内部,打造千人千面的Copilot。站长网2023-07-30 10:26:160000华为北汽智选品牌样车已出炉 此前华为转让“STELATO”商标

据财联社报道,接近北汽新能源的人士透露,华为与北汽合作的“界”牌样车已经“出炉”。这款车定位中大型纯电轿车,预计将在2024年上半年发布。此外,国家知识产权局商标局1865期商标公告显示,华为技术有限公司向北汽新能源汽车股份有限公司转让了多枚“STELATO”商标。据消息人士透露,STELATO是华为与北汽智选品牌的英文名称,与华为智选模式下的其他品牌如问界、智界等命名风格相呼应。0000网易互娱AI Lab图像生成论文被AI顶会接收

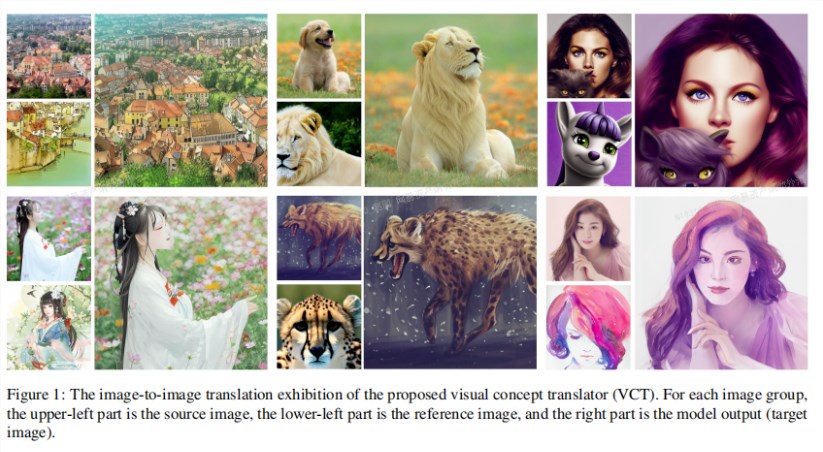

网易互娱AILab的一篇学术论文《GeneralImage-to-ImageTranslationwithOne-ShotImageGuidance》被国际计算机视觉顶级学术会议ICCV2023接收。该论文提出了一种名为VCT(视觉概念转换器)的图像编辑技术,可以通过一张参考图像将物体或风格转移到源图像上,同时保持源图像的整体结构不变。站长网2023-08-08 11:48:550000