反击DeepSeek失败!Llama 4效果不好,Meta承认有问题

今天凌晨1点半,Meta生成式AI领导者Ahmad Al-Dahle在社交平台发布了一篇长文,对前天刚开源的Llama4质疑进行了官方回应。

Ahmad表示,Llama4一开发完就发布了,所以,不同服务中模型质量难免会有一些差异。Meta很快会修复这些漏洞提升性能。同时否认在测试集上进行了预训练。

但Meta在官网发布时特意点名DeepSeek,说他们新开源的Llama4Maverick在代码能力可以比肩其新开源的V3模型,国内不少知名媒体也以此为噱头来写标题。

现在看来Meta首次反击是失败了,期待他们后续优化以及正训练的2万亿参数的教师模型。

以下是Ahmad完整声明:

我们很高兴能开始让大家都用上Llama4。我们已经听说很多人使用这些模型取得了不错的成果。

话虽如此,我们也听到了一些关于不同服务中模型质量参差不齐的报告。由于模型一准备好我们就发布了,所以我们预计所有公开的应用实现都需要几天时间来进行优化调整。我们会继续进行漏洞修复工作,并与合作伙伴完成对接流程。

我们还听到有人声称Llama4在测试集上进行了训练,这纯属无稽之谈,我们绝对不会这么做。据我们的判断,人们所看到的质量差异是由于需要对应用实现进行稳定化处理造成的。

我们相信Llama4模型是一项重大的技术进步,我们期待着与社区合作,充分挖掘其价值。

其实,在Llama4开源当天就有人质疑其性能。其代码能力比Grok3、DeepSeek V3、Sonnet3.5/7差很多。

无论是Scout还是Maverick模型,我使用了详尽的提示词,在实际编码方面似乎都几乎无法使用。

考虑到Meta公司付出的努力,我很惊讶一个4000亿参数的模型(即便它是混合专家模型)表现竟如此糟糕。它与DeepSeekV3”相比差距甚远。

我们对不同平台提供的Scout和Maverick进行了测试,结果发现这两款模型表现都不佳,甚至被参数规模更小的模型比下去了。

在基础编程任务之外,它们就会出错,而且在遵循指令方面能力也很弱。Maverick的排名接近谷歌的Gemini2.5,这一点令人担忧。它们给人的感觉就像是处于GPT-3.5时代的模型。很高兴Meta正在采取措施让情况稳定下来。

能够提前使用Llama4固然很棒,但这里有个关键事实:一个强大的模型,其实际效果取决于它的应用实现情况。

你在实验室里测试的效果,并不等同于用户在实际使用中所体验到的效果。在过度炒作和实际操作之间存在的差距,才是真正需要努力去填补的地方。

鉴于许多运行时环境都是开源的,或许未来在发布产品以免陷入如此混乱的局面之前,你们能够确保那些修复措施已经落实到位?“是你使用方式不对”这种说辞可不大好听。

也有网友质疑Meta刷榜:“质量参差不齐”??我看到的每一项基准测试中,Llama4的表现都糟透了,除非你参考的是LMSYS的“1417eon”基准测试结果。

你们向LMSYS开放了哪个API呢?因为目前LMSYS那边的模型列表中的表现也非常差。

Llama4就是垃圾,你们在这件事上搞砸得太厉害了。与其误导大家,还不如承认错误。不确定在测试集上动手脚这件事是不是真的,但鉴于它在基准测试中的高分以及在现实世界中糟糕的表现,这种可能性似乎很大。

在聊天机器人竞技场的大语言模型排行榜上,Meta公司的Llama4Maverick在编程方面排名第一。

然而,几乎我给出的每一个难的编程提示或中等难度的编程提示,它都无法完成。在编程方面,它比DeepSeek V3-0324、Claude3.5/3.7Sonnet或Gemini2.0Pro差得多。

所以,这位网友也在质疑Meta刷榜的问题。

其实从发布的时间点就能看出来,Meta这次并没有准备好。作为类ChatGPT的开源鼻祖之一,Llama4这么重磅的开源模型,居然放在了美国周六的大晚上发布(国内的周日凌晨3点),这太不符合常规了。

按照他们以往发布的Llama系列模型,一般会放在美国周二、周三早上10点左右。所以,在发布Llama4时他们本身就心虚。

DeepSeek的横空出世给Meta造成了巨大压力,其用户、口碑正在严重流失,他们急需一款重磅产品挽回败局。在今年过年DeepSeek疯狂刷屏那段时间,Meta还特意组建了“作战研究室”来研究其模型。但从最终结果来看,依然不是很理想。

此外,由于关税大战的原因,Meta的股票遭遇重创,他们也需要一个利好消息来拉升股票,现在适得其反。

3年来首次!消息称马斯克本周将访华:还要参观特斯拉上海工厂

5月29日消息,据媒体报道,特斯拉CEO埃隆马斯克将在本周访问中国,如果确定的话,这将是他3年来首次访华。据了解,马斯克上次来中国还是2020年初了,彼时,他参加特斯拉上海工厂的交付仪式,仪式上马斯克还大秀灵魂舞步,尬舞”视频引起热议。消息称,预计马斯克2023中国行期间还将参观特斯拉上海工厂,不过,目前还不清楚马斯克将具体与谁会见。0000老黄现身站台“AR眼镜的iPhone时刻”

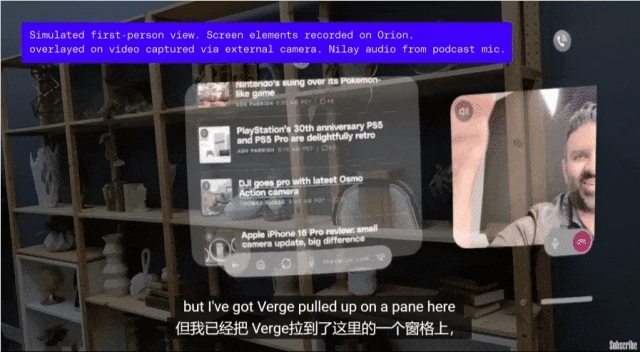

万众瞩目下,小扎接过了一个神秘保险箱,箱子还用铁链牢牢拴在工作人员手中……吊足众人胃口后,他才兴奋揭秘:发布Meta首款AR眼镜——Orion,并直呼“这就是世界上最先进的眼镜”。(违反广告法警告doge)发布过程中,Orion的全息投影技术着实震撼了众人一把。这项技术已经应用在了视频通话中,以至于有人感慨:2020年的Zoom时代看起来就像石器时代站长网2024-09-30 20:49:450004万兴天幕大模型4月28日公测 文生视频支持60秒+内容

万兴科技公布其旗下音视频多媒体大模型——万兴“天幕”将于4月28日迎来公开测试阶段。公司副总裁朱伟指出,尽管大模型在文本和图像领域已经实现了生产力的商业化应用,但在音视频领域,由于数据集不足、视频内容结构复杂、算力成本高昂等问题,其成熟应用仍需时间。他预测,随着技术的不断进步,2024年有望成为AI视频领域的爆发年,届时视频大模型将迎来快速迭代。站长网2024-04-18 20:47:440000视频生成框架WonderJourney:一句话一张图就能生成无限3D画面

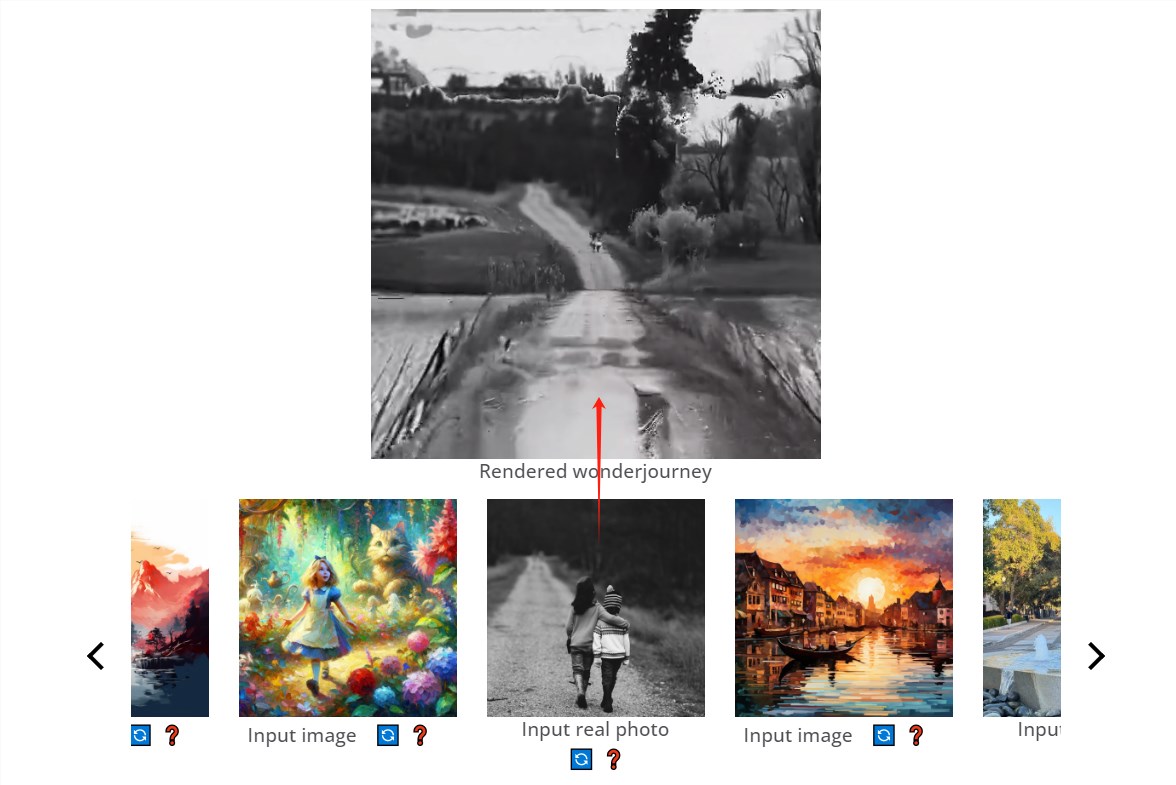

划重点:🌐斯坦福华人提出全新视频生成框架WonderJourney,能一句话或一张图生成连贯的3D场景。🎨WonderJourney通过LLM生成场景描述,使用文本驱动的视觉模块创造连续的3D场景,通过大型VLM验证生成效果。🎨WonderJourney还可以根据文本描述(如诗歌、俳句和故事摘要)生成可控制的奇妙之旅,呈现出多样化的视觉效果。站长网2023-12-14 14:55:420001绝无系统广告 不和小米、华为竞争!蔚来手机9月21日发布

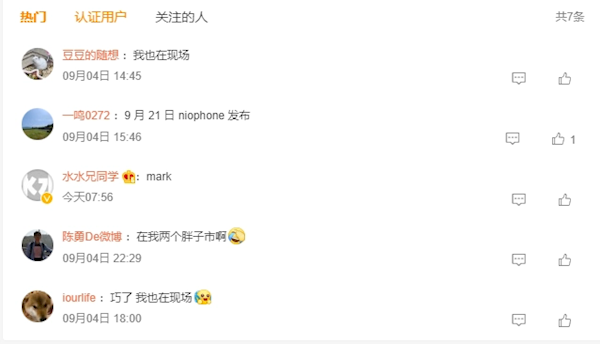

快科技9月5日消息,第二届蔚来商业资源合作伙伴大会”于9月4日在巢湖之滨的合肥洲际酒店举行。据网友@一鸣0272”分享,蔚来联合创始人、总裁秦力洪表示,蔚来计划于9月15日发布新款EC6车型,并很快交付。此外,蔚来还计划在今年9月21日发布大家期待已久的手机产品NIOPhone。据称,西安NIODay时间暂定12月23日。站长网2023-09-05 10:22:290000