全球AI算力报告出炉,LLM最爱A100!谷歌坐拥超100万H100等效算力

AI的物质基础是机器学习硬件,例如图形处理单元(GPU)和张量处理单元(TPU)。

据不完全统计,目前全球超过140款AI加速器,用于开发和部署深度学习时代的机器学习模型。

Epoch AI带来了全球算力的估计报告,利用公开信息估计了全球机器学习硬件的现状和趋势。

除了传统硬件厂商英伟达、AMD等纷纷推出加速卡,一些新兴势力开始「造芯」,算力持续提升。

2008至2024年全球机器学习硬件的计算能力示意图

除了GPU,硬件类型也丰富了起来。比如,出现了专门处理张量计算的TPU(张量处理单元,Tensor Processing Unit)。

报告的主要结论,总结如下:

总量每年增长43%,价格下降30%。

低精度计算成为主流。

顶级硬件能效每1.9年翻一番。

八年间,训练大型模型所需的处理器数量增加了20多倍。

全球NVIDIA支持的计算能力平均每10个月翻一番。

关键发现:ML硬件的「摩尔定律」

ML硬件每年增长43%

以16位浮点运算衡量,机器学习硬件的性能以每年43%的速度增长,每1.9年翻一番。32位性能也存在类似的趋势。

优化机器学习数字格式和张量核心提供了额外的改进。

驱动因素还包括晶体管数量的增加和其他半导体制造技术的进步,以及针对AI工作负载的专门设计。这种改进降低了每FLOP的成本,提高了能源效率,并实现了大规模人工智能训练。

机器学习硬件在不同精度下的峰值计算性能

性价比每年提升30%

每美元性能提升迅速,并且任何给定精度和固定性能水平的硬件每年都会便宜30%。与此同时,制造商不断推出更强大、更昂贵的硬件。

单位时间单位价格下的FLOP

低精度格式是趋势

在使用针对人工智能计算优化的张量核心和数据格式时,GPU通常速度更快。

与使用非张量FP32相比,TF32、张量FP16和张量INT8在总体性能趋势中平均提供约6倍、10倍和12倍的性能提升。

一些芯片甚至实现了更大的加速。例如,H100在INT8时的速度比在FP32时快59倍。

自推出以来,这些改进约占整体性能趋势改进的一半。随着开发人员利用这种性能提升,使用较低精度格式(尤其是张量FP16)训练的模型已经变得很常见。

能效每1.9年翻一番

根据历史数据,顶级GPU和TPU的能效每1.9年翻一番。

就tensor-FP16格式而言,效率最高的加速器是Meta的MTIA(每瓦高达2.1x10^12FLOP/s)和NVIDIA H100(每瓦高达1.4x10^12FLOP/s)。即将推出的Blackwell系列处理器可能会更有效率,具体取决于其功耗。

模型也各有所爱

在Epoch的数据集中,NVIDIA A100是用于高引用或最先进人工智能模型的最常用的硬件,自发布以来已用于65个著名ML模型。

其次是NVIDIA V100,用于训练55个著名模型,其次是谷歌的TPU v3,用于47个。

然而,估计NVIDIA H100到2023年底的销量已超过A100,因此它可能在不久的将来成为训练模型最受欢迎的GPU。

不同加速器训练的知名模型数量

2019年至今,不同领域大模型训练所需算力比较

训练集群规模猛增

用于训练大型语言模型(LLMs)的处理器数量的显著增长。

Google NASv3RL网络(2016):使用了800个GPU进行训练。

Meta Llama3.1405B(2024):使用了16,384个H100GPU进行训练。

这意味着在短短八年间,训练大型模型所需的处理器数量增加了20多倍。

四大「算力帝国」?

谷歌、微软、Meta和亚马逊拥有相当于数十万个NVIDIA H100的AI算力。

这些计算资源既用于他们内部的AI开发,也用于云客户,包括许多顶级AI实验室,如OpenAI和Anthropic。

谷歌可能拥有相当于超过一百万个H100的计算能力,主要来自他们的TPU。

微软可能拥有最大的NVIDIA加速器库存,约为50万个H100当量。

大量的AI计算能力由这四家公司以外的集团共同拥有,包括其他云公司如Oracle和CoreWeave,计算用户如特斯拉和xAI,以及各国政府。

之所以重点介绍谷歌、微软、Meta和亚马逊,因为他们可能拥有最多的计算能力,而其他公司的数据公开较少。

初步工作发现,截至2024年中,谷歌TPU的总算力大约是英伟达芯片的30%。

英伟达每年不止翻一番

自2019年以来,NVIDIA芯片的总可用计算能力大约每年增长2.3倍,从而能够训练越来越大的模型。

也就是说,全球NVIDIA组成的计算能力平均每10个月翻一番。

Hopper这一代NVIDIA AI芯片目前占其所有AI硬件总计算能力的77%。按照这种增长速度,旧的芯片型号在其推出后大约4年左右,对累计计算量的贡献往往会低于一半。

请注意,此分析不包括TPU或其他专用AI加速器,因为这方面的数据较少。TPU可能提供与NVIDIA芯片相当的总计算能力。

按芯片型号分解,发现目前大约77%的NVIDIA FLOP/s来自Hopper代际的GPU,如H100。

目前估计NVIDIA GPU可提供4e21FLOP/s的计算能力,约相当于400万个H100。

注意:这些估计基于NVIDIA的收入申报文件,并假设不同时代芯片的分布随时间变化的模式与AI集群数据集中的模式相同。

英伟达23-24年季度财报

此外,报告发现自2019年以来,计算能力的累计总和(考虑折旧)每年增长2.3倍。

但仅考虑数据中心销售额,而忽略NVIDIA收入报告中「游戏」(Gaming)销售额带来的计算能力。

公开数据集

Epoch同时公布了机器学习硬件数据集和数据分析源代码。

https://epoch.ai/data/machine-learning-hardware-documentation#overview

详细数据分析流程,参见下列NoteBook。

https://colab.research.google.com/drive/1gbbrKDKFjghUPmH-aSI9ACtb1Iuwg-cR?usp=sharing

参考资料:

https://epoch.ai/data/machine-learning-hardware

微信内测朋友圈置顶功能 仅向部分用户开放

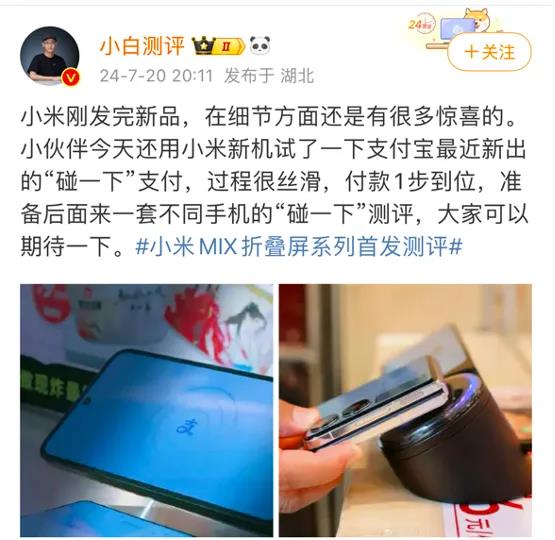

今日,话题#微信内测朋友圈置顶功能#登上热搜,有网友反馈称,部分用户的微信朋友圈已支持置顶,微信仅面向一小部分用户测试该功能。据了解,被置顶的朋友圈,将在个人朋友圈页面顶部长期显示。4月12日,微信8.0.35安卓内测版正式发布。在该版本中,支持视频播放画面缩放等功能、同时优化了青少年模式。站长网2023-04-14 09:23:490000小米开卷“碰一下”,背后有何深意?

在科技界,小米的动态总是让人瞩目。近日,针对小米发布的MIX折叠屏系列新机,小米CMO许斐透露,该机型支持支付宝新出的碰一下支付,比苹果还要快。此话一出,就有网友对小米和支付宝的“互蹭”合作表示欢迎,甚至还有已经支持支付宝“碰一下”的商家也喊话米粉来门店试用体验。站长网2024-07-27 13:33:350001阿里巴巴推出高保真图像到视频生成框架AtomoVideo

近日,阿里巴巴在人工智能领域再次取得突破,推出了一款名为AtomoVideo的高保真图像到视频生成框架。这一技术的问世,标志着基于文本到图像生成技术的视频生成领域取得了显著的快速发展。站长网2024-03-06 11:13:190000腾讯云全新AI绘画产品亮相 已开放超25种生成风格

腾讯云在2023上海国际消费电子技术展上展示了多款AI和GC(GeneralComputing)产品。其中,腾讯云智能展示了全新的AI绘画产品,它依托腾讯优图实验室自研的AI绘画模型,提供AI图像生成与编辑技术API服务,用户能够轻松地根据输入的文本或图片,智能创作出与输入信息相关的图像内容。站长网2023-10-13 15:47:060000OpenAI:目前ChatGPT和API仍不稳定 会出现周期性中断

今日9点30分左右,OpenAI在官方网站再次更新了事故报告。OpenAI指出,目前ChatGPT和API服务仍然可能会出现周期性中断。站长之家了解到,昨日晚间,OpenAI的ChatGPT和API服务出现了严重的中断故障,导致用户和开发者无法正常使用相关服务。对于这次事故,OpenAI表示他们正在全力以赴地研究和修复这个问题。就在今日凌晨,OpenAI表示,已修复了上述问题。站长网2023-11-09 10:32:140000